Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Überwachen von Amazon Comprehend-Endpunkten

Sie können den Durchsatz Ihres Endpunkts anpassen, indem Sie die Anzahl der Inferenzeinheiten (IUs) erhöhen oder verringern. Weitere Informationen zum Aktualisieren Ihres Endpunkts finden Sie unter Aktualisieren von Amazon Comprehend-Endpunkten.

Sie können bestimmen, wie Sie den Durchsatz Ihres Endpunkts am besten anpassen können, indem Sie dessen Nutzung mit der Amazon- CloudWatch Konsole überwachen.

Überwachen Ihrer Endpunktnutzung mit CloudWatch

-

Melden Sie sich bei der an AWS Management Console und öffnen Sie die CloudWatch -Konsole

. -

Wählen Sie links Metriken und dann Alle Metriken aus.

-

Wählen Sie unter Alle Metriken die Option Comprehend aus.

-

Die CloudWatch Konsole zeigt die Dimensionen für die Comprehend-Metriken an. Wählen Sie die EndpointArn Dimension aus.

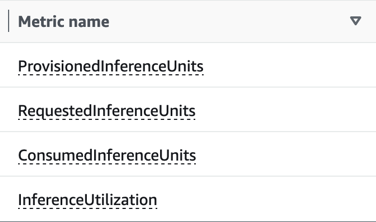

Die Konsole zeigt ProvisionedInferenceUnits, RequestedInferenceUnitsConsumedInferenceUnits, und InferenceUtilization für jeden Ihrer Endpunkte an.

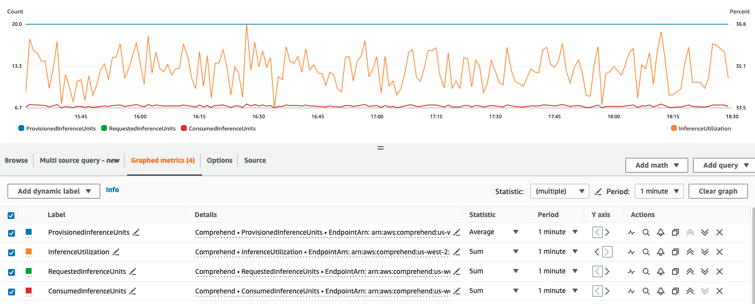

Wählen Sie die vier Metriken aus und navigieren Sie zur Registerkarte Grafische Metriken.

-

Legen Sie die Statistikspalten für RequestedInferenceUnits und ConsumedInferenceUnits auf Summe fest.

-

Legen Sie die Spalte Statistik für InferenceUtilization auf Summe fest.

-

Legen Sie die Spalte Statistik für ProvisionedInferenceUnits auf Durchschnitt fest.

-

Ändern Sie die Spalte Zeitraum für alle Metriken auf 1 Minute.

-

Wählen Sie InferenceUtilization und dann den Pfeil aus, um ihn in eine separate Y-Achse zu verschieben.

Ihr Diagramm ist für die Analyse bereit.

Basierend auf den CloudWatch Metriken können Sie auch Auto Scaling einrichten, um den Durchsatz Ihres Endpunkts automatisch anzupassen. Weitere Informationen zur Verwendung von Auto Scaling mit Ihren Endpunkten finden Sie unter Automatische Skalierung mit Endpunkten.

-

ProvisionedInferenceUnits – Diese Metrik stellt die Anzahl der durchschnittlichen bereitgestellten IUs zum Zeitpunkt der Anforderung dar.

-

RequestedInferenceUnits – Dies basiert auf der Nutzung jeder Anforderung, die an den Service gesendet wurde, der zur Verarbeitung gesendet wurde. Dies kann hilfreich sein, um die zur Verarbeitung gesendete Anfrage mit der tatsächlich verarbeiteten Anfrage zu vergleichen, ohne dass eine Drosselung () auftrittConsumedInferenceUnits. Der Wert für diese Metrik wird berechnet, indem die Anzahl der Zeichen, die zur Verarbeitung gesendet werden, durch die Anzahl der Zeichen dividiert wird, die in einer Minute für 1 verarbeitet werden können.

-

ConsumedInferenceUnits – Dies basiert auf der Verwendung jeder an den Service übermittelten Anfrage, die erfolgreich verarbeitet (nicht gedrosselt) wurde. Dies kann hilfreich sein, wenn Sie vergleichen, was Sie verbrauchen, mit Ihren bereitgestelltenIUs. Der Wert für diese Metrik wird berechnet, indem die Anzahl der verarbeiteten Zeichen durch die Anzahl der Zeichen dividiert wird, die in einer Minute für 1 verarbeitet werden können.

-

InferenceUtilization – Dies wird pro Anforderung ausgegeben. Dieser Wert wird berechnet, indem die in definierten IUs durch ConsumedInferenceUnits dividiert ProvisionedInferenceUnits und in einen Prozentsatz von 100 konvertiert werden.

Anmerkung

Alle Metriken werden nur für erfolgreiche Anforderungen ausgegeben. Die Metrik wird nicht angezeigt, wenn sie aus einer Anforderung stammt, die gedrosselt wurde oder mit einem internen Serverfehler oder einem Kundenfehler fehlschlägt.