Wir aktualisieren den Amazon Machine Learning Learning-Service nicht mehr und akzeptieren keine neuen Benutzer mehr dafür. Diese Dokumentation ist für bestehende Benutzer verfügbar, wir aktualisieren sie jedoch nicht mehr. Weitere Informationen finden Sie unterWas Amazon Machine Learning.

Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Einblicke in binäre Modelle

Interpretieren der Voraussagen

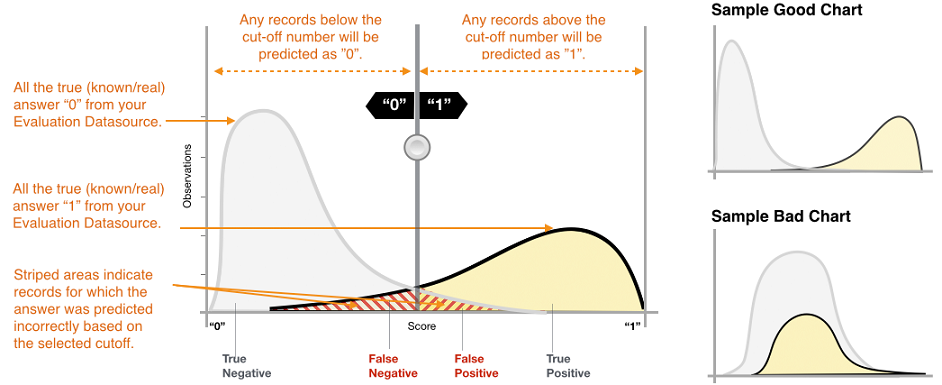

Die tatsächliche Ausgabe von vielen binären Klassifizierungsalgorithmen ist eine Voraussagepunktzahl. Die Punktzahl gibt die Sicherheit des Systems an, dass die angegebene Beobachtung der positiven Klasse angehört (der tatsächliche Zielwert ist 1). Binäre Klassifizierungsmodelle in Amazon ML geben ein Ergebnis im Bereich von 0 bis 1 aus. Als Verbraucher dieser Bewertung können Sie die Punktzahl interpretieren, indem Sie einen Klassifizierungsschwellenwert oder Grenzwert festlegen und die Punktzahl damit vergleichen, um zu entscheiden, ob die Beobachtung als 1 oder 0 klassifiziert wird. Alle Beobachtungen mit Ergebnissen über dem Grenzwert werden als "Ziel = 1" vorausgesagt; Beobachtungen mit Ergebnissen unter dem Grenzwert werden als "Ziel = 0" vorausgesagt.

In Amazon ML ist der standardmäßige Ergebnisgrenzwert 0,5. Sie können diesen Grenzwert Ihren geschäftlichen Anforderungen entsprechend ändern. Sie können die Visualisierungen in der Konsole verwenden, um zu verstehen, wie sich die Auswahl des Grenzwerts auf Ihre Anwendung auswirkt.

Messung der ML-Modellgenauigkeit

Amazon ML bietet eine Genauigkeitsmetrik nach Branchenstandard für binäre Klassifizierungsmodelle, genannt Fläche unter der Kurve (AUC) oder Receiver Operating Characteristic (ROC). AUC misst die Fähigkeit des Modells, eine höhere Bewertung für positive Beispiele im Vergleich zu negativen Beispielen vorherzusagen. Da es unabhängig vom Grenzwert ist, bekommen Sie ein Gefühl für die Voraussagegenauigkeit Ihres Modells aus der AUC-Metrik, ohne einen Schwellenwert auszuwählen.

Die AUC-Metrik gibt einen Dezimalwert zwischen 0 und 1 zurück. AUC-Werte nahe 1 weisen auf ein sehr genaues ML-Modell hin. Werte um 0,5 weisen auf ein ML-Modell hin, das nicht besser als zufälliges Raten ist. Werte um 0 sind ungewöhnlich und weisen in der Regel auf ein Problem mit den Daten hin. Im Wesentlichen gibt ein AUC in der Nähe von 0 an, dass das ML-Modell die richtigen Muster gelernt hat, aber diese verwendet, um Voraussagen zu geben, die im Gegensatz zur Realität stehen (0 wird als 1 vorhergesagt und umgekehrt). Weitere Informationen zur AUC finden Sie auf der Seite Receiver Operating Characteristic

Die grundlegende AUC-Metrik für ein binäres Modell ist 0,5. Dies ist der Wert für ein hypothetisches ML-Modell, das zufällig eine Antwort von 1 oder 0 voraussagt. Ihr binäres ML-Modell sollte besser als das funktionieren, um einen Mehrwert zu bieten.

Verwenden der Performance-Visualisierung

Sehen Sie zur Prüfung der Genauigkeit des ML-Modells die Diagramme in derBewertung-Seite auf der Amazon ML-Konsole. Diese Seite zeigt Ihnen zwei Histogramme: a) ein Histogramm der Punktzahlen für die tatsächlichen positiven Ergebnisse (das Ziel ist 1) und b) ein Histogramm der Punktzahlen für die tatsächlichen negativen Ergebnisse (das Ziel ist 0) in den Auswertungsdaten.

Ein ML-Modell mit guter Voraussagegenauigkeit sagt höhere Ergebnisse für die tatsächliche 1 und niedrigere Ergebnisse für die tatsächliche 0 voraus. Ein perfektes Modell zeigt in den zwei Histogramme an den zwei verschiedenen Enden der X-Achse, dass alle tatsächlichen positiven Ergebnisse hohe Punktzahlen und die tatsächlichen negativen Ergebnisse niedrige Punktzahlen haben. ML-Modelle machen jedoch auch Fehler, und ein typisches Diagramm zeigt Überschneidungen an bestimmten Punktzahlen. Ein extrem schlechtes Modell unterscheidet nicht zwischen den positiven und negativen Klassen, und beide Klassen haben vorwiegend überlappende Histogramme.

Anhand von Visualisierungen können Sie die Anzahl der Voraussagen bestimmen, die in zwei Arten von richtigen Voraussagen und zwei Arten von falschen Voraussagen unterteilt werden.

Richtige Voraussagen

-

Wirkliches Positiv (TP): Amazon ML hat den Wert 1 vorausgesagt, und der tatsächliche Wert ist 1.

-

Wirkliches Negativ (TN): Amazon ML hat den Wert 0 vorausgesagt, und der tatsächliche Wert ist 0.

Falsche Voraussagen

-

Falsches Positiv (FP): Amazon ML hat den Wert 1 vorausgesagt, aber der tatsächliche Wert ist 0.

-

Falsches Negativ (FN): Amazon ML hat den Wert 0 vorausgesagt, aber der tatsächliche Wert ist 1.

Anmerkung

Die Anzahl von TP, TN, FP und FN richtet sich nach dem ausgewählten Schwellenwert, und die Optimierung für eine dieser Zahlen würde einen Kompromiss bei den anderen bedeuten. Eine hohe Anzahl von TPs führt in der Regel zu einer hohen Anzahl von FPs und einer geringen Anzahl von TNs.

Anpassen des Ergebnisgrenzwerts

ML-Modelle arbeiten mittels Generierung von numerischen Voraussagepunktzahlen und Anwenden eines Grenzwertes, um diese Punktzahlen in binäre 0/1-Etiketten zu konvertieren. Durch das Ändern des Grenzwerts können Sie das Verhalten des Modells anpassen, wenn es einen Fehler macht. Auf derBewertungIn der Amazon ML-Konsole können Sie die Auswirkungen von verschiedenen Ergebnisgrenzwerten überprüfen und den Ergebnisgrenzwert speichern, den Sie für Ihr Modell nutzen möchten.

Beachten Sie bei der Anpassung des Schwellenwerts für den Ergebnisgrenzwert den Kompromiss zwischen den beiden Arten von Fehlern. Wenn Sie den Grenzwert nach links verschieben, werden mehr positive Ergebnisse erfasst, aber der Kompromiss besteht in der Erhöhung der Anzahl von falschen Positivangaben. Verschieben nach rechts ergibt weniger falsche Positivangaben, aber der Kompromiss ist, dass einige tatsächliche positive Ergebnisse nicht erfasst werden. Für die Voraussageanwendung können Sie entscheiden, welche Art von Fehler eher akzeptabel ist, indem Sie einen geeigneten Ergebnisgrenzwert festlegen.

Überprüfen von erweiterten Metriken

Amazon ML bietet die folgenden zusätzlichen Metriken, um die Voraussagegenauigkeit des ML-Modells zu messen: Richtigkeit, Genauigkeit, Wiedererkennbarkeit und Falschpositivrate.

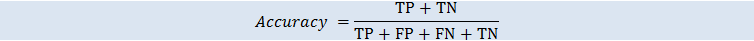

Accuracy

DieRichtigkeit (ACC) misst den Anteil der richtigen Voraussagen. Der Bereich liegt zwischen 0 und 1. Ein größerer Wert gibt eine bessere Richtigkeit an:

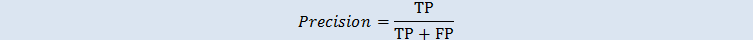

Genauigkeit

Genauigkeit misst den Anteil der tatsächlichen Positiva unter den Beispielen, die als positiv vorausgesagt wurden. Der Bereich liegt zwischen 0 und 1. Ein größerer Wert gibt eine bessere Richtigkeit an:

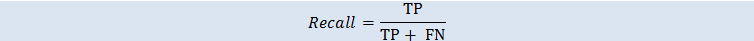

Wiedererkennung

Wiedererkennung misst den Anteil der tatsächlichen Positiva, die als positiv vorausgesagt wurden. Der Bereich liegt zwischen 0 und 1. Ein größerer Wert gibt eine bessere Richtigkeit an:

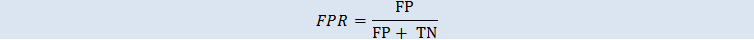

Falschpositivrate

Die Falschpositivrate (FPR) misst den Anteil falscher Alarme oder den Anteil tatsächlicher negativer Ergebnisse, die als positiv vorhergesagt wurden. Der Bereich liegt zwischen 0 und 1. Ein kleinerer Wert gibt eine bessere Richtigkeit der Voraussage an:

Abhängig von Ihrem Unternehmensproblem benötigen Sie vielleicht eher ein Modell, das für eine bestimmte Teilmenge dieser Metriken gut funktioniert. Zwei Unternehmensanwendungen können beispielsweise sehr unterschiedliche Anforderungen an ihr ML-Modell haben:

-

Eine Anwendung muss vielleicht sehr sicher sein, dass die positiven Voraussagen tatsächlich positiv sind (hohe Präzision) und kann es verkraften, dass einige positive Beispiele falsch als negativ klassifiziert werden (moderate Wiedererkennung).

-

Eine andere Anwendung soll so viele positive Beispiele wie möglich korrekt voraussagen (hohe Wiedererkennung) und nimmt es in Kauf, dass einige negative Beispiele falsch als positiv klassifiziert werden (moderate Genauigkeit).

In Amazon ML können Sie einen Ergebnisgrenzwert festlegen, der einem bestimmten Wert von einer der oben genannten erweiterten Metriken entspricht. Außerdem werden die Kompromisse durch Optimierung für eine der Metriken angezeigt. Wenn Sie beispielsweise einen Grenzwert auswählen, der eine hohe Genauigkeit erzielt, erhalten Sie dafür in der Regel eine geringere Wiedererkennung.

Anmerkung

Sie müssen den Ergebnisgrenzwert speichern, damit er für die Klassifizierung künftiger Voraussagen Ihrer ML-Modelle wirksam wird.