Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Algorithmus-Images erstellen

Ein SageMaker Amazon-Algorithmus verlangt, dass der Käufer seine eigenen Daten zum Training mitbringt, bevor er Vorhersagen trifft. Als AWS Marketplace Verkäufer können Sie Algorithmen und Modelle SageMaker für maschinelles Lernen (ML) erstellen, die Ihre Käufer einsetzen können AWS. In den folgenden Abschnitten erfahren Sie, wie Sie Algorithmus-Images erstellen AWS Marketplace. Dazu gehört die Erstellung des Docker-Training-Images für das Training Ihres Algorithmus und des Inferenz-Images, das Ihre Inferenzlogik enthält. Sowohl das Trainings- als auch das Inferenzbild sind für die Veröffentlichung eines Algorithmusprodukts erforderlich.

Themen

Übersicht

Ein Algorithmus umfasst die folgenden Komponenten:

-

Ein in Amazon

gespeichertes Trainingsbild ECR -

Ein in Amazon Elastic Container Registry (AmazonECR) gespeichertes Inferenzbild

Anmerkung

Bei Algorithmusprodukten generiert der Trainingscontainer Modellartefakte, die bei der Modellbereitstellung in den Inferenzcontainer geladen werden.

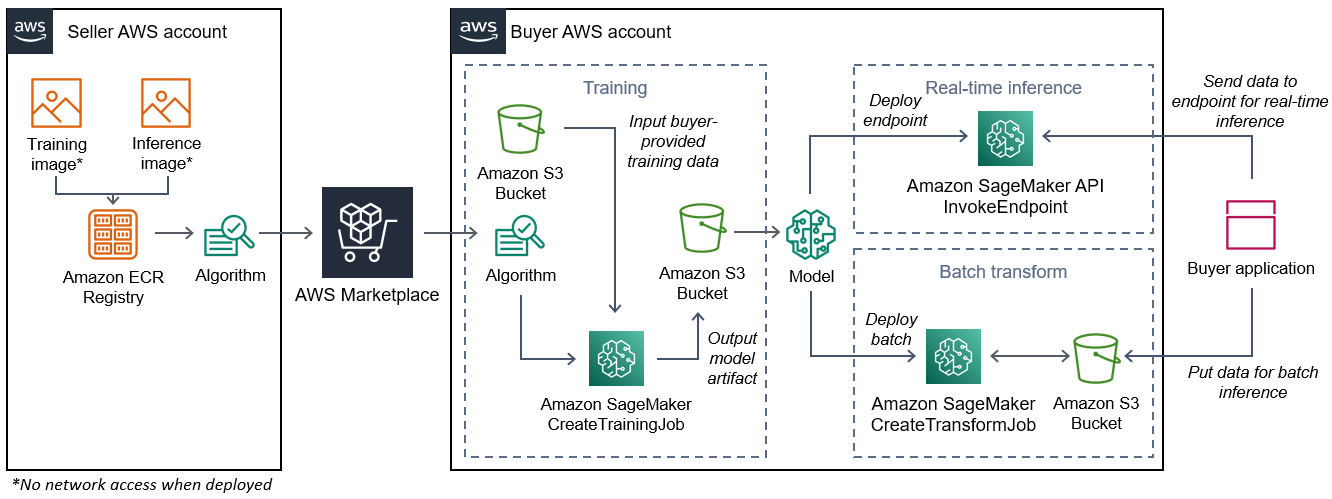

Das folgende Diagramm zeigt den Arbeitsablauf für die Veröffentlichung und Verwendung von Algorithmusprodukten.

Der Arbeitsablauf zum Erstellen eines SageMaker Algorithmus für AWS Marketplace umfasst die folgenden Schritte:

-

Der Verkäufer erstellt ein Schulungs-Image und ein Inferenz-Image (kein Netzwerkzugriff bei der Bereitstellung) und lädt es in die ECR Amazon-Registrierung hoch.

-

Der Verkäufer erstellt dann eine Algorithmusressource in Amazon SageMaker und veröffentlicht sein ML-Produkt auf AWS Marketplace.

-

Der Käufer abonniert das ML-Produkt.

-

Der Käufer erstellt einen Trainingsjob mit einem kompatiblen Datensatz und entsprechenden Hyperparameterwerten. SageMaker führt das Trainingsbild aus und lädt die Trainingsdaten und Hyperparameter in den Trainingscontainer. Wenn der Schulungsjob abgeschlossen ist, werden die Modellartefakte, die sich darin

/opt/ml/model/befinden, komprimiert und in den Amazon S3 S3-Bucketdes Käufers kopiert. -

Der Käufer erstellt ein Modellpaket mit den in Amazon S3 gespeicherten Modellartefakten aus dem Training und stellt das Modell bereit.

-

SageMaker führt das Inferenz-Image aus, extrahiert die komprimierten Modellartefakte und lädt die Dateien in den Verzeichnispfad des Inferenz-Containers,

/opt/ml/model/wo sie von dem Code verwendet werden, der die Inferenz bereitstellt. -

Gibt an, ob das Modell als Endpunkt- oder Batch-Transformationsjob bereitgestellt wird, die Daten zur Inferenz im Namen des Käufers über den HTTP Endpunkt des Containers an den Container SageMaker weiterleitet und die Prognoseergebnisse zurückgibt.

Anmerkung

Weitere Informationen finden Sie unter Train Models.

Ein Trainingsbild für Algorithmen erstellen

In diesem Abschnitt finden Sie eine exemplarische Vorgehensweise, wie Sie Ihren Trainingscode in ein Trainingsimage verpacken. Ein Trainingsimage ist erforderlich, um ein Algorithmusprodukt zu erstellen.

Ein Trainings-Image ist ein Docker-Image, das Ihren Trainingsalgorithmus enthält. Der Container hält sich an eine bestimmte Dateistruktur, um das Kopieren von Daten SageMaker in und aus Ihrem Container zu ermöglichen.

Bei der Veröffentlichung eines Algorithmusprodukts sind sowohl die Trainings- als auch die Inferenzbilder erforderlich. Nachdem Sie Ihr Trainingsbild erstellt haben, müssen Sie ein Inferenzbild erstellen. Die beiden Bilder können zu einem Bild kombiniert werden oder als separate Bilder verbleiben. Ob Sie die Bilder kombinieren oder trennen, liegt bei Ihnen. In der Regel ist Inferenz einfacher als Training, und Sie möchten möglicherweise separate Bilder verwenden, um die Leistung der Inferenz zu verbessern.

Anmerkung

Im Folgenden finden Sie nur ein Beispiel für einen Verpackungscode für ein Trainingsbild. Weitere Informationen finden Sie unter Verwenden Sie Ihre eigenen Algorithmen und Modelle mit den AWS Marketplace und den AWS Marketplace

SageMaker Beispielen

Schritte

Schritt 1: Erstellen des Container-Images

Damit das Trainings-Image mit Amazon kompatibel ist SageMaker, muss es einer bestimmten Dateistruktur entsprechen, damit SageMaker die Trainingsdaten und Konfigurationseingaben in bestimmte Pfade in Ihrem Container kopiert werden können. Nach Abschluss des Trainings werden die generierten Modellartefakte in einem bestimmten Verzeichnispfad in dem Container gespeichert, aus dem die SageMaker Kopien stammen.

Im Folgenden wird Docker verwendet, das in einer Entwicklungsumgebung auf einer Ubuntu-Distribution von Linux CLI installiert ist.

Bereiten Sie Ihr Programm darauf vor, Konfigurationseingaben zu lesen

Wenn Ihr Schulungsprogramm vom Käufer bereitgestellte Konfigurationseingaben erfordert, werden diese bei der Ausführung im Folgenden in Ihren Container kopiert. Falls erforderlich, muss Ihr Programm aus diesen spezifischen Dateipfaden lesen.

-

/opt/ml/input/configist das Verzeichnis, das Informationen enthält, die steuern, wie Ihr Programm ausgeführt wird.-

hyperparameters.jsonist ein Wörterbuch mit Namen und JSON Werten von Hyperparametern im -Format. Die Werte sind Zeichenketten, daher müssen Sie sie möglicherweise konvertieren. -

resourceConfig.jsonist eine Datei im JSON -Format, die das Netzwerklayout beschreibt, das für verteilte Schulungen verwendet wird. Wenn Ihr Trainingsimage verteiltes Training nicht unterstützt, können Sie diese Datei ignorieren.

-

Anmerkung

Weitere Informationen zu Konfigurationseingaben finden Sie unter So SageMaker stellt Amazon Schulungsinformationen bereit.

Bereiten Sie Ihr Programm für das Lesen von Dateneingaben vor

Trainingsdaten können in einem der folgenden beiden Modi an den Container übergeben werden. Ihr Trainingsprogramm, das im Container ausgeführt wird, verarbeitet die Trainingsdaten in einem dieser beiden Modi.

Dateimodus

-

/opt/ml/input/data/<channel_name>/enthält die Eingabedaten für diesen Kanal. Die Kanäle werden auf der Grundlage des Aufrufs derCreateTrainingJobOperation erstellt, aber es ist generell wichtig, dass die Kanäle den Erwartungen des Algorithmus entsprechen. Die Dateien für jeden Kanal werden von Amazon S3in dieses Verzeichnis kopiert, wobei die durch die Amazon S3 S3-Schlüsselstruktur angegebene Baumstruktur beibehalten wird.

Pipe-Modus

-

/opt/ml/input/data/<channel_name>_<epoch_number>ist die Pfeife für eine bestimmte Epoche. Epochen beginnen bei Null und nehmen jedes Mal, wenn Sie sie lesen, um eins zu. Die Anzahl der Epochen, die Sie ausführen können, ist unbegrenzt, aber Sie müssen jede Pipe schließen, bevor Sie die nächste Epoche lesen können.

Bereiten Sie Ihr Programm darauf vor, Trainingsergebnisse zu schreiben

Die Ausgabe des Trainings wird in die folgenden Containerverzeichnisse geschrieben:

-

/opt/ml/model/ist das Verzeichnis, in das Sie das Modell oder die Modellartefakte schreiben, die Ihr Trainingsalgorithmus generiert. Ihr Modell kann jedes beliebige Format haben. Es kann sich um eine einzelne Datei oder einen ganzen Verzeichnisbaum handeln. SageMaker packt alle Dateien in diesem Verzeichnis in eine komprimierte Datei (.tar.gz). Diese Datei ist an dem Amazon S3 S3-Speicherort verfügbar, der durch denDescribeTrainingJobAPI Vorgang zurückgegeben wurde. -

/opt/ml/output/ist ein Verzeichnis, in das der Algorithmus einefailureDatei schreiben kann, die beschreibt, warum der Job fehlgeschlagen ist. Der Inhalt dieser Datei wird imFailureReasonDescribeTrainingJobErgebnisfeld zurückgegeben. Bei erfolgreichen Aufträgen gibt es keinen Grund, diese Datei zu schreiben, da sie ignoriert wird.

Erstellen Sie das Skript für den Containerlauf

Erstellen Sie ein train Shell-Skript, das SageMaker ausgeführt wird, wenn es das Docker-Container-Image ausführt. Wenn das Training abgeschlossen ist und die Modellartefakte in ihre jeweiligen Verzeichnisse geschrieben wurden, beenden Sie das Skript.

./train

#!/bin/bash # Run your training program here # # # #

Erstellen der Dockerfile

Erstellen Sie Dockerfile in Ihrem Build-Kontext eine. In diesem Beispiel wird Ubuntu 18.04 als Basis-Image verwendet, aber Sie können mit jedem Basis-Image beginnen, das für Ihr Framework funktioniert.

./Dockerfile

FROM ubuntu:18.04 # Add training dependencies and programs # # # # # # Add a script that SageMaker will run # Set run permissions # Prepend program directory to $PATH COPY /train /opt/program/train RUN chmod 755 /opt/program/train ENV PATH=/opt/program:${PATH}

Das Dockerfile fügt das zuvor erstellte train Skript zum Image hinzu. Das Verzeichnis des Skripts wird dem hinzugefügt, PATH sodass es ausgeführt werden kann, wenn der Container ausgeführt wird.

Im vorherigen Beispiel gibt es keine tatsächliche Trainingslogik. Fügen Sie für Ihr aktuelles Trainingsimage die Trainingsabhängigkeiten zu und fügen Sie die Logik hinzuDockerfile, um die Trainingseingaben zu lesen, um die Modellartefakte zu trainieren und zu generieren.

Ihr Trainingsimage muss alle erforderlichen Abhängigkeiten enthalten, da es keinen Internetzugang haben wird.

Weitere Informationen finden Sie unter Verwenden Sie Ihre eigenen Algorithmen und Modelle mit den AWS Marketplace und den AWS Marketplace

SageMaker Beispielen

Schritt 2: Lokales Erstellen und Testen des Images

Im Build-Kontext existieren jetzt die folgenden Dateien:

-

./Dockerfile -

./train -

Ihre Trainingsabhängigkeiten und -logik

Als Nächstes können Sie dieses Container-Image erstellen, ausführen und testen.

Erstellen Sie das Image

Führen Sie den Docker-Befehl im Build-Kontext aus, um das Image zu erstellen und zu taggen. In diesem Beispiel wird das Tag my-training-image verwendet.

sudo docker build --tag my-training-image ./

Nachdem Sie diesen Docker-Befehl ausgeführt haben, um das Image zu erstellen, sollten Sie die Ausgabe sehen, während Docker das Image auf der Grundlage jeder Zeile in Ihrem erstellt. Dockerfile Wenn der Vorgang abgeschlossen ist, sollten Sie etwas Ähnliches wie das Folgende sehen.

Successfully built abcdef123456

Successfully tagged my-training-image:latestLokales Ausführen von

Nachdem dieser Vorgang abgeschlossen ist, testen Sie das Image lokal, wie im folgenden Beispiel gezeigt.

sudo docker run \ --rm \ --volume '<path_to_input>:/opt/ml/input:ro' \ --volume '<path_to_model>:/opt/ml/model' \ --volume '<path_to_output>:/opt/ml/output' \ --name my-training-container \ my-training-image \ train

Im Folgenden finden Sie Befehlsdetails:

-

--rm— Entfernt den Container automatisch, nachdem er gestoppt wurde. -

--volume '<path_to_input>:/opt/ml/input:ro'— Stellen Sie das Testeingabeverzeichnis für den Container schreibgeschützt zur Verfügung. -

--volume '<path_to_model>:/opt/ml/model'— Binden Sie den Pfad ein, in dem die Modellartefakte auf dem Host-Computer gespeichert sind, wenn der Trainingstest abgeschlossen ist. -

--volume '<path_to_output>:/opt/ml/output'— Binden Sie den Pfad, in den die Fehlerursache in einerfailureDatei auf dem Host-Computer geschrieben wird. -

--name my-training-container— Geben Sie diesem laufenden Container einen Namen. -

my-training-image— Führt das erstellte Image aus. -

train— SageMaker Führt dasselbe Skript aus, das beim Ausführen des Containers ausgeführt wird.

Nach der Ausführung dieses Befehls erstellt Docker einen Container aus dem von Ihnen erstellten Trainings-Image und führt ihn aus. Der Container führt das train Skript aus, das Ihr Trainingsprogramm startet.

Nachdem Ihr Trainingsprogramm abgeschlossen und der Container beendet wurde, überprüfen Sie, ob die Artefakte des Ausgabemodells korrekt sind. Überprüfen Sie außerdem die Protokollausgaben, um sicherzustellen, dass sie keine Protokolle erzeugen, die Sie nicht benötigen, und stellen Sie gleichzeitig sicher, dass genügend Informationen über den Trainingsjob bereitgestellt werden.

Damit ist das Packen Ihres Trainingscodes für ein Algorithmusprodukt abgeschlossen. Da ein Algorithmusprodukt auch ein Inferenzbild enthält, fahren Sie mit dem nächsten Abschnitt fort. Erstellen eines Inferenzbilds für Algorithmen

Erstellen eines Inferenzbilds für Algorithmen

Dieser Abschnitt bietet eine exemplarische Vorgehensweise zum Verpacken Ihres Inferenzcodes in ein Inferenzbild für Ihr Algorithmusprodukt.

Das Inferenz-Image ist ein Docker-Image, das Ihre Inferenzlogik enthält. Der Container stellt zur Laufzeit HTTP Endpunkte zur Verfügung, damit Daten zu und von SageMaker Ihrem Container übergeben werden können.

Bei der Veröffentlichung eines Algorithmusprodukts sind sowohl die Trainings- als auch die Inferenzbilder erforderlich. Falls Sie dies noch nicht getan haben, lesen Sie den vorherigen Abschnitt überEin Trainingsbild für Algorithmen erstellen. Die beiden Bilder können zu einem Bild kombiniert werden oder als separate Bilder verbleiben. Ob Sie die Bilder kombinieren oder trennen, liegt bei Ihnen. In der Regel ist Inferenz einfacher als Training, und Sie möchten möglicherweise separate Bilder verwenden, um die Leistung der Inferenz zu verbessern.

Anmerkung

Im Folgenden finden Sie nur ein Beispiel für einen Verpackungscode für ein Inferenzbild. Weitere Informationen finden Sie unter Verwenden Sie Ihre eigenen Algorithmen und Modelle mit den AWS Marketplace und den AWS Marketplace

SageMaker Beispielen

Das folgende Beispiel verwendet der Einfachheit halber einen Webdienst, Flask

Schritt 1: Erstellen des Inferenzbilds

Damit das Inferenz-Image kompatibel ist SageMaker, muss das Docker-Image Endpunkte verfügbar machen. HTTP Leitet während der Ausführung Ihres Containers die vom Käufer bereitgestellten Eingaben zur Inferenz an den Endpunkt Ihres Containers SageMaker weiter. HTTP Das Ergebnis der Inferenz wird im Hauptteil der HTTP Antwort zurückgegeben.

Im Folgenden wird Docker verwendet, das in einer Entwicklungsumgebung auf einer Ubuntu-Distribution von Linux CLI installiert ist.

Erstellen Sie das Webserver-Skript

In diesem Beispiel wird ein Python-Server namens Flask

Anmerkung

Flask

Erstellen Sie das Flask-Webserver-Skript, das die beiden HTTP Endpunkte auf dem verwendeten TCP Port 8080 bedient. SageMaker Im Folgenden sind die beiden erwarteten Endpunkte aufgeführt:

-

/ping— sendet SageMaker HTTP GET Anfragen an diesen Endpunkt, um zu überprüfen, ob Ihr Container bereit ist. Wenn Ihr Container bereit ist, antwortet er auf HTTP GET Anfragen an diesem Endpunkt mit einem HTTP 200-Antwortcode. -

/invocations— SageMaker stellt HTTP POST Anfragen zur Inferenz an diesen Endpunkt. Die Eingabedaten für die Inferenz werden im Hauptteil der Anfrage gesendet. Der vom Benutzer angegebene Inhaltstyp wird im Header übergeben. HTTP Der Hauptteil der Antwort ist die Inferenzausgabe.

./web_app_serve.py

# Import modules import json import re from flask import Flask from flask import request app = Flask(__name__) # Create a path for health checks @app.route("/ping") def endpoint_ping(): return "" # Create a path for inference @app.route("/invocations", methods=["POST"]) def endpoint_invocations(): # Read the input input_str = request.get_data().decode("utf8") # Add your inference code here. # # # # # # Add your inference code here. # Return a response with a prediction response = {"prediction":"a","text":input_str} return json.dumps(response)

Im vorherigen Beispiel gibt es keine tatsächliche Inferenzlogik. Fügen Sie für Ihr eigentliches Inferenzbild die Inferenzlogik zur Web-App hinzu, sodass sie die Eingabe verarbeitet und die Vorhersage zurückgibt.

Ihr Inferenzbild muss alle erforderlichen Abhängigkeiten enthalten, da es keinen Internetzugang haben wird.

Erstellen Sie das Skript für den Containerlauf

Erstellen Sie ein Skript mit dem Namenserve, das SageMaker ausgeführt wird, wenn es das Docker-Container-Image ausführt. Starten Sie in diesem Skript den HTTP Webserver.

./serve

#!/bin/bash # Run flask server on port 8080 for SageMaker flask run --host 0.0.0.0 --port 8080

Erstellen der Dockerfile

Erstellen Sie Dockerfile in Ihrem Build-Kontext eine. In diesem Beispiel wird Ubuntu 18.04 verwendet, aber Sie können mit jedem Basis-Image beginnen, das für Ihr Framework funktioniert.

./Dockerfile

FROM ubuntu:18.04 # Specify encoding ENV LC_ALL=C.UTF-8 ENV LANG=C.UTF-8 # Install python-pip RUN apt-get update \ && apt-get install -y python3.6 python3-pip \ && ln -s /usr/bin/python3.6 /usr/bin/python \ && ln -s /usr/bin/pip3 /usr/bin/pip; # Install flask server RUN pip install -U Flask; # Add a web server script to the image # Set an environment to tell flask the script to run COPY /web_app_serve.py /web_app_serve.py ENV FLASK_APP=/web_app_serve.py # Add a script that Amazon SageMaker will run # Set run permissions # Prepend program directory to $PATH COPY /serve /opt/program/serve RUN chmod 755 /opt/program/serve ENV PATH=/opt/program:${PATH}

Das Dockerfile fügt die beiden zuvor erstellten Skripte zum Image hinzu. Das Verzeichnis des serve Skripts wird dem hinzugefügt, PATH sodass es ausgeführt werden kann, wenn der Container ausgeführt wird.

Ihr Programm wird für das dynamische Laden von Modellartefakten vorbereitet

Bei Algorithmusprodukten verwendet der Käufer seine eigenen Datensätze mit Ihrem Trainingsbild, um einzigartige Modellartefakte zu generieren. Wenn der Trainingsprozess abgeschlossen ist, gibt Ihr Trainingscontainer Modellartefakte in das Container-Verzeichnis

/opt/ml/model/ aus. SageMaker komprimiert den Inhalt in diesem Verzeichnis in eine .tar.gz-Datei und speichert sie in der Datei des Käufers in Amazon S3. AWS-Konto

Wenn das Modell bereitgestellt wird, SageMaker führt es Ihr Inferenz-Image aus, extrahiert die Modellartefakte aus der .tar.gz-Datei, die im Konto des Käufers in Amazon S3 gespeichert ist, und lädt sie in den Inferenzcontainer im Verzeichnis. /opt/ml/model/ Zur Laufzeit verwendet Ihr Inferenzcontainer-Code die Modelldaten.

Anmerkung

Um jegliches geistiges Eigentum zu schützen, das möglicherweise in den Modellartefaktdateien enthalten ist, können Sie die Dateien vor der Ausgabe verschlüsseln. Weitere Informationen finden Sie unter Sicherheit und geistiges Eigentum bei Amazon SageMaker.

Schritt 2: Lokales Erstellen und Testen des Images

Im Build-Kontext existieren jetzt die folgenden Dateien:

-

./Dockerfile -

./web_app_serve.py -

./serve

Als Nächstes können Sie dieses Container-Image erstellen, ausführen und testen.

Erstellen Sie das Image

Führen Sie den Docker-Befehl aus, um das Image zu erstellen und zu taggen. In diesem Beispiel wird das Tag my-inference-image verwendet.

sudo docker build --tag my-inference-image ./

Nachdem Sie diesen Docker-Befehl ausgeführt haben, um das Image zu erstellen, sollten Sie die Ausgabe sehen, während Docker das Image auf der Grundlage jeder Zeile in Ihrem erstellt. Dockerfile Wenn der Vorgang abgeschlossen ist, sollten Sie etwas Ähnliches wie das Folgende sehen.

Successfully built abcdef123456

Successfully tagged my-inference-image:latestLokales Ausführen von

Nachdem Ihr Build abgeschlossen ist, können Sie das Image lokal testen.

sudo docker run \ --rm \ --publish 8080:8080/tcp \ --volume '<path_to_model>:/opt/ml/model:ro' \ --detach \ --name my-inference-container \ my-inference-image \ serve

Im Folgenden finden Sie Befehlsdetails:

-

--rm— Entfernt den Container automatisch, nachdem er gestoppt wurde. -

--publish 8080:8080/tcp— Machen Sie Port 8080 verfügbar, um zu simulieren, SageMaker an welchen Port HTTP Anfragen gesendet werden. -

--volume '<path_to_model>:/opt/ml/model:ro'— Binden Sie den Pfad an den Ort, an dem die Testmodellartefakte auf dem Host-Computer schreibgeschützt gespeichert sind, um sie Ihrem Inferenzcode im Container zur Verfügung zu stellen. -

--detach— Führt den Container im Hintergrund aus. -

--name my-inference-container— Geben Sie diesem laufenden Container einen Namen. -

my-inference-image— Führt das erstellte Image aus. -

serve— SageMaker Führt dasselbe Skript aus, das beim Ausführen des Containers ausgeführt wird.

Nach dem Ausführen dieses Befehls erstellt Docker einen Container aus dem Inferenz-Image und führt ihn im Hintergrund aus. Der Container führt das serve Skript aus, das Ihren Webserver zu Testzwecken startet.

Testen Sie den HTTP Ping-Endpunkt

Wenn Ihr Container SageMaker ausgeführt wird, pingt er regelmäßig den Endpunkt. Wenn der Endpunkt eine HTTP Antwort mit dem Statuscode 200 zurückgibt, signalisiert er ihm, SageMaker dass der Container für die Inferenz bereit ist.

Führen Sie den folgenden Befehl aus, um den Endpunkt zu testen und den Antwortheader einzubeziehen.

curl --include http://127.0.0.1:8080/ping

Das folgende Beispiel zeigt eine Beispielausgabe.

HTTP/1.0 200 OK

Content-Type: text/html; charset=utf-8

Content-Length: 0

Server: MyServer/0.16.0 Python/3.6.8

Date: Mon, 21 Oct 2019 06:58:54 GMTTesten Sie den Inferenzendpunkt HTTP

Wenn der Container anzeigt, dass er bereit ist, indem er einen Statuscode 200 SageMaker zurückgibt, leitet er die Inferenzdaten über eine POST Anfrage an den /invocations HTTP Endpunkt weiter.

Führen Sie den folgenden Befehl aus, um den Inferenzendpunkt zu testen.

curl \ --request POST \ --data "hello world" \ http://127.0.0.1:8080/invocations

Eine Beispielausgabe wird im folgenden Beispiel gezeigt..

{"prediction": "a", "text": "hello world"}Wenn diese beiden HTTP Endpunkte funktionieren, ist das Inferenzbild jetzt kompatibel mit. SageMaker

Anmerkung

Das Modell Ihres Algorithmusprodukts kann auf zwei Arten bereitgestellt werden: in Echtzeit und im Batch-Modus. SageMaker Verwendet für beide Bereitstellungen dieselben HTTP Endpunkte beim Ausführen des Docker-Containers.

Führen Sie den folgenden Befehl aus, um den Container zu beenden.

sudo docker container stop my-inference-container

Wenn sowohl Ihre Trainings- als auch die Inferenzbilder für Ihr Algorithmusprodukt fertig und getestet sind, fahren Sie fortIhre Bilder in die Amazon Elastic Container Registry hochladen.