Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Migrieren von ML Build, Training und Bereitstellung von Workloads zu Amazon SageMaker mithilfe von AWS-Entwicklertools

Erstellt von Scot Marvin (AWS)

R-Typ: Plattformwechsel | Quelle: Machine Learning | Ziel: Amazon SageMaker |

Erstellt von: AWS | Umgebung: PoC oder Pilotprojekt | Technologien: Machine Learning und KI DevOps; Migration |

AWS-Services: Amazon SageMaker |

Übersicht

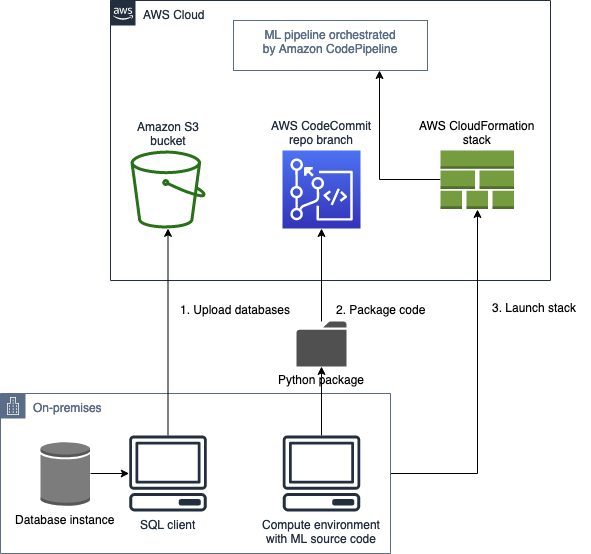

Dieses Muster bietet Anleitungen für die Migration einer On-Premises-Anwendung für Machine Learning (ML), die auf Unix- oder Linux-Servern ausgeführt wird, um auf AWS mit Amazon zu trainieren und bereitzustellen SageMaker. Diese Bereitstellung verwendet eine Pipeline für kontinuierliche Integration und kontinuierliche Bereitstellung (CI/CD). Das Migrationsmuster wird mithilfe eines AWS- CloudFormation Stacks bereitgestellt.

Voraussetzungen und Einschränkungen

Voraussetzungen

Ein aktives AWS-Konto, das AWS Landing Zone

verwendet AWS-Befehlszeilenschnittstelle (AWS CLI),

die auf Ihrem Unix- oder Linux-Server installiert und konfiguriert ist Ein ML-Quellcode-Repository in CodeCommit, GitHubAWS oder Amazon Simple Storage Service (Amazon S3)

Einschränkungen

In einer AWS-Region können nur 300 einzelne Pipelines bereitgestellt werden.

Dieses Muster ist für überwachte ML-Workloads mit train-and-deploy Code in Python vorgesehen.

Produktversionen

Docker-Version 19.03.5, Build 633a0ea, mit Python 3.6x

Architektur

Quelltechnologie-Stack

On-Premises-Linux-Compute-Instance mit Daten entweder im lokalen Dateisystem oder in einer relationalen Datenbank

Quellarchitektur

Zieltechnologie-Stack

AWS CodePipeline bereitgestellt mit Amazon S3 für die Datenspeicherung und Amazon DynamoDB als Metadatenspeicher für die Nachverfolgung oder Protokollierung von Pipeline-Ausführungen

Zielarchitektur

Architektur der Anwendungsmigration

Natives Python-Paket und AWS- CodeCommit Repository (und ein SQL-Client für On-Premises-Datensätze auf der Datenbank-Instance)

Tools

Python

Git

AWS CLI – Die AWS CLI

stellt den AWS- CloudFormation Stack bereit und verschiebt Daten in den S3-Bucket. Der S3-Bucket wiederum führt zum Ziel.

Polen

| Aufgabe | Beschreibung | Erforderliche Fähigkeiten |

|---|---|---|

| Validieren Sie Quellcode und Datensätze. | Data Scientist | |

| Identifizieren Sie die Instance-Typen und -Größen für die Erstellung, Schulung und Bereitstellung des Ziels. | Dateningenieur, Datenwissenschaftler | |

| Erstellen Sie eine Funktionsliste und Kapazitätsanforderungen. | ||

| Identifizieren Sie die Netzwerkanforderungen. | DBA, Systemadministrator | |

| Identifizieren Sie die Sicherheitsanforderungen für den Netzwerk- oder Hostzugriff für die Quell- und Zielanwendungen. | Dateningenieur, ML-Techniker, Systemadministrator | |

| Bestimmen Sie die Backup-Strategie. | ML-Techniker, Systemadministrator | |

| Bestimmen Sie die Verfügbarkeitsanforderungen. | ML-Techniker, Systemadministrator | |

| Identifizieren Sie die Migrations- oder Umstellungsstrategie der Anwendung. | Datenwissenschaftler, ML-Techniker |

| Aufgabe | Beschreibung | Erforderliche Fähigkeiten |

|---|---|---|

| Erstellen einer Virtual Private Cloud (VPC). | ML-Techniker, Systemadministrator | |

| Erstellen Sie Sicherheitsgruppen. | ML-Techniker, Systemadministrator | |

| Richten Sie einen Amazon S3-Bucket und AWS- CodeCommit Repository-Verzweigungen für ML-Code ein. | ML-Techniker |

| Aufgabe | Beschreibung | Erforderliche Fähigkeiten |

|---|---|---|

| Verwenden Sie native MySQL-Tools oder Tools von Drittanbietern, um Trainings-, Validierungs- und Testdatensätze in den bereitgestellten S3-Bucket zu migrieren. | Dies ist für die AWS- CloudFormation Stack-Bereitstellung erforderlich. | Dateningenieur, ML-Ingenieur |

| Verpacken Sie den ML-Trainings- und Hosting-Code als Python-Pakete und pushen Sie in das bereitgestellte Repository in AWS CodeCommit oder GitHub. | Sie benötigen den Verzweigungsnamen des Repositorys, um die AWS- CloudFormation Vorlage für die Migration bereitzustellen. | Datenwissenschaftler, ML-Techniker |

| Aufgabe | Beschreibung | Erforderliche Fähigkeiten |

|---|---|---|

| Folgen Sie der ML-Workload-Migrationsstrategie. | Anwendungsbesitzer, ML-Techniker | |

| Stellen Sie den AWS- CloudFormation Stack bereit. | Verwenden Sie die AWS CLI, um den Stack zu erstellen, der in der YAML-Vorlage deklariert ist, die mit dieser Lösung bereitgestellt wird. | Datenwissenschaftler, ML-Techniker |

| Aufgabe | Beschreibung | Erforderliche Fähigkeiten |

|---|---|---|

| Stellen Sie die Anwendungsclients auf die neue Infrastruktur um. | Anwendungseigentümer, Datenwissenschaftler, ML-Techniker |

| Aufgabe | Beschreibung | Erforderliche Fähigkeiten |

|---|---|---|

| Fahren Sie die temporären AWS-Ressourcen herunter. | Fahren Sie alle benutzerdefinierten Ressourcen aus der AWS- CloudFormation Vorlage herunter (z. B. alle AWS Lambda-Funktionen, die nicht verwendet werden). | Datenwissenschaftler, ML-Techniker |

| Überprüfen und validieren Sie die Projektdokumente. | Anwendungsbesitzer, Datenwissenschaftler | |

| Validieren Sie die Ergebnisse und die Metriken zur ML-Modellbewertung mit Operatoren. | Stellen Sie sicher, dass die Modellleistung den Erwartungen der Anwendungsbenutzer entspricht und mit dem On-Premises-Status vergleichbar ist. | Anwendungsbesitzer, Datenwissenschaftler |

| Schließen Sie das Projekt ab und geben Sie Feedback. | Anwendungsbesitzer, ML-Techniker |

Zugehörige Ressourcen

Anlagen

Um auf zusätzliche Inhalte zuzugreifen, die diesem Dokument zugeordnet sind, entpacken Sie die folgende Datei: attachment.zip