Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Infrastructure OU — Netzwerkkonto

| Beeinflussen Sie die future der AWS Security Reference Architecture (AWS SRA), indem Sie an einer kurzen Umfrage teilnehmen |

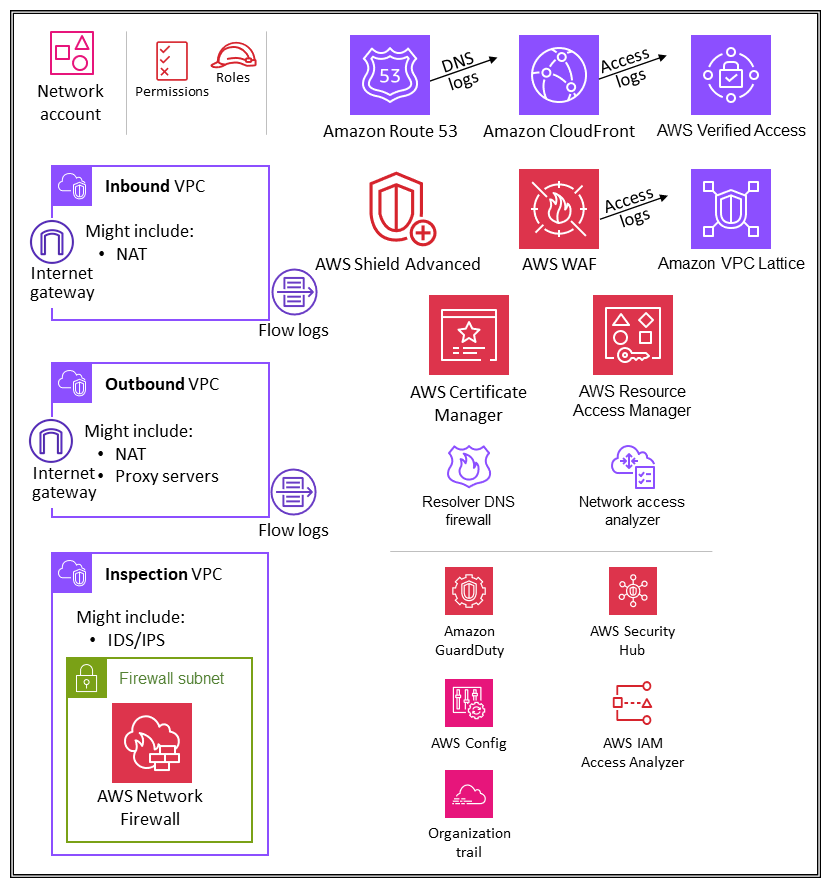

Das folgende Diagramm zeigt die AWS-Sicherheitsservices, die in dem Netzwerkkonto konfiguriert werden.

Das Netzwerkkonto verwaltet das Gateway zwischen Ihrer Anwendung und dem weiteren Internet. Es ist wichtig, diese bidirektionale Schnittstelle zu schützen. Das Netzwerkkonto isoliert die Netzwerkservices, die Konfiguration und den Betrieb von den Workloads, der Sicherheit und anderen Infrastrukturen der einzelnen Anwendungen. Diese Regelung schränkt nicht nur Konnektivität, Berechtigungen und Datenfluss ein, sondern unterstützt auch die Aufgabentrennung und die geringsten Berechtigungen für die Teams, die mit diesen Konten arbeiten müssen. Durch die Aufteilung des Netzwerkflusses in separate eingehende und ausgehende virtuelle private Clouds (VPCs) können Sie sensible Infrastrukturen und vertraulichen Datenverkehr vor unerwünschtem Zugriff schützen. Das eingehende Netzwerk gilt allgemein als risikoreicher und verdient eine angemessene Weiterleitung, Überwachung und mögliche Problembehebung. Diese Infrastrukturkonten erben die Zugriffsberechtigungen des Organisationsverwaltungskontos und der Infrastruktur-OE. Teams für Netzwerk und Sicherheits verwalten den Großteil der Infrastruktur in diesem Konto.

Netzwerkarchitektur

Obwohl Netzwerkdesign und -spezifikationen den Rahmen dieses Dokuments sprengen würden, empfehlen wir diese drei Optionen für die Netzwerkkonnektivität zwischen den verschiedenen Konten: VPC-Peering PrivateLink, AWS und AWS Transit Gateway. Wichtige Überlegungen bei der Auswahl dieser Optionen sind Betriebsnormen, Budgets und spezifische Bandbreitenanforderungen.

-

VPC-Peering ‒ Die einfachste Methode, zwei miteinander zu verbinden, VPCs ist die Verwendung von VPC-Peering. Eine Verbindung ermöglicht eine vollständige bidirektionale Konnektivität zwischen den. VPCs VPCs die sich in separaten Konten und AWS-Regionen befinden, können auch miteinander verbunden werden. Im großen Maßstab, wenn Sie Dutzende bis Hunderte von Peering-Verbindungen haben VPCs, führt die Verbindung dieser Verbindungen mit Peering zu einem Geflecht von Hunderten bis Tausenden von Peering-Verbindungen, was schwierig zu verwalten und zu skalieren sein kann. VPC-Peering eignet sich am besten, wenn Ressourcen in einer VPC mit Ressourcen in einer anderen VPC kommunizieren müssen, die Umgebung beider kontrolliert und gesichert VPCs wird und die Anzahl der VPCs zu verbindenden Ressourcen weniger als 10 beträgt (um die individuelle Verwaltung jeder Verbindung zu ermöglichen).

-

AWS PrivateLink

‒ PrivateLink bietet private Konnektivität zwischen VPCs Services und Anwendungen. Sie können Ihre eigene Anwendung in Ihrer VPC erstellen und sie als PrivateLink -gestützten Dienst (als Endpunktdienst bezeichnet) konfigurieren. Andere AWS-Prinzipale können je nach Art des Services über einen Schnittstellen-VPC-Endpunkt oder einen Gateway-Load-Balancer-Endpunkt eine Verbindung von ihrer VPC zu Ihrem Endpunkt-Service herstellen. Wenn Sie den Dienst verwenden PrivateLink, wird der Datenverkehr nicht über ein öffentlich routbares Netzwerk geleitet. Verwenden Sie diese Option, PrivateLink wenn Sie über ein Client-Server-Setup verfügen, in dem Sie einem oder mehreren Verbrauchern VPCs unidirektionalen Zugriff auf einen bestimmten Dienst oder eine Gruppe von Instanzen in der Service Provider-VPC gewähren möchten. Dies ist auch eine gute Option, wenn sich die IP-Adressen der Clients und Server der beiden VPCs überschneiden, da elastische Netzwerkschnittstellen innerhalb der Client-VPC PrivateLink verwendet werden, sodass keine IP-Konflikte mit dem Dienstanbieter auftreten. -

AWS Transit Gateway

‒ Transit Gateway bietet ein hub-and-spoke Design für Verbindungen VPCs und lokale Netzwerke als vollständig verwalteten Service, ohne dass Sie virtuelle Appliances bereitstellen müssen. AWS verwaltet Hochverfügbarkeit und Skalierbarkeit. Ein Transit-Gateway ist eine regionale Ressource und kann Tausende von Personen VPCs innerhalb derselben AWS-Region verbinden. Sie können Ihre Hybrid-Konnektivität (VPN- und AWS-Direct-Connect-Verbindungen) mit einem einzigen Transit-Gateway verbinden und so die gesamte Routing-Konfiguration Ihrer AWS-Organisation an einem Ort konsolidieren und kontrollieren. Ein Transit-Gateway löst die Komplexität, die mit der Erstellung und Verwaltung mehrerer VPC-Peering-Verbindungen in großem Maßstab verbunden ist. Dies ist die Standardeinstellung für die meisten Netzwerkarchitekturen, aber aufgrund spezifischer Anforderungen in Bezug auf Kosten, Bandbreite und Latenz ist VPC-Peering möglicherweise besser für Ihre Anforderungen geeignet.

Eingehende (Erfassungs)-VPC

Die eingehende VPC soll Netzwerkverbindungen akzeptieren, überprüfen und weiterleiten, die außerhalb der Anwendung initiiert wurden. Abhängig von den Besonderheiten der Anwendung können Sie mit einer gewissen Network Address Translation (NAT) in dieser VPC rechnen. Flow-Protokolle von dieser VPC werden erfasst und im Protokollarchiv-Konto gespeichert.

Ausgehende (Ausgabe)-VPC

Die ausgehende VPC ist für die Verarbeitung von Netzwerkverbindungen vorgesehen, die von der Anwendung aus initiiert werden. Abhängig von den Besonderheiten der Anwendung können Sie erwarten, dass Sie Datenverkehr-NAT, AWS-Servicespezifische VPC-Endpunkte und das Hosten externer API-Endpunkte in dieser VPC sehen. Flow-Protokolle von dieser VPC werden erfasst und im Protokollarchiv-Konto gespeichert.

Überprüfungs-VPC

Eine spezielle Inspektions-VPC bietet einen vereinfachten und zentralen Ansatz für die Verwaltung von Inspektionen zwischen VPCs (in derselben oder in verschiedenen AWS-Regionen), dem Internet und lokalen Netzwerken. Stellen Sie für die AWS-SRA sicher, dass der gesamte Datenverkehr zwischen den Inspektionen die Inspektions-VPC VPCs durchläuft, und vermeiden Sie es, die Inspektions-VPC für andere Workloads zu verwenden.

AWS Network Firewall

AWS Network Firewall

Sie verwenden in Ihrer VPC eine Firewall pro Availability Zone. Für jede Availability Zone wählen Sie ein Subnetz aus, das den Firewall-Endpunkt hostet, der Ihren Datenverkehr filtert. Der Firewall-Endpunkt in einer Availability Zone kann alle Subnetze innerhalb der Zone schützen, mit Ausnahme des Subnetzes, in dem er sich befindet. Je nach Anwendungsfall und Bereitstellungsmodell kann das Firewall-Subnetz entweder öffentlich oder privat sein. Die Firewall ist für den eingehenden oder ausgehenden Datenverkehr vollständig transparent und führt keine Network Address Translation (NAT) durch. Sie behält die Quell- und Zieladresse bei. In dieser Referenzarchitektur werden die Firewall-Endpunkte in einer Überprüfungs-VPC gehostet. Der gesamte Datenverkehr von der eingehenden VPC und zur ausgehenden VPC wird zur Überprüfung durch dieses Firewall-Subnetz geleitet.

Die Network Firewall macht Firewall-Aktivitäten anhand von CloudWatch Amazon-Metriken in Echtzeit sichtbar und bietet eine bessere Sichtbarkeit des Netzwerkverkehrs, indem Protokolle an Amazon Simple Storage Service (Amazon S3) und Amazon Data Firehose gesendet werden. CloudWatch Network Firewall ist mit Ihrem bestehenden Sicherheitsansatz kompatibel, einschließlich Technologien von AWS-Partnern

In der AWS-SRA wird Network Firewall innerhalb des Netzwerkkontos verwendet, da die auf Netzwerksteuerung ausgerichtete Funktionalität des Service mit der Absicht des Kontos übereinstimmt.

Designüberlegungen

-

AWS Firewall Manager unterstützt Network Firewall, sodass Sie Network-Firewall-Regeln zentral in Ihrem Unternehmen konfigurieren und bereitstellen können. (Einzelheiten finden Sie in der AWS-Dokumentation unter AWS-Network-Firewall-Richtlinien.) Wenn Sie Firewall Manager konfigurieren, erstellt er automatisch eine Firewall mit Regelsätzen in den Konten VPCs , die Sie angeben. Außerdem wird für jede Availability Zone, die öffentliche Subnetze enthält, ein Endpunkt in einem dedizierten Subnetz bereitgestellt. Gleichzeitig werden alle Änderungen am zentral konfigurierten Regelsatz automatisch nachgelagert auf den bereitgestellten Firewalls von Network Firewall aktualisiert.

-

Mit Network Firewall sind mehrere Bereitstellungsmodelle

verfügbar. Welchen Ansatz Sie wählen, hängt von Ihrem Anwendungsfall und Ihren Anforderungen ab. Beispiele sind unter anderem: -

Ein verteiltes Bereitstellungsmodell, bei dem die Network Firewall einzeln bereitgestellt wird VPCs.

-

Ein zentralisiertes Bereitstellungsmodell, bei dem Network Firewall in einer zentralen VPC für Ost-West-(VPC-zu-VPC) oder Nord-Süd-Datenverkehr (ausgehender und eingehender Internetzugriff, On-Premises) bereitgestellt wird.

-

Ein kombiniertes Bereitstellungsmodell, bei dem Network Firewall in einer zentralen VPC für den Ost-West- und einen Teil des Nord-Süd-Datenverkehrs bereitgestellt wird.

-

-

Es ist eine bewährte Methode, das Network-Firewall-Subnetz nicht für die Bereitstellung sonstiger Services zu verwenden. Dies liegt daran, dass Network Firewall den Datenverkehr von Quellen oder Zielen innerhalb des Firewall-Subnetzes nicht überprüfen kann.

Network Access Analyzer

Network Access Analyzer ist ein Feature von Amazon VPC, das unbeabsichtigten Zugriff auf Ihre Ressourcen identifiziert. Sie können Network Access Analyzer verwenden, um die Netzwerksegmentierung zu validieren, Ressourcen zu identifizieren, auf die über das Internet oder nur über vertrauenswürdige IP-Adressbereiche zugegriffen werden kann, und um zu überprüfen, ob Sie über angemessene Netzwerkkontrollen für alle Netzwerkpfade verfügen.

Network Access Analyzer verwendet Automated-Reasoning-Algorithmen, um die Netzwerkpfade zu analysieren, die ein Paket zwischen Ressourcen in einem AWS-Netzwerk nehmen kann, und liefert Ergebnisse für Pfade, die Ihrem definierten Network Access Scope entsprechen. Network Access Analyzer führt eine statische Analyse einer Netzwerkkonfiguration durch, was bedeutet, dass im Rahmen dieser Analyse keine Pakete im Netzwerk übertragen werden.

Die Regeln von Amazon Inspector Network Reachability bieten ein verwandtes Feature. Die durch diese Regeln generierten Ergebnisse werden im Anwendungskonto verwendet. Sowohl Network Access Analyzer als auch Network Reachability verwenden die neueste Technologie der AWS Provable Security Initiative

Das Netzwerkkonto definiert die kritische Netzwerkinfrastruktur, die den Datenverkehr in und aus Ihrer AWS-Umgebung steuert. Dieser Datenverkehr muss genau überwacht werden. In der AWS-SRA wird Network Access Analyzer innerhalb des Netzwerkkontos verwendet, um unbeabsichtigten Netzwerkzugriff zu identifizieren, über Internet-Gateways zugängliche Ressourcen zu identifizieren und zu überprüfen, ob geeignete Netzwerkkontrollen wie Netzwerk-Firewalls und NAT-Gateways auf allen Netzwerkpfaden zwischen Ressourcen und Internet-Gateways vorhanden sind.

Designüberlegung

-

Network Access Analyzer ist ein Feature von Amazon VPC und kann in jedem AWS-Konto verwendet werden, das über eine VPC verfügt. Netzwerkadministratoren können kontenübergreifende IAM-Rollen mit eng abgegrenztem Umfang einrichten, um zu überprüfen, ob die genehmigten Netzwerkpfade innerhalb eines jeden AWS-Kontos durchgesetzt werden.

AWS RAM

Mit AWS Resource Access Manager

Mit AWS RAM können Sie Ressourcen gemeinsam nutzen, die keine ressourcenbasierten IAM-Richtlinien unterstützen, wie VPC-Subnetze und Route-53-Regeln. Darüber hinaus können die Besitzer einer Ressource mit AWS RAM sehen, welche Prinzipale Zugriff auf einzelne Ressourcen haben, die sie gemeinsam genutzt haben. IAM-Entitäten können die Liste der Ressourcen, die für sie freigegeben wurden, direkt abrufen. Dies ist bei Ressourcen, die im Rahmen von IAM-Ressourcenrichtlinien gemeinsam genutzt werden, nicht möglich. Wenn AWS RAM zur gemeinsamen Nutzung von Ressourcen außerhalb Ihrer AWS-Organisation verwendet wird, wird ein Einladungsprozess eingeleitet. Der Empfänger muss die Einladung annehmen, bevor der Zugriff auf die Ressourcen gewährt wird. Dies bietet zusätzliche gegenseitige Kontrollen.

AWS RAM wird vom Ressourcenbesitzer in dem Konto aufgerufen und verwaltet, in dem die gemeinsam genutzte Ressource bereitgestellt wird. Ein häufiger Anwendungsfall für AWS RAM, der in der AWS-SRA veranschaulicht wird, besteht darin, dass Netzwerkadministratoren VPC-Subnetze und Transit-Gateways für die gesamte AWS-Organisation freigeben. Dies ermöglicht die Entkopplung der AWS-Konto- und Netzwerkverwaltungsfunktionen und trägt zur Aufgabentrennung bei. Weitere Informationen zu den Vorteilen der VPC-Freigabe finden Sie im AWS-Blogeintrag VPC-Freigabe: Ein neuer Ansatz für mehrere Konten und VPC-Verwaltung

Designüberlegung

-

Obwohl AWS-RAM-as-a-Service nur innerhalb des Netzwerkkontos in der AWS-SRA bereitgestellt wird, wird es normalerweise in mehr als einem Konto bereitgestellt. Sie können beispielsweise Ihr Data-Lake-Management auf einem einzigen Data-Lake-Konto zentralisieren und dann die Datenkatalogressourcen (Datenbanken und Tabellen) von AWS Lake Formation mit anderen Konten in Ihrer AWS-Organisation teilen. Weitere Informationen finden Sie in der Dokumentation zu AWS Lake Formation und im AWS-Blogbeitrag Sichere Freigabe Ihrer Daten zwischen AWS-Konten mithilfe von AWS Lake Formation

. Darüber hinaus können Sicherheitsadministratoren AWS RAM verwenden, um beim Aufbau einer AWS Private CA Hierarchie bewährte Methoden zu befolgen. CAs kann mit externen Dritten geteilt werden, die Zertifikate ausstellen können, ohne Zugriff auf die CA-Hierarchie zu haben. Auf diese Weise können Quellorganisationen den Zugriff Dritter einschränken und entziehen.

AWS Verified Access

AWS Verified Access

Verified Access unterstützt zwei gängige Muster von Unternehmensanwendungen: interne Anwendungen und Internetanwendungen. Verified Access lässt sich mithilfe von Application Load Balancers oder elastischen Netzwerkschnittstellen in Anwendungen integrieren. Wenn Sie einen Application Load Balancer verwenden, benötigt Verified Access einen internen Load Balancer. Da Verified Access AWS WAF auf Instance-Ebene unterstützt, kann eine bestehende Anwendung, die über eine AWS-WAF-Integration mit einem Application Load Balancer verfügt, Richtlinien vom Load Balancer auf die Verified-Access-Instance verschieben. Eine Unternehmensanwendung wird als Verified-Access-Endpunkt dargestellt. Jeder Endpunkt ist einer Verified-Access-Gruppe zugeordnet und erbt die Zugriffsrichtlinie für die Gruppe. Eine Verified-Access-Gruppe besteht aus einer Sammlung von Verified-Access-Endpunkten und einer Verified-Access-Richtlinie auf Gruppenebene. Gruppen vereinfachen die Richtlinienverwaltung und ermöglichen es IT-Administratoren, grundlegende Kriterien festzulegen. Anwendungsbesitzer können je nach Sensibilität der Anwendung weitere detaillierte Richtlinien definieren.

In der AWS-SRA wird Verified Access innerhalb des Netzwerkkontos gehostet. Das zentrale IT-Team richtet zentral verwaltete Konfigurationen ein. Sie können beispielsweise Vertrauensanbieter wie Identitätsanbieter (z. B. Okta) und Anbieter von Gerätevertrauensstellungen (z. B. Jamf) miteinander verbinden, Gruppen erstellen und die Richtlinien auf Gruppenebene festlegen. Diese Konfigurationen können dann mithilfe von AWS Resource Access Manager (AWS RAM) für Dutzende, Hunderte oder Tausende von Workload-Konten freigegeben werden. Auf diese Weise können Anwendungsteams die zugrunde liegenden Endpunkte verwalten, die ihre Anwendungen verwalten, ohne dass andere Teams zusätzliche Kosten verursachen. AWS RAM bietet eine skalierbare Möglichkeit, Verified Access für Unternehmensanwendungen zu nutzen, die auf verschiedenen Workload-Konten gehostet werden.

Designüberlegung

-

Sie können Endpunkte für Anwendungen mit ähnlichen Sicherheitsanforderungen gruppieren, um die Richtlinienverwaltung zu vereinfachen, und die Gruppe dann mit Anwendungskonten teilen. Alle Anwendungen in der Gruppe verwenden dieselbe Gruppenrichtlinie. Wenn für eine Anwendung in der Gruppe aufgrund eines besonderen Anwendungsfalls eine bestimmte Richtlinie erforderlich ist, können Sie für diese Anwendung eine Richtlinie auf Anwendungsebene anwenden.

Amazon VPC Lattice

Amazon VPC Lattice

VPC Lattice ist in AWS Resource Access Manager (AWS RAM) integriert, um die Freigabe von Services und Servicenetzwerken zu ermöglichen. AWS SRA stellt eine verteilte Architektur dar, in der Entwickler oder Servicebesitzer VPC-Lattice-Services in ihrem Anwendungskonto erstellen. Servicebesitzer definieren die Listener, Routing-Regeln und Zielgruppen zusammen mit Authentifizierungsrichtlinien. Anschließend geben sie die Services für andere Konten frei und ordnen die Services VPC-Lattice-Servicenetzwerken zu. Diese Netzwerke werden von Netzwerkadministratoren im Netzwerkkonto erstellt und mit dem Anwendungskonto gemeinsam genutzt. Netzwerkadministratoren konfigurieren die Authentifizierungsrichtlinien und die Überwachung von Services auf Netzwerkebene. Administratoren ordnen VPCs VPC-Lattice-Dienste einem oder mehreren Servicenetzwerken zu. Eine ausführliche Anleitung zu dieser verteilten Architektur finden Sie im AWS-Blogbeitrag Mit Amazon VPC Lattice sichere Multi-Konto-/Multi-VPC-Verbindungen für Ihre Anwendungen entwickeln

Designüberlegung

-

Je nach dem Betriebsmodell Ihres Unternehmens oder der Sichtbarkeit des Servicenetzwerks können Netzwerkadministratoren ihre Dienstnetzwerke gemeinsam nutzen und den Dienstbesitzern die Kontrolle darüber geben, ihre Dienste und VPCs diesen Dienstnetzwerken zuzuordnen. Oder Servicebesitzer können ihre Services gemeinsam nutzen, und Netzwerkadministratoren können die Services Servicenetzwerken zuordnen.

Ein Client kann nur Anfragen an Services senden, die einem Servicenetzwerk zugeordnet sind, wenn sich der Client in einer VPC befindet, die demselben Servicenetzwerk zugeordnet ist. Client-Datenverkehr, der eine VPC-Peering-Verbindung oder ein Transit-Gateway durchquert, wird verweigert.

Edge-Sicherheit

Edge-Sicherheit umfasst im Allgemeinen drei Arten von Schutzmaßnahmen: sichere Inhaltsbereitstellung, Schutz auf Netzwerk- und Anwendungsebene sowie Abwehr von verteilten Denial-of-Service-Angriffen (DDoS). Inhalte wie Daten, Videos und Anwendungen APIs müssen schnell und sicher bereitgestellt werden, wobei die empfohlene Version von TLS zur Verschlüsselung der Kommunikation zwischen Endpunkten verwendet wird. Für den Inhalt sollten außerdem Zugriffsbeschränkungen durch signierte URLs, signierte Cookies und Token-Authentifizierung gelten. Die Sicherheit auf Anwendungsebene sollte darauf ausgelegt sein, den Bot-Verkehr zu kontrollieren, gängige Angriffsmuster wie SQL-Injection oder Cross-Site Scripting (XSS) zu blockieren und Sichbarkeit des Web-Datenverkehrs gewährleisten. Am Netzwerkrand bietet DDo S-Mitigation eine wichtige Schutzschicht, die die kontinuierliche Verfügbarkeit geschäftskritischer Geschäftsabläufe und Dienste gewährleistet. Anwendungen und Anwendungen APIs sollten vor SYN-Floods, UDP-Floods oder anderen Reflection-Angriffen geschützt sein und über eine integrierte Abwehr verfügen, um grundlegende Angriffe auf Netzwerkebene zu stoppen.

AWS bietet verschiedene Services zur Bereitstellung einer sicheren Umgebung, von der Core-Cloud bis zum Edge des AWS-Netzwerks. Amazon CloudFront, AWS Certificate Manager (ACM), AWS Shield, AWS WAF und Amazon Route 53 arbeiten zusammen, um einen flexiblen, mehrschichtigen Sicherheitsperimeter zu schaffen. Mit Amazon CloudFront können Inhalte oder Anwendungen über HTTPS bereitgestellt werden APIs, indem TLSv1 .3 verwendet wird, um die Kommunikation zwischen Viewer-Clients und zu verschlüsseln und CloudFront zu sichern. Sie können ACM verwenden, um ein benutzerdefiniertes SSL-Zertifikat

Amazon CloudFront

Amazon CloudFront

CloudFront bietet mehrere Optionen, um den Zugriff auf Ihre Inhalte zu sichern und einzuschränken. Beispielsweise kann es den Zugriff auf Ihren Amazon S3 S3-Ursprung einschränken, indem es signierte URLs und signierte Cookies verwendet. Weitere Informationen finden Sie in der CloudFront Dokumentation unter Konfiguration des sicheren Zugriffs und Beschränkung des Zugriffs auf Inhalte.

Die AWS-SRA veranschaulicht zentralisierte CloudFront Verteilungen im Netzwerkkonto, da sie dem zentralisierten Netzwerkmuster entsprechen, das mithilfe von Transit Gateway implementiert wird. Durch die Bereitstellung und Verwaltung von CloudFront Verteilungen im Netzwerkkonto profitieren Sie von den Vorteilen zentraler Steuerungen. Sie können alle CloudFront Distributionen an einem zentralen Ort verwalten, was es einfacher macht, den Zugriff zu kontrollieren, Einstellungen zu konfigurieren und die Nutzung über alle Konten hinweg zu überwachen. Darüber hinaus können Sie die ACM-Zertifikate, DNS-Einträge und die CloudFront Protokollierung von einem zentralen Konto aus verwalten. Das CloudFront Sicherheits-Dashboard bietet Transparenz und Kontrollen von AWS WAF direkt in Ihrer CloudFront Distribution. Sie erhalten Einblick in die wichtigsten Sicherheitstrends Ihrer Anwendung, den erlaubten und blockierten Datenverkehr sowie die Bot-Aktivitäten. Sie können Ermittlungstools wie visuelle Protokollanalysen und integrierte Blockierungskontrollen verwenden, um Datenverkehrsmuster zu isolieren und den Datenverkehr zu blockieren, ohne Protokolle abzufragen oder Sicherheitsregeln zu schreiben.

Designüberlegungen

-

Alternativ können Sie die Anwendung auch CloudFront als Teil der Anwendung im Anwendungskonto bereitstellen. In diesem Szenario trifft das Anwendungsteam beispielsweise Entscheidungen darüber, wie die CloudFront Distributionen bereitgestellt werden, legt die geeigneten Cache-Richtlinien fest und übernimmt die Verantwortung für die Verwaltung, Prüfung und Überwachung der CloudFront Distributionen. Durch die Verteilung der CloudFront Distributionen auf mehrere Konten können Sie von zusätzlichen Servicekontingenten profitieren. Ein weiterer Vorteil CloudFront ist, dass Sie die inhärente und automatisierte Origin Access Identity (OAI) und Origin Access Control (OAC) -Konfiguration verwenden können, um den Zugriff auf Amazon S3 S3-Ursprünge einzuschränken.

-

Wenn Sie Webinhalte über ein CDN bereitstellen, müssen Sie verhindern CloudFront, dass Zuschauer das CDN umgehen und direkt auf Ihre ursprünglichen Inhalte zugreifen. Um diese Ausgangszugriffsbeschränkung zu erreichen, können Sie eine AWS WAF verwenden CloudFront , um benutzerdefinierte Header hinzuzufügen und die Header zu überprüfen, bevor Sie Anfragen an Ihren benutzerdefinierten Ursprung weiterleiten. Eine ausführliche Erläuterung dieser Lösung finden Sie im AWS-Sicherheits-Blogbeitrag How to enhance Amazon CloudFront Origin Security with AWS WAF and AWS Secrets Manager

. Eine alternative Methode besteht darin, nur die CloudFront Präfixliste in der Sicherheitsgruppe einzuschränken, die dem Application Load Balancer zugeordnet ist. Dadurch wird sichergestellt, dass nur eine CloudFront Distribution auf den Load Balancer zugreifen kann.

AWS WAF

AWS WAF

AWS WAF verwendet Web-Zugriffskontrolllisten (ACLs), um eine Reihe von AWS-Ressourcen zu schützen. Eine Web-ACL ist ein Satz von Regeln, welche die Überprüfungskriterien sowie eine zugeordnete Maßnahme definieren (Blockieren, Erlauben, Zählen oder Bot Control ausführen), wenn eine Web-Anforderung den Kriterien entspricht. AWS WAF bietet einen Satz von verwalteten Regeln

AWS WAF bietet eine Reihe intelligenter, stufenweise verwalteter Regeln für allgemeine und gezielte Bots und den Schutz vor Kontoübernahmen (ATP). Ihnen werden eine Abonnementgebühr und eine Gebühr für die Datenverkehrs-Überprüfung berechnet, wenn Sie die Regelgruppen Bot Control und ATP verwenden. Wir empfehlen daher, dass Sie zuerst den Datenverkehr überwachen und sich erst dann für eine Option entscheiden. Sie können die Dashboards für Bot-Management und Kontoübernahme verwenden, die kostenlos auf der AWS-WAF-Konsole verfügbar sind, um diese Aktivitäten zu überwachen und dann zu entscheiden, ob Sie eine intelligente, abgestufte AWS-WAF-Regelgruppe benötigen.

In der AWS-SRA ist AWS WAF CloudFront in das Netzwerkkonto integriert. In dieser Konfiguration erfolgt die WAF-Regelverarbeitung an den Edge-Standorten statt innerhalb der VPC. Auf diese Weise kann bösartiger Datenverkehr näher am Endbenutzer gefiltert werden, der den Inhalt angefordert hat, und verhindert, dass bösartiger Datenverkehr in Ihr Kernnetzwerk gelangt.

Sie können vollständige AWS-WAF-Protokolle an einen S3-Bucket im Log-Archive-Konto senden, indem Sie den kontoübergreifenden Zugriff auf den S3-Bucket konfigurieren. Weitere Informationen finden Sie im AWS-re:Post-Artikel

Designüberlegungen

-

Als Alternative zur zentralen Bereitstellung von AWS WAF im Netzwerkkonto lassen sich einige Anwendungsfälle besser durch die Bereitstellung von AWS WAF im Anwendungskonto erfüllen. Sie können diese Option beispielsweise wählen, wenn Sie Ihre CloudFront Distributionen in Ihrem Anwendungskonto bereitstellen oder öffentlich zugängliche Application Load Balancer haben oder wenn Sie Amazon API Gateway vor Ihren Webanwendungen verwenden. Wenn Sie sich entscheiden, AWS WAF in jedem Anwendungskonto bereitzustellen, verwenden Sie AWS Firewall Manager, um die AWS-WAF-Regeln in diesen Konten vom zentralen Security-Tooling-Konto aus zu verwalten.

-

Sie können auch allgemeine AWS-WAF-Regeln auf der CloudFront Ebene und zusätzliche anwendungsspezifische AWS-WAF-Regeln auf einer regionalen Ressource wie dem Application Load Balancer oder dem API-Gateway hinzufügen.

AWS Shield

AWS Shield

Sie können die automatische Abwehr auf Anwendungsebene DDo S von Shield Advanced verwenden, um Shield Advanced so zu konfigurieren, dass es automatisch reagiert, um Angriffe der Anwendungsschicht (Schicht 7) gegen Ihre geschützten CloudFront Distributionen und Application Load Balancers abzuwehren. Wenn Sie diese Funktion aktivieren, generiert Shield Advanced automatisch benutzerdefinierte AWS-WAF-Regeln, um S-Angriffe abzuwehren DDo. Shield Advanced bietet Ihnen auch Zugriff auf das AWS Shield Response Team (SRT). Sie können sich jederzeit an SRT wenden, um benutzerdefinierte Abhilfemaßnahmen für Ihre Anwendung oder während eines aktiven S-Angriffs zu erstellen und zu verwalten. DDo Wenn Sie möchten, dass SRT Ihre geschützten Ressourcen proaktiv überwacht und Sie während eines DDo S-Versuchs kontaktiert, sollten Sie die Aktivierung der Proactive Engagement-Funktion in Betracht ziehen.

Designüberlegungen

-

Wenn Sie Workloads haben, denen Internetressourcen im Anwendungskonto gegenüberstehen, z. B. Amazon CloudFront, ein Application Load Balancer oder ein Network Load Balancer, konfigurieren Sie Shield Advanced im Anwendungskonto und fügen Sie diese Ressourcen zum Shield-Schutz hinzu. Sie können AWS Firewall Manager verwenden, um diese Optionen in großem Maß zu konfigurieren.

-

Wenn Sie mehrere Ressourcen im Datenfluss haben, z. B. eine CloudFront Verteilung vor einem Application Load Balancer, verwenden Sie nur die Einstiegspunktressource als geschützte Ressource. Dadurch wird sichergestellt, dass Sie Shield Data Transfer Out (DTO)-Gebühren

nicht zweimal für zwei Ressourcen zahlen. -

Shield Advanced zeichnet Metriken auf, die Sie in Amazon überwachen können CloudWatch. (Weitere Informationen finden Sie unter Metriken und Alarme für AWS Shield Advanced in der AWS-Dokumentation.) Richten Sie CloudWatch Alarme ein, um SNS-Benachrichtigungen an Ihr Sicherheitscenter zu erhalten, wenn ein DDo S-Ereignis erkannt wird. Bei einem vermuteten DDo S-Ereignis wenden Sie sich an das AWS Enterprise Support-Team

, indem Sie ein Support-Ticket einreichen und diesem die höchste Priorität zuweisen. Das Enterprise Support Team wird das Shield Response Team (SRT) bei der Bearbeitung des Ereignisses einbeziehen. Darüber hinaus können Sie die Lambda-Funktion des AWS-Shield-Engagements vorkonfigurieren, um ein Support-Ticket zu erstellen und eine E-Mail an das SRT-Team zu senden.

AWS Certificate Manager

Mit AWS Certificate Manager (ACM)

ACM wird im Netzwerkkonto verwendet, um ein öffentliches TLS-Zertifikat zu generieren, das wiederum von CloudFront Distributionen verwendet wird, um die HTTPS-Verbindung zwischen Zuschauern und herzustellen. CloudFront Weitere Informationen finden Sie in der CloudFront -Dokumentation.

Designüberlegung

-

Bei externen Zertifikaten muss sich ACM in demselben Konto befinden wie die Ressourcen, für die Zertifikate bereitgestellt werden. Zertifikate können nicht über Konten hinweg freigegeben werden.

Amazon Route 53

Amazon Route 53

Sie können Route 53 als DNS-Service verwenden, um Domainnamen Ihren EC2 Instances, S3-Buckets, CloudFront Distributionen und anderen AWS-Ressourcen zuzuordnen. Der verteilte Aufbau der AWS-DNS-Server trägt dazu bei, dass Ihre Endbenutzer konsistent zu Ihrer Anwendung weitergeleitet werden. Features wie Route-53-Datenverkehrsfluss und Routing-Steuerung helfen Ihnen dabei, die Zuverlässigkeit zu verbessern. Wenn Ihr primärer Anwendungsendpunkt nicht mehr verfügbar ist, können Sie Ihr Failover so konfigurieren, dass Ihre Benutzer an einen anderen Standort umgeleitet werden. Route 53 Resolver bietet rekursive DNS für Ihre VPC- und On-Premises-Netzwerke über AWS Direct Connect oder AWS-verwaltetes VPN.

Durch die Verwendung des AWS Identity and Access Management (IAM)-Service mit Route 53 erhalten Sie eine fein-abgestufte Kontrolle darüber, wer Ihre DNS-Daten aktualisieren kann. Sie können DNS-Sicherheitserweiterungen (DNSSEC) aktivieren, um es DNS-Resolvern zu ermöglichen, zu validieren, ob eine DNS-Antwort von Route 53 stammt und nicht manipuliert wurde.

Die Route 53 Resolver DNS Firewall bietet Schutz für ausgehende DNS-Anfragen von Ihrem. VPCs Diese Anforderungen verlaufen über Route 53 Resolver für die Auflösung von Domainnamen. Eine primäre Verwendung des DNS-Firewall-Schutzes besteht darin, die DNS-Exfiltration Ihrer Daten zu verhindern. Mit der DNS-Firewall können Sie die Domains überwachen und steuern, die Ihre Anwendungen abfragen können. Sie können den Zugriff auf die Domains verweigern, von denen Sie wissen, dass sie schlecht sind, und alle anderen Abfragen durchlaufen lassen. Alternativ können Sie allen Domains den Zugriff verweigern, außer jenen, denen Sie explizit vertrauen. Sie können die DNS-Firewall auch verwenden, um Auflösungsanforderungen an Ressourcen in privaten gehosteten Zonen (gemeinsam oder lokal) einschließlich VPC-Endpunktnamen zu blockieren. Sie kann auch Anfragen für öffentliche oder private EC2 Instanznamen blockieren.

Route-53-Resolver werden standardmäßig als Teil jeder VPC erstellt. In der AWS-SRA wird Route 53 im Netzwerkkonto hauptsächlich für die DNS-Firewall-Funktion verwendet.

Designüberlegung

-

DNS-Firewall und AWS Network Firewall bieten eine Filterung von Domainnnamen, jedoch für verschiedene Arten von Datenverkehr. Zusammen mit DNS Firewall und Network Firewall können Sie domainbasierte Filterung für den Datenverkehr auf Anwendungsebene über zwei verschiedene Netzwerkpfade konfigurieren.

-

Die DNS-Firewall bietet Filterung für ausgehende DNS-Abfragen, die den Route 53 53-Resolver von Anwendungen innerhalb Ihres Systems passieren. VPCs Sie können die DNS-Firewall auch so konfigurieren, dass benutzerdefinierte Antworten für Abfragen an blockierte Domainnamen gesendet werden.

-

Network Firewall bietet Filterung für den Datenverkehr auf Netzwerk- und Anwendungsebene, hat jedoch keine Einsicht in Abfragen, die von Route 53 Resolver durchgeführt werden.

-