Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Zugreifen auf Bewertungsmetriken (Konsole)

Während des Tests wird das Modell anhand des Testdatensatzes auf seine Leistung hin bewertet. Die Labels im Testdatensatz gelten als „Ground Truth“, da sie das darstellen, was das tatsächliche Bild darstellt. Während des Tests trifft das Modell anhand des Testdatensatzes Vorhersagen. Die vorhergesagten Labels werden mit den Ground Truth-Bezeichnungen verglichen, und die Ergebnisse sind auf der Bewertungsseite der Konsole verfügbar.

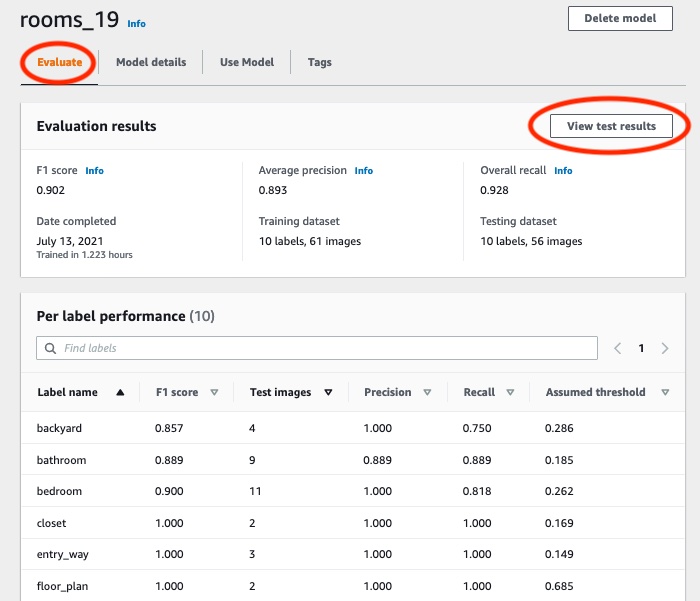

Die Amazon Rekognition Custom Labels-Konsole zeigt zusammenfassende Metriken für das gesamte Modell und Metriken für einzelne Labels. Die in der Konsole verfügbaren Metriken sind Präzision, Erinnerung, F1-Wert, Konfidenz und Konfidenzschwelle. Weitere Informationen finden Sie unter Verbessern eines geschulten Amazon Rekognition Custom Labels-Modells.

Sie können die Konsole verwenden, um sich auf einzelne Metriken zu konzentrieren. Um beispielsweise Präzisionsprobleme bei einem Label zu untersuchen, können Sie die Trainingsergebnisse nach Label und nach falsch positiven Ergebnissen filtern. Weitere Informationen finden Sie unter Metriken für die Bewertung Ihres Modells.

Nach dem Training ist der Trainingsdatensatz schreibgeschützt. Wenn Sie das Modell verbessern möchten, können Sie den Trainingsdatensatz in einen neuen Datensatz kopieren. Sie verwenden die Kopie des Datensatzes, um eine neue Version des Modells zu trainieren.

In diesem Schritt verwenden Sie die Konsole, um auf die Trainingsergebnisse in der Konsole zuzugreifen.

So greifen Sie auf Bewertungsmetriken zu (Konsole)

Öffnen Sie die Amazon Rekognition Rekognition-Konsole unter. https://console.aws.amazon.com/rekognition/

Wählen Sie Benutzerdefinierte Labels verwenden.

Wählen Sie Erste Schritte.

Wählen Sie im linken Navigationsbereich die Option Projekte aus.

Wählen Sie auf der Seite Projekte das Projekt aus, das das trainierte Modell enthält, das Sie auswerten möchten.

Wählen Sie unter Modelle das Modell aus, das Sie bewerten möchten.

Wählen Sie die Registerkarte Bewertung, um die Bewertungsergebnisse zu sehen. Weitere Informationen zum Bewerten eines Modells finden Sie unter Verbessern eines geschulten Amazon Rekognition Custom Labels-Modells.

-

Wählen Sie Testergebnisse anzeigen, um die Ergebnisse für einzelne Testbilder anzuzeigen. Weitere Informationen finden Sie unter Metriken für die Bewertung Ihres Modells. Der folgende Screenshot der Zusammenfassung der Modellbewertung zeigt den F1-Wert, die durchschnittliche Genauigkeit und die allgemeine Erinnerung für 6 Labels mit Testergebnissen und Leistungskennzahlen. Einzelheiten zur Verwendung des trainierten Modells werden ebenfalls bereitgestellt.

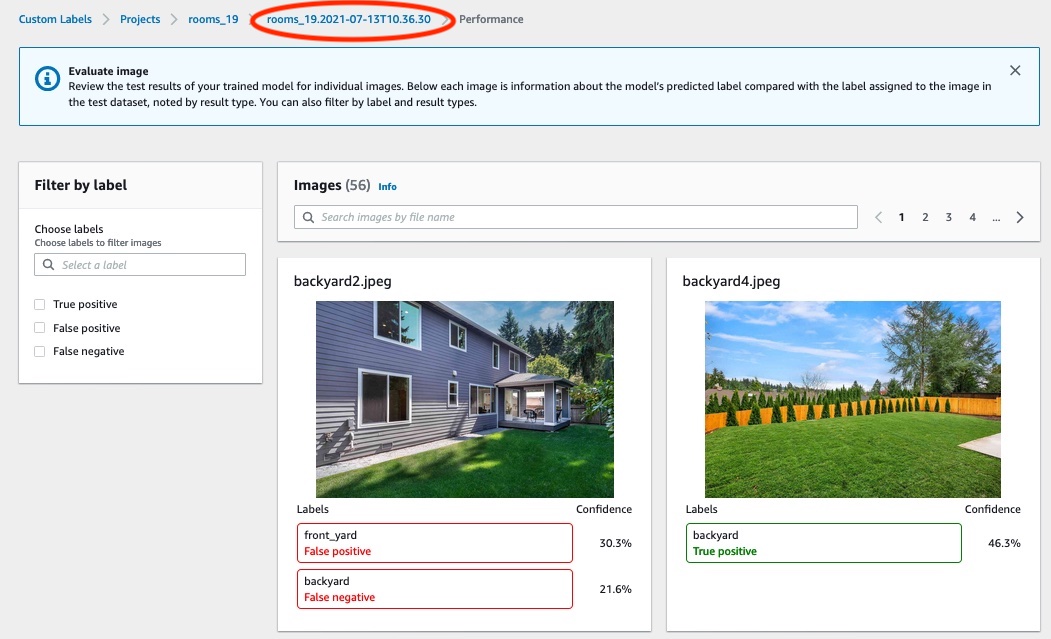

Nachdem Sie sich die Testergebnisse angesehen haben, wählen Sie den Projektnamen aus, um zur Modellseite zurückzukehren. Auf der Seite mit den Testergebnissen werden Bilder mit vorhergesagten Kennzeichnungen und Konfidenzwerten für ein maschinelles Lernmodell angezeigt, das auf die Bildkategorien Hinterhof und Vorgarten trainiert wurde. Zwei Beispielbilder werden angezeigt.

Verwenden Sie die Metriken, um die Leistung des Modells zu bewerten. Weitere Informationen finden Sie unter Verbessern eines Amazon Rekognition Custom Labels-Modells.