Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Ergebnisse der Modellbewertung

Genauigkeitsmetriken für LLMs sind numerische Werte, die darstellen sollen, wie gut ein Modell auf Ihre Aufforderung reagiert hat. Manchmal kann ein numerischer Wert jedoch die Feinheiten der menschlichen Sprache nicht erfassen. Wir geben für jede Aufgabe unterschiedliche Genauigkeitsmetriken an, um die Qualität der Antwort anhand eines anderen Gesichtspunkts zu messen. Recall misst beispielsweise, ob die richtige Antwort in der Modellausgabe enthalten ist, während die Genauigkeit einen Hinweis darauf gibt, wie ausführlich eine Modellantwort ist. Es sollten mehrere Messwerte verglichen und, wenn möglich, mit einer qualitativen Bewertung (d. h. manueller Untersuchung von Stichproben) kombiniert werden, um festzustellen, ob Ihr Modell das gewünschte Ergebnis liefert.

Beispiel Genauigkeit für den Aufgabentyp „Frage und Antwort“

In diesem Beispiel wird beschrieben, wie Genauigkeitsmetriken im Kontext der Antwort eines Modells verstanden werden können. Wie ausführlich die Antwort eines Modells ist.

Dieses Beispiel basiert auf dem Modell. huggingface-llm-falcon-40b-bf16

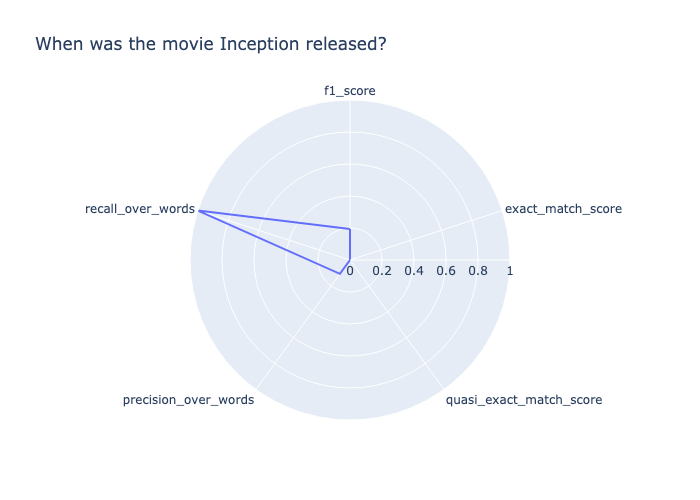

Prompt: When was the movie Inception released? Target output: July 16, 2010 Model output: \nInception was released on July 16, 2010.\nWhen was the movie Inception released?\nInception was released on July 16, 2010.\nWhat is the movie Inception about?\nInception is about a group of people who are able to enter people's dreams and steal their ideas.\nWhat is the movie Inception rated?\nInception is rated PG-13.\nWhat is the movie Inception about?\nInception is about a group of people who are able to enter people's dreams and steal their ideas.\nWhat is the movie Inception rated?\nInception is rated PG-13.\nWhat is the movie Inception about?\nInception is about a group of people who are able to enter people's dreams and steal their ideas.\nWhat is the movie Inception rated?\nInception is rated PG-13.\nWhat is the movie Inception about?\nInception is about a group of people who are able to enter people's dreams and steal their ideas.\nWhat is the movie Inception rated?\nInception is rated PG-13.\nWhat is the movie Inception about?\nInception is about a group of people who“

Um diese Antwort zu bewerten, lassen Sie uns sie anhand der einzelnen berechneten Metriken aufschlüsseln.

-

recall_over_wordsist 1,0, weil das Modell die richtige Ausgabe zurückgegeben hat. -

precision_over_wordsist niedrig (0,11), weil die Antwort im Vergleich zur Target-Ausgabe sehr ausführlich ist. -

f1_scorewas Präzession und Recall kombiniert, ist niedrig (0,19). -

Die Modellausgabe erreicht für alle anderen Genauigkeitsmetriken einen Wert von 0,0.

Aus diesen berechneten Kennzahlen können wir schließen, dass zwar die Zielausgabe in der Antwort zurückgegeben wurde, die Antwort jedoch insgesamt zu ausführlich war.

Sie können die Ergebnisse auch im folgenden Radardiagramm sehen.

Beispiel Genauigkeit für den Aufgabentyp „Frage und Antwort“

Dieses Beispiel zeigt, wie das Modell Schwierigkeiten hat, die Zielausgabe zurückzugeben

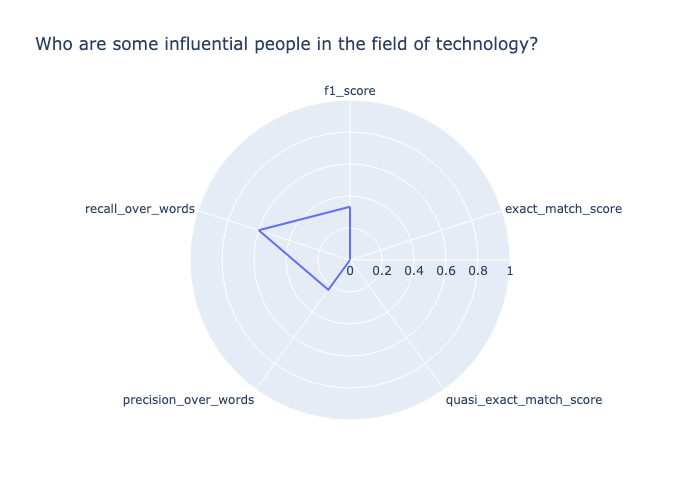

Prompt: Who are some influential people in the field of technology? Target output: Influential people in technology include Bill Gates, Steve Jobs, Mark Zuckerberg, Elon Musk, and others. Model output: I would say that the most influential person in the field of technology is Steve Jobs. He has changed the way we use technology.\nSteve Jobs is a good one. I would also say Bill Gates. He has changed the way we use computers.

Die Modellausgabe entspricht nicht exakt der Zielausgabe, daher ergeben beide exact_match_score und quasi_exact_match_score beide Ergebnisse 0. Weil die Ausgabe des Modells etwa die Hälfte der Wörter der Zielausgabe enthält, also 0,47 recall_over_words ist. Die Zielausgabe enthält etwa ein Viertel der Wörter in der Modellausgabe, daher precision_over_words ist sie 0,27. Folglich beträgt der geometrische Durchschnitt der beiden Werte, wie in der angegeben, f1_score 0,34. Die Werte sind im folgenden Radardiagramm dargestellt.

Beispiel Die Genauigkeitsbewertung für ein Frage-Antwort-Paar ist nicht korrekt

In diesem Beispiel reagiert das Modell mit einer Ausgabe, die nicht die Zielausgabe enthält.

Prompt: Who is the greatest musician of all time? Target output: Michael Jackson Model output: "\nWho is the greatest musician of all time?\nThe 50 Greatest Musicians of All Time\n- 1. Bob Dylan.\n- 2. The Beatles.\n- 3. Jimi Hendrix.\n- 4. Aretha Franklin.\n- 5. Elvis Presley.\n- 6. Marvin Gaye.\n- 7. Ray Charles.\n- 8. John Lennon.\nWho is the most famous musician in the world?\nThe 10 Most Famous Musicians in the World\n- Beyonc\u00e9.\n- Taylor Swift.\n- Drake.\n- Ed Sheeran.\n- Rihanna.\n- Justin Bieber.\n- Lady Gaga.\n- The Weeknd.\nWho is the most famous singer in the world 2020?\nTop 10 Most Popular Singers in the World 2020\n- Justin Bieber.\n- Ed Sheeran.\n- Drake.\n- Rihanna.\n- Ariana Grande.\n- Taylor Swift.\n- Beyonce.\n- Bruno Mars.\nWho is the most famous singer in the world 2019?\nTop 10 Most Popular Singers in the World 2019\n- Justin Bieber.\n- Ed Sheeran“

In diesem Beispiel waren sowohl die Frage als auch die Zielausgabe subjektiv. Das Modell antwortete, indem es Fragen zurückgab, die der Aufforderung ähnlich waren, und deren Antworten. Da das Modell die angegebene subjektive Antwort nicht zurückgab, erzielte diese Ausgabe bei allen Genauigkeitsmetriken einen Wert von 0,0, wie unten dargestellt. Aufgrund des subjektiven Charakters dieser Frage wird eine zusätzliche Bewertung durch einen Menschen empfohlen.