Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Wie funktioniert der SageMaker XGBoost Algorithmus

XGBoostist eine beliebte und effiziente Open-Source-Implementierung des Gradient Boosted Trees-Algorithmus. Gradient Boosting ist ein überwachter Lernalgorithmus, der versucht, eine Zielvariable genau vorherzusagen, indem er die Schätzungen aus einer Menge einfacher und schwächerer Modelle kombiniert.

Wenn Gradient Boosting für die Regression verwendet wird, sind die schwachen Lernenden Regressionsbäume, und jeder Regressionsbaum ordnet einem seiner Blätter, das eine kontinuierliche Punktzahl enthält, einen Eingabedatenpunkt zu. XGBoostminimiert eine regularisierte Zielfunktion (L1 und L2), die eine konvexe Verlustfunktion (basierend auf der Differenz zwischen den vorhergesagten und den angestrebten Ergebnissen) und einem Strafterm für die Modellkomplexität (mit anderen Worten, die Regressionsbaumfunktionen) kombiniert. Das Training erfolgt iterativ, indem neue Bäume hinzugefügt werden, welche die Reste oder Fehler vorheriger Bäume prognostizieren, die dann mit den vorherigen Bäumen verknüpft werden, um eine endgültige Prognose zu erstellen. Dies wird als Gradient Boosting bezeichnet, weil beim Hinzufügen neuer Modelle ein Gradient-Descent-Algorithmus zur Verlustminimierung verwendet wird.

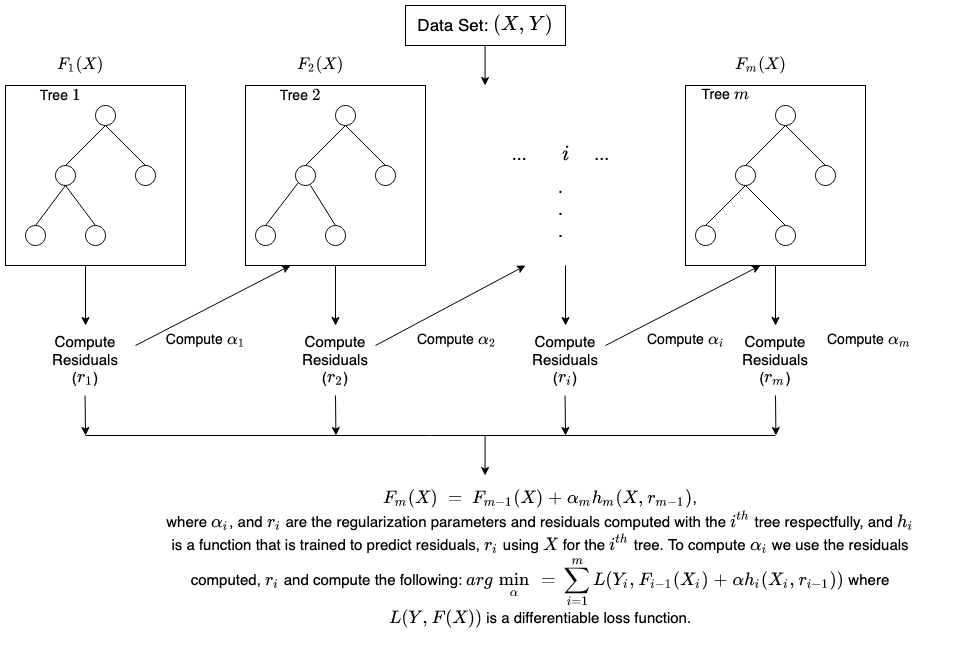

Im Folgenden finden Sie eine kurze Abbildung, wie Gradient Tree Boosting funktioniert.

Nähere Informationen dazu finden Sie XGBoost unter: