Tras considerarlo detenidamente, hemos decidido retirar las aplicaciones de Amazon Kinesis Data Analytics para SQL en dos pasos:

1. A partir del 15 de octubre de 2025, no podrá crear nuevas aplicaciones de Kinesis Data Analytics para SQL.

2. Eliminaremos sus aplicaciones a partir del 27 de enero de 2026. No podrá iniciar ni utilizar sus aplicaciones de Amazon Kinesis Data Analytics para SQL. A partir de ese momento, el servicio de soporte de Amazon Kinesis Data Analytics para SQL dejará de estar disponible. Para obtener más información, consulte Retirada de las aplicaciones de Amazon Kinesis Data Analytics para SQL.

Ejemplo: ventana de saltos con ROWTIME

Cuando una consulta en ventana procesa cada ventana de forma que no se superpongan, la ventana se denomina ventana de saltos. Para obtener más información, consulte Ventanas de saltos de tamaño constante (Agregados utilizando GROUP BY). Este ejemplo de Amazon Kinesis Data Analytics se utiliza la columna ROWTIME para crear ventanas de saltos. La columna ROWTIME representa la hora en que la aplicación leyó el registro.

En este ejemplo, escribirá los siguientes registros en un flujo de datos de Kinesis.

{"TICKER": "TBV", "PRICE": 33.11} {"TICKER": "INTC", "PRICE": 62.04} {"TICKER": "MSFT", "PRICE": 40.97} {"TICKER": "AMZN", "PRICE": 27.9} ...

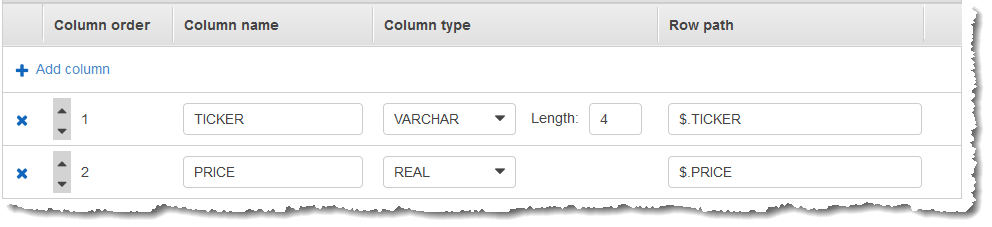

A continuación, cree una aplicación de Kinesis Data Analytics en la AWS Management Console con el flujo de datos de Kinesis como origen de streaming. El proceso de detección lee los registros de muestra en el origen de streaming e infiere un esquema en la aplicación con dos columnas (TICKER y PRICE), tal como se muestra a continuación.

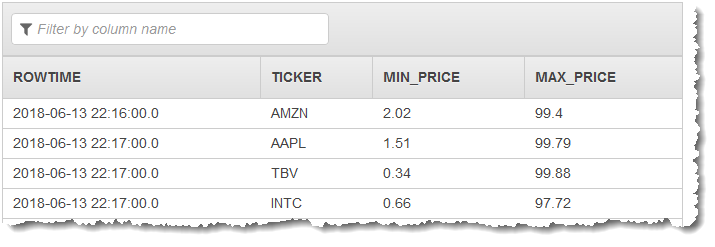

Utilice el código de aplicación con las funciones MIN y MAX para crear una agregación en ventana de los datos. A continuación, inserte los datos resultantes en otra secuencia en la aplicación, tal y como se muestra en la siguiente captura de pantalla:

En el siguiente procedimiento, se crea una aplicación de Kinesis Data Analytics que agrega valores en el flujo de entrada en una ventana de saltos basada en ROWTIME.

Temas

Paso 1: crear un flujo de datos de Kinesis

Cree un flujo de datos de Amazon Kinesis y rellene los registros como se indica a continuación:

Inicie sesión en la AWS Management Console y abra la consola de Kinesis en https://console.aws.amazon.com/kinesis

. -

Elija Flujos de datos en el panel de navegación.

-

Elija Create Kinesis Stream (Crear secuencia de Kinesis) y, a continuación, cree una secuencia con un fragmento. Para obtener más información, consulte Crear secuencia en la Guía para desarrolladores de Amazon Kinesis Data Streams.

-

Para escribir registros en un flujo de datos de Kinesis en un entorno de producción, recomendamos utilizar Kinesis Client Library o la API de Kinesis Data Streams. Para simplificar, en este ejemplo se utiliza el siguiente script Python para generar registros. Ejecute el código para rellenar los registros de ticker de muestra. Este código simple escribe continuamente un registro de ticker aleatorio en el flujo. Mantenga el script ejecutándose para poder generar el esquema de la aplicación en un paso posterior.

import datetime import json import random import boto3 STREAM_NAME = "ExampleInputStream" def get_data(): return { "EVENT_TIME": datetime.datetime.now().isoformat(), "TICKER": random.choice(["AAPL", "AMZN", "MSFT", "INTC", "TBV"]), "PRICE": round(random.random() * 100, 2), } def generate(stream_name, kinesis_client): while True: data = get_data() print(data) kinesis_client.put_record( StreamName=stream_name, Data=json.dumps(data), PartitionKey="partitionkey" ) if __name__ == "__main__": generate(STREAM_NAME, boto3.client("kinesis"))

Paso 2: creación de una aplicación de Kinesis Data Analytics

Cree una aplicación de análisis de datos de Kinesis Data Analytics de la siguiente manera:

Abra la consola de Managed Service para Apache Flink en https://console.aws.amazon.com/kinesisanalytics

. -

Elija Create application (Crear aplicación), introduzca el nombre de la aplicación y elija Create application (Crear aplicación).

-

En la página de detalles de la aplicación, elija Connect streaming data (Conectar datos de streaming) para conectarse al origen.

-

En la página Connect to source (Conectarse al origen), haga lo siguiente:

-

Elija la secuencia que ha creado en la sección anterior.

-

Elija Discover Schema (Detectar esquema). Espere a que la consola muestre el esquema inferido y los registros de muestra utilizados para inferir en el esquema de la secuencia en la aplicación que ha creado. El esquema inferido cuenta con dos columnas.

-

Elija Save schema and update stream samples. Después de que la consola guarde el esquema, elija Exit (Salir).

-

Elija Guardar y continuar.

-

-

En la página de detalles de la aplicación, elija Go to SQL editor (Ir al editor de SQL). Para iniciar la aplicación, elija Yes, start application (Sí, iniciar la aplicación) en el cuadro de diálogo que aparece.

-

En el editor de SQL, escriba el código de la aplicación y verifique los resultados como se indica a continuación:

-

Copie el siguiente código de la aplicación y péguelo en el editor.

CREATE OR REPLACE STREAM "DESTINATION_SQL_STREAM" (TICKER VARCHAR(4), MIN_PRICE REAL, MAX_PRICE REAL); CREATE OR REPLACE PUMP "STREAM_PUMP" AS INSERT INTO "DESTINATION_SQL_STREAM" SELECT STREAM TICKER, MIN(PRICE), MAX(PRICE) FROM "SOURCE_SQL_STREAM_001" GROUP BY TICKER, STEP("SOURCE_SQL_STREAM_001".ROWTIME BY INTERVAL '60' SECOND); -

Elija Save and run SQL.

En la pestaña Real-time analytics (Análisis en tiempo real), puede ver todas las secuencias en la aplicación creadas por esta y comprobar los datos.

-