Ya no actualizamos el servicio Amazon Machine Learning ni aceptamos nuevos usuarios para él. Esta documentación está disponible para los usuarios actuales, pero ya no la actualizamos. Para obtener más información, consulte Qué es Amazon Machine Learning.

Paso 4: Revisar el desempeño predictivo del modelo de ML y establecer un umbral de puntuación

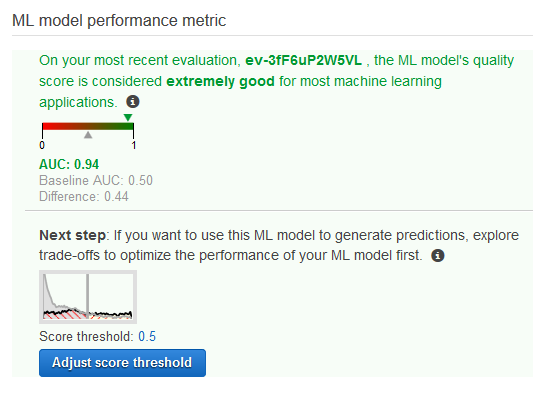

Ahora que ha creado el modelo de ML y Amazon Machine Learning (Amazon ML) lo ha evaluado, vamos a ver si es suficientemente bueno para ponerlo en práctica. Durante la evaluación, Amazon ML ha calculado una métrica de calidad estándar del sector, denominada métrica Area Under a Curve (AUC), que expresa la calidad del desempeño del modelo de ML. Amazon ML también interpreta la métrica AUC para indicarle si la calidad del modelo de ML es suficiente para la mayoría de las aplicaciones de machine learning. (Para obtener más información sobre AUC, consulte Medición de la precisión del modelo de ML.) Vamos a revisar la métrica AUC y, a continuación, a ajustar el umbral o límite de puntuación para optimizar el desempeño predictivo del modelo.

Revisar la métrica AUC del modelo de ML

-

En la página ML model summary (Resumen de modelos de ML), en el panel de navegación ML model report (Informe de modelos de ML), seleccione Evaluations (Evaluaciones), Evaluation: ML model: Banking model 1 (Evaluación: modelo de ML: modelo bancario 1) y, a continuación, Summary (Resumen).

-

En la página Evaluation summary (Resumen de evaluación), revise el resumen de la evaluación, incluida la métrica de desempeño de AUC del modelo.

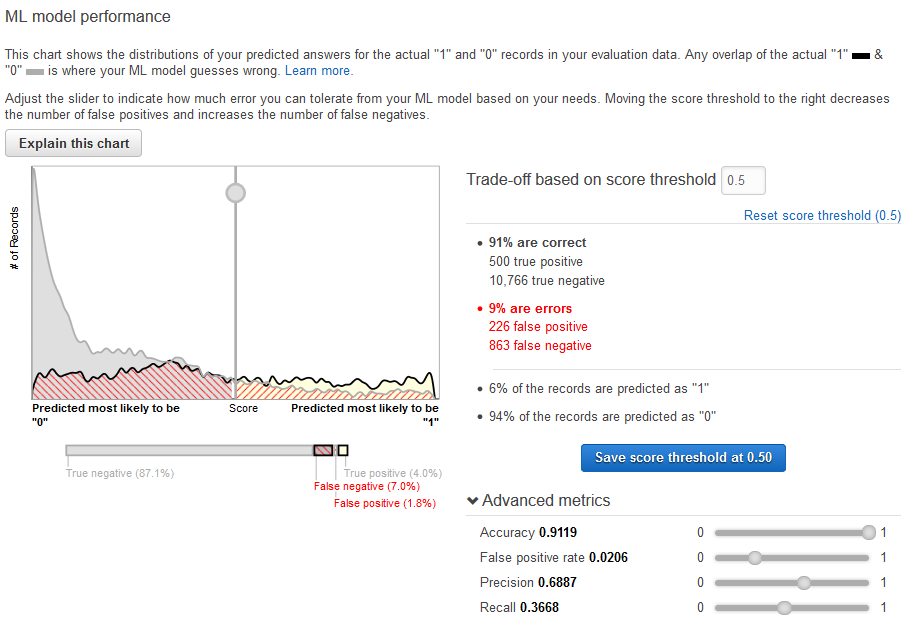

El modelo de ML genera puntuaciones numéricas de predicciones para cada registro de una fuente de datos de predicciones y, a continuación, aplica un umbral para convertir estas puntuaciones en etiquetas binarias de 0 (para no) o 1 (para sí). Al cambiar el umbral de puntuación, puede ajustar la manera en la que el modelo de ML asigna estas etiquetas. A continuación, establezca el umbral de puntuación.

Establecer un umbral de puntuación para el modelo de ML

-

En la página Evaluation Summary (Resumen de evaluación), seleccione Adjust Score Threshold (Ajustas umbral de puntuación).

Puede ajustar las métricas de desempeño del modelo de ML ajustando el umbral de puntuación. Ajustar este valor cambia el nivel de confianza que debe tener el modelo en una predicción antes de considerar que la predicción es positiva. También cambia la cantidad de falsos negativos y falsos positivos que está dispuesto a tolerar en sus predicciones.

Puede controlar el límite de lo que el modelo considera una predicción positiva incrementando el umbral de puntuación hasta que solo considere que las predicciones con más probabilidad de ser positivos reales son positivas. También puede reducir el umbral de puntuación hasta que deje de tener falsos negativos. Seleccione un límite para reflejar las necesidades de su empresa. En este tutorial, cada falso positivo cuesta dinero de campaña, por lo que queremos una proporción alta de positivos reales respecto a falsos positivos.

-

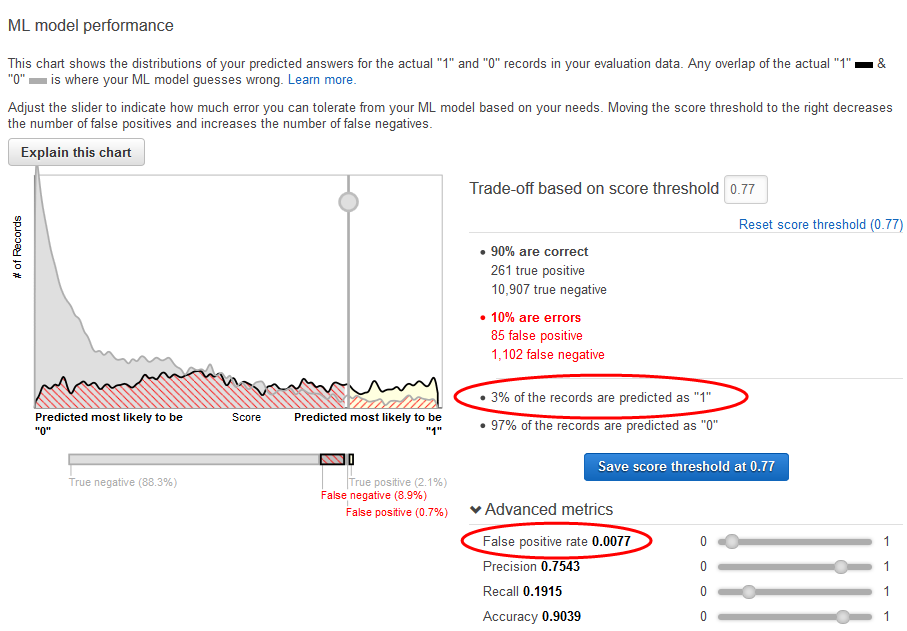

Digamos que desea dirigirse al primer 3% de clientes que se suscribirán al producto. Deslice el selector vertical para establecer el umbral de puntuación en un valor que corresponda a 3% of the records are predicted as "1" (3% de los registros están previstos como "1").

Observe el impacto de este umbral de puntuación en el rendimiento del modelo de ML: la tasa de falsos positivos es de 0,007. Supongamos que esa proporción de falsos positivos es aceptable.

-

Seleccione Save score threshold at 0.77 (Guardar umbral de puntuación en 0,77).

Cada vez que usa este modelo de ML para realizar predicciones, predecirá los registros con puntuaciones superiores al 0,77 como "1", y el resto de los registros como "0".

Para obtener más información sobre el umbral de puntuación, consulte Clasificación binaria.

Ahora está preparado para generar predicciones utilizando un modelo.