Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Configure su proveedor de modelos

nota

En esta sección, asumimos que el lenguaje y los modelos de incrustación que planea usar ya están implementados. En el caso de los modelos proporcionados por AWS, ya deberías tener el ARN de tu SageMaker punto de conexión o acceso a Amazon Bedrock. En el caso de otros proveedores de modelos, debe disponer de la API clave utilizada para autenticar y autorizar las solicitudes a su modelo.

Jupyter AI es compatible con una amplia gama de proveedores de modelos y modelos lingüísticos. Consulte la lista de modelos compatibles

La configuración de Jupyter AI varía en función de si utilizas la interfaz de usuario del chat o los comandos mágicos.

Configura tu proveedor de modelos en la interfaz de usuario del chat

nota

Puede configurar varios modelos LLMs e incrustar siguiendo las mismas instrucciones. Sin embargo, debe configurar al menos un modelo de idioma.

Para configurar la interfaz de usuario del chat

-

En JupyterLab, accede a la interfaz de chat seleccionando el icono de chat (

) en el panel de navegación izquierdo.

) en el panel de navegación izquierdo. -

Seleccione el icono de configuración (

) en la esquina superior derecha del panel izquierdo. Esto abre el panel de configuración de Jupyter AI.

) en la esquina superior derecha del panel izquierdo. Esto abre el panel de configuración de Jupyter AI. -

Rellene los campos relacionados con su proveedor de servicios.

-

Para modelos proporcionados por JumpStart Amazon Bedrock

-

En la lista desplegable de modelos de lenguaje, seleccione

sagemaker-endpointlos modelos implementados con Amazon Bedrock JumpStart obedrocklos modelos gestionados por Amazon Bedrock. -

Los parámetros varían en función de si el modelo se implementa en Amazon Bedrock SageMaker o en Amazon.

-

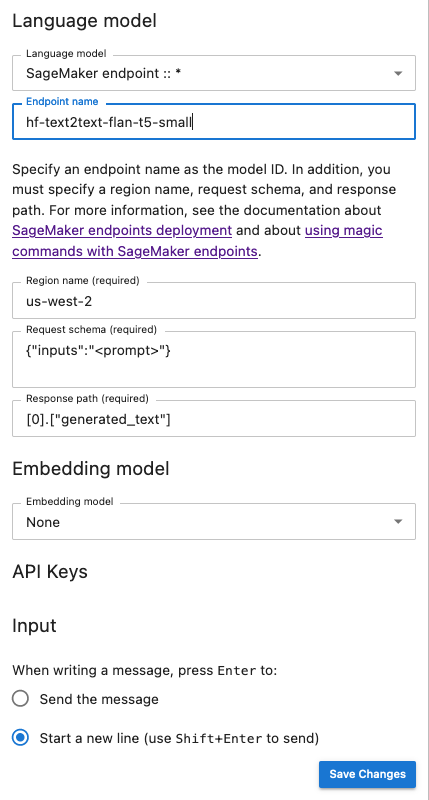

Para los modelos implementados con JumpStart:

-

Introduzca el nombre de su terminal en Nombre del terminal y, a continuación, el nombre Región de AWS en el que está desplegado el modelo en el nombre de la región. Para recuperar ARN los puntos finales, navegue hasta SageMaker los puntos finales https://console.aws.amazon.com/sagemaker/

y, a continuación, seleccione Inferencia y puntos finales en el menú de la izquierda. -

Pegue el esquema JSON de solicitud adaptado a su modelo y la ruta de respuesta correspondiente para analizar el resultado del modelo.

nota

Puede encontrar el formato de solicitud y respuesta de varios modelos básicos JumpStart en los siguientes cuadernos de ejemplo

. Cada cuaderno lleva el nombre del modelo que muestra.

-

-

Para los modelos gestionados por Amazon Bedrock: añada el AWS perfil que almacena sus AWS credenciales en el sistema (opcional) y, a continuación, el perfil Región de AWS en el que se implementa el modelo en el nombre de la región.

-

-

(Opcional) Seleccione un modelo de incrustación al que tenga acceso. Los modelos de incrustación se utilizan para capturar información adicional de los documentos locales, lo que permite que el modelo de generación de texto responda a preguntas dentro del contexto de esos documentos.

-

Seleccione Guardar cambios y navegue hasta el icono de flecha izquierda (

) en la esquina superior izquierda del panel izquierdo. Esto abre la interfaz de chat de Jupyter AI. Puedes empezar a interactuar con tu modelo.

) en la esquina superior izquierda del panel izquierdo. Esto abre la interfaz de chat de Jupyter AI. Puedes empezar a interactuar con tu modelo.

-

-

Para modelos alojados por proveedores externos

-

En la lista desplegable del modelo de idioma, selecciona tu ID de proveedor. Puedes encontrar los detalles de cada proveedor, incluida su identificación, en la lista de proveedores modelo de

Jupyter AI. -

(Opcional) Seleccione un modelo de incrustación al que tenga acceso. Los modelos de incrustación se utilizan para capturar información adicional de los documentos locales, lo que permite que el modelo de generación de texto responda a preguntas dentro del contexto de esos documentos.

-

Inserta las claves de tus modelos. API

-

Selecciona Guardar cambios y navega hasta el icono de flecha izquierda (

) situado en la esquina superior izquierda del panel izquierdo. Esto abre la interfaz de chat de Jupyter AI. Puedes empezar a interactuar con tu modelo.

) situado en la esquina superior izquierda del panel izquierdo. Esto abre la interfaz de chat de Jupyter AI. Puedes empezar a interactuar con tu modelo.

-

-

La siguiente instantánea es una ilustración del panel de configuración de la interfaz de usuario del chat configurado para invocar un modelo FLAN-T5-Small proporcionado e implementado en. JumpStart SageMaker

Transfiera parámetros de modelo adicionales y parámetros personalizados a su solicitud

Es posible que su modelo necesite parámetros adicionales, como un atributo personalizado para la aprobación del acuerdo de usuario o ajustes en otros parámetros del modelo, como la temperatura o la longitud de respuesta. Recomendamos configurar estos ajustes como una opción de inicio de la JupyterLab aplicación mediante una configuración de ciclo de vida. Para obtener información sobre cómo crear una configuración de ciclo de vida y adjuntarla a su dominio o a un perfil de usuario desde la SageMaker consola

Utilice el siguiente JSON esquema para configurar los parámetros adicionales:

{ "AiExtension": { "model_parameters": { "<provider_id>:<model_id>": { Dictionary of model parameters which is unpacked and passed as-is to the provider.} } } } }

El siguiente script es un ejemplo de un archivo de JSON configuración que puede usar al crear una JupyterLab aplicación LCC para establecer la longitud máxima de un modelo Jurassic-2 de AI21 Labs implementado en Amazon Bedrock. Aumentar la longitud de la respuesta generada por el modelo puede evitar el truncamiento sistemático de la respuesta del modelo.

#!/bin/bash set -eux mkdir -p /home/sagemaker-user/.jupyter json='{"AiExtension": {"model_parameters": {"bedrock:ai21.j2-mid-v1": {"model_kwargs": {"maxTokens": 200}}}}}' # equivalent to %%ai bedrock:ai21.j2-mid-v1 -m {"model_kwargs":{"maxTokens":200}} # File path file_path="/home/sagemaker-user/.jupyter/jupyter_jupyter_ai_config.json" #jupyter --paths # Write JSON to file echo "$json" > "$file_path" # Confirmation message echo "JSON written to $file_path" restart-jupyter-server # Waiting for 30 seconds to make sure the Jupyter Server is up and running sleep 30

El siguiente script es un ejemplo de un archivo de JSON configuración para crear una JupyterLab aplicación que LCC se utiliza para establecer parámetros de modelo adicionales para un modelo Anthropic Claude implementado en Amazon Bedrock.

#!/bin/bash set -eux mkdir -p /home/sagemaker-user/.jupyter json='{"AiExtension": {"model_parameters": {"bedrock:anthropic.claude-v2":{"model_kwargs":{"temperature":0.1,"top_p":0.5,"top_k":25 0,"max_tokens_to_sample":2}}}}}' # equivalent to %%ai bedrock:anthropic.claude-v2 -m {"model_kwargs":{"temperature":0.1,"top_p":0.5,"top_k":250,"max_tokens_to_sample":2000}} # File path file_path="/home/sagemaker-user/.jupyter/jupyter_jupyter_ai_config.json" #jupyter --paths # Write JSON to file echo "$json" > "$file_path" # Confirmation message echo "JSON written to $file_path" restart-jupyter-server # Waiting for 30 seconds to make sure the Jupyter Server is up and running sleep 30

Una vez que lo haya adjuntado LCC a su dominio o perfil de usuario, agréguelo LCC a su espacio al lanzar la aplicación. JupyterLab Para asegurarse de que su archivo de configuración esté actualizado por elLCC, ejecútelo more ~/.jupyter/jupyter_jupyter_ai_config.json en una terminal. El contenido del archivo debe corresponder al contenido del JSON archivo pasado alLCC.

Configure su proveedor de modelos en un cuaderno

Para invocar un modelo mediante Jupyter AI en libretas JupyterLab o Studio Classic mediante los comandos y mágicos %%ai%ai

-

Instale las bibliotecas cliente específicas de su proveedor de modelos en su entorno de portátiles. Por ejemplo, cuando se utilizan modelos OpenAI, es necesario instalar la biblioteca

openaicliente. Puedes encontrar la lista de bibliotecas cliente requeridas por proveedor en la columna de paquetes de Python de la lista de proveedores del modelode IA de Jupyter. nota

En el caso de los modelos alojados por AWS, ya

boto3está instalado en la imagen de SageMaker distribución utilizada por JupyterLab Studio Classic o en cualquier imagen de ciencia de datos utilizada con Studio Classic. -

-

Para los modelos alojados por AWS

Asegúrese de que su función de ejecución tenga permiso para invocar su SageMaker punto de conexión para los modelos proporcionados por Amazon Bedrock JumpStart o de que usted tenga acceso a ellos.

-

Para modelos alojados por proveedores externos

Exporte la API clave de su proveedor al entorno de su portátil mediante variables de entorno. Puedes usar el siguiente comando mágico. Sustituya la

provider_API_keyvariable del comando por la variable de entorno que se encuentra en la columna de variables de entorno de la lista de proveedores del modelode IA de Jupyter correspondiente a su proveedor. %env provider_API_key=your_API_key

-