Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

XGBoost

Cuando se utiliza el aumento del gradiente

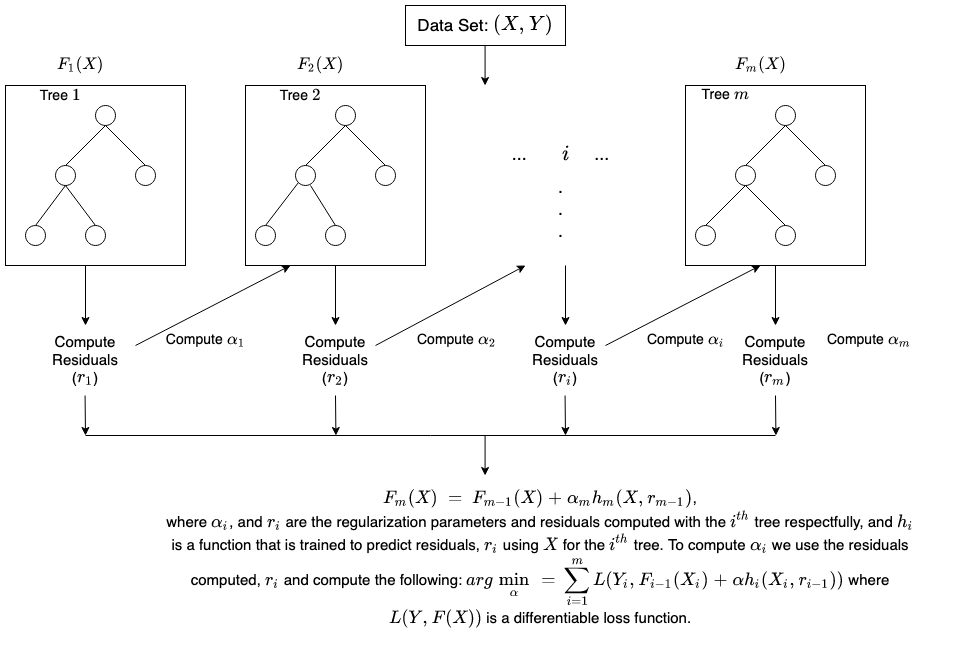

Esta es una sencilla descripción gráfica sobre el funcionamiento de la potenciación de árboles por gradiente.

Para obtener más información al respecto, consulte: XGBoost