Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Commencez à utiliser Apache Spark sur Amazon Athena

Pour commencer à utiliser Apache Spark sur Amazon Athena, vous devez d'abord créer un groupe de travail compatible avec Spark. Après être passé dans le groupe de travail, vous pouvez créer un bloc-notes ou ouvrir un bloc-notes existant. Lorsque vous ouvrez un bloc-notes dans Athena, une nouvelle session est automatiquement lancée pour celui-ci et vous pouvez travailler avec lui directement dans l'éditeur de blocs-notes d'Athena.

Note

Assurez-vous de créer un groupe de travail compatible avec Spark avant de tenter de créer un bloc-notes.

Étape 1 : créer un groupe de travail compatible avec Spark dans Athena

Vous pouvez utiliser des groupes de travail dans Athena pour regrouper des utilisateurs, des équipes, des applications ou des charges de travail, et pour suivre les coûts. Pour utiliser Apache Spark dans Amazon Athena, vous devez créer un groupe de travail Amazon Athena qui utilise un moteur Spark.

Note

Les groupes de travail compatibles avec Apache Spark peuvent utiliser l'éditeur de bloc-notes Athena, mais pas l'éditeur de requêtes Athena. Seuls les SQL groupes de travail Athena peuvent utiliser l'éditeur de requêtes Athena.

Créer un groupe de travail compatible avec Spark dans Athena

-

Ouvrez la console Athena à https://console.aws.amazon.com/athena/

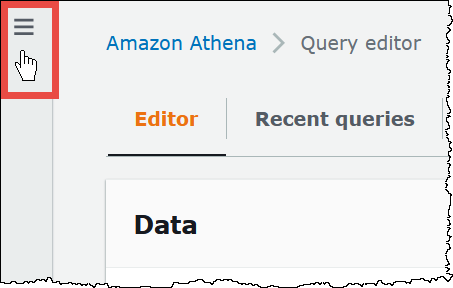

Si le panneau de navigation de la console n'est pas visible, choisissez le menu d'extension sur la gauche.

-

Dans le panneau de navigation, choisissez Workgroups (Groupes de travail).

-

Sur la page Workgroups (Groupes de travail), choisissez Create workgroup (Créer un groupe de travail).

-

Dans le champ Workgroup name (Nom du groupe de travail), saisissez un nom pour votre groupe de travail Apache Spark.

-

(Facultatif) Dans le champ Description, saisissez une description de votre groupe de travail.

-

Dans le champ Analytics engine (Moteur d'analyse), choisissez Apache Spark.

Note

Une fois que vous avez créé un groupe de travail, le type de moteur d'analyse du groupe de travail ne peut pas être modifié. Par exemple, un groupe de travail du moteur Athena version 3 ne peut pas être remplacé par un groupe de travail PySpark du moteur version 3.

-

Pour les besoins de ce tutoriel, sélectionnez Turn on example notebook (Activer l'exemple de bloc-notes). Cette fonctionnalité facultative ajoute un exemple de bloc-notes portant le nom

example-notebook-à votre groupe de travail et ajoute AWS Glue les autorisations associées que le bloc-notes utilise pour créer, afficher et supprimer des bases de données et des tables spécifiques de votre compte, ainsi que les autorisations de lecture dans Amazon S3 pour l'exemple de jeu de données. Pour voir les autorisations ajoutées, choisissez View additional permissions details (Afficher les détails des autorisations supplémentaires).random_stringNote

L'exécution de l'exemple de bloc-notes peut entraîner des coûts supplémentaires.

-

Pour les paramètres des résultats du calcul, choisissez l'une des options suivantes :

-

Create a new S3 bucket (Créer un nouveau compartiment S3) – Cette option crée un compartiment Amazon S3 dans votre compte pour les résultats de vos calculs. Le nom du bucket a le format

account_id-region-athena-results-bucket-alphanumeric_id -

Choose an existing S3 location (Choisir un emplacement S3 existant) – Pour cette option, procédez comme suit :

-

Saisissez le chemin d'un emplacement S3 existant dans la zone de recherche, ou choisissez Browse S3 (Parcourir S3) pour choisir un compartiment dans une liste.

Note

Lorsque vous sélectionnez un emplacement existant dans Amazon S3, n'ajoutez pas de barre oblique (

/) à cet emplacement. Ainsi, le lien vers l'emplacement des résultats du calcul sur la page des détails du calcul pointe vers un répertoire incorrect. Si cela se produit, modifiez l'emplacement des résultats du groupe de travail pour supprimer la barre oblique de fin de ligne. -

(Facultatif) Choisissez View (Afficher) pour ouvrir la page Buckets (Compartiments) de la console Amazon S3 où vous pouvez voir plus d'informations sur le compartiment existant que vous avez choisi.

-

(Facultatif) Dans le champ Propriétaire attendu du compartiment, entrez AWS ID de compte que vous pensez être le propriétaire du bucket d'emplacement de sortie des résultats de votre requête. Nous vous recommandons de choisir cette option comme mesure de sécurité supplémentaire lorsque cela est possible. Si l'ID du compte du propriétaire du compartiment ne correspond pas à l'ID que vous avez spécifié, les tentatives de sortie vers le compartiment échoueront. Pour obtenir des informations détaillées, consultez Vérification de la propriété du compartiment avec la condition de propriétaire du compartiment dans le Guide de l'utilisateur Simple Storage Service (Amazon S3).

-

(Facultatif) Sélectionnez Assign bucket owner full control over query results (Attribuer au propriétaire du compartiment le contrôle total des résultats de la requête) si l'emplacement des résultats de votre calcul est détenu par un autre compte et si vous voulez accorder à cet autre compte le contrôle total des résultats de votre requête.

-

-

-

(Facultatif) Choisissez Chiffrer les résultats de la requête si vous souhaitez que les résultats de votre requête soient chiffrés.

-

Pour le type de chiffrement, choisissez l'une des options suivantes :

-

SSE_S3 — Cette option utilise le chiffrement côté serveur (SSE) avec des clés de chiffrement gérées par Amazon S3.

-

SSE_ KMS — Cette option utilise le chiffrement côté serveur () SSE avec AWS KMS-clés gérées.

Pour Choose an AWS KMS touche, choisissez l'une des options suivantes.

-

Utiliser AWS clé possédée — La AWS KMS la clé est détenue et gérée par AWS. Aucuns frais supplémentaires ne vous seront facturés pour l'utilisation de cette clé.

-

Choisissez un autre AWS KMS touche (avancée) : pour cette option, effectuez l'une des opérations suivantes :

-

Pour utiliser une clé existante, utilisez le champ de recherche pour choisir un AWS KMS ou entrez une cléARN.

-

Pour créer une clé dans AWS KMS console, choisissez Create an AWS KMS clé. Votre rôle d'exécution doit avoir l'autorisation d'utiliser la clé que vous créez. Une fois que vous avez fini de créer la clé dans la KMS console, revenez à la page Créer un groupe de travail dans la console Athena, puis utilisez le AWS KMS touche ou entrez dans un champ ARN de recherche pour choisir la clé que vous venez de créer.

-

-

Important

Lorsque vous modifiez le AWS KMS keypour un groupe de travail, les blocs-notes gérés avant la mise à jour font toujours référence à l'ancienne clé. KMS Les blocs-notes gérés après la mise à jour utilisent la nouvelle KMS clé. Pour mettre à jour les anciens blocs-notes afin de référencer la nouvelle KMS clé, exportez puis importez chacun des anciens blocs-notes. Si vous supprimez l'ancienne KMS clé avant de mettre à jour les références de l'ancien bloc-notes vers la nouvelle KMS clé, les anciens blocs-notes ne sont plus déchiffrables et ne peuvent pas être récupérés.

Ce comportement s'applique également aux mises à jour des alias, qui sont des noms conviviaux pour les KMS clés. Lorsque vous mettez à jour un alias de KMS clé pour qu'il pointe vers une nouvelle KMS clé, les blocs-notes gérés avant la mise à jour de l'alias font toujours référence à l'ancienne KMS clé, et les blocs-notes gérés après la mise à jour de l'alias utilisent la nouvelle KMS clé. Tenez compte de ces points avant de mettre à jour vos KMS clés ou alias.

-

-

-

Pour les configurations supplémentaires, choisissez Utiliser les valeurs par défaut. Cette option vous permet de démarrer avec votre groupe de travail compatible avec Spark. Lorsque vous utilisez les valeurs par défaut, Athena crée pour vous IAM un rôle et un emplacement des résultats de calcul dans Amazon S3. Le nom du IAM rôle et l'emplacement du compartiment S3 à créer sont affichés dans la zone située sous l'en-tête Configurations supplémentaires.

Si vous ne souhaitez pas utiliser les valeurs par défaut, suivez les étapes de la (Facultatif) Spécifiez vos propres configurations de groupe de travail section pour configurer manuellement votre groupe de travail.

-

(Facultatif) Étiquettes – Utilisez cette option pour ajouter des étiquettes à votre groupe de travail. Pour de plus amples informations, veuillez consulter Tag : ressources d'Athena.

-

Choisissez Créer un groupe de travail. Un message vous informe que le groupe de travail a été créé avec succès et qu'il apparaît dans la liste des groupes de travail.

(Facultatif) Spécifiez vos propres configurations de groupe de travail

Si vous souhaitez définir votre propre IAM rôle et l'emplacement des résultats des calculs pour votre bloc-notes, suivez les étapes décrites dans cette section. Si vous avez sélectionné Use defaults (Utiliser les valeurs par défaut) pour l'option Additional configurations (Configurations supplémentaires), ignorez cette rubrique et passez directement à Étape 2 : Ouvrez l'explorateur de blocs-notes et changez de groupe de travail .

La procédure suivante suppose que vous avez terminé les étapes 1 à 9 de la procédure Créer un groupe de travail compatible avec Spark dans Athena décrite à la rubrique précédente.

Spécifier vos propres configurations de groupe de travail

-

Si vous souhaitez créer ou utiliser votre propre IAM rôle ou configurer le chiffrement des blocs-notes, étendez la configuration des IAM rôles.

-

Pour que Service Role autorise Athena, choisissez l'une des options suivantes :

-

Créer et utiliser un nouveau rôle de service — Choisissez cette option pour qu'Athéna crée un rôle de service pour vous. Pour voir les autorisations accordées par le rôle, choisissez View permission details (Afficher les détails des autorisations).

-

Utiliser un rôle de service existant : dans le menu déroulant, choisissez un rôle existant. Le rôle que vous choisissez doit inclure les autorisations de la première option. Pour plus d'informations sur les autorisations pour les groupes de travail avec bloc-notes, voir Résoudre les problèmes liés aux groupes de travail compatibles avec Spark.

-

-

Pour Notebook and calculation code encryption key management (Gestion des clés de chiffrement du bloc-notes et du code de calcul), choisissez l'une des options suivantes :

-

Chiffrer en utilisant AWS clé possédée (par défaut) — La AWS KMS la clé est détenue et gérée par AWS. Aucuns frais supplémentaires ne vous seront facturés pour l'utilisation de cette clé.

-

Chiffrez à l'aide du vôtre AWS KMS clé — Pour cette option, effectuez l'une des opérations suivantes :

-

Pour utiliser une clé existante, utilisez le champ de recherche pour choisir un AWS KMS ou entrez une cléARN.

-

Pour créer une clé dans AWS KMS console, choisissez Create an AWS KMS clé. Votre rôle d'exécution doit avoir l'autorisation d'utiliser la clé que vous créez. Une fois que vous avez fini de créer la clé dans la KMS console, revenez à la page Créer un groupe de travail dans la console Athena, puis utilisez le AWS KMS touche ou entrez dans un champ ARN de recherche pour choisir la clé que vous venez de créer.

-

Important

Lorsque vous modifiez le AWS KMS keypour un groupe de travail, les blocs-notes gérés avant la mise à jour font toujours référence à l'ancienne clé. KMS Les blocs-notes gérés après la mise à jour utilisent la nouvelle KMS clé. Pour mettre à jour les anciens blocs-notes afin de référencer la nouvelle KMS clé, exportez puis importez chacun des anciens blocs-notes. Si vous supprimez l'ancienne KMS clé avant de mettre à jour les références de l'ancien bloc-notes vers la nouvelle KMS clé, les anciens blocs-notes ne sont plus déchiffrables et ne peuvent pas être récupérés.

Ce comportement s'applique également aux mises à jour des alias, qui sont des noms conviviaux pour les KMS clés. Lorsque vous mettez à jour un alias de KMS clé pour qu'il pointe vers une nouvelle KMS clé, les blocs-notes gérés avant la mise à jour de l'alias font toujours référence à l'ancienne KMS clé, et les blocs-notes gérés après la mise à jour de l'alias utilisent la nouvelle KMS clé. Tenez compte de ces points avant de mettre à jour vos KMS clés ou alias.

-

-

-

(Facultatif) Autres paramètres : développez cette option pour activer ou désactiver l'option Publier CloudWatch les métriques pour le groupe de travail. Ce champ est sélectionné par défaut. Pour de plus amples informations, veuillez consulter Surveillez les calculs d'Apache Spark avec CloudWatch des métriques.

-

(Facultatif) Étiquettes – Utilisez cette option pour ajouter des étiquettes à votre groupe de travail. Pour de plus amples informations, veuillez consulter Tag : ressources d'Athena.

-

Choisissez Créer un groupe de travail. Un message vous informe que le groupe de travail a été créé avec succès et qu'il apparaît dans la liste des groupes de travail.

Étape 2 : Ouvrez l'explorateur de blocs-notes et changez de groupe de travail

Pour pouvoir utiliser le groupe de travail compatible avec Spark que vous venez de créer, vous devez passer au groupe de travail. Pour changer de groupe de travail compatible avec Spark, vous pouvez utiliser l'option Workgroup (Groupe de travail) dans l'explorateur ou l'éditeur de blocs-notes.

Note

Avant de commencer, vérifiez que votre navigateur ne bloque pas les cookies tiers. Tout navigateur qui bloque les cookies tiers par défaut ou en tant que paramètre activé par l'utilisateur empêchera le lancement des bloc-notes. Pour en savoir plus sur la gestion des cookies, voir :

Ouvrir l'explorateur de blocs-notes et changer de groupe de travail

-

Dans le volet de navigation, choisissez Notebook explorer (Explorateur de bloc-notes).

-

Utilisez l'option Workgroup (Groupe de travail) en haut à droite de la console pour choisir le groupe de travail compatible avec Spark que vous avez créé. L'exemple de bloc-notes est affiché dans la liste des blocs-notes.

Vous pouvez utiliser l'explorateur de bloc-notes de la manière suivante :

-

Choisissez le nom associé d'un bloc-notes pour ouvrir le bloc-notes dans une nouvelle session.

-

Pour renommer, supprimer ou exporter votre bloc-notes, utilisez le menu Actions.

-

Pour importer un fichier de bloc-notes, sélectionnez Import file (Importer un fichier).

-

Pour créer un bloc-notes, sélectionnez Create notebook (Créer un bloc-notes).

-

Étape 3 : Exécuter l'exemple de bloc-notes

L'exemple de bloc-notes interroge les données d'un jeu de données disponible publiquement sur les trajets en taxi dans la ville de New York. Le bloc-notes contient des exemples qui montrent comment utiliser Spark DataFramesSQL, Spark et AWS Glue Data Catalog.

Exécuter l'exemple de bloc-notes

-

Dans l'explorateur de blocs-notes, choisissez le nom associé à l'exemple de bloc-notes.

Cela démarre une session de bloc-notes avec les paramètres par défaut et ouvre le bloc-notes dans l'éditeur de blocs-notes. Un message vous informe qu'une nouvelle session Apache Spark a été démarrée en utilisant les paramètres par défaut (20 maximumDPUs).

-

Pour exécuter les cellules dans l'ordre et observer les résultats, cliquez une fois sur le bouton Run (Exécuter) pour chaque cellule du bloc-notes.

-

Faites défiler vers le bas pour voir les résultats et faire apparaître de nouvelles cellules.

-

Pour les cellules qui comportent un calcul, une barre de progression indique le pourcentage achevé, le temps écoulé et le temps restant.

-

L'exemple de bloc-notes crée une base de données et une table dans votre compte. La dernière cellule les supprime lors d'une étape de nettoyage.

-

Note

Si vous modifiez les noms de dossiers, de tables ou de bases de données dans l'exemple de bloc-notes, assurez-vous que ces modifications sont reflétées dans les IAM rôles que vous utilisez. Sinon, le bloc-notes risque de ne pas fonctionner en raison d'autorisations insuffisantes.

Étape 4 : Modifier les détails de la session

Après avoir démarré une session de bloc-notes, vous pouvez modifier les détails de la session tels que le format des tables, le chiffrement, le délai d'inactivité de la session et le nombre maximal d'unités de traitement de données (DPUs) simultanées que vous souhaitez utiliser. A DPU est une mesure relative de la puissance de traitement composée de 4 % vCPUs de capacité de calcul et de 16 Go de mémoire.

Modifier les détails de la session

-

Dans l'éditeur de bloc-notes, dans le menu Session en haut à droite, choisissez Edit session (Modifier la session).

-

Dans la boîte de dialogue Modifier les détails de la session, dans la section Propriétés Spark, choisissez ou saisissez des valeurs pour les options suivantes :

-

Format de table supplémentaire : choisissez Linux Foundation Delta Lake, Apache Hudi, Apache Iceberg ou Personnalisé.

-

Pour les options de tableau Delta, Hudi ou Iceberg, les propriétés de tableau requises pour le format de tableau correspondant vous sont automatiquement fournies dans les options Modifier dans le tableau et Modifier dans JSON. Pour plus d'informations sur l'utilisation de ces formats de table, consultez Utiliser des formats de table autres que Hive dans Athena pour Spark.

-

Pour ajouter ou supprimer des propriétés de tableau pour le type de tableau personnalisé ou pour d'autres types de tableau, utilisez les JSON options Modifier dans le tableau et Modifier dans.

-

Pour l'option Modifier dans la table, choisissez Ajouter une propriété pour ajouter une propriété, ou choisissez Supprimer pour supprimer une propriété. Utilisez les champs Clé et Valeur pour saisir les noms des propriétés et leurs valeurs.

-

Pour l'JSONoption Modifier dans, utilisez l'éditeur de JSON texte pour modifier directement la configuration.

-

Pour copier le JSON texte dans le presse-papiers, choisissez Copier.

-

Pour supprimer tout le texte de l'JSONéditeur, choisissez Effacer.

-

Pour configurer l'habillage des lignes ou choisir un thème de couleur pour l'JSONéditeur, choisissez l'icône des paramètres (engrenage).

-

-

-

Activer le chiffrement Spark : sélectionnez cette option pour chiffrer les données écrites sur le disque et envoyées via les nœuds du réseau Spark. Pour de plus amples informations, veuillez consulter Activer le chiffrement Apache Spark.

-

-

Dans la section Paramètres de la session, choisissez ou saisissez des valeurs pour les options suivantes :

-

Session idle timeout (Délai d'inactivité de la session) – Choisissez ou saisissez une valeur comprise entre 1 et 480 minutes. La valeur par défaut est de 20.

-

Coordinator size (Taille du coordinateur) – Le coordinateur est un exécuteur spécial qui orchestre le travail de traitement et gère les autres exécuteurs d'une session de bloc-notes. Actuellement, 1 DPU est la valeur par défaut et la seule valeur possible.

-

Executor size (Taille de l'exécuteur) – L'exécuteur est la plus petite unité de calcul qu'une session de bloc-notes peut demander à Athena. Actuellement, 1 DPU est la valeur par défaut et la seule valeur possible.

-

Valeur simultanée maximale : nombre maximal de machines DPUs pouvant être exécutées simultanément. La valeur par défaut est 20, le minimum est 3 et le maximum est 60. L'augmentation de cette valeur n'entraîne pas automatiquement l'allocation de ressources supplémentaires, mais Athena tentera d'allouer jusqu'au maximum spécifié lorsque la charge de calcul le nécessite et que des ressources sont disponibles.

-

-

Choisissez Save (Enregistrer).

-

À l'invite Confirm edit (Confirmer la modification), choisissez Confirm (Confirmer).

Athena enregistre votre bloc-notes et démarre une nouvelle session avec les paramètres que vous avez spécifiés. Une bannière dans l'éditeur de bloc-notes vous informe qu'une nouvelle session a commencé avec les paramètres modifiés.

Note

Athena mémorise les paramètres de votre session pour le bloc-notes. Si vous modifiez les paramètres d'une session et que vous mettez ensuite fin à la session, Athena utilise les paramètres de session que vous avez configurés la prochaine fois que vous démarrez une session pour le bloc-notes.

Étape 5 : Afficher les détails de la session et des calculs

Après avoir exécuté le bloc-notes, vous pouvez consulter les détails de votre session et de vos calculs.

Afficher les détails de la session et des calculs

-

Dans le menu Session en haut à droite, choisissez View details (Afficher les détails).

-

L'onglet Current session (Session en cours) affiche des informations sur la session en cours, notamment l'ID de la session, l'heure de création, l'état et le groupe de travail.

-

L'onglet Historique répertorie la session IDs des sessions précédentes. Pour afficher les détails d'une session précédente, sélectionnez l'onglet History (Historique), puis choisissez un ID de session dans la liste.

-

La section Calculations (Calculs) affiche une liste des calculs effectués au cours de la session.

-

-

Pour afficher les détails d'un calcul, choisissez l'ID du calcul.

-

Sur la page Calculation details (Détails du calcul), vous pouvez effectuer les opérations suivantes :

-

Pour consulter le code du calcul, voir la section Code.

-

Pour voir les résultats du calcul, choisissez l'onglet Results (Résultats).

-

Pour télécharger les résultats que vous voyez en format texte, sélectionnez Download results (Télécharger les résultats).

-

Pour afficher les informations sur les résultats du calcul dans Amazon S3, choisissez View in S3 (Afficher dans S3).

-

Étape 6 : Mettre fin à la session

Pour terminer la session du bloc-notes

-

Dans l'éditeur de bloc-notes, dans le menu Session en haut à droite, choisissez Terminate (Terminer).

-

À l'invite Confirm session termination (Confirmer la fin de la session), choisissez Confirm (Confirmer). Votre bloc-notes est enregistré et vous êtes renvoyé à l'éditeur de blocs-notes.

Note

La fermeture d'un onglet de bloc-notes dans l'éditeur de bloc-notes ne met pas automatiquement fin à la session d'un bloc-notes actif. Si vous voulez vous assurer que la session est terminée, utilisez l'option Session, Terminate (Terminer).

Étape 7 : Créez votre propre carnet

Une fois que vous avez créé un groupe de travail Athena compatible avec Spark, vous pouvez créer votre propre bloc-notes.

Pour créer un bloc-notes

-

Si le panneau de navigation de la console n'est pas visible, choisissez le menu d'extension sur la gauche.

-

Dans le volet de navigation de la console Athena, choisissez Notebook Explorer (Explorateur de bloc-notes) ou Notebook Editor (Éditeur de bloc-notes).

-

Effectuez l’une des actions suivantes :

-

Dans Notebook explorer (Explorateur de blocs-notes), choisissez Create notebook (Créer un bloc-notes).

-

Dans Notebook editor (Éditeur de bloc-notes), choisissez Create notebook (Créer un bloc-notes) ou cliquez sur l'icône plus (+) pour ajouter un bloc-notes.

-

-

Dans la boîte de dialogue Create notebook (Créer un bloc-notes), saisissez un nom dans le champ Notebook name (Nom du bloc-notes).

-

(Facultatif) Développez Propriétés Spark, puis choisissez ou saisissez des valeurs pour les options suivantes :

-

Format de table supplémentaire : choisissez Linux Foundation Delta Lake, Apache Hudi, Apache Iceberg ou Personnalisé.

-

Pour les options de tableau Delta, Hudi ou Iceberg, les propriétés de tableau requises pour le format de tableau correspondant vous sont automatiquement fournies dans les options Modifier dans le tableau et Modifier dans JSON. Pour plus d'informations sur l'utilisation de ces formats de table, consultez Utiliser des formats de table autres que Hive dans Athena pour Spark.

-

Pour ajouter ou supprimer des propriétés de tableau pour le type de tableau personnalisé ou pour d'autres types de tableau, utilisez les JSON options Modifier dans le tableau et Modifier dans.

-

Pour l'option Modifier dans la table, choisissez Ajouter une propriété pour ajouter une propriété, ou choisissez Supprimer pour supprimer une propriété. Utilisez les champs Clé et Valeur pour saisir les noms des propriétés et leurs valeurs.

-

Pour l'JSONoption Modifier dans, utilisez l'éditeur de JSON texte pour modifier directement la configuration.

-

Pour copier le JSON texte dans le presse-papiers, choisissez Copier.

-

Pour supprimer tout le texte de l'JSONéditeur, choisissez Effacer.

-

Pour configurer l'habillage des lignes ou choisir un thème de couleur pour l'JSONéditeur, choisissez l'icône des paramètres (engrenage).

-

-

-

Activer le chiffrement Spark : sélectionnez cette option pour chiffrer les données écrites sur le disque et envoyées via les nœuds du réseau Spark. Pour de plus amples informations, veuillez consulter Activer le chiffrement Apache Spark.

-

-

(Facultatif) Développez Session parameters (Paramètres de session), puis choisissez ou saisissez des valeurs pour les options suivantes :

-

Session idle timeout (Délai d'inactivité de la session) – Choisissez ou saisissez une valeur comprise entre 1 et 480 minutes. La valeur par défaut est de 20.

-

Coordinator size (Taille du coordinateur) – Le coordinateur est un exécuteur spécial qui orchestre le travail de traitement et gère les autres exécuteurs d'une session de bloc-notes. Actuellement, 1 DPU est la valeur par défaut et la seule valeur possible. Une DPU (unité de traitement des données) est une mesure relative de la puissance de traitement composée de 4 % vCPUs de capacité de calcul et de 16 Go de mémoire.

-

Executor size (Taille de l'exécuteur) – L'exécuteur est la plus petite unité de calcul qu'une session de bloc-notes peut demander à Athena. Actuellement, 1 DPU est la valeur par défaut et la seule valeur possible.

-

Valeur simultanée maximale : nombre maximal de machines DPUs pouvant être exécutées simultanément. La valeur par défaut est 20 et la valeur maximale est 60. L'augmentation de cette valeur n'entraîne pas automatiquement l'allocation de ressources supplémentaires, mais Athena tentera d'allouer jusqu'au maximum spécifié lorsque la charge de calcul le nécessite et que des ressources sont disponibles.

-

-

Sélectionnez Create (Créer). Votre bloc-notes s'ouvre dans une nouvelle session dans l'éditeur de bloc-notes.

Pour plus d'informations sur la gestion des fichiers de votre bloc-notes, consultezGérer les fichiers du bloc-notes.