Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Didacticiel : Ajout d'un crawler AWS Glue

Pour ce AWS Glue, il vous est demandé d'analyser les données d'arrivée des principaux transporteurs aériens afin de calculer la popularité des aéroports de départ d'un mois à l'autre. Vous disposez de données de vols pour l'année 2016 au format CSV stockées dans Amazon S3. Avant de transformer et d'analyser vos données, vous cataloguez ses métadonnées dans AWS Glue Data Catalog.

Dans ce didacticiel, ajoutons un crawler qui déduit les métadonnées de ces journaux de vol dans Amazon S3 et crée une table dans votre catalogue de données.

Rubriques

Prérequis

Ce tutoriel suppose que vous avez un compte AWS et un accès à AWS Glue.

Étape 1 : Ajouter un crawler

Procédez comme suit pour configurer et exécuter un crawler qui extrait les métadonnées d'un fichier CSV stocké dans Amazon S3.

Pour créer un crawler qui lit les fichiers stockés sur Amazon S3

-

Dans la console de service AWS Glue, dans le menu de gauche, sélectionnez Crawlers.

-

Sur la page Crawlers, sélectionnez Créer un Crawler. Cela démarre une série de pages qui vous invitent à saisir les détails du crawler.

-

Dans le champ Nom de l'analyseur, saisissez

Flights Data Crawler, et sélectionnez Suivant.Les crawlers invoquent les classifieurs pour déduire le schéma de vos données. Ce didacticiel utilise le classifieur intégré pour CSV par défaut.

-

Pour le type de source du crawler, sélectionnez Data stores (Magasins de données), puis Next (Suivant).

-

Maintenant, faisons pointer le crawler vers vos données. Sur la page Add a data store (Ajouter un magasin de données), sélectionnez le magasin de données Amazon S3. Ce tutoriel n'utilise pas de connexion, alors laissez le champ Connection (Connexion) vide s'il est visible.

Pour l'option Crawl data in (Analyser les données dans), sélectionnez Specified path in another account (Chemin d'accès spécifié dans un autre compte). Ensuite, pour Inclure le chemin, saisissez le chemin où le crawler peut trouver les données de vol, qui est

s3://crawler-public-us-east-1/flight/2016/csv. Après avoir saisi le chemin d'accès, le titre de ce champ devient Include path (Inclure le chemin). Choisissez Next (Suivant). -

Vous pouvez analyser plusieurs magasins de données avec un seul crawler. Cependant, dans ce tutoriel, nous n'utilisons qu'un seul magasin de données, alors sélectionnez No (Non), puis Next (Suivant).

-

Le crawler a besoin d'autorisations pour accéder au magasin de données et créer des objets dans le répertoire AWS Glue Data Catalog. Pour configurer ces autorisations, sélectionnez Create an IAM role (Créer un rôle IAM). Le nom du rôle IAM commence par

AWSGlueServiceRole-, et dans le champ, vous saisissez la dernière partie du nom du rôle. SaisissezCrawlerTutorial, puis sélectionnez Save (Enregistrer).Note

Pour créer un rôle IAM, votre utilisateur AWS doit avoir les autorisations

CreateRole,CreatePolicyetAttachRolePolicy.L'assistant crée un rôle IAM nommé

AWSGlueServiceRole-CrawlerTutorial, attache la politiqueAWSGlueServiceRolegérée par AWS à ce rôle, et ajoute une politique en ligne qui autorise l'accès en lecture à l'emplacement Amazon S3s3://crawler-public-us-east-1/flight/2016/csv. -

Créez une planification pour le crawler. Pour Frequency (Fréquence), sélectionnez Run on demand (Exécuter à la demande), puis Next (Suivant).

-

Les crawlers créent des tables dans votre catalogue de données. Les tables sont contenues dans une base de données dans le catalogue de données. Tout d'abord, sélectionnez Add database (Ajouter une base de données) pour créer une base de données. Dans la fenêtre contextuelle, saisissez

test-flights-dbpour le nom de la base de données, puis sélectionnez Create (Créer).Ensuite, saisissez

flightspour Prefix added to tables (Préfixe ajouté aux tables). Utilisez les valeurs par défaut pour le reste des champs et sélectionnez Next (Suivant). -

Vérifiez les choix que vous avez fait dans le panneau Add crawler (Ajouter un analyseur) de l'assistant. Si vous voyez des erreurs, vous pouvez choisir Back (Retour) pour revenir aux pages précédentes et apporter des modifications.

Après avoir examiné les informations, sélectionnez Terminer pour créer le crawler.

Étape 2 : Exécuter le crawler

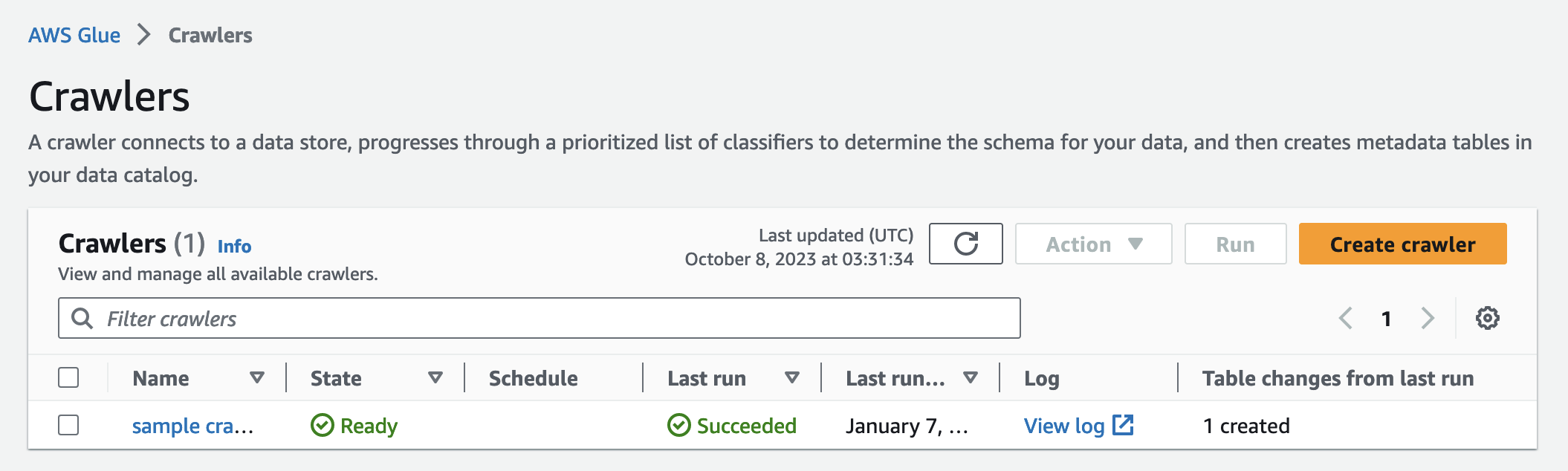

Après avoir créé un crawler, l'assistant vous envoie à la page d'affichage des Crawlers. Étant donné que vous créez le crawler avec une planification à la demande, vous avez la possibilité d'exécuter le crawler.

Pour exécuter un crawler

-

La bannière située en haut de cette page vous indique que le crawler a été créé et vous demande si vous souhaitez l'exécuter maintenant. Sélectionnez Lancez-le maintenant ? pour exécuter le crawler.

La bannière change pour afficher les messages « Tentative d'exécution » et « Exécution » pour votre crawler. Une fois que le crawler démarre, la bannière disparaît et l'affichage du crawler est mis à jour pour afficher l'état Starting (Démarrage) de celui-ci. Après une minute, vous pouvez cliquer sur l'icône Actualiser pour mettre à jour l'état du crawler qui s'affiche dans le tableau.

-

Une fois que le crawler a terminé sa tâche, une nouvelle bannière s'affiche qui décrit les modifications apportées par le crawler. Vous pouvez choisir le lien test-flights-db pour afficher les objets du catalogue de données.

Étape 3 : Afficher les objets AWS Glue Data Catalog

Le crawler lit les données à l'emplacement source et crée des tables dans le catalogue de données. Une table est une définition de métadonnées qui représente vos données. Les tables du catalogue de données ne contiennent pas de données. Au lieu de cela, vous utilisez ces tables comme source ou cible dans une définition de tâche.

Pour afficher les objets du catalogue de données créés par le crawler.

-

Dans le panneau de navigation de gauche, sous Data catalog (Catalogue de données), sélectionnez Databases (Bases de données). Ici, vous pouvez voir la base de données

flights-dbqui est créée par le crawler. -

Dans le panneau de navigation de gauche, sous Data catalog (Catalogue de données), et sous Databases (Bases de données), sélectionnez Tables. Ici, vous pouvez voir la table

flightscsvqui est créée par le crawler. Si vous sélectionnez le nom de la table, vous pouvez afficher la configuration, les paramètres et les propriétés de la table. En faisant défiler cette vue vers le bas, vous pouvez afficher le schéma, qui est une information sur les colonnes et les types de données de la table. -

Si vous sélectionnez View partitions (Afficher les partitions) sur la page d'affichage de la table, vous pouvez voir les partitions créées pour les données. La première colonne est la clé de partition.