Nous ne mettons plus à jour le service Amazon Machine Learning et n'acceptons plus de nouveaux utilisateurs pour ce service. Cette documentation est disponible pour les utilisateurs existants, mais nous ne la mettons plus à jour. Pour plus d'informations, veuillez consulter la rubriqueQu'est-ce qu'Amazon Machine Learning.

Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Analyse du modèle binaire

Interprétation des prédictions

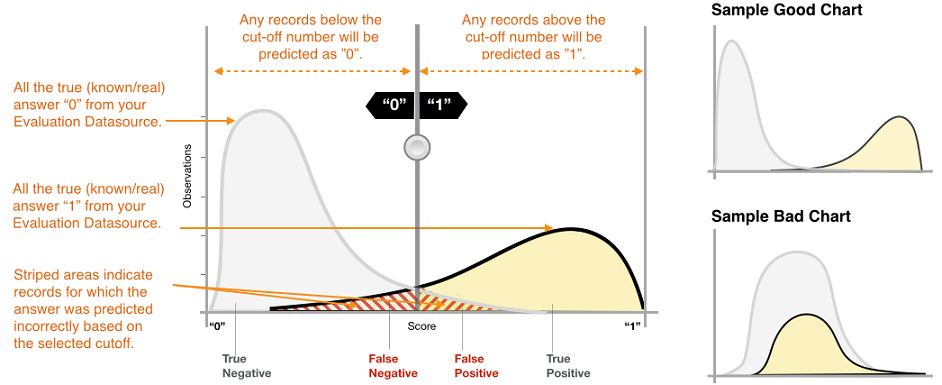

La sortie réelle de nombreux algorithmes de classification binaire est un score de prédiction. Ce score indique la certitude du système que l'observation donnée appartient à la classe des positifs (la valeur cible réelle est 1). Les modèles de classification binaire dans Amazon ML génèrent un score compris entre 0 et 1. En tant que consommateur de ce score, pour décider si l'observation doit être classée comme 1 ou 0, vous interprétez le score en sélectionnant une limite de classification, ou seuil, et comparez le score à ce seuil. Toutes les observations avec des scores supérieurs au seuil sont prédites comme cible = 1, et les scores inférieurs au seuil sont prédits comme cible = 0.

Dans Amazon ML, le score limite par défaut est 0,5. Vous pouvez choisir de mettre à jour cette limite en fonction des besoins de votre entreprise. Vous pouvez utiliser les visualisations disponibles dans la console pour comprendre comment le choix du seuil affectera votre application.

Mesure de la précision du modèle d'apprentissage-machine

Amazon ML fournit une métrique de précision conforme aux normes du secteur pour les modèles de classification binaire, appelée Area Under the (Receiver Operating Characteristic) Curve (AUC). La métrique AUC mesure l'aptitude du modèle à prédire un score plus élevé pour les exemples positifs par rapport aux exemples négatifs. Comme cela est indépendant du score seuil, vous pouvez vous faire une idée de la précision des prédictions de votre modèle à partir de la métrique AUC, sans choisir de seuil.

Elle renvoie une valeur décimale comprise entre 0 et 1. Les valeurs AUC proches de 1 indiquent un modèle ML qui est très précis. Les valeurs proches de 0,5 indiquent un modèle d'apprentissage-machine qui n'est pas meilleur que de deviner au hasard. Les valeurs proches de 0 sont inhabituelles et indiquent généralement un problème avec les données. Fondamentalement, une valeur AUC proche de 0 indique que le modèle d'apprentissage-machine a appris les bonnes tendances, mais les utilise pour effectuer des prédictions inversées par rapport à la réalité (les « 0 » sont prédits comme des « 1 » et vice versa). Pour plus d'informations sur la métrique AUC, accédez à la page Courbe ROC

La métrique AUC de base pour un modèle binaire est 0,5. C'est la valeur correspondant à un modèle d'apprentissage-machine hypothétique qui prédit de façon aléatoire une réponse égale à 1 ou à 0. Votre modèle d'apprentissage-machine binaire doit avoir de meilleurs résultats que cette valeur pour commencer à être intéressant.

Utilisation de la visualisation des performances

Pour étudier la précision du modèle d'apprentissage, vous pouvez consulter les graphiques à laEvaluationsur la console Amazon ML. Cette page montre deux histogrammes : a) un histogramme des scores pour les positifs observés (la cible est 1) et b) un histogramme des scores pour les négatifs observés (la cible est 0) dans les données d'évaluation.

Un modèle d'apprentissage-machine qui a une bonne précision prédictive prédira de meilleurs scores pour les « 1 » observés et des scores inférieurs pour les « 0 » observés. Un modèle parfait aura ces deux histogrammes aux deux extrémités de l'axe des x, montrant que les positifs observés ont tous eu des scores élevés et que les négatifs observés ont tous eu des scores bas. Cependant, les modèles d'apprentissage-machine commettent des erreurs et un graphique typique indiquera que les deux histogrammes se chevauchent pour certains scores. Un modèle extrêmement inefficace ne pourra pas distinguer entre les classes des positifs et des négatifs, et les deux classes auront des histogrammes majoritairement superposés.

Grâce aux visualisations, vous pouvez identifier le nombre de prédictions qui appartiennent aux deux types de prédictions correctes et aux deux types de prédictions erronées.

Prédictions correctes

-

Vrai positif (TP, True positive) : Amazon ML a prédit la valeur 1, et la valeur constatée est 1.

-

Vrai négatif (TN, Vrai négatif) Amazon ML a prédit la valeur 0, et la valeur constatée est 0.

Prédictions erronées

-

Faux positif (FP, False positive) Amazon ML a prédit la valeur 1, mais la valeur constatée est 0.

-

Faux négatif (FN, False Negative) Amazon ML a prédit la valeur 0, mais la valeur constatée est 1.

Note

Le nombre de VP, VN, FP et FN dépend du score seuil sélectionné, et l'optimisation de l'un quelconque de ces nombres s'effectue aux dépens des autres. Un nombre élevé de VP entraîne généralement un nombre élevé de FP et un nombre réduit de VN.

Ajustement du score seuil

Les modèles d'apprentissage-machine fonctionnent en générant des scores de prédiction numériques, puis en appliquant un seuil pour convertir ces scores en étiquettes 0/1 binaires. En changeant le score seuil, vous pouvez ajuster le comportement du modèle lorsqu'il effectue une erreur. Dans la pageEvaluationdans la console Amazon ML, vous pouvez consulter l'impact de divers scores seuil et vous pouvez enregistrer le score seuil que vous souhaitez utiliser pour votre modèle.

Lorsque vous ajustez le score seuil, observez le compromis que cela représente entre les deux types d'erreurs. Déplacer le seuil vers la gauche capture plus de vrais positifs, mais la contre-partie est une augmentation du nombre d'erreurs de faux positifs. Le déplacer vers la droite capture moins d'erreurs de faux positifs, mais la contre-partie est de manquer certains vrais positifs. Pour votre application prédictive, vous décidez du type d'erreur qui est plus tolérable en sélectionnant un score seuil approprié.

Revue des métriques avancées

Amazon ML fournit les métriques supplémentaires suivantes pour mesurer la précision prédictive du modèle d'apprentissage : la précision, le taux de positifs prédits, la sensibilité et le taux de faux positifs.

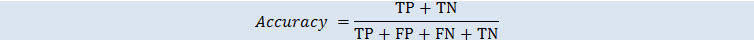

Accuracy

La précision (ACC) mesure la fraction de prédictions correctes. La plage est comprise entre 0 et 1. Plus la valeur est grande et meilleure est la précision prédictive :

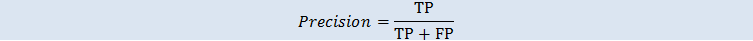

Précision

Le taux de positifs prédits mesure la fraction de positifs observés parmi les exemples prédits comme positifs. La plage est comprise entre 0 et 1. Plus la valeur est grande et meilleure est la précision prédictive :

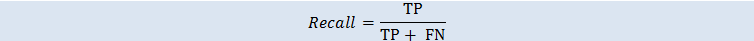

Sensibilité

La sensibilité mesure la fraction de positifs observés qui sont prédits comme positifs. La plage est comprise entre 0 et 1. Plus la valeur est grande et meilleure est la précision prédictive :

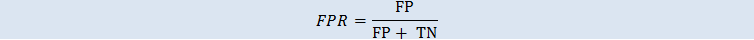

Taux de faux positifs

Le taux de faux positifs (TFP) mesure le taux de fausses alertes ou la fraction de négatifs observés qui sont prédits comme positifs. La plage est comprise entre 0 et 1. Plus la valeur est petite et meilleure est la précision prédictive :

En fonction de votre problème, vous pouvez être plus intéressé par un modèle performant pour un sous-ensemble spécifique de ces métriques. Par exemple, deux applications métier peuvent avoir des exigences très différentes en matière de modèle d'apprentissage-machine :

-

Une application peut avoir besoin d'être extrêmement certaine que les prédictions positives soient effectivement positives (taux de positifs prédits élevé) et peut se permettre de mal classer certains exemples positifs comme négatifs (sensibilité moyenne).

-

Une autre application peut avoir besoin de prédire correctement autant d'exemples positifs que possible (haute sensibilité) et acceptera que certains exemples négatifs soient mal classés comme positifs (taux de positifs prédits moyen).

Amazon ML vous permet de choisir un score seuil qui correspond à une valeur particulière de l'une quelconque des métriques avancées précédentes. Il montre également les compromis induits par l'optimisation d'une métrique quelconque. Par exemple, si vous sélectionnez un seuil qui correspond à un taux de positifs prédits élevé, vous devez généralement accepter une baisse de la sensibilité en contre-partie.

Note

Vous devez enregistrer le score seuil pour qu'il prenne effet lors de la classification de futures prédictions par votre modèle d'apprentissage-machine.