Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Infrastructure UO – Compte réseau

| Influencez le futur de l'architecture de référence de AWS sécurité (AWS SRA) en répondant à une courte enquête |

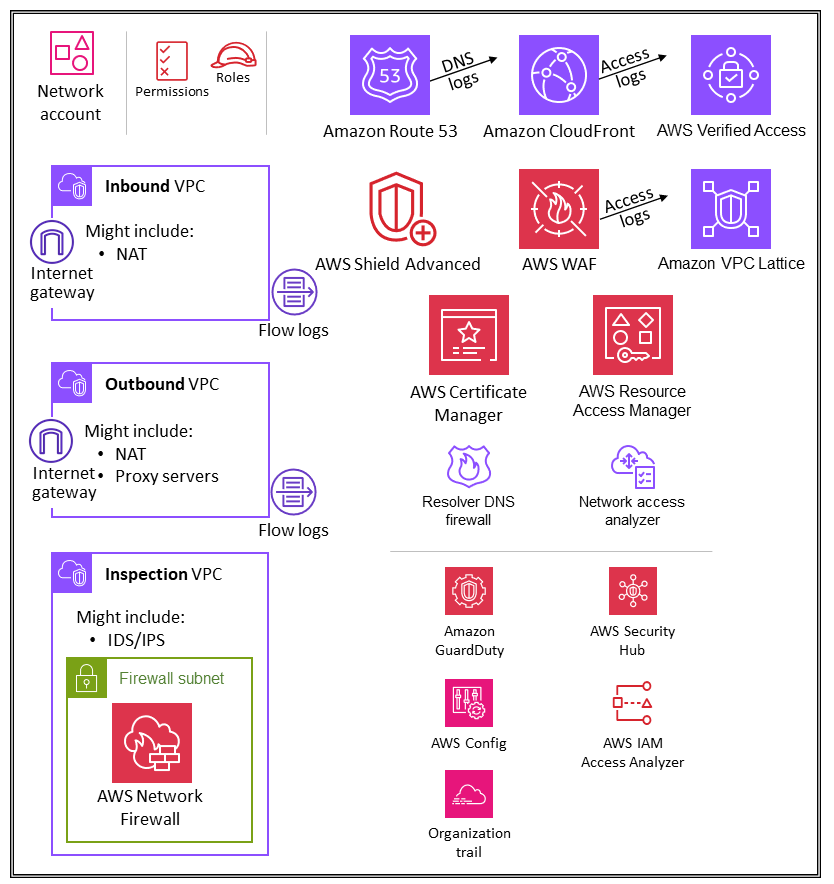

Le schéma suivant illustre les services de AWS sécurité configurés dans le compte réseau.

Le compte réseau gère la passerelle entre votre application et Internet en général. Il est important de protéger cette interface bidirectionnelle. Le compte Réseau isole les services, la configuration et le fonctionnement du réseau des charges de travail des applications individuelles, de la sécurité et des autres infrastructures. Cette disposition permet non seulement de limiter la connectivité, les autorisations et le flux de données, mais aussi de favoriser la séparation des tâches et le moindre privilège pour les équipes qui ont besoin d’opérer sur ces comptes. En divisant le flux réseau en clouds privés virtuels entrants et sortants distincts (VPCs), vous pouvez protéger l'infrastructure et le trafic sensibles contre les accès indésirables. Le réseau entrant est généralement considéré comme présentant un risque plus élevé et doit faire l’objet d’un routage, d’une surveillance et d’une atténuation des problèmes potentiels appropriés. Ces comptes d’infrastructure hériteront des barrières de protection d’autorisation du compte de gestion de l’organisation et de l’UO de l’infrastructure. Les équipes de mise en réseau (et de sécurité) gèrent la majorité de l’infrastructure de ce compte.

Architecture réseau

Bien que la conception et les spécificités du réseau dépassent le cadre de ce document, nous recommandons les trois options suivantes pour la connectivité réseau entre les différents comptes : VPC peering et AWS Transit Gateway. AWS PrivateLink Les normes opérationnelles, les budgets et les besoins spécifiques en matière de bande passante sont des éléments importants à prendre en compte lors du choix de l’un d’entre eux.

-

VPCpeering ‒ Le moyen le plus simple d'en connecter deux VPCs est d'utiliser le VPC peering. Une connexion permet une connectivité bidirectionnelle complète entre lesVPCs. VPCsqui se trouvent dans des comptes distincts et AWS les régions peuvent également être comparées entre elles. À grande échelle, lorsque vous en avez des dizaines, voire des centainesVPCs, leur interconnexion par le biais du peering se traduit par un maillage de centaines, voire de milliers de connexions d'appairage, ce qui peut être difficile à gérer et à faire évoluer. VPCil est préférable d'utiliser le peering lorsque les ressources d'une connexion VPC doivent communiquer avec les ressources d'une autreVPC, que l'environnement des deux VPCs est contrôlé et sécurisé et que le nombre de personnes VPCs à connecter est inférieur à 10 (pour permettre la gestion individuelle de chaque connexion).

-

AWS PrivateLink

‒ PrivateLink fournit une connectivité privée entre VPCs les services et les applications. Vous pouvez créer votre propre application dans votre VPC et la configurer en tant que service PrivateLink alimenté par des serveurs (appelé service de point de terminaison). Les autres AWS principaux peuvent créer une connexion entre leur VPC service de point de terminaison et votre service de point de terminaison en utilisant un point de VPCterminaison d'interface ou un point de terminaison Gateway Load Balancer, selon le type de service. Lorsque vous l'utilisez PrivateLink, le trafic de service ne passe pas par un réseau routable publiquement. À utiliser PrivateLink lorsque vous disposez d'une configuration client-serveur dans laquelle vous souhaitez accorder à un ou plusieurs consommateurs un accès VPCs unidirectionnel à un service ou à un ensemble d'instances spécifiques du fournisseur de services. VPC C'est également une bonne option lorsque les adresses IP des clients et des serveurs des deux sites VPCs se chevauchent, car elle PrivateLink utilise des interfaces réseau élastiques au sein du client VPC afin d'éviter tout conflit d'adresses IP avec le fournisseur de services. -

AWSTransit Gateway

‒ Transit Gateway fournit une hub-and-spoke conception pour la connexion VPCs et les réseaux sur site en tant que service entièrement géré sans que vous ayez à provisionner des dispositifs virtuels. AWSgère la haute disponibilité et l'évolutivité. Une passerelle de transport en commun est une ressource régionale qui peut relier des milliers de personnes VPCs au sein d'une même AWS région. Vous pouvez associer votre connectivité hybride (VPNet vos connexions AWS Direct Connect) à une passerelle de transit unique, consolidant et contrôlant ainsi l'ensemble de la configuration de routage de votre AWS entreprise en un seul endroit. Une passerelle de transit résout la complexité liée à la création et à la gestion de plusieurs connexions VPC d'appairage à grande échelle. Il s'agit de la valeur par défaut pour la plupart des architectures réseau, mais des besoins spécifiques en matière de coût, de bande passante et de latence peuvent faire en sorte que le VPC peering réponde mieux à vos besoins.

Entrant (entrée) VPC

L'entrée VPC est destinée à accepter, inspecter et acheminer les connexions réseau initiées en dehors de l'application. En fonction des spécificités de l'application, vous pouvez vous attendre à y voir une traduction d'adresses réseau (NAT)VPC. Les journaux de flux qui en découlent VPC sont capturés et stockés dans le compte Log Archive.

Sortant (sortie) VPC

Le trafic sortant VPC est destiné à gérer les connexions réseau initiées depuis l'application. En fonction des spécificités de l'application, vous pouvez vous attendre à y voir du traficNAT, des points de VPC terminaison AWS spécifiques au service et l'hébergement de points de API terminaison externes. VPC Les journaux de flux qui en découlent VPC sont capturés et stockés dans le compte Log Archive.

Inspection VPC

Une inspection dédiée VPC fournit une approche simplifiée et centralisée pour gérer les inspections entre VPCs (dans la même région ou dans différentes AWS régions), Internet et les réseaux locaux. Dans ce cas AWSSRA, assurez-vous que tout le trafic entre les deux VPCs passe par l'inspection VPC et évitez d'utiliser l'inspection VPC pour toute autre charge de travail.

AWS Network Firewall

AWSNetwork Firewall

Vous utilisez un pare-feu par zone de disponibilité dans votreVPC. Pour chaque zone de disponibilité, vous choisissez un sous-réseau pour héberger le point de terminaison du pare-feu qui filtre votre trafic. Le point de terminaison du pare-feu d’une zone de disponibilité peut protéger tous les sous-réseaux de la zone, à l’exception du sous-réseau dans lequel il se trouve. Selon le cas d’utilisation et le modèle de déploiement, le sous-réseau du pare-feu peut être public ou privé. Le pare-feu est totalement transparent pour le flux de trafic et n'effectue pas de traduction d'adresses réseau (NAT). Il préserve l’adresse de la source et de la destination. Dans cette architecture de référence, les points de terminaison du pare-feu sont hébergés dans le cadre d'une inspectionVPC. Tout le trafic entrant VPC et sortant VPC est acheminé via ce sous-réseau de pare-feu à des fins d'inspection.

Network Firewall rend l'activité du pare-feu visible en temps réel grâce aux CloudWatch métriques Amazon et offre une visibilité accrue du trafic réseau en envoyant des journaux à Amazon Simple Storage Service (Amazon S3) CloudWatch et à Amazon Data Firehose. Network Firewall est interopérable avec votre approche de sécurité existante, y compris les technologies des AWSpartenaires

Dans le AWSSRA, Network Firewall est utilisé dans le compte réseau car les fonctionnalités du service axées sur le contrôle du réseau correspondent à l'intention du compte.

Considérations relatives à la conception

-

AWSFirewall Manager prend en charge le Network Firewall, ce qui vous permet de configurer et de déployer de manière centralisée les règles de Network Firewall au sein de votre entreprise. (Pour plus de détails, consultez les politiques de AWS Network Firewall dans la AWS documentation.) Lorsque vous configurez Firewall Manager, celui-ci crée automatiquement un pare-feu avec des ensembles de règles VPCs que vous spécifiez dans les comptes. Il déploie également un point de terminaison dans un sous-réseau dédié pour chaque zone de disponibilité contenant des sous-réseaux publics. Dans le même temps, toute modification apportée à l’ensemble de règles configuré de manière centralisée est automatiquement mise à jour en aval sur les pare-feux Network Firewall déployés.

-

Plusieurs modèles de déploiement

sont disponibles avec Network Firewall. Le bon modèle dépend de votre cas d’utilisation et de vos besoins. Voici quelques exemples : -

Modèle de déploiement distribué dans lequel Network Firewall est déployé de manière individuelleVPCs.

-

Modèle de déploiement centralisé dans lequel Network Firewall est déployé dans un système centralisé VPC pour le trafic est-ouest (VPC-vers-VPC) ou nord-sud (entrée et sortie Internet, sur site).

-

Modèle de déploiement combiné dans lequel Network Firewall est déployé dans un système centralisé VPC pour le trafic est-ouest et un sous-ensemble de trafic nord-sud.

-

-

En guise de bonne pratique, n’utilisez pas le sous-réseau Network Firewall pour déployer d’autres services. En effet, Network Firewall ne peut pas inspecter le trafic provenant de sources ou de destinations situées dans le sous-réseau du pare-feu.

Analyseur d’accès réseau

L'analyseur d'accès réseau est une fonctionnalité d'Amazon VPC qui identifie les accès réseau non intentionnels à vos ressources. Vous pouvez utiliser l’analyseur d’accès réseau pour valider la segmentation du réseau, identifier les ressources accessibles depuis Internet ou accessibles uniquement à partir de plages d’adresses IP fiables, et vérifier que vous disposez des contrôles réseau appropriés sur tous les chemins réseau.

Network Access Analyzer utilise des algorithmes de raisonnement automatisés pour analyser les chemins réseau qu'un paquet peut emprunter entre les ressources d'un AWS réseau et produit des résultats pour les chemins correspondant à l'étendue d'accès réseau que vous avez définie. L’analyseur d’accès réseau effectue une analyse statique de la configuration d’un réseau, ce qui signifie qu’aucun paquet n’est transmis sur le réseau dans le cadre de cette analyse.

Les règles d’accessibilité du réseau Amazon Inspector fournissent une fonctionnalité connexe. Les résultats générés par ces règles sont utilisés dans le compte de l’application. Network Access Analyzer et Network Reachability utilisent tous deux les dernières technologies issues de l'initiative AWS Provable Security

Le compte réseau définit l'infrastructure réseau critique qui contrôle le trafic entrant et sortant de votre AWS environnement. Ce trafic doit être étroitement surveillé. Dans le AWSSRA, l'analyseur d'accès réseau est utilisé dans le compte réseau pour aider à identifier les accès réseau non intentionnels, à identifier les ressources accessibles à Internet via des passerelles Internet et à vérifier que les contrôles réseau appropriés tels que les pare-feux et les passerelles réseau sont présents sur tous les chemins réseau entre les ressources et les NAT passerelles Internet.

Considération relative à la conception

-

Network Access Analyzer est une fonctionnalité d'AmazonVPC, et il peut être utilisé dans n'importe quel AWS compte doté d'unVPC. Les administrateurs réseau peuvent obtenir des IAM rôles intercomptes étroitement définis afin de vérifier que les chemins réseau approuvés sont appliqués au sein de chaque AWS compte.

AWS RAM

AWSResource Access Manager

AWSRAMvous permet de partager des ressources qui ne prennent pas en charge les politiques IAM basées sur les ressources, telles que les VPC sous-réseaux et les règles Route 53. De plus, avec AWSRAM, les propriétaires d'une ressource peuvent voir quels principaux ont accès aux ressources individuelles qu'ils ont partagées. IAMles entités peuvent récupérer directement la liste des ressources partagées avec elles, ce qu'elles ne peuvent pas faire avec les ressources partagées par les politiques de IAM ressources. S'il AWS RAM est utilisé pour partager des ressources en dehors de votre AWS organisation, un processus d'invitation est lancé. Le destinataire doit accepter l’invitation avant que l’accès aux ressources ne soit accordé. Cela permet de renforcer les contrôles et les équilibres.

AWSRAMest invoqué et géré par le propriétaire de la ressource, dans le compte sur lequel la ressource partagée est déployée. Un cas d'utilisation courant AWS RAM illustré dans le AWS SRA est que les administrateurs réseau partagent des VPC sous-réseaux et des passerelles de transit avec l'ensemble AWS de l'organisation. Cela permet de dissocier les fonctions de gestion des AWS comptes et du réseau et contribue à la séparation des tâches. Pour plus d'informations sur le VPC partage, consultez le billet de AWS blog sur le VPCpartage : une nouvelle approche en matière de VPC gestion et de comptes multiples

Considération relative à la conception

-

Bien AWS RAM qu'un service soit déployé uniquement dans le compte réseau du AWSSRA, il est généralement déployé sur plusieurs comptes. Par exemple, vous pouvez centraliser la gestion de votre lac de données sur un seul compte de lac de données, puis partager les ressources du catalogue de données de AWS Lake Formation (bases de données et tables) avec d'autres comptes de votre AWS organisation. Pour plus d'informations, consultez la documentation de AWS Lake Formation et le billet de AWS blog Partagez vos données en toute sécurité entre AWS comptes à l'aide de AWS Lake Formation

. En outre, les administrateurs de sécurité peuvent AWS RAM suivre les meilleures pratiques lorsqu'ils créent une Autorité de certification privée AWS hiérarchie. CAspeuvent être partagés avec des tiers externes, qui peuvent émettre des certificats sans avoir accès à la hiérarchie de l'autorité de certification. Cela permet aux organisations d’origine de limiter et de révoquer l’accès des tiers.

Accès vérifié AWS

AWSVerified Access

L’accès vérifié prend en charge deux modèles d’applications d’entreprise courants : internes et orientées vers Internet. L’accès vérifié s’intègre aux applications à l’aide d’Application Load Balancer ou d’interfaces réseau élastiques. Si vous utilisez un Application Load Balancer, l’accès vérifié nécessite un équilibreur de charge interne. Comme Verified Access est compatible AWS WAF au niveau de l'instance, une application existante intégrée à un Application Load Balancer peut déplacer les politiques de l'équilibreur de charge vers l'instance Verified Access. AWS WAF Une application d’entreprise est représentée sous la forme d’un point de terminaison d’accès vérifié. Chaque point de terminaison est associé à un groupe d’accès vérifié et hérite de la stratégie d’accès du groupe. Un groupe d’accès vérifié est un ensemble de points de terminaison d’accès vérifié et une stratégie d’accès vérifié au niveau du groupe. Les groupes simplifient la gestion des stratégies et permettent aux administrateurs informatiques de définir des critères de base. Les propriétaires d’applications peuvent en outre définir des stratégies détaillées en fonction de la sensibilité de l’application.

Dans le AWSSRA, l'accès vérifié est hébergé dans le compte réseau. L’équipe informatique centrale met en place des configurations gérées de manière centralisée. Par exemple, les membres de l’équipe peuvent connecter des fournisseurs de confiance tels que des fournisseurs d’identité (par exemple, Okta) et des fournisseurs de confiance d’appareils (par exemple, Jamf), créer des groupes et déterminer la stratégie au niveau du groupe. Ces configurations peuvent ensuite être partagées avec des dizaines, des centaines ou des milliers de comptes de charge de travail à l'aide de AWS Resource Access Manager (AWSRAM). Cela permet aux équipes chargées des applications de gérer les points de terminaison sous-jacents qui gèrent leurs applications sans que d’autres équipes aient à s’en soucier. AWSRAMfournit un moyen évolutif de tirer parti de l'accès vérifié pour les applications d'entreprise hébergées sur différents comptes de charge de travail.

Considération relative à la conception

-

Vous pouvez regrouper les points de terminaison des applications qui ont des exigences de sécurité similaires afin de simplifier l’administration des stratégies, puis partager le groupe avec les comptes d’application. Toutes les applications du groupe partagent la même stratégie de groupe. Si une application du groupe nécessite une stratégie spécifique en raison d’un cas particulier, vous pouvez appliquer une stratégie au niveau de l’application pour cette application.

Amazon VPC Lattice

Amazon VPC Lattice

VPCLattice s'intègre à AWS Resource Access Manager (AWSRAM) pour permettre le partage de services et de réseaux de services. AWSSRAdécrit une architecture distribuée dans laquelle les développeurs ou les propriétaires de services créent des services VPC Lattice dans leur compte d'application. Les propriétaires de services définissent les écouteurs, les règles de routage et les groupes cibles ainsi que les stratégies d’authentification. Ils partagent ensuite les services avec d'autres comptes et les associent aux réseaux de services VPC Lattice. Ces réseaux sont créés par les administrateurs réseau dans le compte réseau et partagés avec le compte d’application. Les administrateurs réseau configurent les stratégies d’authentification au niveau du réseau de services et la surveillance. Les administrateurs associent VPCs les services VPC Lattice à un ou plusieurs réseaux de services. Pour une présentation détaillée de cette architecture distribuée, consultez le billet de AWS blog Créez une VPC connectivité multi-comptes sécurisée pour vos applications avec Amazon VPC

Considération relative à la conception

-

En fonction du modèle opérationnel de votre organisation en matière de services ou de visibilité du réseau de services, les administrateurs réseau peuvent partager leurs réseaux de services et donner aux propriétaires de services le contrôle nécessaire pour associer leurs services et VPCs à ces réseaux de services. Les propriétaires de services peuvent également partager leurs services et les administrateurs de réseaux peuvent associer les services à des réseaux de services.

Un client peut envoyer des demandes à des services associés à un réseau de services uniquement s'il fait partie d'un VPC réseau associé au même réseau de services. Le trafic client qui passe par une connexion d'VPCappairage ou une passerelle de transit est refusé.

Sécurit à la périphérie

La sécurité périphérique implique généralement trois types de protection : la diffusion sécurisée du contenu, la protection du réseau et de la couche applicative, et l'atténuation des attaques par déni de service distribué (DDoS). Les contenus tels que les données, les vidéos, les applications APIs doivent être diffusés rapidement et en toute sécurité, en utilisant la version recommandée de TLS pour crypter les communications entre les points de terminaison. Le contenu doit également être soumis à des restrictions d'accès via des cookies signés et une authentification par jeton. URLs La sécurité au niveau des applications doit être conçue pour contrôler le trafic des robots, bloquer les modèles d'attaque courants tels que l'SQLinjection ou les scripts intersites (XSS) et fournir une visibilité sur le trafic Web. À la périphérie, l'DDoSatténuation fournit une couche de défense importante qui garantit la disponibilité continue des opérations et des services commerciaux critiques. Les applications APIs doivent également être protégées contre SYN les inondations, UDP les inondations ou autres attaques par réflexion, et disposer d'un dispositif d'atténuation intégré pour stopper les attaques de base au niveau de la couche réseau.

AWSpropose plusieurs services destinés à fournir un environnement sécurisé, du cloud central à la périphérie du AWS réseau. Amazon CloudFront, AWS Certificate Manager (ACM) AWSWAF, AWS Shield et Amazon Route 53 travaillent ensemble pour créer un périmètre de sécurité flexible à plusieurs niveaux. Avec Amazon CloudFrontAPIs, le contenu ou les applications peuvent être diffusés HTTPS en utilisant TLSv1 .3 pour crypter et sécuriser les communications entre les clients spectateurs et CloudFront. Vous pouvez l'utiliser ACM pour créer un SSLcertificat personnalisé

Amazon CloudFront

Amazon CloudFront

CloudFront propose plusieurs options pour sécuriser et restreindre l'accès à votre contenu. Par exemple, il peut restreindre l'accès à votre origine Amazon S3 en utilisant des cookies signés URLs et signés. Pour plus d'informations, consultez la section Configuration de l'accès sécurisé et restriction de l'accès au contenu dans la CloudFront documentation.

Cela AWS SRA illustre les CloudFront distributions centralisées dans le compte Network, car elles s'alignent sur le modèle de réseau centralisé mis en œuvre à l'aide de Transit Gateway. En déployant et en gérant les CloudFront distributions dans le compte réseau, vous bénéficiez des avantages des contrôles centralisés. Vous pouvez gérer toutes les CloudFront distributions en un seul endroit, ce qui facilite le contrôle de l'accès, la configuration des paramètres et le suivi de l'utilisation sur tous les comptes. En outre, vous pouvez gérer les ACM certificats, les DNS enregistrements et la CloudFront journalisation à partir d'un seul compte centralisé. Le tableau CloudFront de bord de sécurité fournit de la AWS WAF visibilité et des contrôles directement dans votre CloudFront distribution. Vous bénéficiez d'une visibilité sur les principales tendances en matière de sécurité de votre application, le trafic autorisé et bloqué et l'activité des robots. Vous pouvez utiliser des outils d'investigation tels que des analyseurs visuels de journaux et des contrôles de blocage intégrés pour isoler les modèles de trafic et bloquer le trafic sans interroger les journaux ni écrire de règles de sécurité.

Considérations relatives à la conception

-

Vous pouvez également effectuer le déploiement dans le CloudFront cadre de l'application dans le compte d'application. Dans ce scénario, l'équipe chargée de l'application prend des décisions telles que la manière dont les CloudFront distributions sont déployées, détermine les politiques de cache appropriées et assume la responsabilité de la gouvernance, de l'audit et de la surveillance des CloudFront distributions. En répartissant les CloudFront distributions sur plusieurs comptes, vous pouvez bénéficier de quotas de service supplémentaires. Autre avantage, vous pouvez utiliser la configuration inhérente et automatisée CloudFront de l'identité d'accès à l'origine (OAI) et du contrôle d'accès à l'origine (OAC) pour restreindre l'accès aux origines Amazon S3.

-

Lorsque vous diffusez du contenu Web par le biais d'un CDN tel que CloudFront, vous devez empêcher les spectateurs de contourner le contenu d'origine CDN et d'y accéder directement. Pour obtenir cette restriction d'accès à l'origine, vous pouvez utiliser CloudFront et AWS WAF ajouter des en-têtes personnalisés et vérifier les en-têtes avant de transférer les demandes à votre origine personnalisée. Pour une explication détaillée de cette solution, consultez le billet de blog sur la AWS sécurité How to enhance Amazon CloudFront Origin Security with AWS WAF and AWS Secrets Manager

. Une autre méthode consiste à limiter uniquement la liste de CloudFront préfixes dans le groupe de sécurité associé à l'Application Load Balancer. Cela permettra de garantir que seule une CloudFront distribution peut accéder à l'équilibreur de charge.

AWS WAF

AWSWAF

AWSWAFutilise des listes de contrôle d'accès Web (ACLs) pour protéger un ensemble de AWS ressources. Un site Web ACL est un ensemble de règles qui définit les critères d'inspection et une action associée à effectuer (bloquer, autoriser, compter ou exécuter un contrôle par bot) si une requête Web répond aux critères. AWSWAFfournit un ensemble de règles gérées

AWSWAFfournit un ensemble de règles intelligentes gérées par niveaux pour les robots courants et ciblés et la protection contre le piratage de compte ()ATP. Des frais d'abonnement et des frais d'inspection du trafic vous sont facturés lorsque vous utilisez le contrôle du bot et les groupes de ATP règles. C’est pourquoi nous vous recommandons de surveiller d’abord votre trafic et de décider ensuite de ce que vous allez utiliser. Vous pouvez utiliser les tableaux de bord de gestion des bots et de prise de contrôle de compte disponibles gratuitement sur la AWS WAF console pour surveiller ces activités, puis décider si vous avez besoin d'un groupe de AWS WAF règles de niveau intelligent.

Dans le AWSSRA, AWS WAF est intégré CloudFront au compte réseau. Dans cette configuration, le traitement des WAF règles s'effectue aux emplacements périphériques plutôt qu'à l'intérieur duVPC. Cela permet de filtrer le trafic malveillant plus près de l’utilisateur final qui a demandé le contenu, et d’empêcher le trafic malveillant d’entrer dans votre réseau principal.

Vous pouvez envoyer AWS WAF des journaux complets vers un compartiment S3 dans le compte Log Archive en configurant l'accès entre comptes au compartiment S3. Pour plus d'informations, consultez l'article AWS Re:Post

Considérations relatives à la conception

-

Comme alternative au déploiement AWS WAF centralisé dans le compte réseau, certains cas d'utilisation sont mieux satisfaits AWS WAF en déployant dans le compte d'application. Par exemple, vous pouvez choisir cette option lorsque vous déployez vos CloudFront distributions dans votre compte d'application ou que vous utilisez des équilibreurs de charge d'application destinés au public, ou si vous utilisez Amazon API Gateway devant vos applications Web. Si vous décidez de déployer AWS WAF dans chaque compte d'application, utilisez AWS Firewall Manager pour gérer les AWS WAF règles de ces comptes à partir du compte Security Tooling centralisé.

-

Vous pouvez également ajouter des AWS WAF règles générales au niveau de la CloudFront couche et des AWS WAF règles supplémentaires spécifiques à l'application dans une ressource régionale telle que l'Application Load Balancer ou la passerelle. API

AWS Shield

AWSShield

Vous pouvez utiliser la fonction DDoS d'atténuation automatique de la couche d'application de Shield Advanced pour configurer Shield Advanced afin de réagir automatiquement afin d'atténuer les attaques de la couche application (couche 7) contre vos CloudFront distributions protégées et vos équilibreurs de charge d'application. Lorsque vous activez cette fonctionnalité, Shield Advanced génère automatiquement des AWS WAF règles personnalisées pour atténuer les DDoS attaques. Shield Advanced vous donne également accès à la AWSShield Response Team (SRT). Vous pouvez nous contacter SRT à tout moment pour créer et gérer des mesures d'atténuation personnalisées pour votre application ou lors d'une DDoS attaque active. Si vous SRT souhaitez surveiller de manière proactive vos ressources protégées et vous contacter lors d'une DDoS tentative, pensez à activer la fonctionnalité d'engagement proactif.

Considérations relatives à la conception

-

Si vos charges de travail sont dirigées par des ressources connectées à Internet dans le compte de l'application, telles qu'Amazon CloudFront, un Application Load Balancer ou un Network Load Balancer, configurez Shield Advanced dans le compte de l'application et ajoutez ces ressources à la protection Shield. Vous pouvez utiliser AWS Firewall Manager pour configurer ces options à grande échelle.

-

Si le flux de données comporte plusieurs ressources, par exemple une CloudFront distribution devant un Application Load Balancer, utilisez uniquement la ressource du point d'entrée comme ressource protégée. Cela vous évitera de payer deux fois les frais de Shield Data Transfer Out (DTO)

pour deux ressources. -

Shield Advanced enregistre les statistiques que vous pouvez surveiller sur Amazon CloudWatch. (Pour plus d'informations, consultez la section Mesures et alarmes AWS Shield Advanced dans la AWS documentation.) Configurez des CloudWatch alarmes pour recevoir SNS des notifications à votre centre de sécurité lorsqu'un DDoS événement est détecté. En DDoS cas de suspicion, contactez l'équipe de support aux AWS entreprises

en déposant un ticket d'assistance et en lui attribuant la priorité la plus élevée. L'équipe de support aux entreprises inclura l'équipe Shield Response (SRT) lors de la gestion de l'événement. En outre, vous pouvez préconfigurer la fonction AWS Shield Engagement Lambda pour créer un ticket d'assistance et envoyer un e-mail à SRT l'équipe.

AWSCertificate Manager

AWSCertificate Manager (ACM)

ACMest utilisé dans le compte Network pour générer un TLS certificat public, qui, à son tour, est utilisé par les CloudFront distributions pour établir la HTTPS connexion entre les spectateurs et CloudFront. Pour plus d'informations, consultez la CloudFront documentation.

Considération relative à la conception

-

Pour les certificats externes, ils ACM doivent résider sur le même compte que les ressources pour lesquelles ils fournissent des certificats. Les certificats ne peuvent pas être partagés entre plusieurs comptes.

Amazon Route 53

Amazon Route 53

Vous pouvez utiliser Route 53 en tant que DNS service pour mapper des noms de domaine à vos EC2 instances, compartiments S3, CloudFront distributions et autres AWS ressources. La nature distribuée des AWS DNS serveurs permet de garantir que vos utilisateurs finaux sont acheminés de manière cohérente vers votre application. Des fonctionnalités telles que le flux de trafic et le contrôle du routage de Route 53 vous aident à améliorer la fiabilité. Si le point de terminaison principal de votre application devient indisponible, vous pouvez configurer votre basculement pour rediriger vos utilisateurs vers un autre emplacement. Route 53 Resolver fournit une solution récursive DNS pour vos réseaux VPC et ceux sur site via Direct AWS Connect ou gérés. AWS VPN

En utilisant le service AWS Identity and Access Management (IAM) avec Route 53, vous pouvez contrôler avec précision qui peut mettre à jour vos DNS données. Vous pouvez activer DNS la signature des extensions de sécurité (DNSSEC) pour permettre aux DNS résolveurs de vérifier qu'une DNS réponse provient de Route 53 et qu'elle n'a pas été modifiée.

Route 53 Resolver DNS Firewall protège les DNS demandes sortantes provenant de votre. VPCs Ces demandes passent par Route 53 Resolver pour la résolution du nom de domaine. L'une des principales utilisations des protections par DNS pare-feu est d'empêcher l'DNSexfiltration de vos données. Avec DNS Firewall, vous pouvez surveiller et contrôler les domaines que vos applications peuvent interroger. Vous pouvez refuser l’accès aux domaines malveillants et autoriser le passage de toutes les autres requêtes. Vous pouvez également refuser l’accès à tous les domaines, sauf ceux que vous approuvez explicitement. Vous pouvez également utiliser le DNS pare-feu pour bloquer les demandes de résolution adressées aux ressources des zones hébergées privées (partagées ou locales), y compris les noms des points de VPC terminaison. Il peut également bloquer les demandes de noms d'EC2instances publics ou privés.

Les résolveurs Route 53 sont créés par défaut dans le cadre de chaqueVPC. Dans le AWSSRA, la Route 53 est utilisée dans le compte réseau principalement pour la fonctionnalité de DNS pare-feu.

Considération relative à la conception

-

DNSFirewall et AWS Network Firewall proposent tous deux un filtrage des noms de domaine, mais pour différents types de trafic. Vous pouvez utiliser DNS Firewall et Network Firewall ensemble pour configurer le filtrage basé sur le domaine pour le trafic de la couche application sur deux chemins réseau différents.

-

DNSLe pare-feu permet de filtrer les DNS requêtes sortantes qui transitent par le résolveur Route 53 à partir d'applications internes à votre ordinateur. VPCs Vous pouvez également configurer le DNS pare-feu pour envoyer des réponses personnalisées aux requêtes aux noms de domaine bloqués.

-

Network Firewall fournit un filtrage pour le trafic de la couche réseau et d’application, mais n’a pas de visibilité sur les requêtes effectuées par Route 53 Resolver.

-