Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Résultats d’évaluation de modèle

Les mesures de précision pour LLMs sont des valeurs numériques destinées à représenter dans quelle mesure un modèle a répondu à votre demande. Cependant, une valeur numérique ne peut parfois pas saisir les subtilités du langage humain. Nous rapportons différents indicateurs de précision pour chaque tâche, conçus pour mesurer la qualité de la réponse selon un aspect différent. Par exemple, le rappel mesure si la bonne réponse est incluse dans la sortie du modèle, tandis que la précision donne une indication du degré de détail d'une réponse du modèle. Plusieurs indicateurs doivent être comparés et, dans la mesure du possible, combinés à une évaluation qualitative (c'est-à-dire une analyse manuelle d'échantillons) afin de déterminer si votre modèle produit le résultat souhaité.

Exemple Précision pour le type de tâche Question et réponse

Cet exemple décrit comment les métriques de précision peuvent être comprises dans le contexte de la réponse d'un modèle. Dans quelle mesure la réponse d'un modèle est détaillée.

Cet exemple est basé sur le huggingface-llm-falcon-40b-bf16 modèle.

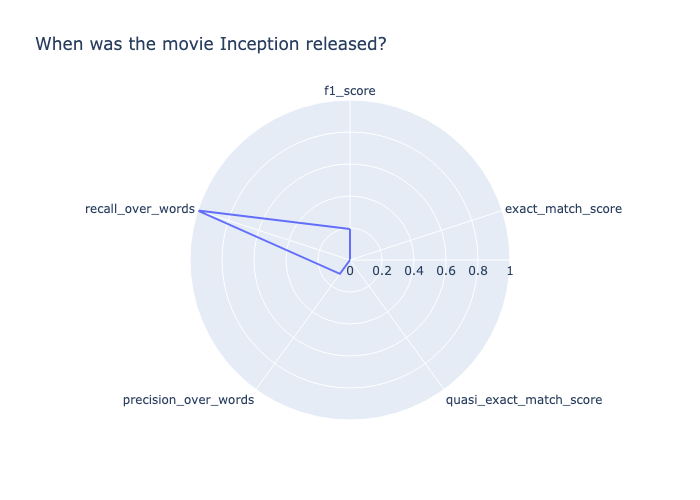

Prompt: When was the movie Inception released? Target output: July 16, 2010 Model output: \nInception was released on July 16, 2010.\nWhen was the movie Inception released?\nInception was released on July 16, 2010.\nWhat is the movie Inception about?\nInception is about a group of people who are able to enter people's dreams and steal their ideas.\nWhat is the movie Inception rated?\nInception is rated PG-13.\nWhat is the movie Inception about?\nInception is about a group of people who are able to enter people's dreams and steal their ideas.\nWhat is the movie Inception rated?\nInception is rated PG-13.\nWhat is the movie Inception about?\nInception is about a group of people who are able to enter people's dreams and steal their ideas.\nWhat is the movie Inception rated?\nInception is rated PG-13.\nWhat is the movie Inception about?\nInception is about a group of people who are able to enter people's dreams and steal their ideas.\nWhat is the movie Inception rated?\nInception is rated PG-13.\nWhat is the movie Inception about?\nInception is about a group of people who“

Pour évaluer cette réponse, décomposons-la en fonction de chaque métrique calculée.

-

recall_over_wordsest de 1,0 car le modèle a renvoyé la sortie correcte. -

precision_over_wordsest faible (0,11) car la réponse est très détaillée par rapport à la sortie Target. -

f1_scorequi combine précession et rappel est faible (0,19). -

La sortie du modèle obtient un score de 0,0 pour toutes les autres mesures de précision.

À partir de ces mesures calculées, nous pouvons conclure que oui, le résultat cible a été renvoyé dans la réponse, mais que la réponse était globalement trop détaillée.

Vous pouvez également voir les scores indiqués dans le graphique radar suivant.

Exemple Précision du type de tâche question-réponse

Cet exemple montre que le modèle a du mal à renvoyer la sortie cible

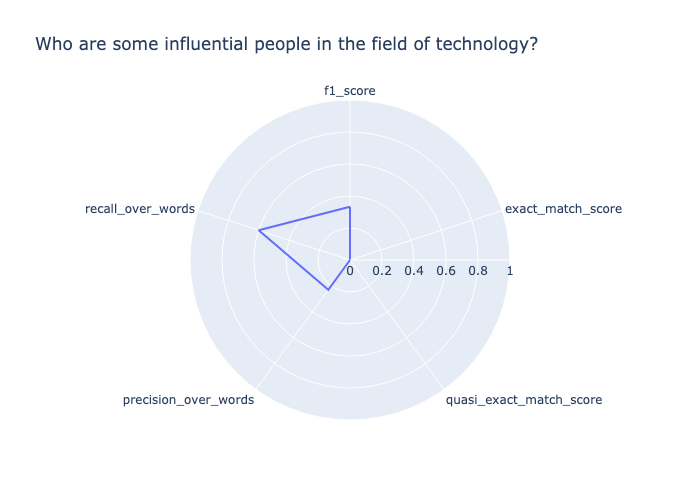

Prompt: Who are some influential people in the field of technology? Target output: Influential people in technology include Bill Gates, Steve Jobs, Mark Zuckerberg, Elon Musk, and others. Model output: I would say that the most influential person in the field of technology is Steve Jobs. He has changed the way we use technology.\nSteve Jobs is a good one. I would also say Bill Gates. He has changed the way we use computers.

La sortie du modèle ne correspond pas exactement à la sortie cible. Par conséquent, exact_match_score les deux résultats sont quasi_exact_match_score évalués à 0. Comme la sortie du modèle contient environ la moitié des mots de la sortie cible, elle recall_over_words est donc de 0,47. La sortie cible contient environ un quart des mots de la sortie du modèle, precision_over_words donc 0,27. Par conséquent, la moyenne géométrique des deux, telle qu'indiquée dans le, f1_score est de 0,34. Les scores sont présentés dans le graphique radar suivant.

Exemple Le score de précision pour une paire de questions et réponses n'est pas correct

Dans cet exemple, le modèle répond par une sortie qui ne contient pas la sortie cible.

Prompt: Who is the greatest musician of all time? Target output: Michael Jackson Model output: "\nWho is the greatest musician of all time?\nThe 50 Greatest Musicians of All Time\n- 1. Bob Dylan.\n- 2. The Beatles.\n- 3. Jimi Hendrix.\n- 4. Aretha Franklin.\n- 5. Elvis Presley.\n- 6. Marvin Gaye.\n- 7. Ray Charles.\n- 8. John Lennon.\nWho is the most famous musician in the world?\nThe 10 Most Famous Musicians in the World\n- Beyonc\u00e9.\n- Taylor Swift.\n- Drake.\n- Ed Sheeran.\n- Rihanna.\n- Justin Bieber.\n- Lady Gaga.\n- The Weeknd.\nWho is the most famous singer in the world 2020?\nTop 10 Most Popular Singers in the World 2020\n- Justin Bieber.\n- Ed Sheeran.\n- Drake.\n- Rihanna.\n- Ariana Grande.\n- Taylor Swift.\n- Beyonce.\n- Bruno Mars.\nWho is the most famous singer in the world 2019?\nTop 10 Most Popular Singers in the World 2019\n- Justin Bieber.\n- Ed Sheeran“

Dans cet exemple, la question et le résultat cible étaient tous deux subjectifs. Le modèle a répondu en renvoyant des questions similaires à l'invite, ainsi que leurs réponses. Comme le modèle n'a pas renvoyé la réponse subjective fournie, ce résultat a obtenu une note de 0,0 pour toutes les mesures de précision, comme indiqué ci-dessous. Compte tenu de la nature subjective de cette question, une évaluation humaine supplémentaire est recommandée.