Terjemahan disediakan oleh mesin penerjemah. Jika konten terjemahan yang diberikan bertentangan dengan versi bahasa Inggris aslinya, utamakan versi bahasa Inggris.

Amazon FSx untuk kinerja Lustre

Amazon FSx for Lustre, dibangun di atas Lustre, sistem file berkinerja tinggi yang populer, memberikan kinerja scale-out yang meningkat secara linier dengan ukuran sistem file. Sistem file Lustre terskala secara horizontal di beberapa server file dan disk. Penskalaan ini memberikan setiap klien akses langsung ke data yang disimpan pada setiap disk untuk menghapus banyaknya kemacetan yang ada dalam sistem file tradisional. Amazon FSx for Lustre dibangun di atas arsitektur Lustre yang dapat diskalakan untuk mendukung kinerja tingkat tinggi di sejumlah besar klien.

Topik

Cara FSx kerja sistem file Lustre

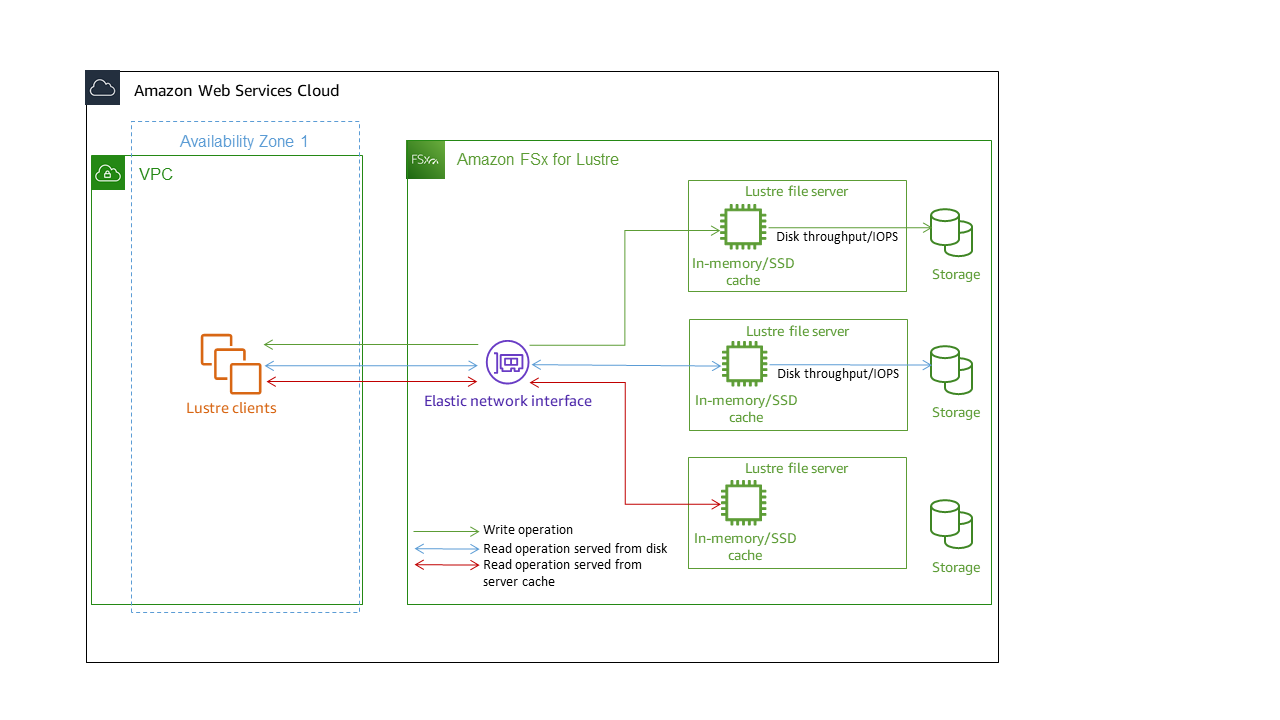

Masing-masing FSx untuk sistem file Lustre terdiri dari server file yang klien berkomunikasi dengan, dan satu set disk yang dilampirkan ke setiap file server yang menyimpan data Anda. Setiap server file menggunakan cache dalam memori untuk meningkatkan performa untuk data yang diakses paling sering. HDDsistem file berbasis juga dapat disediakan dengan cache baca SSD berbasis untuk lebih meningkatkan kinerja untuk data yang paling sering diakses. Ketika klien mengakses data yang disimpan dalam memori atau SSD cache, server file tidak perlu membacanya dari disk, yang mengurangi latensi dan meningkatkan jumlah total throughput yang dapat Anda drive. Diagram berikut menggambarkan jalur operasi tulis, operasi baca yang disajikan dari disk, dan operasi baca yang disajikan dari dalam memori atau SSD cache.

Ketika Anda membaca data yang disimpan di dalam memori atau SSD cache server file, kinerja sistem file ditentukan oleh throughput jaringan. Ketika Anda menulis data ke sistem file Anda, atau ketika Anda membaca data yang tidak disimpan pada cache dalam memori, kinerja sistem file ditentukan oleh yang lebih rendah dari throughput jaringan dan throughput disk.

Saat Anda menyediakan sistem file HDD Lustre dengan SSD cache, Amazon FSx membuat SSD cache yang secara otomatis berukuran hingga 20 persen dari HDD kapasitas penyimpanan sistem file. Melakukan hal ini memberikan latensi sub-milidetik dan lebih tinggi IOPS untuk file yang sering diakses.

Performa kumpulan sistem file

Throughput yang didukung oleh sistem file FSx for Lustre sebanding dengan kapasitas penyimpanannya. Amazon FSx untuk sistem file Lustre menskalakan hingga GBps ratusan throughput dan jutaan. IOPS Amazon FSx for Lustre juga mendukung akses bersamaan ke file atau direktori yang sama dari ribuan instance komputasi. Akses ini memungkinkan checkpointing data cepat dari memori aplikasi ke penyimpanan, yang merupakan teknik umum dalam komputasi kinerja tinggi ()HPC. Anda dapat meningkatkan jumlah penyimpanan dan kapasitas throughput yang diperlukan setiap saat setelah Anda membuat sistem file. Untuk informasi selengkapnya, lihat Mengelola kapasitas penyimpanan.

FSxuntuk sistem file Lustre menyediakan throughput burst read menggunakan mekanisme kredit I/O jaringan untuk mengalokasikan bandwidth jaringan berdasarkan pemanfaatan bandwidth rata-rata. Sistem-sistem file memperoleh kredit ketika penggunaan bandwidth jaringan mereka di bawah batas baseline, dan dapat menggunaan kredit ini ketika sistem-sistem file melaksanakan transfer data jaringan.

Tabel berikut menunjukkan kinerja yang dirancang FSx untuk opsi penerapan Lustre.

| Jenis Deployment | Throughput jaringan (MB/s/Tib penyimpanan disediakan) | Jaringan IOPS (IOPS/Tib penyimpanan disediakan) | Penyimpanan cache (GiB RAM dari/Tib penyimpanan disediakan) | Latensi disk per operasi file (milidetik, P50) | Throughput disk (MBps/Tib penyimpanan atau SSD cache disediakan) | ||

|---|---|---|---|---|---|---|---|

Baseline |

Meledak |

Baseline |

Meledak |

||||

| SCRATCH_2 | 200 | 1300 | Puluhan ribu baseline Ratusan ribu burst |

6.7 |

Metadata: sub-ms Data: sub-ms |

200 (baca) 100 (tulis) |

‐ |

| PERSISTENT-125 | 320 | 1300 | 3.4 |

125 |

500 | ||

| PERSISTENT-250 | 640 | 1300 | 6.8 |

250 |

500 | ||

| PERSISTENT-500 | 1300 | ‐ | 13.7 | 500 | ‐ |

||

| PERSISTENT-1000 | 2600 | ‐ | 27.3 | 1000 | ‐ | ||

| Jenis Deployment | Throughput jaringan (MB/s/Tib penyimpanan atau cache disediakan) SSD | Jaringan IOPS (IOPS/Tib penyimpanan disediakan) | Penyimpanan cache (GiB RAM dari/Tib penyimpanan disediakan) | Latensi disk per operasi file (milidetik, P50) | Throughput disk (MBps/Tib penyimpanan atau SSD cache disediakan) | ||

|---|---|---|---|---|---|---|---|

Baseline |

Meledak |

Baseline |

Meledak |

||||

| PERSISTENT-12 | |||||||

| HDDpenyimpanan | 40 | 375* |

Puluhan ribu baseline Ratusan ribu burst |

Memori 0,4 |

Metadata: sub-ms Data: ms ber-digit tunggal |

12 |

80 (baca) 50 (tulis) |

| SSDbaca cache |

200 |

1.900 |

200 SSD cache |

Data: sub-ms |

200 |

- |

|

| PERSISTENT-40 | |||||||

| HDDpenyimpanan | 150 | 1.300* |

Puluhan ribu baseline Ratusan ribu burst |

1.5 |

Metadata: sub-ms Data: ms ber-digit tunggal |

40 |

250 (baca) 150 (tulis) |

| SSDbaca cache |

750 |

6500 |

200 SSD cache |

Data: sub-ms |

200 |

- |

|

| Jenis Deployment | Throughput jaringan (MB/s per TiB penyimpanan yang disediakan) | Jaringan IOPS (IOPSper TiB penyimpanan yang disediakan) | Penyimpanan cache (GiB per TiB penyimpanan disediakan) | Latensi disk per operasi file (milidetik, P50) | Throughput disk (MB/s per TiB penyimpanan atau cache yang disediakan) SSD | ||

|---|---|---|---|---|---|---|---|

Baseline |

Meledak |

Baseline |

Meledak |

||||

| PERSISTENT-50 | 250 | 1.300* | Puluhan ribu baseline Ratusan ribu burst |

2.2 RAM |

Metadata: sub-ms Data: sub-ms |

50 | 240 |

| PERSISTENT-100 | 500 | 1.300* | 4.4 RAM | 100 | 240 | ||

| PERSISTENT-200 | 750 | 1.300* | 8.8 RAM | 200 | 240 | ||

catatan

* Sistem file persisten berikut ini Wilayah AWS menyediakan ledakan jaringan hingga 530 MB/s per TiB penyimpanan: Afrika (Cape Town), Asia Pasifik (Hong Kong), Asia Pasifik (Osaka), Asia Pasifik (Singapura), Kanada (Tengah), Eropa (Frankfurt), Eropa (London), Eropa (Milan), Eropa (Stockholm), Timur Tengah (Bahrain), Amerika Selatan (São Paulo), China, dan AS Barat (Los Angeles).

Contoh: Agregat baseline dan burst throughput

Contoh berikut menggambarkan bagaimana kapasitas penyimpanan dan throughput disk mempengaruhi performa sistem file.

Sistem file persisten dengan kapasitas penyimpanan 4,8 TiB dan 50 MB/s per TiB throughput per unit penyimpanan menyediakan throughput disk dasar agregat 240 MB/s dan throughput disk burst 1,152 Gb/s.

Terlepas dari ukuran sistem file, Amazon FSx untuk Lustre menyediakan latensi sub-milidetik yang konsisten untuk operasi file.

Kinerja metadata sistem file

Operasi IO metadata sistem file per detik (IOPS) menentukan jumlah file dan direktori yang dapat Anda buat, daftar, baca, dan hapus per detik. Metadata IOPS secara otomatis disediakan FSx untuk sistem file Lustre berdasarkan kapasitas penyimpanan yang Anda berikan.

Sistem file Persistent_2 memungkinkan Anda untuk menyediakan Metadata IOPS independen dari kapasitas penyimpanan dan memberikan peningkatan visibilitas ke dalam jumlah dan jenis instans IOPS klien metadata yang mengemudi di sistem file Anda.

Dengan FSx untuk sistem file Lustre Persistent_2, jumlah metadata yang IOPS Anda sediakan dan jenis operasi metadata menentukan tingkat operasi metadata yang dapat didukung oleh sistem file Anda. Tingkat metadata yang IOPS Anda berikan menentukan jumlah yang IOPS disediakan untuk disk metadata sistem file Anda.

| Jenis operasi | Operasi yang dapat Anda kendarai per detik untuk setiap metadata yang disediakan IOPS |

|---|---|

|

Membuat File, Buka dan Tutup |

2 |

|

Hapus File |

1 |

|

Direktori Buat, Ganti Nama |

0.1 |

|

Direktori Hapus |

0,2 |

Anda dapat memilih untuk menyediakan metadata IOPS menggunakan mode Otomatis atau mode yang disediakan pengguna. Dalam mode Otomatis, Amazon FSx secara otomatis menyediakan metadata IOPS berdasarkan kapasitas penyimpanan sistem file Anda sesuai dengan tabel di bawah ini:

| Kapasitas penyimpanan sistem file | Termasuk metadata IOPS dalam mode Otomatis |

|---|---|

|

1200 GiB |

1500 |

|

2400 GiB |

3000 |

|

4800—9600 GiB |

6000 |

|

12000—45600 GiB |

12000 |

|

≥48000 GiB |

12000 IOPS per 24000 GiB |

Dalam mode yang disediakan pengguna, Anda dapat memilih untuk menentukan jumlah metadata yang akan disediakan. IOPS Anda membayar Metadata yang IOPS disediakan di atas nomor default IOPS Metadata untuk sistem file Anda.

Layout penyimpanan sistem file

Semua data file dalam Lustre disimpan pada volume penyimpanan yang disebut target penyimpanan objek ()OSTs. Semua metadata file (termasuk nama file, stempel waktu, izin, dan lainnya) disimpan pada volume penyimpanan yang disebut target metadata (). MDTs Amazon FSx untuk sistem file Lustre terdiri dari satu atau lebih MDTs dan beberapa. OSTs Masing-masing OST berukuran sekitar 1 hingga 2 TiB, tergantung pada jenis penyebaran sistem file. Amazon FSx for Lustre menyebarkan data file Anda ke seluruh OSTs yang membentuk sistem file Anda untuk menyeimbangkan kapasitas penyimpanan dengan throughput dan pemuatan. IOPS

Untuk melihat penggunaan penyimpanan MDT dan OSTs yang membentuk sistem file Anda, jalankan perintah berikut dari klien yang memiliki sistem file terpasang.

lfs df -hmount/path

Hasil akhir dari perintah ini adalah sebagai berikut.

UUID bytes Used Available Use% Mounted onmountname-MDT0000_UUID 68.7G 5.4M 68.7G 0% /fsx[MDT:0]mountname-OST0000_UUID 1.1T 4.5M 1.1T 0% /fsx[OST:0]mountname-OST0001_UUID 1.1T 4.5M 1.1T 0% /fsx[OST:1] filesystem_summary: 2.2T 9.0M 2.2T 0% /fsx

Sedang melakukan stripe data di sistem file Anda

Anda dapat mengoptimalkan performa throughput sistem file Anda dengan melakukan file striping. Amazon FSx for Lustre secara otomatis menyebarkan OSTs file untuk memastikan bahwa data disajikan dari semua server penyimpanan. Anda dapat menerapkan konsep yang sama di tingkat file dengan mengonfigurasi bagaimana file digaris-garis di beberapa. OSTs

Striping berarti bahwa file dapat dibagi menjadi beberapa potongan yang kemudian disimpan di berbagai bagian. OSTs Ketika file digaris-garis di beberapaOSTs, permintaan baca atau tulis ke file tersebar di seluruh file tersebutOSTs, meningkatkan throughput agregat atau aplikasi IOPS Anda dapat melaluinya.

Berikut ini adalah layout default untuk Amazon FSx untuk sistem file Lustre.

Untuk sistem file yang dibuat sebelum 18 Desember 2020, tata letak default menentukan jumlah garis 1. Ini berarti bahwa kecuali tata letak yang berbeda ditentukan, setiap file yang dibuat di Amazon FSx untuk Lustre menggunakan alat Linux standar disimpan pada satu disk.

Untuk sistem file yang dibuat setelah 18 Desember 2020, tata letak default adalah tata letak file progresif di mana file di bawah ukuran 1GiB disimpan dalam satu garis, dan file yang lebih besar diberi jumlah garis 5.

Untuk sistem file yang dibuat setelah 25 Agustus 2023, tata letak default adalah tata letak file progresif 4 komponen yang dijelaskan di. Layout file progresif

Untuk semua sistem file terlepas dari tanggal pembuatannya, file yang diimpor dari Amazon S3 tidak menggunakan tata letak default, melainkan menggunakan tata letak dalam parameter sistem file.

ImportedFileChunkSizeFile yang diimpor S3 yang lebih besar dari fileImportedFileChunkSizeakan disimpan di beberapa OSTs dengan jumlah garis.(FileSize / ImportedFileChunksize) + 1Nilai default dariImportedFileChunkSizeadalah 1GiB.

Anda dapat melihat konfigurasi layout dari sebuah file atau direktori menggunakan perintah lfs getstripe.

lfs getstripepath/to/filename

Perintah ini melaporkan jumlah stripe dari file, ukuran stripe, dan offset stripe. Jumlah garis adalah berapa banyak file OSTs yang digaris-garis. Ukuran garis adalah berapa banyak data kontinu disimpan pada fileOST. Stripe offset adalah indeks yang pertama OST bahwa file tersebut bergaris.

Memodifikasi konfigurasi striping Anda

Parameter layout dari sebuah file diatur ketika file pertama kali dibuat. Gunakan perintah lfs setstripe untuk membuat sebuah file yang baru, kosong dengan layout yang telah ditentukan.

lfs setstripefilename--stripe-countnumber_of_OSTs

Perintah lfs setstripe mempengaruhi hanya layout dari sebuah file baru. Gunakan perintah tersebut untuk menentukan layout sebuah file sebelum Anda membuatnya. Anda juga dapat menentukan layout untuk sebuah direktori. Setelah ditetapkan pada sebuah direktori, layout diterapkan ke setiap file baru yang ditambahkan ke direktori tersebut, tetapi tidak ke file yang sudah ada. Setiap subdirektori baru yang Anda buat juga mewarisi layout baru, yang kemudian diterapkan ke setiap file atau direktori baru yang Anda buat dalam subdirektori tersebut.

Untuk memodifikasi layout dari file yang ada, gunakan perintah lfs migrate. Perintah ini menyalin file sebagaimana diperlukan untuk mendistribusikan isinya berdasarkan layout yang Anda tentukan di perintah. Misalnya, file-file yang ditambahkan atau ditingkatkan ukurannya tidak akan mengubah jumlah stripe, jadi Anda harus me-migrasi file-file untuk mengubah layout file. Atau, Anda dapat membuat file baru menggunakan perintah lfs setstripe untuk menentukan layout-nya, menyalin konten semula ke file yang baru, dan kemudian mengubah nama file yang baru untuk mengganti file semula.

Mungkin ada kasus-kasus di mana konfigurasi layout default tidak optimal untuk beban kerja Anda. Misalnya, sistem file dengan puluhan OSTs dan sejumlah besar file multi-gigabyte dapat melihat kinerja yang lebih tinggi dengan menghapus file di lebih dari nilai hitungan garis default lima. OSTs Membuat file besar dengan jumlah strip rendah dapat menyebabkan kemacetan kinerja I/O dan juga dapat menyebabkan terisi. OSTs Dalam hal ini, Anda dapat membuat sebuah direktori dengan jumlah stripe yang lebih besar untuk file-file ini.

Mengatur layout yang ditetapkan stripe-nya untuk file-file besar (terutama file-file yang lebih besar dari ukuran gigabyte) adalah penting karena alasan-alasan berikut ini:

Meningkatkan throughput dengan memungkinkan beberapa OSTs dan server terkait untuk berkontribusiIOPS, bandwidth jaringan, dan CPU sumber daya saat membaca dan menulis file besar.

Mengurangi kemungkinan bahwa sebagian kecil OSTs menjadi hot spot yang membatasi kinerja beban kerja secara keseluruhan.

Mencegah satu file besar mengisiOST, mungkin menyebabkan kesalahan penuh disk.

Tidak ada konfigurasi layout optimal tunggal untuk semua kasus penggunaan. Untuk panduan men-detail tentang layout file, lihat Mengelola Layout File (Melakukan Stripe) dan Ruang Bebas

Layout yang sudah ditentukan stripe-nya adalah masalah bagi file-file besar, terutama dalam kasus penggunaan di mana file-file secara rutin memiliki ukuran ratusan megabyte atau lebih. Untuk alasan ini, layout default untuk sistem file baru menetapkan jumlah stripe sebanyak lima untuk file-file di atas ukuran 1GiB.

Jumlah Stripe adalah parameter layout yang harus Anda sesuaikan untuk sistem yang men-support file-file besar. Jumlah garis menentukan jumlah OST volume yang akan menampung potongan file bergaris. Misalnya, dengan jumlah garis 2 dan ukuran garis 1MiB, Lustre menulis potongan 1MiB alternatif dari file ke masing-masing dua. OSTs

Jumlah garis efektif adalah yang lebih kecil dari jumlah OST volume aktual dan nilai jumlah garis yang Anda tentukan. Anda dapat menggunakan nilai hitungan garis khusus

-1untuk menunjukkan bahwa garis-garis harus ditempatkan pada semua OST volume.Mengatur jumlah strip besar untuk file kecil adalah sub-optimal karena untuk operasi tertentu Lustre memerlukan jaringan pulang-pergi ke setiap OST tata letak, bahkan jika file terlalu kecil untuk mengkonsumsi ruang pada semua volume. OST

Anda dapat mengatur layout file progresif (PFL) yang memungkinkan tata letak file berubah sesuai ukuran. PFLKonfigurasi dapat menyederhanakan pengelolaan sistem file yang memiliki kombinasi file besar dan kecil tanpa Anda harus secara eksplisit mengatur konfigurasi untuk setiap file. Untuk informasi selengkapnya, lihat Layout file progresif.

Ukuran Stripe secara default adalah 1MiB. Menyetel garis offset mungkin berguna dalam keadaan khusus, tetapi secara umum yang terbaik adalah membiarkannya tidak ditentukan dan menggunakan default.

Layout file progresif

Anda dapat menentukan konfigurasi tata letak file progresif (PFL) untuk direktori untuk menentukan konfigurasi garis yang berbeda untuk file kecil dan besar sebelum mengisinya. Misalnya, Anda dapat mengatur direktori tingkat PFL atas sebelum data apa pun ditulis ke sistem file baru.

Untuk menentukan PFL konfigurasi, gunakan lfs setstripe perintah dengan -E opsi untuk menentukan komponen tata letak untuk file berukuran berbeda, seperti perintah berikut:

lfs setstripe -E 100M -c 1 -E 10G -c 8 -E 100G -c 16 -E -1 -c 32/mountname/directory

Perintah ini menetapkan empat komponen tata letak:

Komponen pertama (

-E 100M -c 1) menunjukkan nilai jumlah stripe sebanyak 1 untuk file-file dengan ukuran 100MiB.Komponen kedua (

-E 10G -c 8) menunjukkan nilai jumlah stripe sebanyak 8 untuk file-file dengan ukuran 10GiB.Komponen ketiga (

-E 100G -c 16) menunjukkan jumlah garis 16 untuk file berukuran hingga 100GiB.Komponen keempat (

-E -1 -c 32) menunjukkan jumlah garis 32 untuk file yang lebih besar dari 100GiB.

penting

Menambahkan data ke file yang dibuat dengan PFL tata letak akan mengisi semua komponen tata letaknya. Misalnya, dengan perintah 4-komponen yang ditunjukkan di atas, jika Anda membuat file 1MiB dan kemudian menambahkan data ke ujungnya, tata letak file akan diperluas untuk memiliki jumlah garis -1, yang berarti semua yang ada di OSTs sistem. Ini tidak berarti data akan ditulis untuk setiapOST, tetapi operasi seperti membaca panjang file akan mengirim permintaan secara paralel ke setiapOST, menambahkan beban jaringan yang signifikan ke sistem file.

Oleh karena itu, berhati-hatilah untuk membatasi jumlah stripe untuk panjang file berukuran kecil dan medium yang selanjutnya dapat diisi oleh data ke dalamnya. Karena file log biasanya tumbuh dengan menambahkan catatan baru, Amazon FSx untuk Lustre menetapkan jumlah garis default 1 ke file apa pun yang dibuat dalam mode tambahan, terlepas dari konfigurasi garis default yang ditentukan oleh direktori induknya.

PFLKonfigurasi default di Amazon FSx untuk sistem file Lustre yang dibuat setelah 25 Agustus 2023 diatur dengan perintah ini:

lfs setstripe -E 100M -c 1 -E 10G -c 8 -E 100G -c 16 -E -1 -c 32/mountname

Pelanggan dengan beban kerja yang memiliki akses sangat bersamaan pada file sedang dan besar cenderung mendapat manfaat dari tata letak dengan lebih banyak garis pada ukuran yang lebih kecil dan striping di semua file terbesar, seperti yang ditunjukkan dalam OSTs contoh tata letak empat komponen.

Memantau performa dan penggunaan

Setiap menit, Amazon FSx untuk Lustre memancarkan metrik penggunaan untuk setiap disk (danMDT) OST ke Amazon. CloudWatch

Untuk melihat detail penggunaan sistem file agregat, Anda dapat melihat statistik Jumlah dari setiap metrik. Misalnya, Jumlah DataReadBytes statistik melaporkan total throughput baca yang dilihat oleh semua OSTs dalam sistem file. Sama halnya, Jumlah dari statistik FreeDataStorageCapacity melaporkan jumlah kapasitas penyimpanan yang tersedia untuk data file di dalam sistem file.

Untuk informasi selengkapnya tentang pemantauan performa dari sistem file Anda, lihat Memantau Amazon FSx untuk sistem file Lustre.

Tips performa

Saat menggunakan Amazon FSx untuk Lustre, ingatlah kiat kinerja berikut. Untuk batas-batas layanan, lihat Kuota untuk Amazon FSx for Lustre.

-

Ukuran I/O rata-rata - Karena Amazon FSx untuk Lustre adalah sistem file jaringan, setiap operasi file melewati perjalanan pulang pergi antara klien dan Amazon FSx untuk Lustre, menimbulkan overhead latensi kecil. Karena latency per-operasi ini, throughput keseluruhan secara umum meningkat karena ukuran I/O rata-rata yang meningkat, karena overhead diamortisasi melebihi jumlah data yang lebih besar.

-

Model permintaan — Dengan mengaktifkan penulisan asinkron ke sistem file Anda, operasi penulisan yang tertunda di-buffer pada instance Amazon sebelum ditulis ke EC2 Amazon FSx untuk Lustre secara asinkron. Penulisan asinkron biasanya memiliki latensi yang lebih rendah. Saat melakukan penulisan asinkron, kernel menggunakan memori tambahan untuk melakukan cache. Sistem file yang telah mengaktifkan penulisan sinkron mengeluarkan permintaan sinkron ke Amazon FSx untuk Lustre. Setiap operasi melewati perjalanan pulang pergi antara klien dan Amazon FSx untuk Lustre.

catatan

Model permintaan yang Anda pilih memiliki konsistensi pengorbanan (jika Anda menggunakan beberapa EC2 instans Amazon) dan kecepatan.

-

Batasi ukuran direktori - Untuk mencapai kinerja metadata optimal pada Persistent_2 FSx untuk sistem file Lustre, batasi setiap direktori hingga kurang dari 100K file. Membatasi jumlah file dalam direktori mengurangi waktu yang diperlukan untuk sistem file untuk memperoleh kunci pada direktori induk.

-

EC2Instans Amazon — Aplikasi yang melakukan sejumlah besar operasi baca dan tulis mungkin membutuhkan lebih banyak memori atau kapasitas komputasi daripada aplikasi yang tidak. Saat meluncurkan EC2 instans Amazon untuk beban kerja intensif komputasi, pilih jenis instans yang memiliki jumlah sumber daya ini yang dibutuhkan aplikasi Anda. Karakteristik kinerja sistem file Amazon FSx untuk Lustre tidak bergantung pada penggunaan instans yang dioptimalkan AmazonEBS.

-

Penyetelan instans klien yang direkomendasikan untuk kinerja optimal

Untuk semua jenis dan ukuran instans klien, kami sarankan untuk menerapkan penyetelan berikut:

sudo lctl set_param osc.*.max_dirty_mb=64Untuk tipe instance klien dengan memori lebih dari 64 GiB, kami sarankan untuk menerapkan penyetelan berikut:

sudo lctl set_param ldlm.namespaces.*.lru_max_age=600000 sudo lctl set_param ldlm.namespaces.*.lru_size=<100 *number_of_CPUs>Untuk tipe instans klien dengan lebih dari 64 v CPU core, kami sarankan untuk menerapkan penyetelan berikut:

echo "options ptlrpc ptlrpcd_per_cpt_max=32" >> /etc/modprobe.d/modprobe.conf echo "options ksocklnd credits=2560" >> /etc/modprobe.d/modprobe.conf # reload all kernel modules to apply the above two settings sudo rebootSetelah klien dipasang, penyetelan berikut perlu diterapkan:

sudo lctl set_param osc.*OST*.max_rpcs_in_flight=32 sudo lctl set_param mdc.*.max_rpcs_in_flight=64 sudo lctl set_param mdc.*.max_mod_rpcs_in_flight=50

Perhatikan bahwa

lctl set_paramdiketahui tidak bertahan selama reboot. Karena parameter ini tidak dapat diatur secara permanen dari sisi klien, disarankan untuk mengimplementasikan pekerjaan boot cron untuk mengatur konfigurasi dengan penyetelan yang disarankan. -

Keseimbangan beban kerja OSTs - Dalam beberapa kasus, beban kerja Anda tidak mendorong throughput agregat yang dapat disediakan oleh sistem file Anda (200 MB/s per TiB penyimpanan). Jika demikian, Anda dapat menggunakan CloudWatch metrik untuk memecahkan masalah jika kinerja dipengaruhi oleh ketidakseimbangan dalam pola I/O beban kerja Anda. Untuk mengidentifikasi apakah ini penyebabnya, lihat CloudWatch metrik Maksimum untuk Amazon FSx untuk Lustre.

Dalam beberapa kasus, statistik ini menunjukkan beban pada atau di atas 240 MBps throughput (kapasitas throughput FSx Amazon 1,2-Tib tunggal untuk disk Lustre). Dalam kasus tersebut, beban kerja Anda tidak tersebar secara merata di seluruh disk Anda. Jika demikian kasusnya, Anda dapat menggunakan perintah

lfs setstripeuntuk memodifikasi striping file yang paling sering diakses oleh beban kerja Anda. Untuk kinerja optimal, stripe file dengan persyaratan throughput tinggi di semua yang OSTs terdiri dari sistem file Anda.Jika file Anda diimpor dari repositori data, Anda dapat mengambil pendekatan lain untuk menghapus file throughput tinggi Anda secara merata di seluruh file Anda. OSTs Untuk melakukan ini, Anda dapat memodifikasi

ImportedFileChunkSizeparameter saat membuat Amazon berikutnya FSx untuk sistem file Lustre.Misalnya, beban kerja Anda menggunakan sistem file 7.0-Tib (yang terdiri dari 6x 1.17-TibOSTs) dan perlu mendorong throughput tinggi di seluruh file 2.4-GiB. Dalam hal ini, Anda dapat mengatur

ImportedFileChunkSizenilainya(2.4 GiB / 6 OSTs) = 400 MiBsehingga file Anda tersebar merata di seluruh sistem file AndaOSTs. -

Klien Lustre untuk Metadata IOPS - Jika sistem file Anda memiliki konfigurasi metadata yang ditentukan, kami sarankan Anda menginstal klien Lustre 2.15 atau klien Lustre 2.12 dengan salah satu versi OS ini: Amazon Linux 2023; Amazon Linux 2; Red Hat/Rocky Linux 8.9, 8.10, atau 9.x; CentOS 8.9 atau 8.10; Ubuntu 22 dengan kernel 6.2 atau 6.5; atau Ubuntu 20.