Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Utilizzo di Aurora: zero ETL integrazioni con Amazon Redshift

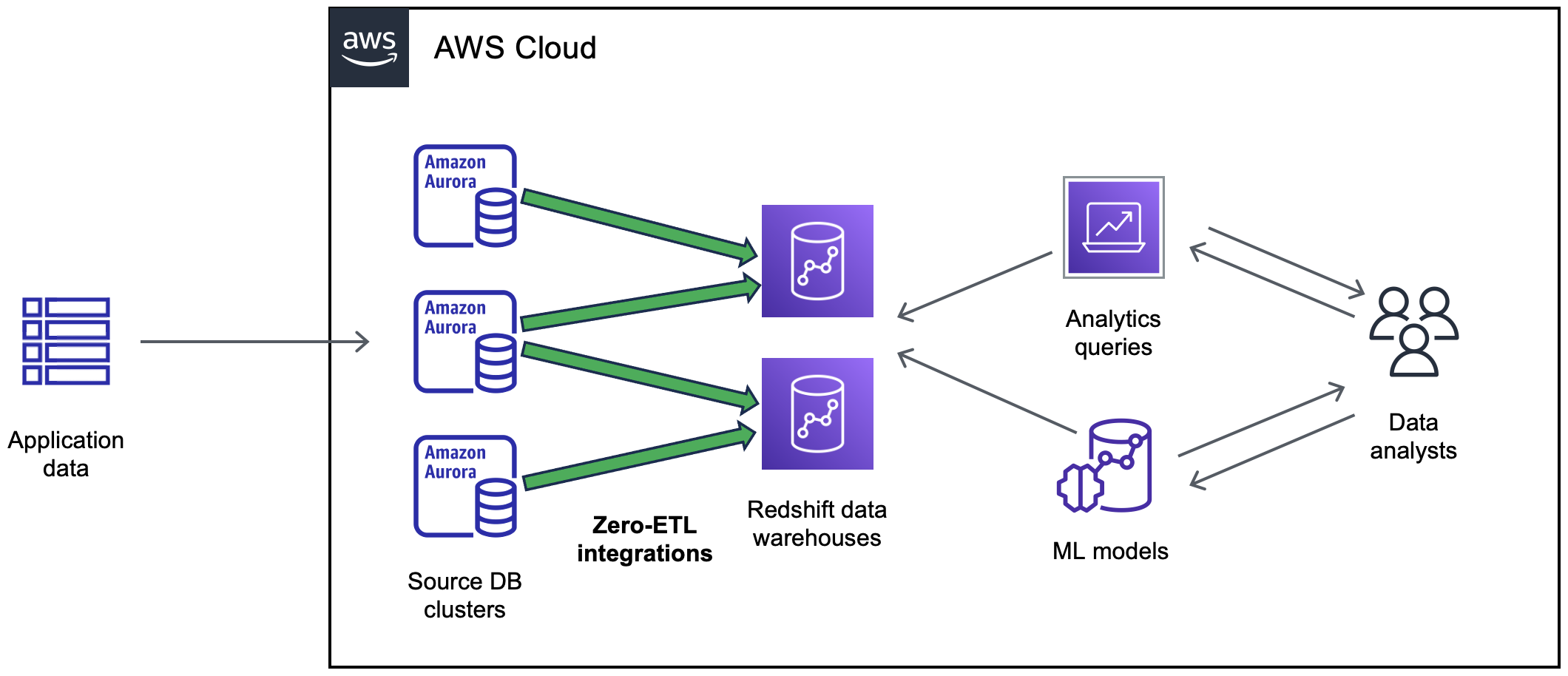

ETLL'integrazione zero di Aurora con Amazon Redshift consente analisi e machine learning (ML) quasi in tempo reale utilizzando Amazon Redshift su petabyte di dati transazionali di Aurora. È una soluzione completamente gestita per rendere disponibili i dati transazionali in Amazon Redshift dopo averli scritti su un cluster di . Extract, transform e load (ETL) è il processo di combinazione di dati provenienti da più fonti in un grande data warehouse centrale.

Un'ETLintegrazione zero rende i dati del del cluster Aurora DB disponibili in Amazon Redshift quasi in tempo reale. Una volta che i dati sono in Amazon Redshift, puoi potenziare i tuoi carichi di lavoro di analisi, ML e intelligenza artificiale utilizzando le funzionalità integrate di Amazon Redshift, come apprendimento automatico, viste materializzate, condivisione dei dati, accesso federato a più data store e data lake e integrazioni con Amazon, Amazon e altri SageMaker QuickSight Servizi AWS.

Per creare un'ETLintegrazione zero, specifichi un cluster di Aurora DB come origine e un data warehouse Amazon Redshift come destinazione. L'integrazione replica i dati dal database di origine nel data warehouse di destinazione.

Il diagramma seguente illustra questa funzionalità.

L'integrazione monitora lo stato della pipeline dei dati ed esegue il ripristino in caso di problemi quando possibile. Puoi creare integrazioni da più (cluster Aurora DB) in un unico namespace Amazon Redshift, che ti consente di ricavare informazioni su più applicazioni.

Per informazioni sui prezzi per le ETL integrazioni zero, consulta Aurora

Argomenti

- Vantaggi

- Concetti chiave

- Limitazioni

- Quote

- Regioni supportate

- Guida introduttiva alle ETL integrazioni zero di Aurora con Amazon Redshift

- Creazione di ETL integrazioni zero di Aurora con Amazon Redshift

- Filtraggio dei dati per le integrazioni zero di Aurora con Amazon ETL Redshift

- Aggiungere dati a un di origine (cluster Aurora DB) e interrogarli in Amazon Redshift

- Visualizzazione e monitoraggio delle ETL integrazioni zero di Aurora con Amazon Redshift

- Modifica delle integrazioni zero di Aurora con Amazon ETL Redshift

- Eliminazione delle integrazioni zero di Aurora con Amazon ETL Redshift

- Risoluzione dei problemi delle ETL integrazioni zero di Aurora con Amazon Redshift

Vantaggi

ETLLe integrazioni zero di Aurora con Amazon Redshift offrono i seguenti vantaggi:

-

Ti consentono di ottenere approfondimenti di tipo olistico da più origini dati.

-

Elimina la necessità di creare e mantenere pipeline di dati complesse che eseguono operazioni di estrazione, trasformazione e caricamento (). ETL ETLLe integrazioni zero eliminano le sfide legate alla creazione e alla gestione delle pipeline fornendole e gestendole al posto tuo.

-

Ti consentono di ridurre il carico e i costi operativi e di concentrarti sul miglioramento delle applicazioni.

-

Consenti di sfruttare le funzionalità di analisi e ML di Amazon Redshift per ricavare informazioni dettagliate da dati transazionali e di altro tipo, per rispondere efficacemente a eventi critici e urgenti.

Concetti chiave

Quando inizi con le ETL integrazioni zero, considera i seguenti concetti:

- Integrazione

-

Una pipeline di dati completamente gestita che replica automaticamente i dati e gli schemi transazionali da un cluster di database DB a un data warehouse Amazon Redshift.

-

Il cluster di Aurora DB da cui vengono replicati i dati. Per Aurora MySQL, è possibile specificare un cluster DB che utilizza istanze DB assegnate o Aurora Serverless v2 Istanze DB come origine. Per l'SQLanteprima di Aurora Postgre, è possibile specificare solo un cluster che utilizza istanze DB assegnate.

- Data warehouse di destinazione

-

Si tratta del data warehouse di Amazon Redshift in cui viene eseguita la replica dei dati. Esistono due tipi di data warehouse: un data warehouse con cluster con provisioning e un data warehouse serverless. Un data warehouse con cluster con provisioning è costituito da un insieme di risorse di calcolo denominate nodi, strutturate in un gruppo denominato cluster. Un data warehouse serverless è composto da un gruppo di lavoro che archivia le risorse di calcolo e da un spazio dei nomi che ospita gli oggetti e gli utenti del database. Entrambi i data warehouse utilizzano un motore Amazon Redshift e contengono uno o più database.

I cluster DB di più di origine possono scrivere sulla stessa destinazione.

Per ulteriori informazioni sui nodi principali e sui nodi di calcolo, consulta Architettura del sistema di data warehouse nella Guida per sviluppatori di database di Amazon Redshift.

Limitazioni

Le seguenti limitazioni si applicano alle ETL integrazioni zero di Aurora con Amazon Redshift.

Argomenti

Limitazioni generali

-

Il cluster DB del di origine deve trovarsi nella stessa regione del data warehouse Amazon Redshift di destinazione.

-

Non puoi rinominare un cluster DB di o una delle sue istanze se dispone di integrazioni esistenti.

-

Non è possibile creare più integrazioni tra gli stessi database di origine e di destinazione.

-

Non è possibile eliminare un cluster DB di integrazioni esistenti. Devi prima eliminare tutte le integrazioni associate.

-

Se il cluster di è all'origine di una distribuzione blu/verde, gli ambienti blu e verde non possono avere ETL integrazioni zero esistenti durante lo switchover. Occorre eliminare l'integrazione, eseguire lo switchover e poi ricrearla.

-

Un cluster DB deve contenere almeno un'istanza DB per essere la fonte di un'integrazione.

-

Se il cluster di origine è il cluster database primario in un database globale Aurora e esegue il failover su uno dei relativi cluster secondari, l'integrazione diventa inattiva. È necessario eliminare e ricreare l'integrazione.

-

Non è possibile creare un'integrazione per un database di origine in cui viene creata attivamente un'altra integrazione.

-

Durante la fase iniziale della creazione di un'integrazione o quando una tabella viene risincronizzata, il seeding dei dati dall'origine alla destinazione può richiedere 20-25 minuti o più, a seconda delle dimensioni del database di origine. Questo ritardo può portare a un aumento del ritardo di replica.

-

Alcuni tipi di dati non sono supportati. Per ulteriori informazioni, consulta Differenze tra i tipi di dati tra i database Aurora e Amazon Redshift.

-

Le transazioni XA non sono supportate.

-

Gli identificatori di oggetto, inclusi il nome del database, il nome della tabella, i nomi delle colonne e altri, possono contenere solo caratteri alfanumerici, numeri, $ e _ (carattere di sottolineatura).

-

Le tabelle di sistema, le tabelle temporanee e le viste non vengono replicate su Amazon Redshift.

Aurora Le mie limitazioni SQL

-

Il cluster DB di origine deve eseguire una versione supportata di Aurora My. SQL Per un elenco delle versioni supportate, consulta Regioni supportate e motori Aurora DB per zero ETL integrazioni con Amazon Redshift.

-

ETLLe integrazioni zero si basano su My SQL binary logging (binlog) per acquisire le continue modifiche ai dati. Non utilizzare il filtraggio dei dati basato su binlog, poiché può causare incongruenze di dati tra i database di origine e di destinazione.

-

ETLLe integrazioni zero sono supportate solo per i database configurati per utilizzare il motore di archiviazione InnoDB.

-

I riferimenti a chiavi esterne con aggiornamenti di tabella predefiniti non sono supportati. In particolare,

ON DELETEleON UPDATEregole non sono supportate conCASCADESET NULL, eSET DEFAULTle azioni. Se si tenta di creare o aggiornare una tabella con tali riferimenti a un'altra tabella, la tabella entrerà in uno stato di errore. -

ALTER TABLEle operazioni di partizione provocano la risincronizzazione della tabella per ricaricare i dati da Aurora ad Amazon Redshift. La tabella non sarà disponibile per l'interrogazione durante la risincronizzazione. Per ulteriori informazioni, consulta Una o più tabelle Amazon Redshift richiedono una risincronizzazione.

Limitazioni dell'anteprima di Aurora Postger SQL

Importante

Anteprima terminata: l'anteprima per le integrazioni SQL zero di Aurora Postgre ETL con Amazon Redshift è terminata. Apprezziamo la tua partecipazione e il tuo feedback. Continuate a seguirci per ulteriori aggiornamenti sulla disponibilità e sui miglioramenti della funzionalità.

-

Il cluster DB di origine deve eseguire Aurora Postgre SQL (compatibile con Postgre 15.4 SQL e Zero- Support). ETL

-

Puoi creare e gestire ETL integrazioni zero per Aurora SQL Postgre solo nell'RDSAmazon Database Preview

Environment, negli Stati Uniti orientali (Ohio) (us-east-2) Regione AWS. Puoi utilizzare l'ambiente di anteprima per testare le versioni beta, release candidate e prime di produzione del software del motore di SQL database Postgre. -

Puoi creare e gestire integrazioni per Aurora SQL Postgre solo utilizzando AWS Management Console. Non puoi usare il AWS Command Line Interface (AWS CLI) RDSAPI, Amazon o uno qualsiasi dei AWS SDKs.

-

Quando crei un cluster DB di origine, il gruppo di parametri scelto deve avere già configurati i valori dei parametri del cluster DB richiesti. Non è possibile creare successivamente un nuovo gruppo di parametri e associarlo al cluster. Per un elenco dei parametri richiesti, vedereFase 1: creazione di un gruppo di parametri del cluster DB personalizzato.

-

Non puoi modificare un'integrazione dopo averla creata. Se è necessario modificare determinate impostazioni, è necessario eliminare e ricreare l'integrazione.

-

Attualmente, i cluster Aurora Postgre SQL DB che sono l'origine di un'integrazione non eseguono la raccolta inutile di dati di replica logica.

-

Tutti i database creati all'interno del cluster Aurora Postgre SQL DB di origine devono utilizzare la codifica -8. UTF

-

ETLLe integrazioni zero con Aurora SQL Postgre non supportano quanto segue:

-

Aurora Serverless v2 Istanze DB. Il cluster DB di origine deve utilizzare istanze DB assegnate.

-

Tipi di dati personalizzati o tipi di dati creati da estensioni.

-

Sottotransazioni

sul cluster DB di origine. -

Ridenominazione di schemi o database all'interno di un cluster DB di origine.

-

Ripristino da un'istantanea del cluster DB o utilizzo della clonazione Aurora per creare un cluster DB di origine. Se si desidera portare i dati esistenti in un cluster di anteprima, è necessario utilizzare le utilità or.

pg_dumppg_restore -

Creazione di slot di replica logica sull'istanza di scrittura del cluster DB di origine.

-

Valori di campo di grandi dimensioni che richiedono The Oversized-Attribute Storage Technique (). TOAST

-

ALTER TABLEoperazioni di partizione. Queste operazioni possono far sì che la tabella si risincronizzi e alla fine entri in uno stato.FailedSe una tabella fallisce, devi eliminarla e ricrearla.

-

Limitazioni di Amazon Redshift

Per un elenco delle limitazioni di Amazon Redshift relative alle ETL integrazioni zero, consulta Considerazioni nella Amazon Redshift Management Guide.

Quote

Il tuo account ha le seguenti quote relative alle integrazioni zero di Aurora con Amazon ETL Redshift. Salvo dove diversamente specificato, ogni quota fa riferimento a una Regione specifica.

| Nome | Predefinito | Descrizione |

|---|---|---|

| Integrazioni | 100 | Il numero totale di integrazioni all'interno di un Account AWS. |

| Integrazioni per data warehouse di destinazione | 50 | Numero di integrazioni che inviano dati a un unico data warehouse Amazon Redshift di destinazione. |

| Integrazioni per cluster di origine | per Aurora MySQL, 1 per Aurora Postgre SQL |

Inoltre, Amazon Redshift pone determinati limiti al numero di tabelle consentite in ogni istanza database o nodo del cluster. Per ulteriori informazioni, consulta Quote e limiti in Amazon Redshift nella Guida alla gestione di Amazon Redshift.

Regioni supportate

ETLLe integrazioni zero di Aurora con Amazon Redshift sono disponibili in un sottoinsieme di Regioni AWS. Per un elenco delle regioni supportate, consulta .