Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Gestione dello storage FSx su Windows File Server

La configurazione di storage del file system include la quantità di capacità di storage assegnata, il tipo di storage e, se il tipo di storage è un'unità a stato solido (SSD), la quantità di SSDIOPS. È possibile configurare queste risorse, insieme alla capacità di throughput del file system, durante la creazione di un file system e dopo la creazione, per ottenere le prestazioni desiderate per il carico di lavoro. Scopri come gestire lo storage del tuo file system e le prestazioni correlate allo storage utilizzando Amazon FSx CLI per la gestione remota su AWS Management Console AWS CLI, PowerShell esplorando i seguenti argomenti.

Argomenti

- Ottimizzazione dei costi di archiviazione

- Gestione della capacità di storage

- Gestione del tipo di storage del file system

- Gestione SSD IOPS

- Riduzione dei costi di storage con la deduplicazione dei dati

- Gestione delle quote di archiviazione

- Aumento della capacità di archiviazione del file system

- Monitoraggio dell'aumento della capacità di archiviazione

- Aumento dinamico della capacità di archiviazione di un file system FSx per Windows File Server

- Aggiornamento del tipo di archiviazione di un file system FSx per Windows

- Monitoraggio degli aggiornamenti dei tipi di archiviazione

- Aggiornamento di un file system SSD IOPS

- Monitoraggio degli aggiornamenti forniti SSD IOPS

- Gestione della deduplicazione dei dati

- Risoluzione dei problemi di deduplicazione dei dati

Ottimizzazione dei costi di archiviazione

Puoi ottimizzare i costi di archiviazione utilizzando le opzioni di configurazione dello storage disponibili in FSx Windows.

Opzioni di tipo di archiviazione: FSx per Windows File Server offre due tipi di storage, unità disco rigido (HDD) e unità a stato solido (SSD), per consentire di ottimizzare costi/prestazioni per soddisfare le esigenze di carico di lavoro. HDDlo storage è progettato per un ampio spettro di carichi di lavoro, tra cui home directory, condivisioni di utenti e dipartimenti e sistemi di gestione dei contenuti. SSDlo storage è progettato per i carichi di lavoro con le prestazioni più elevate e la maggior parte dei carichi di lavoro sensibili alla latenza, inclusi database, carichi di lavoro di elaborazione multimediale e applicazioni di analisi dei dati. Per ulteriori informazioni sui tipi di storage e sulle prestazioni del file system, vedere. FSxper le prestazioni di Windows File Server

Deduplicazione dei dati: i set di dati di grandi dimensioni spesso contengono dati ridondanti, il che aumenta i costi di archiviazione dei dati. Ad esempio, le condivisioni di file utente possono avere più copie dello stesso file, archiviate da più utenti. Le condivisioni di sviluppo software possono contenere molti file binari che rimangono invariati da una build all'altra. È possibile ridurre i costi di archiviazione dei dati attivando la deduplicazione dei dati per il file system. Quando è attivata, la deduplicazione dei dati riduce o elimina automaticamente i dati ridondanti archiviando porzioni duplicate del set di dati una sola volta. Per ulteriori informazioni sulla deduplicazione dei dati e su come attivarla facilmente per il tuo FSx file system Amazon, consulta. Riduzione dei costi di storage con la deduplicazione dei dati

Gestione della capacità di storage

È possibile aumentare la capacità di storage del file system FSx per Windows man mano che i requisiti di archiviazione cambiano. Puoi farlo utilizzando la FSx console Amazon FSxAPI, Amazon o AWS Command Line Interface (AWS CLI). I fattori da considerare quando si pianifica un aumento della capacità di storage includono sapere quando è necessario aumentare la capacità di storage, comprendere in che modo Amazon FSx elabora gli aumenti di capacità di storage e monitorare lo stato di avanzamento di una richiesta di aumento dello storage. Puoi solo aumentare la capacità di storage di un file system, non puoi ridurla.

Nota

Non è possibile aumentare la capacità di archiviazione per i file system creati prima del 23 giugno 2019 o per i file system ripristinati da un backup appartenente a un file system creato prima del 23 giugno 2019.

Quando aumenti la capacità di archiviazione del tuo FSx file system Amazon, Amazon FSx aggiunge un nuovo set di dischi più grande al tuo file system dietro le quinte. Amazon esegue FSx quindi un processo di ottimizzazione dello storage in background per migrare in modo trasparente i dati dai vecchi dischi ai nuovi dischi. L'ottimizzazione dello storage può richiedere da alcune ore a diversi giorni, a seconda del tipo di storage e di altri fattori, con un impatto minimo evidente sulle prestazioni del carico di lavoro. Durante questa ottimizzazione, l'utilizzo del backup è temporaneamente maggiore, poiché sia i vecchi che i nuovi volumi di storage sono inclusi nei backup a livello di file system. Entrambi i set di volumi di storage sono inclusi per garantire che Amazon FSx possa eseguire e ripristinare con successo i backup anche durante l'attività di scalabilità dello storage. L'utilizzo del backup torna al livello di base precedente dopo che i vecchi volumi di storage non sono più inclusi nella cronologia dei backup. Quando la nuova capacità di archiviazione diventa disponibile, ti viene fatturata solo la nuova capacità di archiviazione.

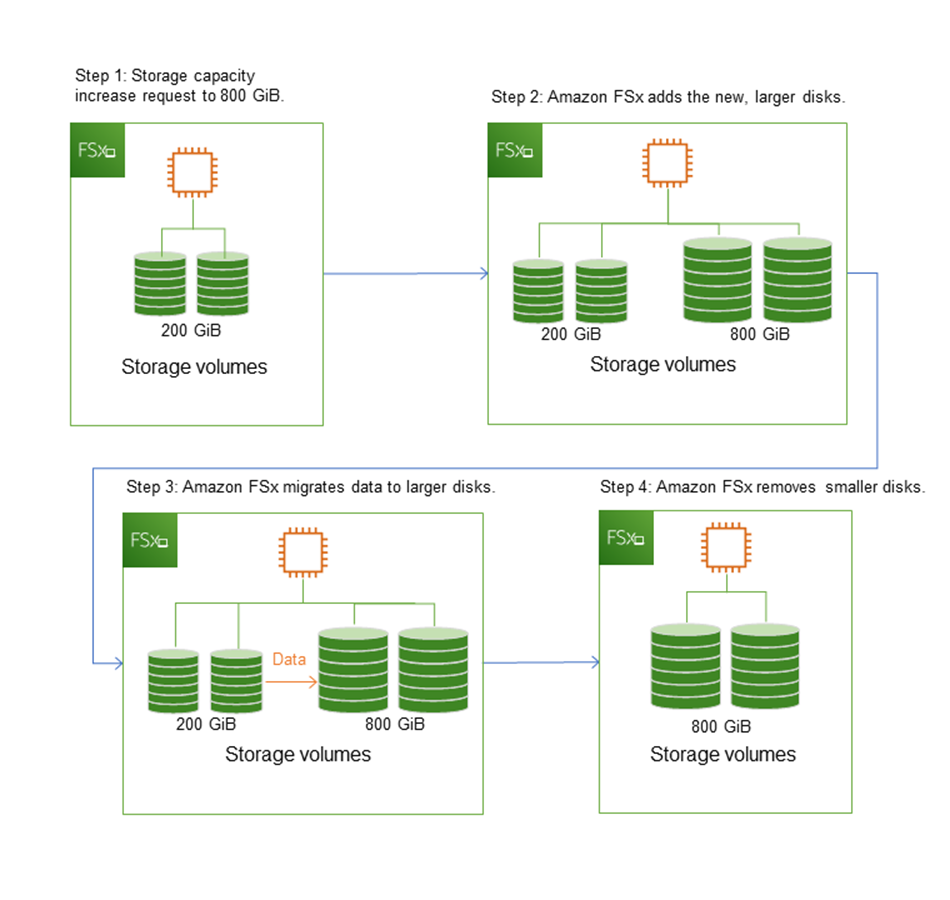

L'illustrazione seguente mostra le quattro fasi principali del processo FSx utilizzato da Amazon per aumentare la capacità di storage di un file system.

Puoi monitorare i progressi dell'ottimizzazione dello SSD storage, gli aumenti della capacità di archiviazione o SSD IOPS gli aggiornamenti in qualsiasi momento utilizzando la FSx console AmazonCLI, oppureAPI. Per ulteriori informazioni, consulta Monitoraggio dell'aumento della capacità di archiviazione.

Cosa sapere sull'aumento della capacità di storage di un file system

Ecco alcuni elementi importanti da considerare quando si aumenta la capacità di archiviazione:

-

Solo aumento: è possibile solo aumentare la quantità di capacità di archiviazione per un file system, non è possibile diminuire la capacità di archiviazione.

-

Aumento minimo: ogni aumento della capacità di storage deve essere pari almeno al 10% della capacità di storage corrente del file system, fino al valore massimo consentito di 65.536 GiB.

-

Capacità di throughput minima: per aumentare la capacità di archiviazione, un file system deve avere una capacità di throughput minima di 16 MB/s. Questo perché la fase di ottimizzazione dello storage è un processo che richiede un elevato livello di throughput.

-

Tempo tra un aumento e l'altro: non è possibile aumentare ulteriormente la capacità di archiviazione su un file system fino a 6 ore dopo l'ultima richiesta di aumento o fino al completamento del processo di ottimizzazione dello storage, a seconda di quale periodo sia più lungo. Il completamento dell'ottimizzazione dello storage può richiedere da alcune ore a qualche giorno. Per ridurre al minimo il tempo necessario per il completamento dell'ottimizzazione dello storage, si consiglia di aumentare la capacità di trasmissione del file system prima di aumentare la capacità di storage (la capacità di throughput può essere ridotta nuovamente al termine del ridimensionamento dello storage) e di aumentare la capacità di storage quando il traffico sul file system è minimo.

Nota

Alcuni eventi del file system possono consumare le risorse prestazionali di I/O del disco. Ad esempio:

La fase di ottimizzazione della scalabilità della capacità di archiviazione può generare un aumento della velocità effettiva del disco e potenzialmente causare avvisi sulle prestazioni. Per ulteriori informazioni, consulta Avvertenze e raccomandazioni sulle prestazioni.

Sapere quando aumentare la capacità di archiviazione

Aumenta la capacità di storage del file system quando la capacità di storage disponibile sta per esaurirsi. Utilizza la FreeStorageCapacity CloudWatch metrica per monitorare la quantità di spazio di archiviazione gratuito disponibile sul file system. Puoi creare un CloudWatch allarme Amazon in base a questa metrica e ricevere una notifica quando scende al di sotto di una soglia specifica. Per ulteriori informazioni, consulta Monitoraggio con Amazon CloudWatch.

Ti consigliamo di mantenere sempre almeno il 10% della capacità di archiviazione gratuita sul tuo file system. L'utilizzo di tutta la capacità di storage può influire negativamente sulle prestazioni e introdurre incongruenze nei dati.

È possibile aumentare automaticamente la capacità di storage del file system quando la quantità di capacità di archiviazione libera scende al di sotto di una soglia definita dall'utente. Utilizza il AWS CloudFormation modello personalizzato AWS sviluppato da ‐per distribuire tutti i componenti necessari per implementare la soluzione automatizzata. Per ulteriori informazioni, consulta Aumento dinamico della capacità di storage.

Aumento della capacità di storage e delle prestazioni del file system

La maggior parte dei carichi di lavoro ha un impatto minimo sulle prestazioni mentre Amazon FSx esegue il processo di ottimizzazione dello storage in background dopo che la nuova capacità di storage è disponibile. Le applicazioni ad alta intensità di scrittura con set di dati attivi di grandi dimensioni potrebbero subire temporaneamente una riduzione fino alla metà delle prestazioni di scrittura. In questi casi, è possibile aumentare la capacità di trasmissione del file system prima di aumentare la capacità di archiviazione. Ciò consente di continuare a fornire lo stesso livello di velocità effettiva per soddisfare le esigenze di prestazioni dell'applicazione. Per ulteriori informazioni, consulta Gestione della capacità di throughput sui FSx file system Windows File Server.

Gestione del tipo di storage del file system

È possibile modificare il tipo di storage del file system da HDD a SSD utilizzando AWS Management Console and AWS CLI. Quando modifichi il tipo di storage inSSD, tieni presente che non puoi aggiornare nuovamente la configurazione del file system prima di 6 ore dopo la richiesta dell'ultimo aggiornamento o fino al completamento del processo di ottimizzazione dello storage, a seconda di quale periodo sia più lungo. Il completamento dell'ottimizzazione dello storage può richiedere da alcune ore a qualche giorno. Per ridurre al minimo questo tempo, ti consigliamo di aggiornare il tipo di archiviazione quando il traffico sul file system è minimo. Per ulteriori informazioni, consulta Aggiornamento del tipo di archiviazione di un file system FSx per Windows.

Non puoi modificare il tipo di archiviazione del file system da SSD aHDD. Se desideri modificare il tipo di storage di un file system da SSD aHDD, dovrai ripristinare un backup del file system su un nuovo file system configurato per l'utilizzo HDD dello storage. Per ulteriori informazioni, consulta Ripristino dei backup su un nuovo file system.

Informazioni sui tipi di storage

È possibile configurare il file system FSx per Windows File Server in modo che utilizzi il tipo di archiviazione su unità a stato solido (SSD) o su disco rigido magnetico (HDD).

SSDlo storage è appropriato per la maggior parte dei carichi di lavoro di produzione con requisiti di prestazioni e sensibilità alla latenza elevati. Esempi di questi carichi di lavoro includono database, analisi dei dati, elaborazione multimediale e applicazioni aziendali. Lo consigliamo anche SSD per casi d'uso che coinvolgono un gran numero di utenti finali, alti livelli di I/O o set di dati con un gran numero di file di piccole dimensioni. Infine, si consiglia di utilizzare l'SSDarchiviazione se si prevede di abilitare le copie shadow. È possibile configurare e scalare SSD IOPS i file system con SSD storage, ma non con HDD storage.

HDDlo storage è progettato per un'ampia gamma di carichi di lavoro, tra cui home directory, condivisioni di file tra utenti e dipartimenti e sistemi di gestione dei contenuti. HDDlo storage ha un costo inferiore rispetto allo SSD storage, ma con latenze più elevate e livelli inferiori di throughput del disco e disco per unità di storage. IOPS Potrebbe essere adatto per condivisioni utente generiche e home directory con requisiti di I/O bassi, sistemi di gestione dei contenuti di grandi dimensioni (CMS) in cui i dati vengono recuperati raramente o set di dati con un numero limitato di file di grandi dimensioni.

Per ulteriori informazioni, consulta Configurazione e prestazioni dello storage.

Gestione SSD IOPS

Per i file system configurati con SSD lo storage, la quantità di SSD IOPS determina la quantità di I/O del disco disponibile quando il file system deve leggere e scrivere dati su disco, rispetto ai dati che si trovano nella cache. È possibile selezionare e scalare la quantità SSD IOPS indipendentemente dalla capacità di archiviazione. La quantità massima di SSD IOPS cui è possibile effettuare il provisioning dipende dalla quantità di capacità di storage e di capacità di throughput selezionata per il file system. Se si tenta di SSD IOPS superare il limite supportato dalla capacità di throughput, potrebbe essere necessario aumentare la capacità di throughput per raggiungere quel livello di. SSD IOPS Per ulteriori informazioni, consulta FSxper le prestazioni di Windows File Server e Gestione della capacità di throughput sui FSx file system Windows File Server.

Ecco alcuni elementi importanti da sapere sull'aggiornamento del provisioning di un file system: SSD IOPS

Scelta di una IOPS modalità: sono IOPS disponibili due modalità tra cui scegliere:

Automatico: scegli questa modalità e Amazon FSx ridimensionerà automaticamente la tua capacità di storage SSD IOPS per mantenere 3 SSD IOPS per GiB di capacità di storage, fino a 400.000 SSD IOPS per file system.

Fornito dall'utente: scegli questa modalità in modo da poter specificare il numero compreso tra 96 e SSD IOPS 400.000. Specificare un numero compreso tra 3 e 50 per IOPS GiB di capacità di storage per tutti i paesi in cui Regioni AWS Amazon FSx è disponibile o tra 3 e 500 per IOPS GiB di capacità di storage negli Stati Uniti orientali (Virginia settentrionale), Stati Uniti occidentali (Oregon), Stati Uniti orientali (Ohio), Europa (Irlanda), Asia Pacifico (Tokyo) e Asia Pacifico (Singapore). Se si sceglie la modalità di provisioning dall'utente e la quantità SSD IOPS specificata non è almeno 3 per IOPS GiB, la richiesta ha esito negativo. Per livelli di provisioning più elevati SSDIOPS, si paga una media IOPS superiore IOPS a 3 GiB per file system.

Aggiornamenti della capacità di storage: se aumenti la capacità di storage del file system e la quantità richiede, per impostazione predefinita, una quantità superiore al SSD IOPS livello corrente fornito dall'utente, Amazon passa FSx automaticamente il file system alla modalità Automatica e il file system avrà un minimo di 3 per SSD IOPS GiB di capacità di storage. SSD IOPS

Aggiornamenti della capacità di throughput: se aumenti la capacità di throughput e il valore massimo SSD IOPS supportato dalla nuova capacità di throughput è superiore al SSD IOPS livello fornito dall'utente, FSx Amazon passa automaticamente il file system alla modalità Automatica.

Frequenza degli SSD IOPS aumenti: non puoi apportare ulteriori SSD IOPS aumenti, aumenti della capacità di throughput o aggiornamenti del tipo di storage su un file system fino a 6 ore dopo l'ultima richiesta di aumento o fino al completamento del processo di ottimizzazione dello storage, a seconda di quale periodo sia più lungo. Il completamento dell'ottimizzazione dello storage può richiedere da alcune ore a qualche giorno. Per ridurre al minimo il tempo necessario per il completamento dell'ottimizzazione dello storage, si consiglia di eseguire la scalabilità SSD IOPS quando il traffico sul file system è minimo.

Nota

Tieni presente che i livelli di capacità di throughput pari o superiori a 4.608 MBps sono supportati solo nei seguenti paesi Regioni AWS: Stati Uniti orientali (Virginia settentrionale), Stati Uniti occidentali (Oregon), Stati Uniti orientali (Ohio), Europa (Irlanda), Asia Pacifico (Tokyo) e Asia Pacifico (Singapore).

Per ulteriori informazioni su come aggiornare la quantità di dati assegnati SSD IOPS FSx per il file system Windows File Server, vedere. Aggiornamento di un file system SSD IOPS

Riduzione dei costi di storage con la deduplicazione dei dati

La deduplicazione dei dati, spesso denominata in breve Dedup, aiuta gli amministratori di storage a ridurre i costi associati alla duplicazione dei dati. Con FSx for Windows File Server, puoi utilizzare Microsoft Data Deduplication per identificare ed eliminare i dati ridondanti. I set di dati di grandi dimensioni spesso contengono dati ridondanti, il che aumenta i costi di archiviazione dei dati. Per esempio:

Le condivisioni di file degli utenti possono avere molte copie dello stesso file o di file simili.

Le condivisioni di sviluppo software possono avere molti file binari che rimangono invariati da una build all'altra.

È possibile ridurre i costi di archiviazione dei dati abilitando la deduplicazione dei dati per il file system. La deduplicazione dei dati riduce o elimina i dati ridondanti archiviando parti duplicate del set di dati una sola volta. Quando si abilita la deduplicazione dei dati, la compressione dei dati è abilitata per impostazione predefinita, comprimendo i dati dopo la deduplicazione per ulteriori risparmi. La deduplicazione dei dati ottimizza le ridondanze senza compromettere la fedeltà o l'integrità dei dati. La deduplicazione dei dati viene eseguita come un processo in background che analizza e ottimizza continuamente e automaticamente il file system ed è trasparente per gli utenti e i client connessi.

I risparmi di storage che è possibile ottenere con la deduplicazione dei dati dipendono dalla natura del set di dati, inclusa la quantità di duplicazione esistente tra i file. I risparmi tipici sono in media del 50-60% per le condivisioni di file per uso generico. Nell'ambito delle azioni, i risparmi vanno dal 30 al 50 percento per i documenti degli utenti al 70-80 percento per i set di dati di sviluppo software. È possibile misurare i potenziali risparmi derivanti dalla deduplicazione utilizzando il comando remoto descritto di seguito. Measure-FSxDedupFileMetadata PowerShell

È inoltre possibile personalizzare la deduplicazione dei dati per soddisfare esigenze di storage specifiche. Ad esempio, è possibile configurare la deduplicazione in modo che venga eseguita solo su determinati tipi di file oppure è possibile creare una pianificazione dei processi personalizzata. Poiché i processi di deduplicazione possono consumare risorse del file server, si consiglia di monitorare lo stato dei processi di deduplicazione utilizzando il. Get-FSxDedupStatus

Per informazioni sulla configurazione della deduplicazione dei dati sul file system, vedere. Gestione della deduplicazione dei dati

Per informazioni sulla risoluzione dei problemi relativi alla deduplicazione dei dati, vedere.

Per ulteriori informazioni sulla deduplicazione dei dati, consulta la documentazione di Microsoft Understanding Data Deduplication

avvertimento

Non è consigliabile eseguire determinati comandi Robocopy con deduplicazione dei dati perché questi comandi possono influire sull'integrità dei dati del Chunk Store. Per ulteriori informazioni, consulta la documentazione sull'interoperabilità di Microsoft Data Deduplication

Le migliori pratiche per l'utilizzo della deduplicazione dei dati

Ecco alcune best practice per l'utilizzo della deduplicazione dei dati:

Pianifica l'esecuzione dei processi di deduplicazione dei dati quando il file system è inattivo: la pianificazione predefinita include un

GarbageCollectionprocesso settimanale alle 2:45 il sabato. UTC Il completamento dell'operazione può richiedere diverse ore se il file system presenta una grande quantità di dati. Se questo periodo non è ideale per il tuo carico di lavoro, pianifica l'esecuzione di questo processo in un momento in cui prevedi uno scarso traffico sul tuo file system.Configura una capacità di throughput sufficiente per completare la deduplicazione dei dati: capacità di throughput più elevate forniscono livelli di memoria più elevati. Microsoft consiglia di disporre di 1 GB di memoria per 1 TB di dati logici per eseguire la deduplicazione dei dati. Utilizza la tabella FSx delle prestazioni di Amazon per determinare la memoria associata alla capacità di throughput del tuo file system e assicurati che le risorse di memoria siano sufficienti per le dimensioni dei tuoi dati.

Personalizza le impostazioni di deduplicazione dei dati per soddisfare le tue esigenze di storage specifiche e ridurre i requisiti di prestazioni: puoi limitare l'ottimizzazione affinché venga eseguita su tipi di file o cartelle specifici oppure impostare una dimensione e una data minime del file per l'ottimizzazione. Per ulteriori informazioni, consulta Riduzione dei costi di storage con la deduplicazione dei dati.