Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Tutorial: aggiunta di un crawler AWS Glue

Per questo AWS Glue, ti viene chiesto di analizzare i dati degli arrivi dei principali vettori aerei per calcolare la popolarità degli aeroporti di partenza mese dopo mese. Hai i dati dei voli per l'anno 2016 in formato CSV memorizzati in Amazon S3. Prima di trasformare e analizzare i dati, è necessario catalogarne i metadati in AWS Glue Data Catalog.

In questo tutorial, aggiungiamo un crawler che deduce i metadati da questi registri di volo in Amazon S3 e creiamo una tabella nel catalogo dati.

Argomenti

Prerequisiti

Questo tutorial presuppone che si abbia un account AWS e l'accesso ad AWS Glue.

Fase 1: aggiunta di un crawler

Segui questa procedura per configurare ed eseguire un crawler che estrae i metadati da un file CSV archiviato in Amazon S3.

Per creare un crawler in grado di leggere i file archiviati su Amazon S3

-

Sulla console di servizio AWS Glue, nel menu a sinistra, scegli Crawlers (Crawler).

-

Nella pagina Crawler, scegli Crea crawler. In questo modo viene avviata una serie di pagine che richiedono di specificare i dettagli del crawler.

-

Rinomina il crawler Crawler name (Nome crawler), inserisci

Flights Data Crawler, quindi scegli Next (Avanti).I crawler invocano classificatori per dedurre lo schema dei dati. Questo tutorial utilizza il classificatore incorporato per CSV per impostazione predefinita.

-

Per il tipo di origine crawler, scegli Data stores (Datastore) e scegli Next (Avanti).

-

Ora puntiamo il crawler ai dati. Nella pagina Add a data store (Aggiungi datasore), scegli il datastore Amazon S3. Questa esercitazione non usa una connessione, quindi lascia il campo Connection (Connessione) vuoto se è visibile.

Per l'opzione Crawl data in (Crawling dati), scegli Specified path in another account (Percorso specificato in un altro account). Quindi, nel campo Include path (Percorso di inclusione), inserisci il percorso in cui il crawler può trovare i dati dei voli, che è

s3://crawler-public-us-east-1/flight/2016/csv. Dopo aver inserito il percorso, il titolo di questo campo cambia in Include path (Percorso di inclusione). Seleziona Next (Successivo). -

È possibile eseguire il crawling di più datasore con un crawler singolo. Tuttavia, in questa esercitazione, stiamo utilizzando un solo datastore, quindi scegli No e poi Next (Successivo).

-

Il crawler ha bisogno delle autorizzazioni per accedere al Data Store e creare oggetti in AWS Glue Data Catalog. Per configurare queste autorizzazioni, scegli Create an IAM role (Crea un ruolo IAM). Il nome del ruolo IAM inizia con

AWSGlueServiceRole-e, nel campo, inserisci l'ultima parte del nome del ruolo. InserisciCrawlerTutorial, quindi seleziona Save (Salva).Nota

Per creare un ruolo IAM, il tuo utente AWS deve avere le autorizzazioni

CreateRole,CreatePolicyeAttachRolePolicy.La procedura guidata crea un ruolo IAM denominato

AWSGlueServiceRole-CrawlerTutorial, allega la policy gestita da AWSAWSGlueServiceRoleal ruolo e aggiunge una policy inline che consente l'accesso in lettura alla posizione di Amazon S3s3://crawler-public-us-east-1/flight/2016/csv. -

Crea una pianificazione per il crawler. Per Frequency (Frequenza), scegli Run on demand (Esegui on demand) e scegli Next (Successivo).

-

I crawler creano le tabelle nel catalogo dati. Un database nel catalogo dati contiene le tabelle. Per prima cosa, scegli Add database (Aggiungi database) per creare un database. Nella finestra popup, inserisci

test-flights-dbper il nome del database, quindi scegli Create (crea).Quindi, inserisci

flightsper Prefix added to tables (Prefisso aggiunto alle tabelle). Utilizza i valori predefiniti per il resto delle opzioni e scegli Next (Successivo). -

Controlla le selezioni eseguite nella procedura guidata Add crawler (Aggiungi crawler). Se vedi errori, puoi scegliere Back (Indietro) per tornare alle pagine precedenti e apportare modifiche.

Dopo aver esaminato le informazioni, scegli Finish (Termina) per creare il crawler.

Fase 2: esecuzione del crawler

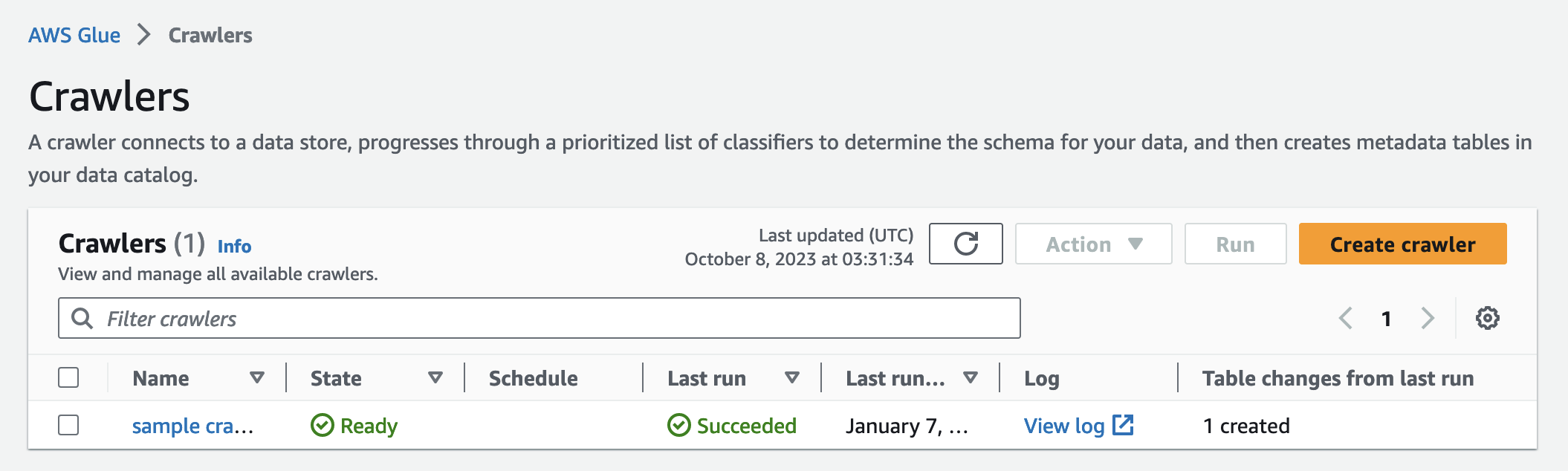

Dopo aver creato un crawler, la procedura guidata ti reindirizza alla pagina di visualizzazione del crawler. Poiché crei il crawler con una pianificazione on demand, ti viene data la possibilità di eseguirlo.

Per eseguire il crawler

-

Il banner nella parte superiore di questa pagina ti permette di sapere che il crawler è stato creato e chiede se si desidera eseguirlo ora. Seleziona Run it now? (Eseguirlo adesso?) per eseguire il crawler.

Il banner cambia e mostra i messaggi "Attempting to run" (Tentativo di esecuzione) e "Running" (In esecuzione) per il crawler. Dopo l'avvio del crawler, il banner scompare e la visualizzazione del crawler viene aggiornata per mostrare lo stato avvio del crawler. Dopo un minuto, puoi fare clic sull'icona Refresh (Aggiorna) per aggiornare lo stato del crawler visualizzato nella tabella.

-

Al completamento del crawler, viene visualizzato un nuovo banner che descrive le modifiche apportate dal crawler. Puoi scegliere la voce test-flights-db per visualizzare gli oggetti del catalogo dati.

Fase 3: visualizzazione degli oggetti AWS Glue Data Catalog

Il crawler legge i dati nella posizione di origine e crea tabelle nel catalogo dati. Una tabella è la definizione di metadati che rappresentano i tuoi dati, incluso il relativo schema. Le tabelle del catalogo dati non contengono dati. Vengono invece utilizzate come origine o destinazione in una definizione di processo.

Per visualizzare gli oggetti del catalogo dati creati dal crawler

-

Nel pannello di navigazione a sinistra, sotto Data catalog (Catalogo dati), scegli Database. Qui è possibile visualizzare database

flights-dbcreato dal crawler. -

Nel pannello di navigazione a sinistra, sotto Data catalog (Catalogo dati) e sotto Databases (Database), scegli Tables (Tabelle). Qui è possibile visualizzare la tabella

flightscsvcreata dal crawler. Scegliendo il nome della tabella, è possibile visualizzare le impostazioni, i parametri e le proprietà della tabella. Scorrendo verso il basso nella visualizzazione, puoi visualizzare lo schema, ovvero informazioni sulle colonne e sui tipi di dati della tabella. -

Se scegli View partitions (Visualizza le partizioni) nella pagina di visualizzazione della tabella, puoi vedere le partizioni create per i dati. La prima colonna è la chiave di partizione.