Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Segnalazione della durata dell'esecuzione e delle unità di inferenza utilizzate

Se hai addestrato e avviato il tuo modello dopo agosto 2022, puoi utilizzare la CloudWatch metrica di InServiceInferenceUnits Amazon per determinare per quante ore è stato eseguito un modello e il numero di unità di inferenza utilizzate durante quelle ore.

Nota

Se disponi di un solo modello in una AWS regione, puoi anche calcolare il tempo di esecuzione del modello monitorando le chiamate riuscite in entrata StartprojectVersion e StopProjectVersion in entrata. CloudWatch Questo approccio non funziona se utilizzi più di un modello nella AWS regione, poiché le metriche non includono informazioni sul modello.

In alternativa, è possibile utilizzare AWS CloudTrail per tenere traccia delle chiamate verso StartProjectVersion e StopProjectVersion (che include il modello ARN nel requestParameters campo della cronologia degli eventi). CloudTrail gli eventi sono limitati a 90 giorni, ma è possibile memorizzare eventi per un massimo di 7 anni in un CloudTraillago.

La procedura seguente crea grafici per quanto segue:

Il numero di ore di funzionamento di un modello.

Il numero di unità di inferenza utilizzate da un modello.

Puoi scegliere un periodo di tempo precedente fino a 15 mesi. Per ulteriori informazioni sulla conservazione delle metriche, consulta Conservazione delle metriche.

Per determinare la durata del modello e le unità di inferenza utilizzate per un modello

-

Accedi AWS Management Console e apri la CloudWatch console all'indirizzo https://console.aws.amazon.com/cloudwatch/

. -

Nel riquadro di navigazione, in Metriche, scegli Tutte le metriche.

Nel riquadro inferiore scegli la scheda Origine.

Assicurati che il pulsante Pannello di controllo sia selezionato.

Nella scheda, sostituisci il JSON esistente con il seguente JSON. Imposta i valori seguenti:

Project_Name— Il progetto che contiene il modello per cui creare il grafico.Version_Name— La versione del modello che per cui creare il grafico.-

AWS_Region— La AWS regione che contiene il modello. Assicurati che la CloudWatch console si trovi nella stessa AWS regione, controllando il selettore della regione nella barra di navigazione nella parte superiore della pagina. Esegui l'aggiornamento in base alle esigenze.

{ "sparkline": true, "metrics": [ [ { "expression": "SUM(m1)*m1", "label": "Inference units used", "id": "e1" } ], [ { "expression": "DATAPOINT_COUNT(m1)*m1/m1", "label": "Hours running", "id": "e2" } ], [ "AWS/Rekognition", "InServiceInferenceUnits", "ProjectName", "Project_Name", "VersionName", "Version_Name", { "id": "m1", "visible": false } ] ], "view": "singleValue", "stacked": false, "region": "AWS_Region", "stat": "Average", "period": 3600, "title": "Hours run and inference units used" }Scegli Aggiorna.

-

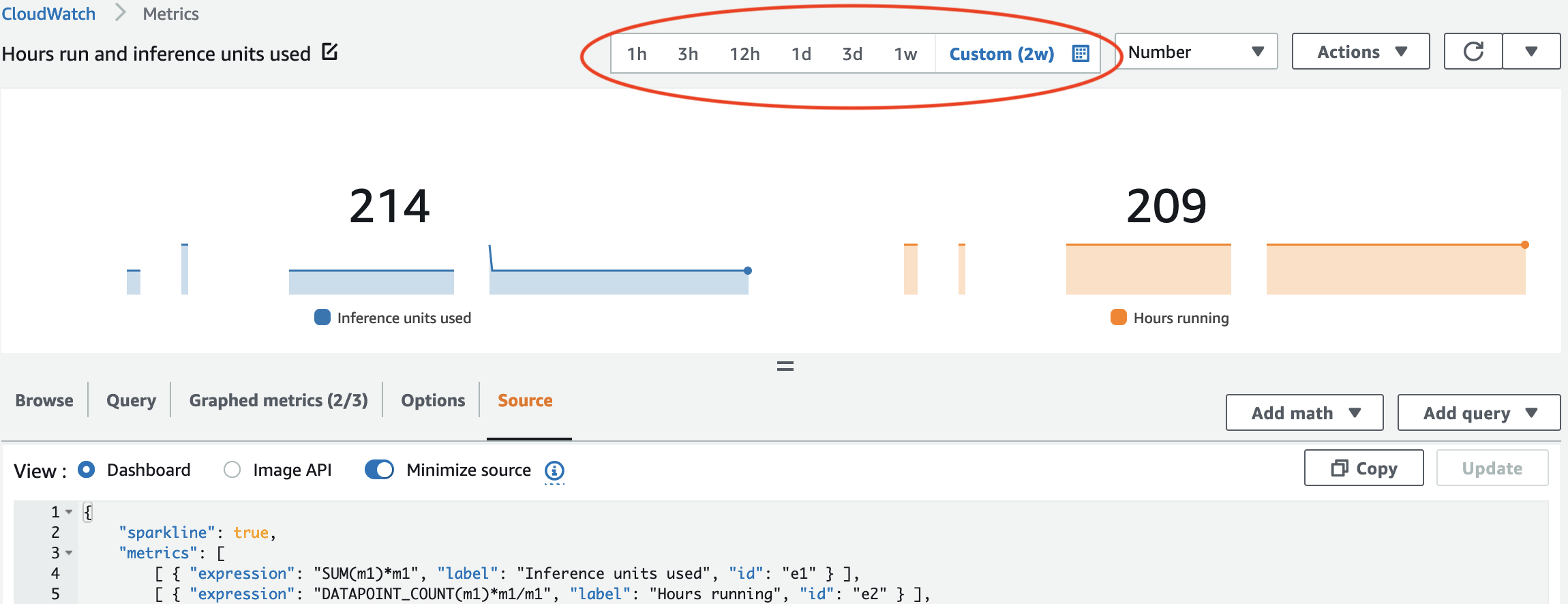

Nella parte superiore della pagina, scegli Salva. Dovreste vedere i numeri relativi alle unità di inferenza utilizzate e alle ore contingenti durante la sequenza temporale. Gli spazi vuoti nel grafico indicano i momenti in cui il modello non era in esecuzione. Di seguito è riportata la schermata della console che mostra le unità di inferenza utilizzate e le ore di esecuzione in periodi di tempo, con un tempo personalizzato di 2 settimane impostato, con i valori più alti di 214 unità di inferenza e 209 ore di funzionamento.

-

(Opzionale) Per aggiungere il grafico a un pannello di controllo, seleziona Operazioni, Aggiungi a pannello di controllo.