Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Report di spiegabilità

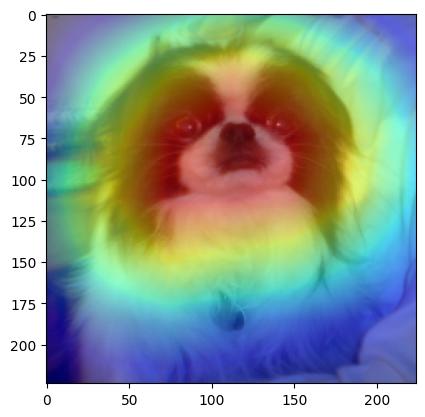

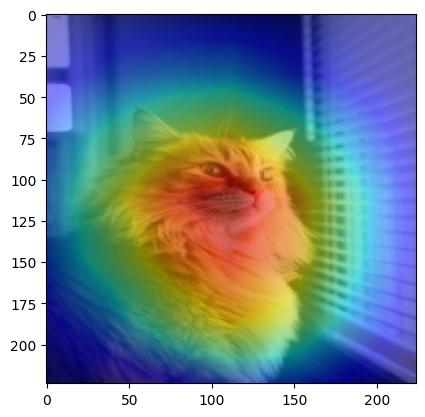

Amazon SageMaker Autopilot fornisce un rapporto di spiegabilità per aiutare a spiegare in che modo il miglior modello candidato fa previsioni per problemi di classificazione delle immagini. Questo report può aiutare gli ingegneri del machine learning, i product manager e altri stakeholder interni a comprendere le caratteristiche del modello. Sia i consumatori che le autorità di regolamentazione si affidano alla trasparenza del machine learning per fidarsi e interpretare le decisioni prese sulla base delle previsioni dei modelli. Puoi utilizzare queste spiegazioni per verificare e soddisfare i requisiti normativi, creare fiducia nel modello, supportare il processo decisionale umano, eseguire il debug e migliorare le prestazioni del modello.

La funzionalità esplicativa di Autopilot per la classificazione delle immagini utilizza un approccio visual class activation map (CAM) che produce una mappa termica in cui la distribuzione e l'intensità di ciascun colore evidenziano le aree di un'immagine che contribuiscono maggiormente a una previsione specifica. Questo approccio si basa sui componenti principali derivati da un'implementazione di Eigen-. CAM

Autopilot genera il rapporto di spiegabilità come file. JSON Il report include dettagli di analisi basati sul set di dati di convalida. Ogni immagine utilizzata per generare il report contiene le seguenti informazioni:

-

input_image_uri: da Amazon S3 URI all'immagine di input presa come input per la heatmap. -

heatmap_image_uri: da Amazon S3 URI all'immagine della mappa termica generata da Autopilot. -

predicted_label: La classe di etichetta prevista dal miglior modello addestrato da Autopilot. -

probability: la sicurezza con cuipredicted_labelviene previsto.

Puoi trovare il prefisso Amazon S3 per gli artefatti di spiegabilità generati per il miglior candidato nella risposta a DescribeAutoMLJobV2 in BestCandidate.CandidateProperties.CandidateArtifactLocations.Explainability.

Gli esempi seguenti illustrano l'aspetto delle mappe di calore su alcuni esempi di Oxford- Pet Dataset. IIIT

| Immagine di input | Immagine heatmap |

|---|---|

|

|

|

|