翻訳は機械翻訳により提供されています。提供された翻訳内容と英語版の間で齟齬、不一致または矛盾がある場合、英語版が優先します。

Infrastructure as Code を使用してサーバーレスデータレイクを AWS Cloud にデプロイして管理する

作成者: Kirankumar Chandrashekar (AWS) と Abdel Jaidi (AWS)

環境:本稼働 | テクノロジー: 分析、サーバーレス、 DevOps | ワークロード:その他すべてのワークロード |

AWS サービス: Amazon S3、Amazon SQS、 CloudFormationAWS、AWS Glue、Amazon CloudWatch、AWS Lambda、AWS Step Functions、Amazon DynamoDB |

[概要]

注意: CodeCommit AWS は新規顧客には利用できなくなりました。AWS CodeCommit Word の既存のお客様は、通常どおりサービスを引き続き使用できます。詳細はこちら

このパターンでは、サーバーレスコンピューティング

SDLF は、AWS クラウドでのエンタープライズデータレイクの配信を加速し、本番環境への迅速なデプロイに役立つ再利用可能なリソースのコレクションです。ベストプラクティスに従ってデータレイクの基本構造を実装するために使用されます。

SDLF は、Word、AWS、Word などの CodePipelineAWS サービスを使用して、コードとインフラストラクチャのデプロイ全体で継続的インテグレーション/継続的デプロイ (CI/CD) プロセスを実装AWS CodeBuildしますAWS CodeCommit。

このパターンでは、複数の AWS サーバーレスサービスを使用してデータレイク管理を簡素化します。これには、ストレージ用の Amazon Simple Storage Service (Amazon S3) と Amazon DynamoDB、コンピューティング用の AWS Lambda と AWS Glue、オーケストレーション用の Amazon CloudWatch Events、Amazon Simple Queue Service (Amazon SQS)、AWS Step Functions が含まれます。

CloudFormation AWS および AWS コードサービスは IaC レイヤーとして機能し、再現可能で迅速なデプロイと、簡単なオペレーションと管理を提供します。

前提条件と制限

前提条件

アクティブ AWS アカウント。

AWS コマンドラインインターフェイス (AWS CLI) がインストールされ、設定されています。

インストールおよび設定済みの Git クライアント。

SDLF ワークショップ

は、ウェブブラウザウィンドウで開き、すぐに使用できます。

アーキテクチャ

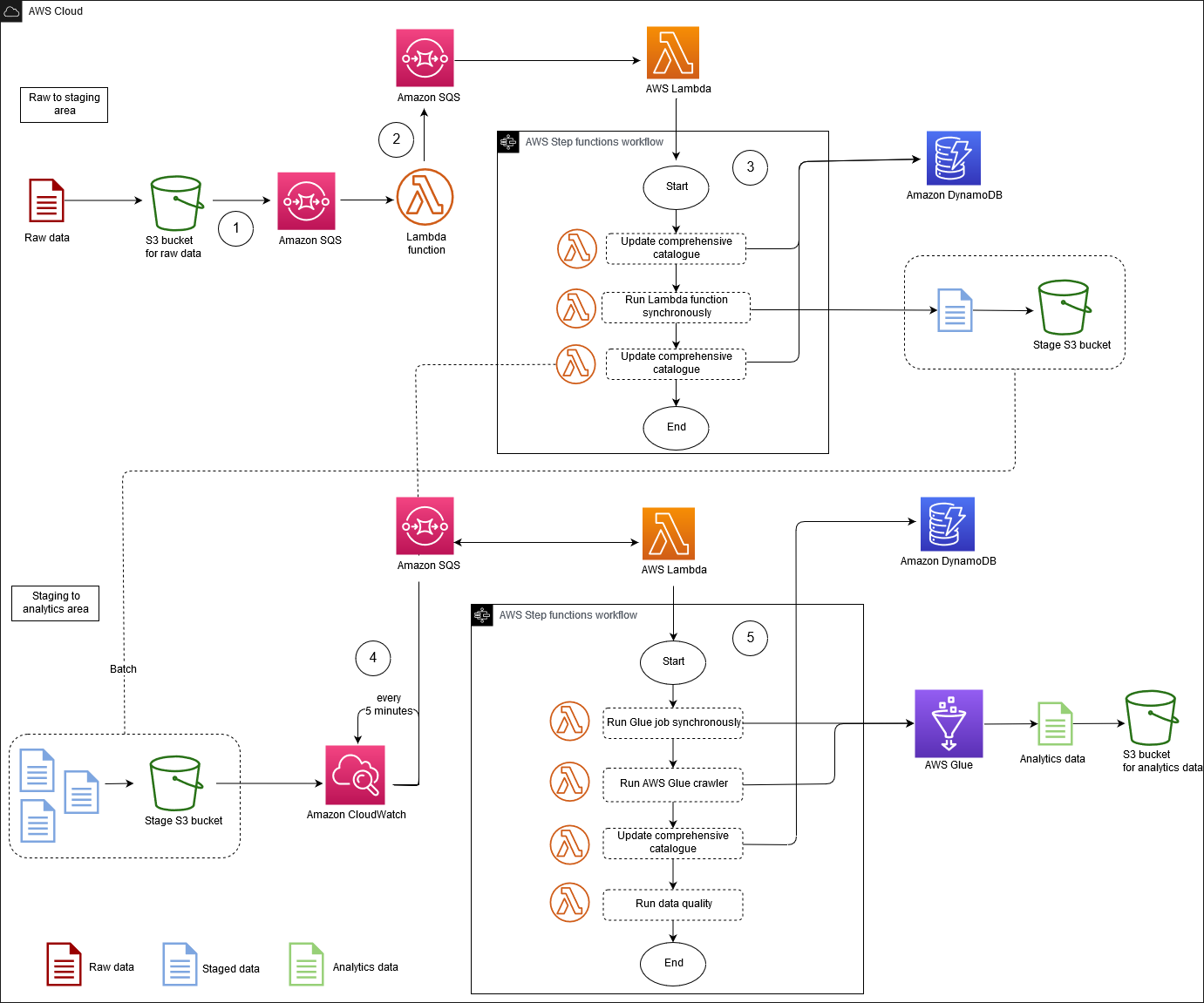

このアーキテクチャ図は、イベント駆動型プロセスを以下のステップで示しています。

raw データ S3 バケットにファイルを追加すると、Amazon S3 イベント通知が SQS キューに配置されます。各通知は JSON ファイルとして配信され、S3 バケット名、オブジェクトキー、タイムスタンプなどのメタデータが含まれます。

この通知は、メタデータに基づいてイベントを正しい抽出、変換、ロード (ETL) プロセスにルーティングする Lambda 関数によって使用されます。Lambda 関数は Amazon DynamoDB テーブルに保存されているコンテキスト設定を使用することもできます。このステップにより、データレイク内の複数のアプリケーションを切り離してスケーリングできるようになります。

イベントは ETL プロセスの最初の Lambda 関数にルーティングされ、データは raw データ領域からデータレイクのステージング領域に変換されて移動されます。最初のステップでは、総合カタログを更新します。これは、データレイクのすべてのファイルメタデータを含む DynamoDB テーブルです。このテーブルの各行には、Amazon S3 に保存されている 1 つのオブジェクトに関する運用メタデータが格納されています。S3 オブジェクトに対して軽い変換を行う Lambda 関数に対して同期呼び出しが行われます。この変換は、計算コストのかからない操作 (ファイルをある形式から別の形式に変換するなど) です。新しいオブジェクトがステージング S3 バケットに追加されているため、包括的なカタログが更新され、SQS の次のフェーズを待つメッセージが ETL キューに送信されます。

A CloudWatch Events ルールは、5 分ごとに Lambda 関数をトリガーします。この関数は、メッセージが前の SQS フェーズから ETL キューに配信されたかどうかを確認します。メッセージが配信された場合、Lambda 関数は AWS プロセスの Word Step Functions から 2 番目の関数を開始します。 ETL

その後、大量の変換がファイルのバッチに適用されます。この重い変換は、AWS Glue ジョブ、AWS Fargate タスク、Amazon EMR ステップ、Amazon SageMaker ノートブックへの同期呼び出しなど、計算コストの高いオペレーションです。テーブルメタデータは、AWS Glue カタログを更新する AWS Glue クローラを使用して出力ファイルから抽出されます。ファイルメタデータは DynamoDB の包括的なカタログテーブルにも追加されます。最後に、Deequ

を活用したデータ品質ステップも実行されます。

テクノロジースタック

Amazon CloudWatch イベント

AWS CloudFormation

AWS CodePipeline

AWS CodeBuild

AWS CodeCommit

Amazon DynamoDB

AWS Glue

AWS Lambda

Amazon S3

Amazon SQS

AWS Step Functions

ツール

Amazon CloudWatch Events – CloudWatch Events は、AWS リソースの変更を記述するシステムイベントのほぼリアルタイムのストリームを提供します。

CloudFormationAWS – CloudFormation は、AWS インフラストラクチャのデプロイを予測どおりに繰り返し作成およびプロビジョニングするのに役立ちます。

CodeBuildAWS – CodeBuild は、ソースコードをコンパイルし、ユニットテストを実行し、すぐにデプロイできるアーティファクトを生成するフルマネージドビルドサービスです。

CodeCommitAWS – CodeCommit は、AWS によってホストされるバージョン管理サービスで、アセット (ソースコードやバイナリファイルなど) をプライベートに保存および管理するために使用できます。

CodePipelineAWS – CodePipeline は、ソフトウェアの変更を継続的にリリースするために必要なステップをモデル化、視覚化、自動化するために使用できる継続的な配信サービスです。

Amazon DynamoDB – DynamoDB は、スケーラビリティを備えた高速で予測可能なパフォーマンスを提供するフルマネージド NoSQL データベースサービスです。

AWS Glue – AWS Glue は、分析用のデータの準備とロードを容易にするフルマネージド型の ETL サービスです。

AWS Lambda – Lambda は、サーバーのプロビジョニングや管理を行わずにコードの実行をサポートします。Lambda は必要に応じてコードを実行し、1 日あたり数個のリクエストから 1 秒あたり数千のリクエストまで自動的にスケールします。

Amazon S3 – Amazon Simple Storage Service (Amazon S3) は、拡張性の高いオブジェクトストレージサービスです。Amazon S3 は、ウェブサイト、モバイルアプリケーション、バックアップ、データレイクなど、幅広いストレージソリューションに使用できます。

AWS Step Functions - AWS Step Functions は、AWS Lambda 関数と複数の AWS サービスをビジネスクリティカルなアプリケーションに簡単にシーケンスできるようにするサーバーレス関数オーケストレーターです。

Amazon SQS – Amazon Simple Queue Service (Amazon SQS) は、マイクロサービス、分散システム、サーバーレスアプリケーションの分離とスケーリングに役立つフルマネージド型のメッセージキューイングサービスです。

Deequ

– Deequ は、大規模なデータセットのデータ品質メトリクスの計算、データ品質制約の定義と検証、データ分布の変化に関する最新情報の把握に役立つツールです。

コードリポジトリ

SDLF のソースコードとリソースは、AWS Labs GitHub リポジトリ

エピック

| タスク | 説明 | 必要なスキル |

|---|---|---|

データレイクの IaC を管理するための CI/CD パイプラインを設定します。 | AWS マネジメントコンソールにサインインし、SDLF ワークショップのhttps://sdlf.workshop.aws/en/10-deployment/100-setup.html | DevOps エンジニア |

| タスク | 説明 | 必要なスキル |

|---|---|---|

ローカルマシンで CodeCommit リポジトリのクローンを作成します。 | SDLF ワークショップの「基盤のデプロイ 詳細については、 CodeCommit ドキュメントの「Connecting toWord repositories」を参照してください。 CodeCommit | DevOps エンジニア |

CloudFormation テンプレートを変更します。 | ローカルワークステーションとコードエディタを使用して、ユースケースや要件に応じて CloudFormation テンプレートを変更します。それらをローカルにクローンされた Git リポジトリにコミットします。 詳細については、 CloudFormation AWS ドキュメントの「Word テンプレートの使用」を参照してください。 AWS CloudFormation | DevOps エンジニア |

変更を CodeCommit リポジトリにプッシュします。 | インフラストラクチャコードはバージョン管理下に置かれ、コードベースへの変更が追跡されるようになりました。Word CodeCommit リポジトリに変更をプッシュすると、 CodePipeline は自動的にインフラストラクチャに適用し、 CodeBuildに配信します。 重要: AWS SAM CLI in CodeBuild を使用する場合は、 コマンド | DevOps エンジニア |

関連リソース

IaC をプロビジョニングするため CI/CD パイプラインを設定する

IaC のバージョン管理

その他のリソース