Linux용 iSCSI 프로비저닝

ONTAP용 FSx는 iSCSI 프로토콜을 지원합니다. iSCSI 프로토콜을 사용하여 클라이언트와 파일 시스템 간에 데이터를 전송하려면 Linux 클라이언트와 파일 시스템 모두에서 iSCSI를 프로비저닝해야 합니다. iSCSI 프로토콜은 고가용성 페어(HA)가 6개 이하인 모든 파일 시스템에서 사용할 수 있습니다.

NetApp ONTAP용 Amazon FSx에서 iSCSI를 구성하는 세 가지 주요 단계는 다음 절차에서 다룹니다.

Linux 호스트에 iSCSI 클라이언트를 설치하고 구성합니다.

파일 시스템의 SVM에서 iSCSI를 구성합니다.

iSCSI 이니시에이터 그룹을 생성합니다.

이니시에이터 그룹을 LUN에 매핑합니다.

Linux 클라이언트에 iSCSI LUN 마운트

시작하기 전 준비 사항

iSCSI용 파일 시스템을 구성하는 프로세스를 시작하기 전에 다음 항목을 완료해야 합니다.

ONTAP용 FSx 파일 시스템을 생성합니다. 자세한 내용은 파일 시스템 만들기 섹션을 참조하세요.

파일 시스템에서 iSCSI LUN을 생성합니다. 자세한 내용은 iSCSI LUN 생성 단원을 참조하십시오.

파일 시스템과 동일한 VPC에서 Amazon Linux 2 AMI(Amazon 머신 이미지)를 실행하는 EC2 인스턴스를 생성합니다. iSCSI를 구성하고 파일 데이터에 액세스할 Linux 호스트입니다.

이러한 절차의 범위를 넘어 호스트가 다른 VPC에 있는 경우, VPC 피어링 또는 AWS Transit Gateway를 사용하여 다른 VPC에 볼륨의 iSCSI 엔드포인트에 대한 액세스 권한을 부여할 수 있습니다. 자세한 내용은 배포 VPC 외부에서 데이터 액세스 단원을 참조하십시오.

Amazon VPC를 사용한 파일 시스템 액세스 제어에 설명된 대로 인바운드 및 아웃바운드 트래픽을 허용하도록 Linux 호스트의 VPC 보안 그룹을 구성합니다.

ONTAP CLI에 액세스하는 데 사용할

fsxadmin권한이 있는 ONTAP 사용자의 자격 증명을 가져옵니다. 자세한 내용은 ONTAP 사용자 및 역할 단원을 참조하십시오.iSCSI용으로 구성하고 ONTAP용 FSx 파일 시스템에 액세스하는 데 사용할 Linux 호스트는 동일한 VPC와 AWS 계정에 있습니다.

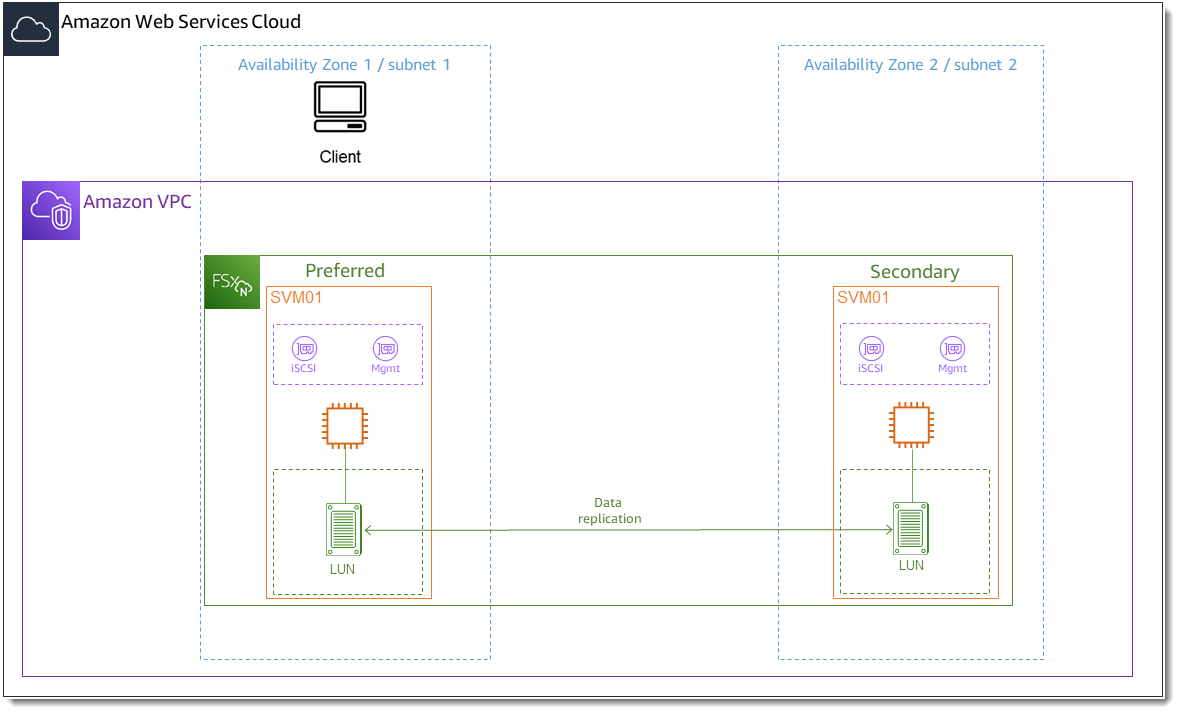

다음 그림과 같이 EC2 인스턴스는 파일 시스템의 기본 서브넷과 동일한 가용 영역에 배치하는 것이 좋습니다.

EC2 인스턴스가 Amazon Linux 2과 다른 Linux AMI를 실행하는 경우 이러한 절차 및 예제에 사용된 일부 유틸리티가 이미 설치되어 있을 수 있으며, 다른 명령을 사용하여 필요한 패키지를 설치할 수 있습니다. 패키지 설치 외에도 이 섹션에 사용된 명령은 다른 EC2 Linux AMI에도 유효합니다.

Linux 호스트에 iSCSI 설치 및 구성

iSCSI 클라이언트 설치

-

Linux 디바이스에

iscsi-initiator-utils및device-mapper-multipath가 설치되어 있는지 확인합니다. SSH 클라이언트를 사용하여 Linux 인스턴스에 연결합니다. 자세한 내용은 SSH를 사용하여 Linux 인스턴스에 연결을 참조하세요. 다음 명령을 사용하여

multipath와 iSCSI 클라이언트를 설치하세요. 파일 서버 간에 자동으로 장애 조치하려면multipath를 설치해야 합니다.~$sudo yum install -y device-mapper-multipath iscsi-initiator-utils-

multipath를 사용하는 경우 파일 서버 간에 자동으로 장애 조치할 때 응답 속도를 높이려면/etc/iscsi/iscsid.conf파일의 대체 제한 시간 값을 기본값인120대신5로 설정합니다.~$sudo sed -i 's/node.session.timeo.replacement_timeout = .*/node.session.timeo.replacement_timeout = 5/' /etc/iscsi/iscsid.conf; sudo cat /etc/iscsi/iscsid.conf | grep node.session.timeo.replacement_timeout iSCSI 서비스를 시작합니다.

~$sudo service iscsid start단, Linux 버전에 따라 다음 명령을 대신 사용해야 할 수도 있습니다.

~$sudo systemctl start iscsid-

다음 명령을 사용하여 에이전트가 실행 중인지 확인합니다.

~$sudo systemctl status iscsid.service시스템이 다음 출력으로 응답합니다.

iscsid.service - Open-iSCSI Loaded: loaded (/usr/lib/systemd/system/iscsid.service; disabled; vendor preset: disabled) Active: active (running) since Fri 2021-09-02 00:00:00 UTC; 1min ago Docs: man:iscsid(8) man:iscsiadm(8) Process: 14658 ExecStart=/usr/sbin/iscsid (code=exited, status=0/SUCCESS) Main PID: 14660 (iscsid) CGroup: /system.slice/iscsid.service ├─14659 /usr/sbin/iscsid └─14660 /usr/sbin/iscsid

Linux 클라이언트에 iSCSI 구성

-

클라이언트가 파일 서버 간에 자동으로 장애 조치할 수 있도록 하려면 다중 경로를 구성해야 합니다. 다음 명령을 사용합니다.

~$sudo mpathconf --enable --with_multipathd y -

다음 명령을 사용하여 Linux 호스트의 이니시에이터 이름을 확인합니다. 이니시에이터 이름의 위치는 iSCSI 유틸리티에 따라 다릅니다.

iscsi-initiator-utils를 사용하는 경우 이니시에이터 이름은/etc/iscsi/initiatorname.iscsi파일에 있습니다.~$sudo cat /etc/iscsi/initiatorname.iscsi시스템이 이니시에이터 이름으로 응답합니다.

InitiatorName=iqn.1994-05.com.redhat:abcdef12345

FSx for ONTAP 파일 시스템에 iSCSI 구성

-

다음 명령을 사용하여 iSCSI LUN을 생성한 FSx for ONTAP 파일 시스템의 NetApp ONTAP CLI에 연결합니다. 자세한 내용은 NetApp ONTAP CLI 사용 섹션을 참조하세요.

~$ssh fsxadmin@your_management_endpoint_ip -

NetApp ONTAP CLI lun igroup create

명령을 사용하여 이니시에이터 그룹( igroup)을 생성합니다. 이니시에이터 그룹은 iSCSI LUN에 매핑되며 LUN에 액세스할 수 있는 이니시에이터(클라이언트)를 제어합니다.host_initiator_name을 이전 절차에서 검색한 Linux 호스트의 이니시에이터 이름으로 바꿉니다.::>lun igroup create -vserversvm_nameigroup_name-initiatorhost_initiator_name-protocol iscsi -ostype linux이 igroup에 매핑된 LUN을 여러 호스트에서 사용할 수 있도록 하려면 여러 이니시에이터 이름을 쉼표로 구분하여 지정할 수 있습니다. 자세한 내용은 NetApp ONTAP 설명서 센터의 lun igroup 생성

을 참조하세요. -

lun igroup show

명령을 사용하여 igroup이 존재하는지 확인합니다.::>lun igroup show시스템이 다음 출력으로 응답합니다.

Vserver Igroup Protocol OS Type Initiators --------- ------------ -------- -------- ------------------------------------svm_nameigroup_nameiscsi linux iqn.1994-05.com.redhat:abcdef12345 -

이 단계에서는 이미 iSCSI LUN을 생성한 것으로 가정합니다. 아직 생성되지 않은 경우 단계별 지침으로 iSCSI LUN 생성 섹션을 참조하여 생성합니다.

lun mapping create

명령을 사용해서 다음 속성을 지정하여 생성된 LUN과 생성된 igroup 사이의 매핑을 생성합니다. -

svm_name -

vol_name -

lun_name -

igroup_name -

lun_id

::>lun mapping create -vserversvm_name-path /vol/vol_name/lun_name-igroupigroup_name-lun-idlun_id -

-

lun show -path명령을 사용하여 LUN이 생성되고 온라인 상태이며 매핑되었는지 확인합니다. ::>lun show -path /vol/vol_name/lun_name-fields state,mapped,serial-hex시스템이 다음 출력으로 응답합니다.

Vserver Path serial-hex state mapped --------- ------------------------------- ------------------------ -------- --------svm_name/vol/vol_name/lun_name6c5742314e5d52766e796150 online mappedserial_hex값(이 예제에서는6c5742314e5d52766e796150)을 저장하면, 이후 단계에서 이 값을 사용하여 블록 장치에 친숙한 이름을 만들 수 있습니다. -

network interface show -vserver명령을 사용하여 iSCSI LUN을 생성한 SVM의 iscsi_1및iscsi_2인터페이스 주소를 검색합니다.::>network interface show -vserversvm_name시스템이 다음 출력으로 응답합니다.

Logical Status Network Current Current Is Vserver Interface Admin/Oper Address/Mask Node Port Home ----------- ---------- ---------- ------------------ ------------- ------- ----svm_nameiscsi_1 up/up 172.31.0.143/20 FSxId0123456789abcdef8-01 e0e true iscsi_2 up/up 172.31.21.81/20 FSxId0123456789abcdef8-02 e0e true nfs_smb_management_1 up/up 198.19.250.177/20 FSxId0123456789abcdef8-01 e0e true 3 entries were displayed.이 예제에서

iscsi_1의 IP 주소는172.31.0.143이고iscsi_2의 IP 주소는172.31.21.81입니다.

Linux 클라이언트에 iSCSI LUN 마운트

Linux 클라이언트에 iSCSI LUN을 탑재하는 프로세스는 세 단계로 구성됩니다.

대상 iSCSI 노드 검색

iSCSI LUN 분할

클라이언트에 iSCSI LUN 탑재

이는 다음 절차에서 다룹니다.

대상 iSCSI 노드를 검색하려면

Linux 클라이언트에서

iscsi_1의 IP 주소인iscsi_1_IP를 사용하여 대상 iSCSI 노드를 검색하려면 다음 명령을 사용합니다.~$sudo iscsiadm --mode discovery --op update --type sendtargets --portaliscsi_1_IP172.31.0.143:3260,1029 iqn.1992-08.com.netapp:sn.9cfa2c41207a11ecac390182c38bc256:vs.3 172.31.21.81:3260,1028 iqn.1992-08.com.netapp:sn.9cfa2c41207a11ecac390182c38bc256:vs.3이 예제에서

iqn.1992-08.com.netapp:sn.9cfa2c41207a11ecac390182c38bc256:vs.3은 기본 가용성 영역에 있는 iSCSI LUN의target_initiator에 해당합니다.(선택 사항) Amazon EC2 단일 클라이언트 최대 처리량인 5Gb/s(~625MB/s)보다 더 높은 처리량을 iSCSI LUN으로 전송하려면 Linux 인스턴스용 Amazon Elastic Compute Cloud 사용자 가이드의 Amazon EC2 인스턴스 네트워크 대역폭에 설명된 절차에 따라 처리량 향상을 위한 추가 세션을 설정하세요.

다음 명령은 각 가용 영역에서 ONTAP 노드당 이니시에이터별로 8개의 세션을 설정하여 클라이언트가 iSCSI LUN에 최대 40Gb/s(5,000MB/s)의 총 처리량을 제공할 수 있도록 합니다.

~$sudo iscsiadm --mode node -Ttarget_initiator--op update -n node.session.nr_sessions -v 8대상 이니시에이터에 로그인합니다. iSCSI LUN이 사용 가능한 디스크로 표시됩니다.

~$sudo iscsiadm --mode node -Ttarget_initiator--loginLogging in to [iface: default, target: iqn.1992-08.com.netapp:sn.9cfa2c41207a11ecac390182c38bc256:vs.3, portal: 172.31.14.66,3260] (multiple) Login to [iface: default, target: iqn.1992-08.com.netapp:sn.9cfa2c41207a11ecac390182c38bc256:vs.3, portal: 172.31.14.66,3260] successful.위 출력은 잘렸습니다. 각 파일 서버의 세션마다

Logging in응답과Login successful응답이 하나씩 표시되어야 합니다. 노드당 세션이 4개인 경우 응답은Logging in8개와Login successful8개입니다.다음 명령을 사용하여

dm-multipath가 여러 정책이 있는 단일 LUN을 표시하여 iSCSI 세션을 식별하고 병합했는지 확인합니다.active로 나열된 디바이스와enabled로 나열된 디바이스 수가 같아야 합니다.~$sudo multipath -ll출력에서 디스크 이름은

dm-xyz와 같은 형식으로 지정됩니다. 여기서xyz는 정수입니다. 다른 멀티패스 디스크가 없는 경우 이 값은dm-0입니다.3600a09806c5742314e5d52766e79614fdm-xyzNETAPP ,LUN C-Mode size=10G features='4 queue_if_no_path pg_init_retries 50 retain_attached_hw_handle' hwhandler='0' wp=rw |-+- policy='service-time 0' prio=50 status=active | |- 0:0:0:1 sda 8:0 active ready running | |- 1:0:0:1 sdc 8:32 active ready running | |- 3:0:0:1 sdg 8:96 active ready running | `- 4:0:0:1 sdh 8:112 active ready running `-+- policy='service-time 0' prio=10 status=enabled |- 2:0:0:1 sdb 8:16 active ready running |- 7:0:0:1 sdf 8:80 active ready running |- 6:0:0:1 sde 8:64 active ready running `- 5:0:0:1 sdd 8:48 active ready running이제 블록 디바이스가 Linux 클라이언트에 연결되었습니다. 이는

/dev/경로에 있습니다. 이 경로를 관리 목적으로 사용해서는 안 됩니다. 대신 경로dm-xyz/dev/mapper/에 있는 심볼 링크를 사용합니다. 여기서wwidwwidwwid

블록 디바이스에 표시 이름을 할당하려면

/etc/multipath.conf파일에 별칭을 만들어 디바이스에 친숙한 이름을 지정합니다. 이렇게 하려면 선호하는 텍스트 편집기를 사용하여 다음 자리 표시자를 대체하여 파일에 다음 항목을 추가합니다.serial_hex를 FSx for ONTAP 파일 시스템에 iSCSI 구성 절차에서 저장한 값으로 바꿉니다.예제에 표시된 대로

serial_hex값에 접두사3600a0980을 추가합니다. 이것은Amazon FSx for NetApp ONTAP이 사용하는 NetApp ONTAP 배포판의 고유한 프리앰블입니다.device_name을 디바이스에 사용할 친숙한 이름으로 바꿉니다.

multipaths { multipath { wwid 3600a0980serial_hexaliasdevice_name} }또는 다음 스크립트를 bash 파일(예:

multipath_alias.sh)로 복사하여 저장할 수도 있습니다.serial_hexdevice_name/etc/multipath.conf파일에서 주석이 없는multipaths섹션을 검색합니다. 해당 항목이 있으면 해당 섹션에multipath항목이 추가됩니다. 없으면 블록 디바이스에multipath항목이 있는 새multipaths섹션이 생성됩니다.#!/bin/bash SN=serial_hex ALIAS=device_name CONF=/etc/multipath.conf grep -q '^multipaths {' $CONF UNCOMMENTED=$? if [ $UNCOMMENTED -eq 0 ] then sed -i '/^multipaths {/a\\tmultipath {\n\t\twwid 3600a0980'"${SN}"'\n\t\talias '"${ALIAS}"'\n\t}\n' $CONF else printf "multipaths {\n\tmultipath {\n\t\twwid 3600a0980$SN\n\t\talias $ALIAS\n\t}\n}" >> $CONF fimultipathd서비스를 다시 시작하여/etc/multipathd.conf의 변경 사항을 적용합니다.~$systemctl restart multipathd.service

LUN 파티션

다음 단계는 fdisk를 사용하여 LUN을 포맷하고 파티셔닝하는 것입니다.

-

다음 명령을 사용하여

device_name에 대한 경로가 있는지 확인합니다.~$ls /dev/mapper/device_name/dev/device_name fdisk를 사용하여 디스크를 파티셔닝합니다. 대화형 프롬프트가 나타날 것입니다. 표시된 순서대로 옵션을 입력합니다. 마지막 섹터보다 작은 값(이 예제에서는20971519)을 사용하여 여러 파티션을 만들 수 있습니다.참고

Last sector값은 iSCSI LUN의 크기(이 예에서는 10GB)에 따라 달라집니다.~$sudo fdisk /dev/mapper/device_namefsdisk대화형 프롬프트가 시작됩니다.Welcome to fdisk (util-linux 2.30.2). Changes will remain in memory only, until you decide to write them. Be careful before using the write command. Device does not contain a recognized partition table. Created a new DOS disklabel with disk identifier 0x66595cb0. Command (m for help):nPartition type p primary (0 primary, 0 extended, 4 free) e extended (container for logical partitions) Select (default p):pPartition number (1-4, default 1):1First sector (2048-20971519, default 2048):2048Last sector, +sectors or +size{K,M,G,T,P} (2048-20971519, default 20971519):20971519Created a new partition 1 of type 'Linux' and of size 512 B. Command (m for help):wThe partition table has been altered. Calling ioctl() to re-read partition table. Syncing disks.w를 입력하면 새 파티션/dev/mapper/을 사용할 수 있게 됩니다.partition_namepartition_name의 형식은<device_name><partition_number>입니다.1은 이전 단계의fdisk명령에 사용된 파티션 번호로 사용되었습니다.-

/dev/mapper/을 경로로 사용하여 파일 시스템을 생성합니다.partition_name~$sudo mkfs.ext4 /dev/mapper/partition_name시스템이 다음 출력으로 응답합니다.

mke2fs 1.42.9 (28-Dec-2013) Discarding device blocks: done Filesystem label= OS type: Linux Block size=4096 (log=2) Fragment size=4096 (log=2) Stride=0 blocks, Stripe width=16 blocks 655360 inodes, 2621184 blocks 131059 blocks (5.00%) reserved for the super user First data block=0 Maximum filesystem blocks=2151677952 80 block groups 32768 blocks per group, 32768 fragments per group 8192 inodes per group Superblock backups stored on blocks: 32768, 98304, 163840, 229376, 294912, 819200, 884736, 1605632 Allocating group tables: done Writing inode tables: done Creating journal (32768 blocks): done Writing superblocks and filesystem accounting information: done

Linux 클라이언트에 LUN 마운트

-

directory_path디렉터리를 파일 시스템의 마운트 지점으로 생성합니다.~$sudo mkdir /directory_path/mount_point -

다음 명령을 사용하여 파일 시스템을 마운트합니다.

~$sudo mount -t ext4 /dev/mapper/partition_name/directory_path/mount_point -

(선택 사항) 특정 사용자에게 탑재 디렉터리의 소유권을 부여하려면

username~$sudo chownusername:username/directory_path/mount_point -

(선택 사항) 파일 시스템에서 데이터를 읽고 쓸 수 있는지 확인합니다.

~$echo "Hello world!" > /directory_path/mount_point/HelloWorld.txt~$catdirectory_path/HelloWorld.txtHello world!Linux 클라이언트에 iSCSI LUN을 성공적으로 생성하고 마운트했습니다.