기계 번역으로 제공되는 번역입니다. 제공된 번역과 원본 영어의 내용이 상충하는 경우에는 영어 버전이 우선합니다.

AWS DataOps 개발 키트를 사용하여 Google Analytics 데이터를 수집, 변환 및 분석하는 데이터 파이프라인 구축

Anton Kukushkin 및 Rudy Puig, Amazon Web Services

요약

이 패턴은 AWS DataOps Development Kit(AWS DDK) 및 기타를 사용하여 Google Analytics 데이터를 수집, 변환 및 분석하는 데이터 파이프라인을 구축하는 방법을 설명합니다 AWS 서비스. AWS DDK는 데이터 워크플로와 최신 데이터 아키텍처를 구축하는 데 도움이 되는 오픈 소스 개발 프레임워크입니다 AWS. AWS DDK의 주요 목표 중 하나는 파이프라인 오케스트레이션, 인프라 구축, 해당 인프라 뒤의 DevOps 생성 등 일반적으로 노동 집약적인 데이터 파이프라인 작업에 할애하는 시간과 노력을 절약하는 것입니다. 이러한 노동 집약적인 작업을 AWS DDK로 오프로드하여 코드 작성 및 기타 고부가가치 활동에 집중할 수 있습니다.

사전 조건 및 제한 사항

사전 조건

제품 버전

Python 3.7 이상

pip 9.0.3 이상

아키텍처

기술 스택

Amazon AppFlow

Amazon Athena

Amazon CloudWatch

Amazon EventBridge

Amazon Simple Storage Service(S3)

Amazon Simple Queue Service(Amazon SQS)

AWS DataOps 개발 키트(AWS DDK)

AWS Lambda

대상 아키텍처

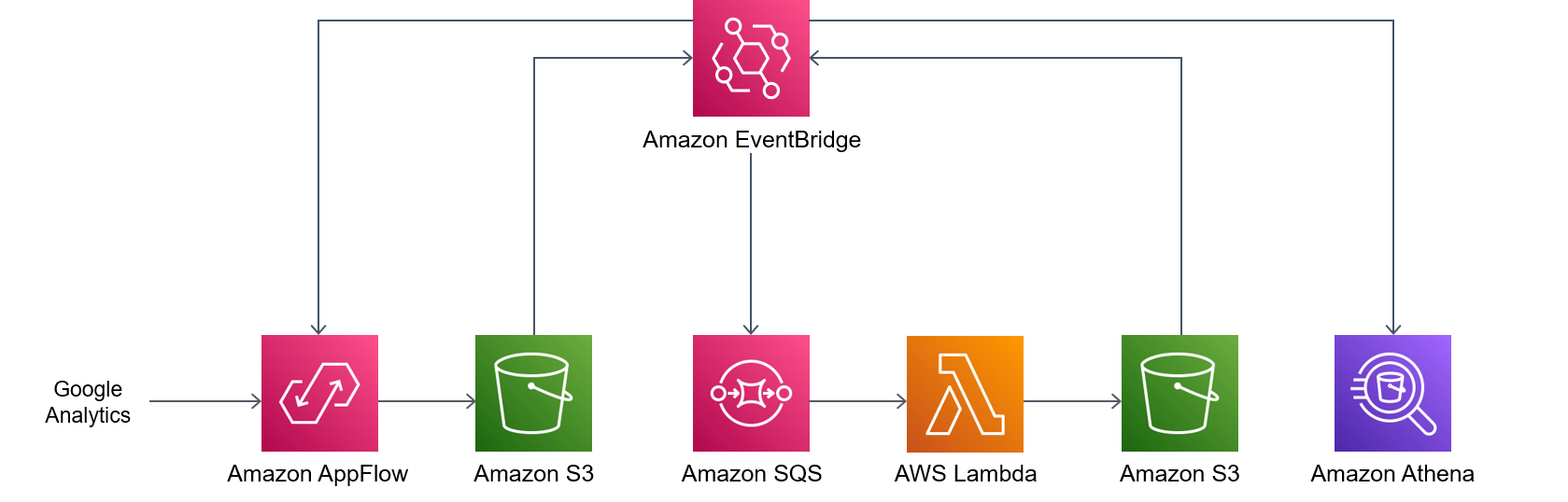

다음 다이어그램은 Google Analytics 데이터를 수집, 변환, 분석하는 이벤트 기반 프로세스를 보여줍니다.

이 다이어그램은 다음 워크플로를 보여줍니다.

Amazon CloudWatch 예약 이벤트 규칙은 Amazon AppFlow를 호출합니다.

Amazon AppFlow는 Google Analytics 데이터를 S3 버킷으로 수집합니다.

S3 버킷에서 데이터를 수집한 후, EventBridge의 이벤트 알림이 생성되고, CloudWatch 이벤트 규칙에 의해 캡처된 다음, Amazon SQS 대기열에 추가됩니다.

Lambda 함수는 Amazon SQS 대기열에서 이벤트를 사용하고, 각 S3 객체를 읽고, 객체를 Apache Parquet 형식으로 변환하고, 변환된 객체를 S3 버킷에 쓴 다음 AWS Glue Data Catalog 테이블 정의를 생성하거나 업데이트합니다.

Athena 쿼리는 테이블에 대해 실행됩니다.

도구

AWS 도구

Amazon AppFlow는 서비스형 소프트웨어(SaaS) 애플리케이션 간에 데이터를 안전하게 교환하는 데 사용할 수 있는 완전 관리형 통합 서비스입니다.

Amazon Athena는 표준 SQL을 사용하여 Amazon S3에 있는 데이터를 직접 분석할 수 있는 대화형 쿼리 서비스입니다.

Amazon CloudWatch를 사용하면 AWS 리소스 및에서 실행되는 애플리케이션의 지표를 실시간으로 모니터링할 AWS 수 있습니다.

Amazon EventBridge는 애플리케이션을 다양한 소스의 실시간 데이터와 연결할 수 있는 서버리스 이벤트 버스 서비스입니다. 예를 들어 AWS Lambda 함수, API 대상을 사용하는 HTTP 호출 엔드포인트 또는 다른의 이벤트 버스가 있습니다 AWS 계정.

Amazon Simple Storage Service(S3)는 원하는 양의 데이터를 저장, 보호 및 검색하는 데 도움이 되는 클라우드 기반 객체 스토리지 서비스입니다.

Amazon Simple Queue Service(Amazon SQS)는 내구력 있고 가용성이 뛰어난 보안 호스팅 대기열을 제공하며 이를 통해 분산 소프트웨어 시스템과 구성 요소를 통합 및 분리할 수 있습니다.

AWS Lambda는 서버를 프로비저닝하거나 관리할 필요 없이 코드를 실행하는 데 도움이 되는 컴퓨팅 서비스입니다. 필요할 때만 코드를 실행하며 자동으로 확장이 가능하므로 사용한 컴퓨팅 시간만큼만 비용을 지불합니다.

AWS 클라우드 개발 키트 (AWS CDK)는 코드에서 클라우드 인프라를 정의하고 이를 프로비저닝하기 위한 프레임워크입니다 AWS CloudFormation.

AWS DataOps Development Kit(AWS DDK)

는 데이터 워크플로와 최신 데이터 아키텍처를 구축하는 데 도움이 되는 오픈 소스 개발 프레임워크입니다 AWS.

코드

이 패턴의 코드는 GitHub AWS DataOps Development Kit(AWS DDK)

에픽

| 작업 | 설명 | 필요한 기술 |

|---|---|---|

소스 코드를 복제합니다. | 다음 명령을 실행하여 소스 코드를 빌드합니다.

| DevOps 엔지니어 |

가상 환경을 생성합니다. | 소스 코드 디렉터리로 이동한 후, 다음 명령을 실행하여 가상 환경을 생성합니다.

| DevOps 엔지니어 |

종속성을 설치합니다. | 가상 환경을 활성화하고 종속성을 설치하려면 다음 명령을 실행합니다.

| DevOps 엔지니어 |

| 작업 | 설명 | 필요한 기술 |

|---|---|---|

환경을 부트스트랩합니다. |

| DevOps 엔지니어 |

데이터를 배포합니다. | 데이터 파이프라인을 배포하려면 | DevOps 엔지니어 |

| 작업 | 설명 | 필요한 기술 |

|---|---|---|

스택 상태를 확인합니다. |

| DevOps 엔지니어 |

문제 해결

| 문제 | Solution |

|---|---|

| Google Analytics용 Amazon AppFlow 커넥터를 만들고 이름을 지침은 Amazon AppFlow 설명서의 Google Analytics를 참고하십시오. |

관련 리소스

AWS DDK 예제

(GitHub)

추가 정보

AWS DDK 데이터 파이프라인은 하나 이상의 단계로 구성됩니다. 다음 코드 예제에서는 AppFlowIngestionStage를 사용하여 Google Analytics에서 데이터를 수집하고, SqsToLambdaStage를 사용하여 데이터 변환을 처리하고, AthenaSQLStage를 사용하여 Athena 쿼리를 실행합니다.

먼저 다음과 같은 코드 예제에서 볼 수 있듯이 데이터 변환 및 수집 단계가 생성됩니다.

appflow_stage = AppFlowIngestionStage( self, id="appflow-stage", flow_name=flow.flow_name, ) sqs_lambda_stage = SqsToLambdaStage( self, id="lambda-stage", lambda_function_props={ "code": Code.from_asset("./ddk_app/lambda_handlers"), "handler": "handler.lambda_handler", "layers": [ LayerVersion.from_layer_version_arn( self, id="layer", layer_version_arn=f"arn:aws:lambda:{self.region}:336392948345:layer:AWSDataWrangler-Python39:1", ) ], "runtime": Runtime.PYTHON_3_9, }, ) # Grant lambda function S3 read & write permissions bucket.grant_read_write(sqs_lambda_stage.function) # Grant Glue database & table permissions sqs_lambda_stage.function.add_to_role_policy( self._get_glue_db_iam_policy(database_name=database.database_name) ) athena_stage = AthenaSQLStage( self, id="athena-sql", query_string=[ ( "SELECT year, month, day, device, count(user_count) as cnt " f"FROM {database.database_name}.ga_sample " "GROUP BY year, month, day, device " "ORDER BY cnt DESC " "LIMIT 10; " ) ], output_location=Location( bucket_name=bucket.bucket_name, object_key="query-results/" ), additional_role_policy_statements=[ self._get_glue_db_iam_policy(database_name=database.database_name) ], )

다음으로, 아래의 코드 예제에서 볼 수 있듯이 이 DataPipeline 구성은 EventBridge 규칙을 사용하여 스테이지를 함께 “연결”하는 데 사용됩니다.

( DataPipeline(self, id="ingestion-pipeline") .add_stage( stage=appflow_stage, override_rule=Rule( self, "schedule-rule", schedule=Schedule.rate(Duration.hours(1)), targets=appflow_stage.targets, ), ) .add_stage( stage=sqs_lambda_stage, # By default, AppFlowIngestionStage stage emits an event after the flow run finishes successfully # Override rule below changes that behavior to call the the stage when data lands in the bucket instead override_rule=Rule( self, "s3-object-created-rule", event_pattern=EventPattern( source=["aws.s3"], detail={ "bucket": {"name": [bucket.bucket_name]}, "object": {"key": [{"prefix": "ga-data"}]}, }, detail_type=["Object Created"], ), targets=sqs_lambda_stage.targets, ), ) .add_stage(stage=athena_stage) )

자세한 코드 예제는 GitHub Analyzing Google Analytics data with Amazon AppFlow, Amazon Athena, and AWS DataOps Development Kit