As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Não há uma definição universalmente aceita do que é um modelo interpretável ou de quais informações são adequadas como interpretação de um modelo. Este guia se concentra na noção comumente usada de importância do atributo, em que uma pontuação de importância para cada atributo de entrada é usada para interpretar como isso afeta as saídas do modelo. Esse método fornece informações, mas também requer cautela. As pontuações de importância dos atributos podem ser enganosas e devem ser analisadas cuidadosamente, incluindo a validação com especialistas no assunto, se possível. Especificamente, recomendamos que você não confie nas pontuações de importância dos atributos sem verificação, pois interpretações errôneas podem levar a decisões comerciais inadequadas.

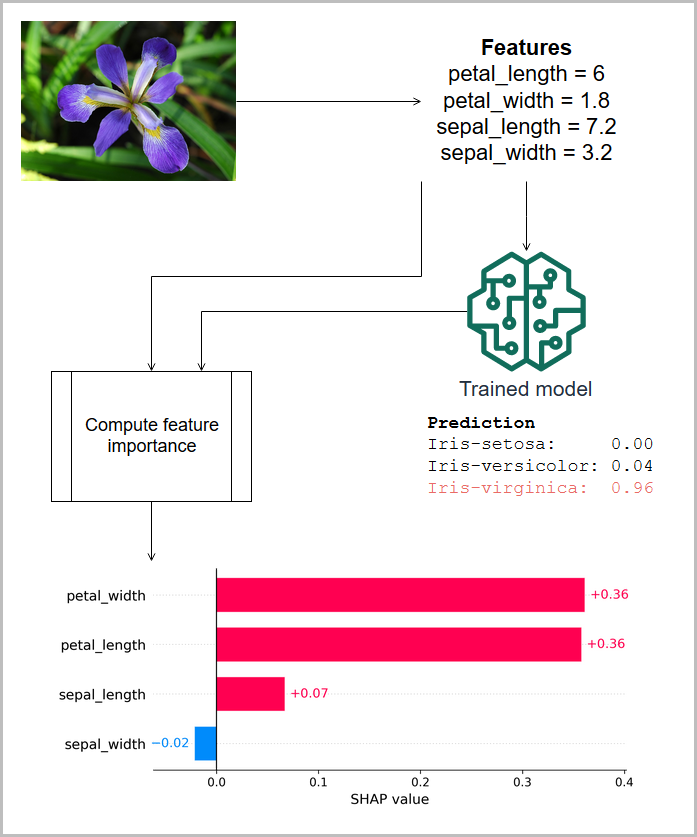

Na ilustração a seguir, os atributos medidos de uma íris são passados para um modelo que prevê a espécie da planta e as importâncias dos atributos associados (atribuições SHAP) para essa previsão são exibidas. Nesse caso, o comprimento da pétala, a largura da pétala e o comprimento da sépala contribuem positivamente para a classificação da Iris virginica, mas a largura da sépala tem uma contribuição negativa. (Essas informações são baseadas no conjunto de dados da íris de [4].)

As pontuações de importância do atributo podem ser globais, indicando que a pontuação é válida para o modelo em todas as entradas, ou locais, indicando que a pontuação se aplica a uma única saída do modelo. As pontuações de importância de atributos locais geralmente são escaladas e somadas para produzir o valor de saída do modelo e, portanto, são denominadas atribuições. Modelos simples são considerados mais interpretáveis porque os efeitos dos atributos de entrada na saída do modelo são mais facilmente compreendidos. Por exemplo, em um modelo de regressão linear, as magnitudes dos coeficientes fornecem uma pontuação global de importância do atributo e, para uma determinada previsão, a atribuição de um atributo local é o produto de seu coeficiente pelo valor do atributo. Na ausência de uma pontuação de importância direta do atributo local para uma previsão, você pode calcular uma pontuação de importância a partir de um conjunto de atributos de entrada da linha de base para entender como um atributo contribui em relação à linha de base.