As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Relatório de explicabilidade

O Amazon SageMaker Autopilot fornece um relatório de explicabilidade para ajudar a explicar como o melhor candidato a modelo faz previsões para problemas de classificação de imagens. Esse relatório pode ajudar engenheiros de ML, gerentes de produto e outras partes interessadas internas a entender as características do modelo. Tanto os consumidores quanto os reguladores confiam na transparência de machine learning para confiar e interpretar as decisões tomadas com base nas previsões do modelo. Você pode usar essas explicações para auditar e atender aos requisitos regulatórios, estabelecer confiança no modelo, apoiar a tomada de decisões humanas e depurar e melhorar a performance do modelo.

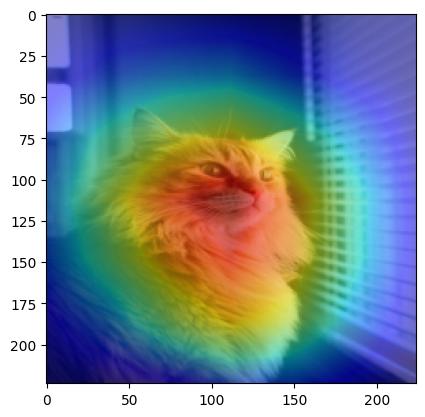

A funcionalidade explicativa do piloto automático para classificação de imagens usa uma abordagem de mapa de ativação de classe visual (CAM) que produz um mapa de calor em que a distribuição e a intensidade de cada cor destacam as áreas de uma imagem que mais contribuem para uma previsão específica. Essa abordagem se baseia nos principais componentes derivados de uma implementação do Eigen

O piloto automático gera o relatório de explicabilidade como um arquivo. JSON O relatório inclui detalhes da análise com base no conjunto de dados de validação. Cada imagem usada para gerar o relatório contém as seguintes informações:

-

input_image_uri: O Amazon S3 URI para a imagem de entrada tomada como entrada para o mapa de calor. -

heatmap_image_uri: Do Amazon S3 URI à imagem do mapa de calor gerada pelo Autopilot. -

predicted_label: A classe de etiqueta prevista pelo melhor modelo treinado pelo Autopilot. -

probability: A confiança com que opredicted_labelfoi previsto.

Você pode encontrar o prefixo Amazon S3 para os artefatos de explicabilidade gerados para o melhor candidato na resposta a DescribeAutoMLJobV2 em BestCandidate.CandidateProperties.CandidateArtifactLocations.Explainability.

Os exemplos a seguir ilustram a aparência dos mapas de calor em algumas amostras do Oxford-Pet

| Imagem de entrada | Imagem do mapa de calor |

|---|---|

|

|

|

|