本文属于机器翻译版本。若本译文内容与英语原文存在差异,则一律以英文原文为准。

SageMaker AI XGBoost 算法的工作原理

XGBoost

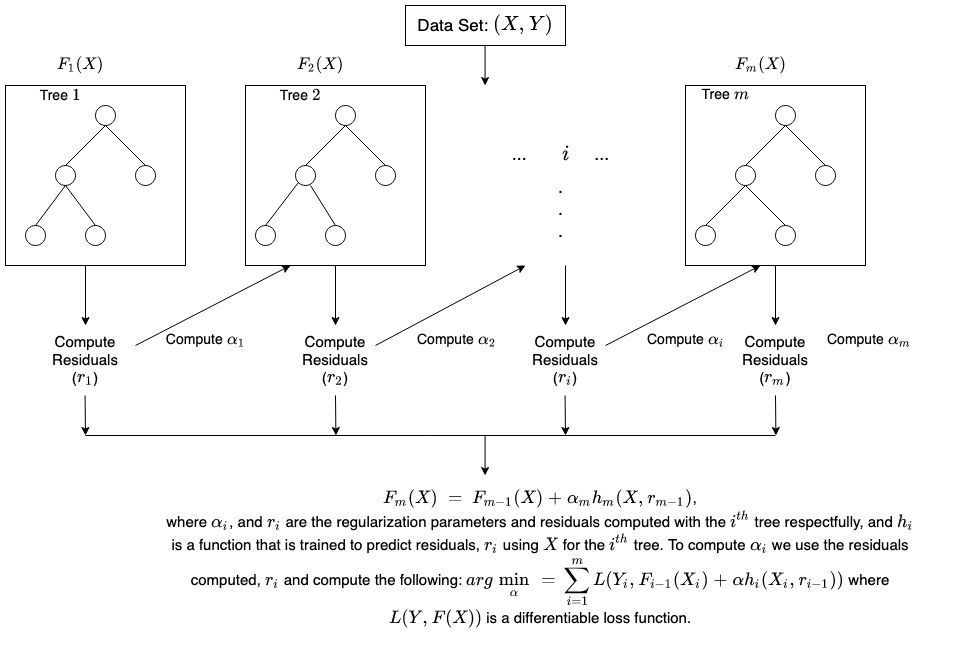

使用梯度提升

下面是关于梯度树提升工作原理的简要说明。

有关更多详细信息 XGBoost,请参阅:

本文属于机器翻译版本。若本译文内容与英语原文存在差异,则一律以英文原文为准。

XGBoost

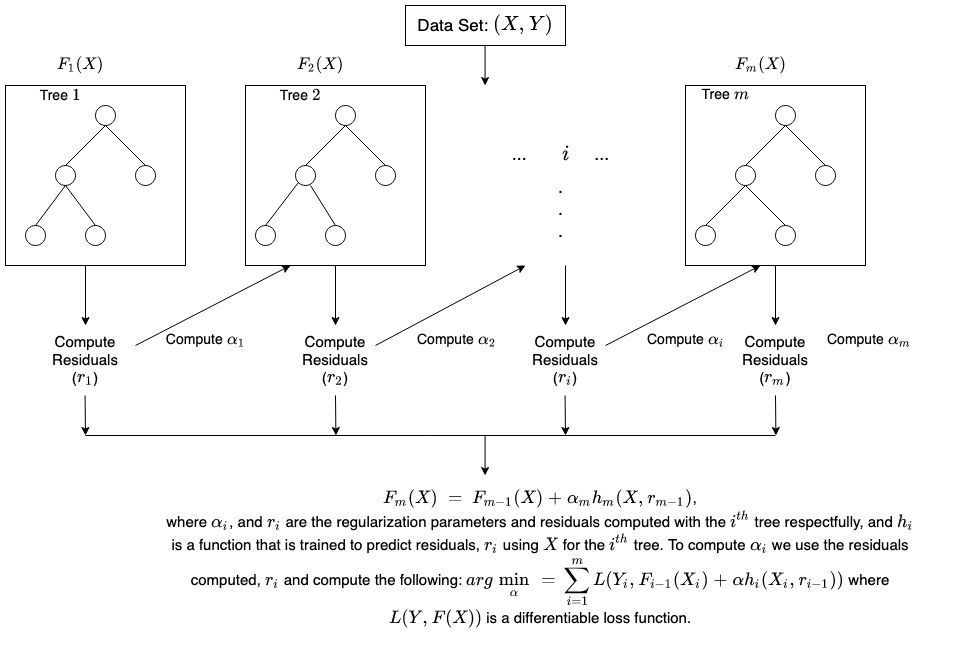

使用梯度提升

下面是关于梯度树提升工作原理的简要说明。

有关更多详细信息 XGBoost,请参阅: