AWS Data Pipeline ist für Neukunden nicht mehr verfügbar. Bestandskunden von AWS Data Pipeline können den Service weiterhin wie gewohnt nutzen. Weitere Informationen

Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Was ist AWS Data Pipeline?

Anmerkung

AWS Data Pipeline Der Service befindet sich im Wartungsmodus und es sind keine neuen Funktionen oder Regionserweiterungen geplant. Weitere Informationen und Informationen zur Migration Ihrer vorhandenen Workloads finden Sie unter. Migration von Workloads von AWS Data Pipeline

AWS Data Pipeline ist ein Webservice, mit dem Sie die Bewegung und Transformation von Daten automatisieren können. Mit AWS Data Pipeline können Sie datengesteuerte Workflows definieren, sodass Aufgaben vom erfolgreichen Abschluss früherer Aufgaben abhängig sein können. Sie definieren die Parameter Ihrer Datentransformationen und setzen AWS Data Pipeline die von Ihnen eingerichtete Logik durch.

Die folgenden Komponenten von AWS Data Pipeline arbeiten zusammen, um Ihre Daten zu verwalten:

-

Eine Pipeline-Definition legt die geschäftliche Logik der Datenverwaltung fest. Weitere Informationen finden Sie unter Syntax der Pipeline-Definitionsdatei.

-

Eine Pipeline plant und führt Aufgaben aus, indem sie EC2 Amazon-Instances zur Ausführung der definierten Arbeitsaktivitäten erstellt. Sie müssen nur die Pipeline-Definition in die Pipeline hochladen und diese anschließend aktivieren. Sie können auch die Pipeline-Definition einer gerade ausgeführten Pipeline bearbeiten. Sie müssen die Pipeline dann nur erneut aktivieren, damit die Änderungen wirksam werden. Außerdem können Sie die Pipeline deaktivieren, eine Datenquelle ändern und dann die Pipeline erneut aktivieren. Wenn Sie die Pipeline nicht mehr benötigen, können Sie sie löschen.

-

Task Runner fragt nach Aufgaben ab und führt diese Aufgaben dann aus. Task Runner könnte zum Beispiel Protokolldateien in Amazon S3 kopieren und Amazon-EMR-Cluster starten. Task Runner ist installiert und wird automatisch auf Ressourcen ausgeführt, die durch Ihre Pipeline-Definitionen erstellt wurden. Sie können eine benutzerdefinierte Task Runner-Anwendung schreiben oder die Task Runner-Anwendung verwenden, die von bereitgestellt wird AWS Data Pipeline. Weitere Informationen finden Sie unter Task Runner.

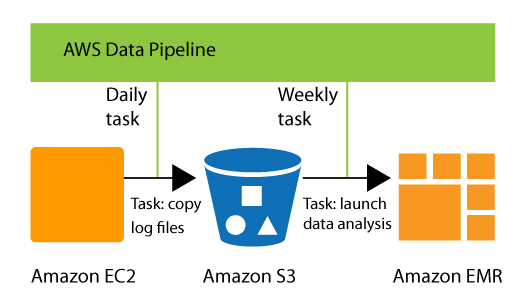

Sie können es beispielsweise verwenden, AWS Data Pipeline um die Protokolle Ihres Webservers jeden Tag in Amazon Simple Storage Service (Amazon S3) zu archivieren und dann einen wöchentlichen Amazon EMR-Cluster (Amazon EMR) über diese Protokolle laufen zu lassen, um Verkehrsberichte zu generieren. AWS Data Pipeline plant die täglichen Aufgaben zum Kopieren von Daten und die wöchentliche Aufgabe zum Starten des Amazon EMR-Clusters. AWS Data Pipeline stellt außerdem sicher, dass Amazon EMR wartet, bis die Daten des letzten Tages auf Amazon S3 hochgeladen wurden, bevor es mit der Analyse beginnt, auch wenn es zu unvorhergesehenen Verzögerungen beim Hochladen der Protokolle kommt.

Inhalt

Zugreifen AWS Data Pipeline

Sie können Ihre Pipelines über die folgenden Schnittstellen erstellen und verwalten:

-

AWS Management Console— Bietet eine Webschnittstelle für den Zugriff AWS Data Pipeline.

-

AWS Command Line Interface (AWS CLI) — Bietet Befehle für eine breite Palette von AWS-Services, einschließlich Windows, macOS und Linux AWS Data Pipeline, und wird unter Windows, macOS und Linux unterstützt. Weitere Informationen zur Installation von finden Sie unter AWS Command Line Interface

. AWS CLI Eine Liste der Befehle für AWS Data Pipeline finden Sie unter datapipeline. -

AWS SDKs — Bietet sprachspezifische Funktionen APIs und übernimmt viele der Verbindungsdetails, wie zum Beispiel die Berechnung der Signaturen, die Verarbeitung des erneuten Absendens von Anforderungen und die Fehlerbehandlung. Weitere Informationen finden Sie unter AWS SDKs

. -

Abfrage-API — Bietet Low-Level-APIs APIs , die Sie mithilfe von HTTPS-Anforderungen aufrufen. Die Verwendung der Abfrage-API ist die direkteste Möglichkeit für den Zugriff auf AWS Data Pipeline. Allerdings müssen dann viele technische Abläufe, wie beispielsweise das Erzeugen des Hashwerts zum Signieren der Anforderung und die Fehlerbehandlung, in der Anwendung durchgeführt werden. Weitere Informationen finden Sie in der AWS Data Pipeline -API-Referenz.

Preisgestaltung

Mit Amazon Web Services bezahlen Sie nur für das, was Sie tatsächlich nutzen. Denn AWS Data Pipeline Sie zahlen für Ihre Pipeline auf der Grundlage, wie oft und wo Ihre Aktivitäten und Voraussetzungen für die Ausführung geplant sind. Weitere Informationen finden Sie unter AWS Data Pipeline – Preise

Wenn Ihr AWS-Konto jünger als 12 Monate ist, sind Sie zur Nutzung des kostenlosen Kontingents berechtigt. Das kostenlose Kontingent umfasst drei Vorbedingungen mit geringer Häufigkeit und fünf Aktivitäten mit geringer Häufigkeit pro Monat. Weitere Informationen finden Sie unter Kostenloses Kontingent für AWS