Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Verwenden Sie SageMaker Clarify, um Verzerrungen zu erklären und zu erkennen

In diesem Thema wird beschrieben, wie Fairness und Modellierbarkeit verstanden und wie Vorurteile mithilfe von Amazon Clarify erklärt und erkannt werden können. SageMaker Sie können einen SageMaker Clarif-Verarbeitungsauftrag so konfigurieren, dass Messwerte für Verzerrungen und Feature-Attributionen berechnet und Berichte zur Erklärbarkeit des Modells generiert werden. SageMaker Clarif-Verarbeitungsaufträge werden mithilfe eines speziellen SageMaker Clarif-Container-Images implementiert. Die folgenden Anweisungen zeigen Ihnen, wie Sie einen SageMaker Clarif-Verarbeitungsauftrag konfigurieren, ausführen und Fehler beheben und wie Sie eine Analyse konfigurieren.

Was bedeutet Fairness und Modellerklärbarkeit von Vorhersagen für maschinelles Lernen?

Modelle für maschinelles Lernen (ML) helfen dabei, Entscheidungen in Bereichen wie Finanzdienstleistungen, Gesundheitswesen, Bildung und Personalwesen zu treffen. Politische Entscheidungsträger, Aufsichtsbehörden und Befürworter haben das Bewusstsein für die ethischen und politischen Herausforderungen geschärft, die maschinelles Lernen und datengesteuerte Systeme mit sich bringen. Amazon SageMaker Clarify kann Ihnen helfen zu verstehen, warum Ihr ML-Modell eine bestimmte Vorhersage getroffen hat und ob sich diese Verzerrung während des Trainings oder der Inferenz auf diese Vorhersage auswirkt. SageMaker Clarify bietet auch Tools, mit denen Sie weniger voreingenommene und verständlichere Modelle für maschinelles Lernen erstellen können. SageMaker Clarify kann auch Modellberichte zur Unternehmensführung erstellen, die Sie Risiko- und Compliance-Teams sowie externen Aufsichtsbehörden zur Verfügung stellen können. Mit SageMaker Clarify können Sie Folgendes tun:

-

Erkennen Sie Verzerrungen und helfen Sie dabei, Ihre Modellvorhersagen zu erklären.

-

Identifizieren Sie die Arten von Verzerrungen in den Daten vor dem Training.

-

Identifizieren Sie Arten von Verzerrungen in Daten nach dem Training, die während des Trainings oder während der Produktion Ihres Modells auftreten können.

SageMaker Clarify hilft zu erklären, wie Ihre Modelle mithilfe von Feature-Attributionen Vorhersagen treffen. Es kann auch Inferenzmodelle, die sich in der Produktion befinden, sowohl auf Verzerrungen als auch auf Abweichungen bei der Merkmalszuweisung überwachen. Diese Informationen können Ihnen in den folgenden Bereichen helfen:

-

Regulatorisch — Politische Entscheidungsträger und andere Aufsichtsbehörden können Bedenken haben, dass Entscheidungen, die Ergebnisse von ML-Modellen verwenden, diskriminierende Auswirkungen haben. Ein ML-Modell kann beispielsweise Verzerrungen kodieren und eine automatisierte Entscheidung beeinflussen.

-

Wirtschaft — Regulierte Bereiche benötigen möglicherweise zuverlässige Erklärungen dafür, wie ML-Modelle Vorhersagen treffen. Die Erklärbarkeit von Modellen kann für Branchen, die auf Zuverlässigkeit, Sicherheit und Konformität angewiesen sind, besonders wichtig sein. Dazu können Finanzdienstleistungen, Personalwesen, Gesundheitswesen und automatisiertes Transportwesen gehören. Beispielsweise müssen Kreditanträge möglicherweise Erläuterungen dazu enthalten, wie ML-Modelle bestimmte Prognosen für Kreditsachbearbeiter, Prognostiker und Kunden getroffen haben.

-

Datenwissenschaft — Datenwissenschaftler und ML-Ingenieure können ML-Modelle debuggen und verbessern, wenn sie feststellen können, ob ein Modell auf der Grundlage verrauschter oder irrelevanter Merkmale Schlüsse zieht. Sie können auch die Einschränkungen ihrer Modelle und die Fehlerquellen verstehen, auf die ihre Modelle stoßen können.

Einen Blogbeitrag, der zeigt, wie man ein vollständiges Machine-Learning-Modell für betrügerische Automobilschadensfälle konzipiert und erstellt, das SageMaker Clarify in eine SageMaker Pipeline integriert, finden Sie unter The Architect und erstellen Sie den gesamten Machine-Learning-Lebenszyklus mit AWS: einer end-to-end SageMaker Amazon-Demo

Bewährte Methoden zur Bewertung von Fairness und Erklärbarkeit im ML-Lebenszyklus

Fairness als Prozess — Begriffe wie Voreingenommenheit und Fairness hängen von ihrer Anwendung ab. Die Messung von Voreingenommenheit und die Wahl der Messgrößen für Voreingenommenheit können sich an sozialen, rechtlichen und anderen nichttechnischen Überlegungen orientieren. Die erfolgreiche Einführung fairnessorientierter ML-Ansätze beinhaltet die Konsensbildung und die Zusammenarbeit zwischen den wichtigsten Interessengruppen. Dazu können Produkt-, Richtlinien-, Rechts-, Technik-, KI/ML-Teams, Endbenutzer und Gemeinschaften gehören.

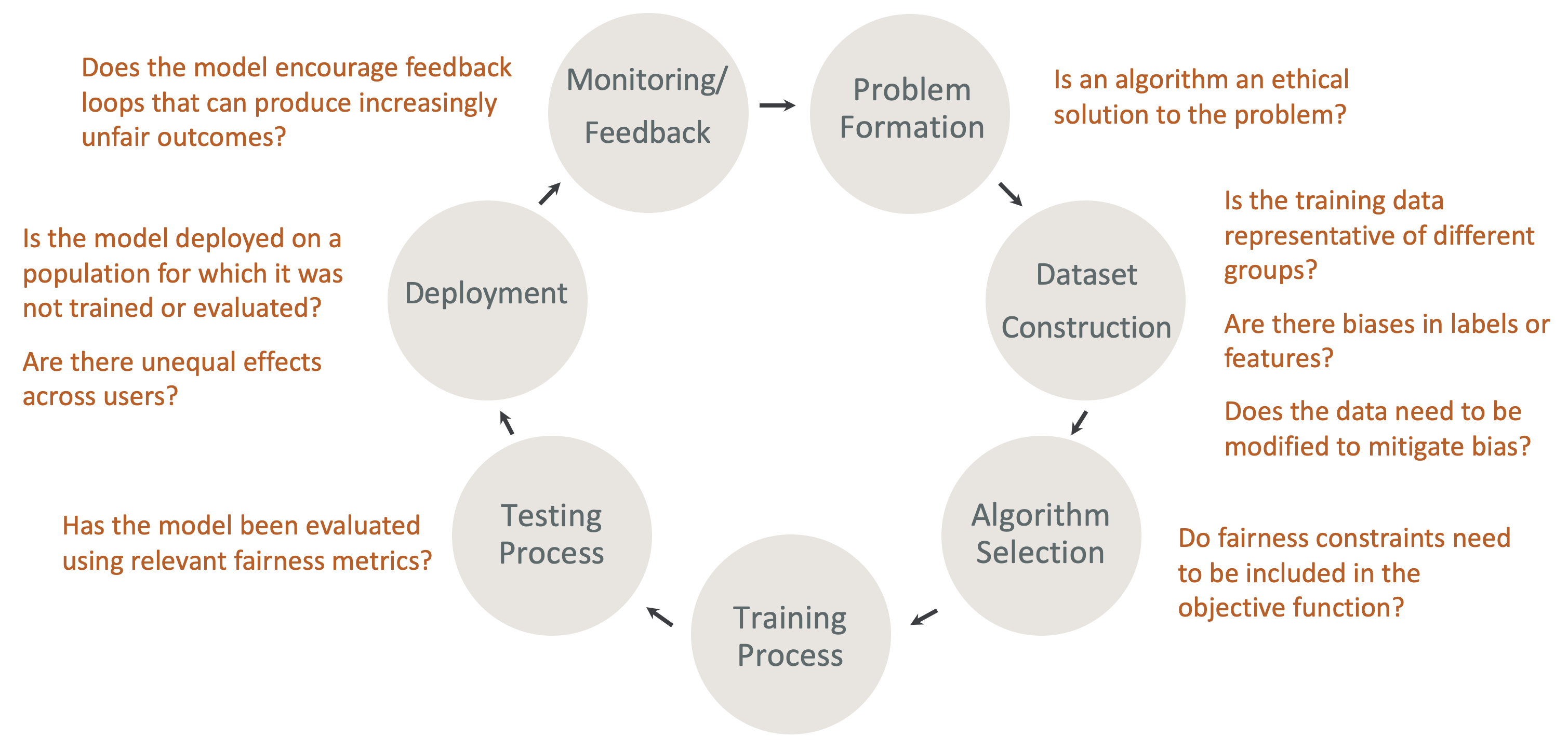

Fairness und erklärbare Gestaltung im ML-Lebenszyklus — Berücksichtigen Sie Fairness und Erklärbarkeit in jeder Phase des ML-Lebenszyklus. Zu diesen Phasen gehören die Problemerstellung, die Erstellung von Datensätzen, die Auswahl der Algorithmen, der Modelltrainingsprozess, der Testprozess, die Bereitstellung sowie die Überwachung und das Feedback. Für diese Analyse ist es wichtig, über die richtigen Tools zu verfügen. Wir empfehlen, während des ML-Lebenszyklus die folgenden Fragen zu stellen:

-

Fördert das Modell Rückkopplungsschleifen, die zu zunehmend unfairen Ergebnissen führen können?

-

Ist ein Algorithmus eine ethische Lösung für das Problem?

-

Sind die Trainingsdaten repräsentativ für verschiedene Gruppen?

-

Gibt es Verzerrungen bei Bezeichnungen oder Merkmalen?

-

Müssen die Daten geändert werden, um Verzerrungen zu verringern?

-

Müssen Fairnessbeschränkungen in die Zielfunktion aufgenommen werden?

-

Wurde das Modell anhand relevanter Fairness-Kennzahlen bewertet?

-

Gibt es ungleiche Auswirkungen auf die einzelnen Nutzer?

-

Wird das Modell in einer Population eingesetzt, für die es nicht trainiert oder evaluiert wurde?

Leitfaden zu den SageMaker Erläuterungen und zur Dokumentation der Vorurteile

Verzerrungen können sowohl vor als auch nach dem Training eines Modells auftreten und in den Daten gemessen werden. SageMaker Clarify kann Erklärungen für Modellvorhersagen nach dem Training und für Modelle liefern, die in der Produktion eingesetzt werden. SageMaker Clarify kann auch Modelle, die sich in der Produktion befinden, auf Abweichungen bei ihren grundlegenden erklärenden Attributen hin überwachen und bei Bedarf Basiswerte berechnen. Die Dokumentation zur Erklärung und Erkennung von Verzerrungen mithilfe von SageMaker Clarify ist wie folgt strukturiert:

-

Informationen zur Einrichtung eines Verarbeitungsjobs für Verzerrungen und Erklärbarkeit finden Sie unter. Einen SageMaker Clarif-Verarbeitungsjob konfigurieren

-

Informationen zur Erkennung von Verzerrungen bei der Vorverarbeitung von Daten, bevor sie zum Trainieren eines Modells verwendet werden, finden Sie unter. Erkennen Sie Datenverzerrungen Bias vor dem Training

-

Informationen zur Erkennung von Daten nach dem Training und Modellverzerrungen finden Sie unter. Erkennen Sie Daten nach dem Training und modellieren Sie Verzerrungen

-

Informationen zum modellunabhängigen Ansatz der Merkmalszuweisung zur Erklärung von Modellvorhersagen nach dem Training finden Sie unter. Erklärbarkeit des Modells

-

Informationen zur Überwachung, ob der Beitrag von Merkmalen vom Basiswert abweicht, der während des Modelltrainings festgelegt wurde, finden Sie unter. Überwachen Sie die Abweichung bei der Featureszuweisung für Modelle in der Produktion

-

Informationen zur Überwachung von Modellen, die sich in der Produktion befinden, im Hinblick auf Abweichungen vom Ausgangswert finden Sie unterÜberwachen Sie Verzerrungen bei Modellen in der Produktion.

-

Hinweise zum Abrufen von Erklärungen in Echtzeit von einem SageMaker Endpunkt finden Sie unterOnline-Erklärbarkeit mit Clarify SageMaker .

Wie SageMaker Clarify Processing Jobs funktionieren

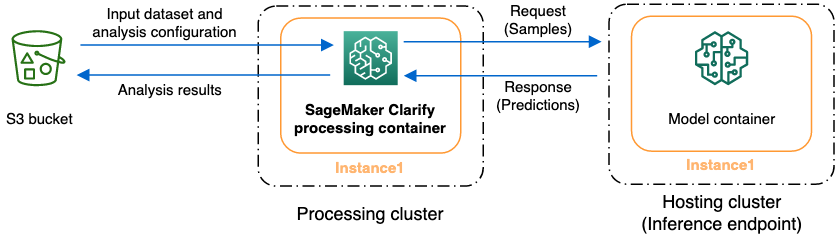

Sie können SageMaker Clarify verwenden, um Ihre Datensätze und Modelle auf Erklärbarkeit und Verzerrungen zu analysieren. Ein SageMaker Clarif-Verarbeitungsauftrag verwendet den SageMaker Clarif-Verarbeitungscontainer, um mit einem Amazon S3 S3-Bucket zu interagieren, der Ihre Eingabedatensätze enthält. Sie können SageMaker Clarify auch verwenden, um ein Kundenmodell zu analysieren, das auf einem SageMaker Inferenzendpunkt bereitgestellt wird.

Die folgende Grafik zeigt, wie ein SageMaker Clarif-Verarbeitungsjob mit Ihren Eingabedaten und optional mit einem Kundenmodell interagiert. Diese Interaktion hängt von der spezifischen Art der durchgeführten Analyse ab. Der SageMaker Clarify-Verarbeitungscontainer bezieht den Eingabedatensatz und die Konfiguration für die Analyse aus einem S3-Bucket. Für bestimmte Analysetypen, einschließlich der Merkmalsanalyse, muss SageMaker der Clarifesty-Verarbeitungscontainer Anfragen an den Modellcontainer senden. Anschließend ruft er die Modellvorhersagen aus der Antwort ab, die der Modellcontainer sendet. Danach berechnet der SageMaker Clarify-Verarbeitungscontainer die Analyseergebnisse und speichert sie im S3-Bucket.

Sie können einen SageMaker Clarif-Verarbeitungsauftrag in mehreren Phasen des Lebenszyklus des maschinellen Lernens ausführen. SageMaker Clarify kann Ihnen bei der Berechnung der folgenden Analysetypen helfen:

-

Messwerte zu Verzerrungen vor dem Training Diese Metriken können Ihnen helfen, die Verzerrung in Ihren Daten zu verstehen, sodass Sie sie beheben und Ihr Modell anhand eines faireren Datensatzes trainieren können. Informationen zu Messwerten Messen Sie die Voreingenommenheit vor dem Training für Verzerrungen vor dem Training finden Sie unter. Um einen Job zur Analyse von Verzerrungsmetriken vor dem Training auszuführen, müssen Sie den Datensatz und eine JSON Analysekonfigurationsdatei für die Analyse bereitstellen. Konfigurieren Sie die Analyse

-

Messwerte für Verzerrungen nach dem Training. Diese Metriken können Ihnen helfen, jegliche Verzerrungen zu verstehen, die durch einen Algorithmus, durch Hyperparameter-Entscheidungen oder durch Verzerrungen verursacht wurden, oder jegliche Verzerrungen, die zu einem früheren Zeitpunkt nicht offensichtlich waren. Weitere Informationen zu Messgrößen für Verzerrungen nach dem Training finden Sie unter. Messen Sie Daten nach dem Training und modellieren Sie Verzerrungen SageMaker Clarify verwendet die Modellvorhersagen zusätzlich zu den Daten und Bezeichnungen, um Verzerrungen zu identifizieren. Um einen Job zur Analyse von Verzerrungsmetriken nach dem Training auszuführen, müssen Sie den Datensatz und eine JSON Analysekonfigurationsdatei bereitstellen. Die Konfiguration sollte den Modell- oder Endpunktnamen enthalten.

-

Formschöne Werte, anhand derer Sie besser verstehen können, welchen Einfluss Ihr Merkmal auf die Prognosen Ihres Modells hat. Weitere Informationen zu Shapely-Werten finden Sie unter. Feature-Attributionen, die Shapley-Werte verwenden Für diese Funktion ist ein trainiertes Modell erforderlich.

-

Partielle Abhängigkeitsdiagramme (PDPs), anhand derer Sie besser verstehen können, wie stark sich Ihre vorhergesagte Zielvariable ändern würde, wenn Sie den Wert eines Merkmals variieren würden. Weitere Informationen zu finden Sie PDPs unter Für Analyse partieller Abhängigkeitsdiagramme (PDPs) diese Funktion ist ein trainiertes Modell erforderlich.

SageMaker Clarify benötigt Modellvorhersagen, um Messwerte und Merkmalszuordnungen nach dem Training berechnen zu können. Sie können einen Endpunkt angeben oder SageMaker Clarify erstellt anhand Ihres Modellnamens einen kurzlebigen Endpunkt, der auch als Schattenendpunkt bezeichnet wird. Der SageMaker Clarith-Container löscht den Schattenendpunkt, nachdem die Berechnungen abgeschlossen sind. Auf hoher Ebene führt der SageMaker Clarith-Container die folgenden Schritte aus:

-

Überprüft Eingaben und Parameter.

-

Erzeugt den Schattenendpunkt (falls ein Modellname angegeben wird).

-

Lädt den Eingabedatensatz in einen Datenrahmen.

-

Ruft bei Bedarf Modellvorhersagen vom Endpunkt ab.

-

Berechnet Messwerte für Verzerrungen und Merkmalszuschreibungen.

-

Löscht den Schattenendpunkt.

-

Generieren Sie die Analyseergebnisse.

Nach Abschluss SageMaker des Clarif-Verarbeitungsauftrags werden die Analyseergebnisse an dem Ausgabeort gespeichert, den Sie im Verarbeitungsausgabeparameter des Jobs angegeben haben. Zu diesen Ergebnissen gehören eine JSON Datei mit Messwerten und globalen Feature-Attributionen, ein grafischer Bericht und zusätzliche Dateien für lokale Feature-Attributionen. Sie können die Ergebnisse vom Ausgabespeicherort herunterladen und anzeigen.

Weitere Informationen zu Bias-Metriken, Erklärbarkeit und deren Interpretation finden Sie unter Erfahren Sie, wie Amazon SageMaker Clarify hilft, Verzerrungen zu erkennen

Beispiel-Notebooks

Die folgenden Abschnitte enthalten Notizbücher, die Ihnen den Einstieg in die Verwendung von SageMaker Clarify, die Verwendung von Clarify für spezielle Aufgaben, einschließlich Aufgaben innerhalb eines verteilten Jobs, und für Computer Vision erleichtern sollen.

Erste Schritte

Die folgenden Beispielnotizbücher zeigen, wie Sie SageMaker Clarify verwenden können, um mit Aufgaben zur Erklärbarkeit und Modellverzerrungen zu beginnen. Zu diesen Aufgaben gehören das Erstellen eines Verarbeitungsjobs, das Trainieren eines Modells für maschinelles Lernen (ML) und das Überwachen von Modellvorhersagen:

-

Erklärbarkeit und Erkennung von Verzerrungen mit Amazon SageMaker Clarify — Verwenden Sie SageMaker Clarify

, um einen Verarbeitungsjob zu erstellen, um Verzerrungen zu erkennen und Modellvorhersagen zu erklären. -

Überwachung von Verzerrungen und Abweichungen bei der Merkmalszuweisung Amazon SageMaker Clarify

— Verwenden Sie Amazon SageMaker Model Monitor, um Verzerrungen und Abweichungen bei der Merkmalszuweisung im Laufe der Zeit zu überwachen. -

So lesen Sie einen Datensatz im JSON Lines-Format in

einen SageMaker Clarif-Verarbeitungsauftrag ein. -

Verzerrungen mindern, ein anderes Modell ohne Vorurteile trainieren und es in das Modellregister aufnehmen — Verwenden Sie

Synthetic Minority Oversampling Technique (SMOTE) und SageMaker Clarify, um die Verzerrung zu verringern, trainieren Sie ein anderes Modell und nehmen Sie das neue Modell dann in das Modellregister auf. Dieses Beispielnotizbuch zeigt auch, wie die neuen Modellartefakte, einschließlich Daten, Code und Modellmetadaten, in die Modellregistrierung aufgenommen werden. Dieses Notizbuch ist Teil einer Reihe, die zeigt, wie SageMaker Clarify in eine SageMaker Pipeline integriert werden kann, die im Architect beschrieben ist, und wie der gesamte Lebenszyklus des maschinellen Lernens mit einem AWS Blogbeitrag erstellt wird.

Sonderfälle

Die folgenden Notizbücher zeigen Ihnen, wie Sie SageMaker Clarify für spezielle Fälle verwenden, auch in Ihrem eigenen Container, und für Aufgaben zur Verarbeitung natürlicher Sprache:

-

Fairness und Erklärbarkeit mit SageMaker Clarify (Bring Your Own Container) — Erstellen Sie Ihr eigenes

Modell und Ihren eigenen Container, die in SageMaker Clarify integriert werden können, um Verzerrungen zu messen und einen Bericht zur Erklärbarkeitsanalyse zu erstellen. In diesem Beispielnotizbuch werden auch wichtige Begriffe vorgestellt und es wird gezeigt, wie Sie über Studio Classic auf den Bericht zugreifen können. SageMaker -

Fairness und Erklärbarkeit mit SageMaker Clarify Spark Distributed Processing

— Verwenden Sie verteilte Verarbeitung, um einen SageMaker Clarif-Job auszuführen, der die Verzerrung eines Datensatzes vor dem Training und die Verzerrung eines Modells nach dem Training misst. Dieses Beispielnotizbuch zeigt Ihnen auch, wie Sie eine Erklärung für die Bedeutung der Eingabefunktionen für die Modellausgabe erhalten und über Studio Classic auf den Bericht zur Erklärbarkeitsanalyse zugreifen können. SageMaker -

Erklärbarkeit mit SageMaker Clarify — Partielle Abhängigkeitsdiagramme (PDP)

— Verwenden Sie SageMaker Clarify, um einen Bericht zur Erklärbarkeit eines Modells zu erstellen PDPs und darauf zuzugreifen. -

Erläuterung der Textstimmungsanalyse mithilfe der Erklärbarkeit von SageMaker Clarify Natural Language Processing (NLP) — Verwenden Sie Clarify für die Stimmungsanalyse

von Text. SageMaker -

Verwenden Sie die Erklärbarkeit von Computer Vision (CV) zur Bildklassifizierung und Objekterkennung.

Es wurde verifiziert, dass diese Notizbücher in Amazon SageMaker Studio Classic laufen. Anweisungen zum Öffnen eines Notizbuchs in Studio Classic finden Sie unterErstellen oder öffnen Sie ein Amazon SageMaker Studio Classic-Notizbuch. Wenn Sie aufgefordert werden, einen Kernel auszuwählen, wählen Sie Python 3 (Data Science).