Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Überwachen Sie einen Schattentest

Sie können sich die Details eines Shadow-Tests ansehen und ihn überwachen, während er läuft oder nachdem er abgeschlossen ist. SageMaker präsentiert ein Live-Dashboard, in dem die Betriebskennzahlen wie die Modelllatenz und die aggregierte Fehlerrate der Produktions- und Schattenvarianten verglichen werden.

Führen Sie die folgenden Schritte aus, um die Details eines einzelnen Tests in der Konsole anzuzeigen:

-

Wählen Sie auf der Seite Shadow-Tests im Abschnitt Shadow-Test den Test aus, den Sie überwachen möchten.

-

Wählen Sie in der Dropdown-Liste Aktionen die Option Ansicht aus. Eine Übersichtsseite mit den Details des Tests und einem Metrik-Dashboard wird angezeigt.

Die Übersichtsseite besteht aus den folgenden drei Abschnitten.

- Übersicht

-

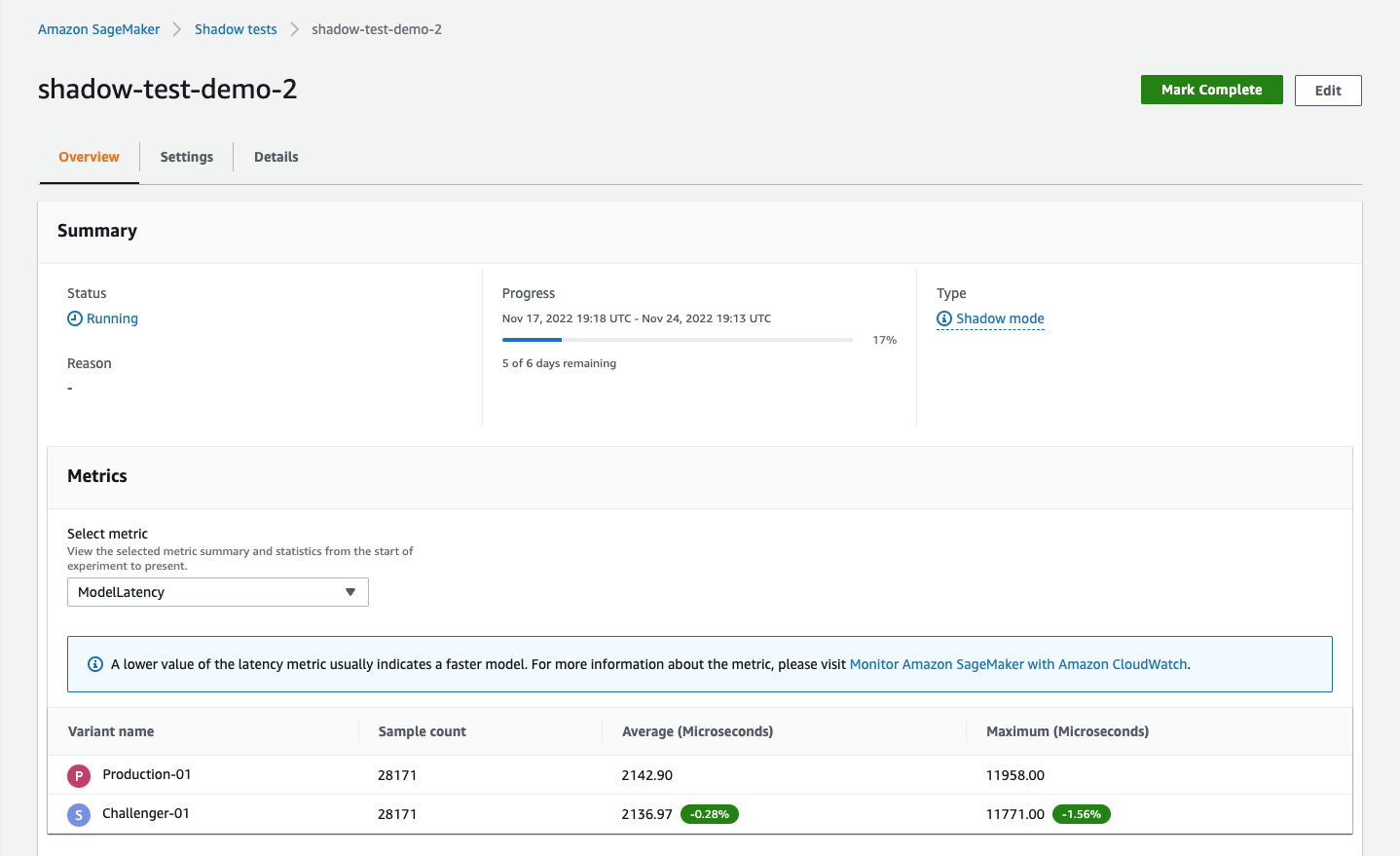

In diesem Abschnitt werden der Fortschritt und der Status des Tests zusammengefasst. Außerdem werden die zusammenfassenden Statistiken der Metrik angezeigt, die aus der Dropdown-Liste Metrik auswählen im Unterabschnitt Metriken ausgewählt wurde. Im folgenden Screenshot wird dieser Abschnitt gezeigt.

Im vorherigen Screenshot zeigen die Registerkarten Einstellungen und Details die Einstellungen, die Sie ausgewählt haben, sowie die Details, die Sie bei der Erstellung des Tests eingegeben haben.

- Analyse

-

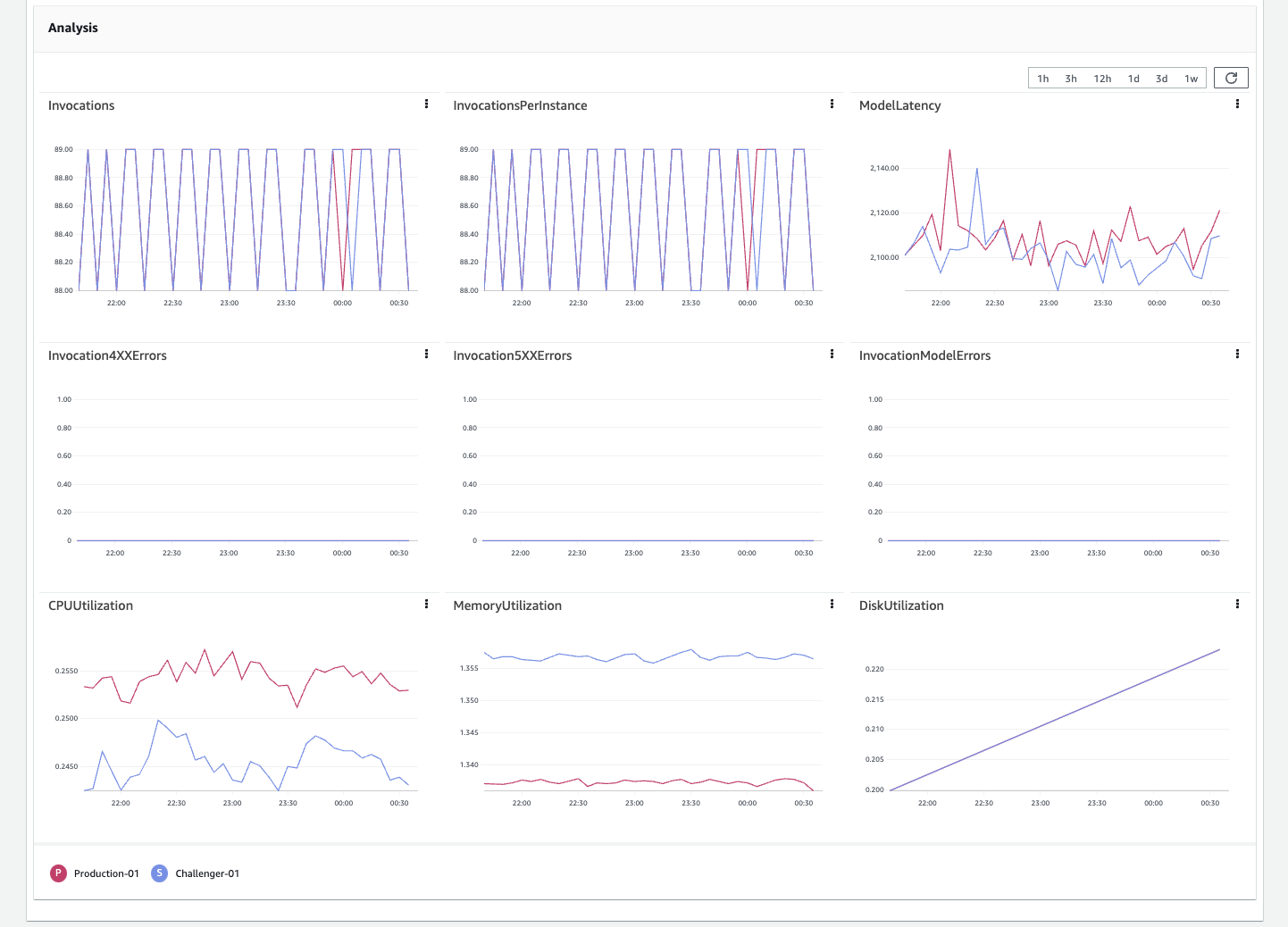

In diesem Abschnitt wird ein Metriken-Dashboard mit separaten Diagrammen für die folgenden Metriken gezeigt:

InvocationsInvocationsPerInstanceModelLatencyInvocation4XXErrorsInvocation5XXErrorsInvocationModelErrorsCPUUtilizationMemoryUtilizationDiskUtilization

Die letzten drei Metriken überwachen die Nutzung der Laufzeitressourcen des Modellcontainers. Der Rest sind CloudWatch Metriken, mit denen Sie die Leistung Ihrer Variante analysieren können. Im Allgemeinen deuten weniger Fehler auf ein stabileres Modell hin. Eine geringere Latenz deutet entweder auf ein schnelleres Modell oder eine schnellere Infrastruktur hin. Weitere Informationen zu CloudWatch Metriken finden Sie unterSageMaker Metriken zum Aufrufen von Endpunkten. Der folgende Screenshot zeigt das Dashboard mit den Metriken.

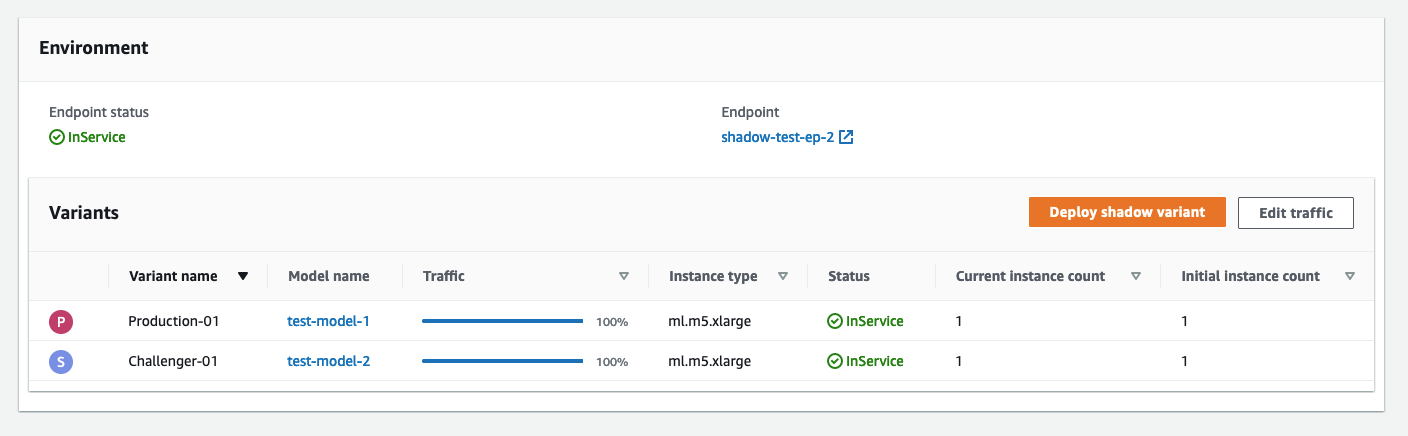

- Umgebung

-

In diesem Abschnitt werden die Varianten angezeigt, die Sie im Test verglichen haben. Wenn Sie mit der Leistung der Shadow-Variante auf der Grundlage der oben genannten Metriken zufrieden sind, können Sie die Shadow-Variante zur Produktion hochstufen, indem Sie Shadow-Variante bereitstellen wählen. Weitere Informationen zur Bereitstellung einer Shadow-Variante finden Sie unter Hochstufen einer Schattenvariante. Sie können auch den Prozentsatz der Datenverkehrssamplungen ändern und mit dem Testen fortfahren, indem Sie Traffic bearbeiten wählen. Weitere Informationen zur Bearbeitung einer Shadow-Variante finden Sie unter Bearbeiten Sie einen Schattentest. Im folgenden Screenshot wird dieser Abschnitt gezeigt.