Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Wichtig

Amazon Web Services (AWS) gibt bekannt, dass es keine neuen Releases oder Versionen von SageMaker Training Compiler geben wird. Sie können SageMaker Training Compiler weiterhin über die vorhandenen AWS Deep Learning Containers (DLCs) für SageMaker Schulungen verwenden. Es ist wichtig zu beachten, dass auf die vorhandenen DLCs Dateien zwar weiterhin zugegriffen werden kann, sie jedoch gemäß der Support-Richtlinie für AWS Deep Learning Containers Framework keine Patches oder Updates mehr erhalten. AWS

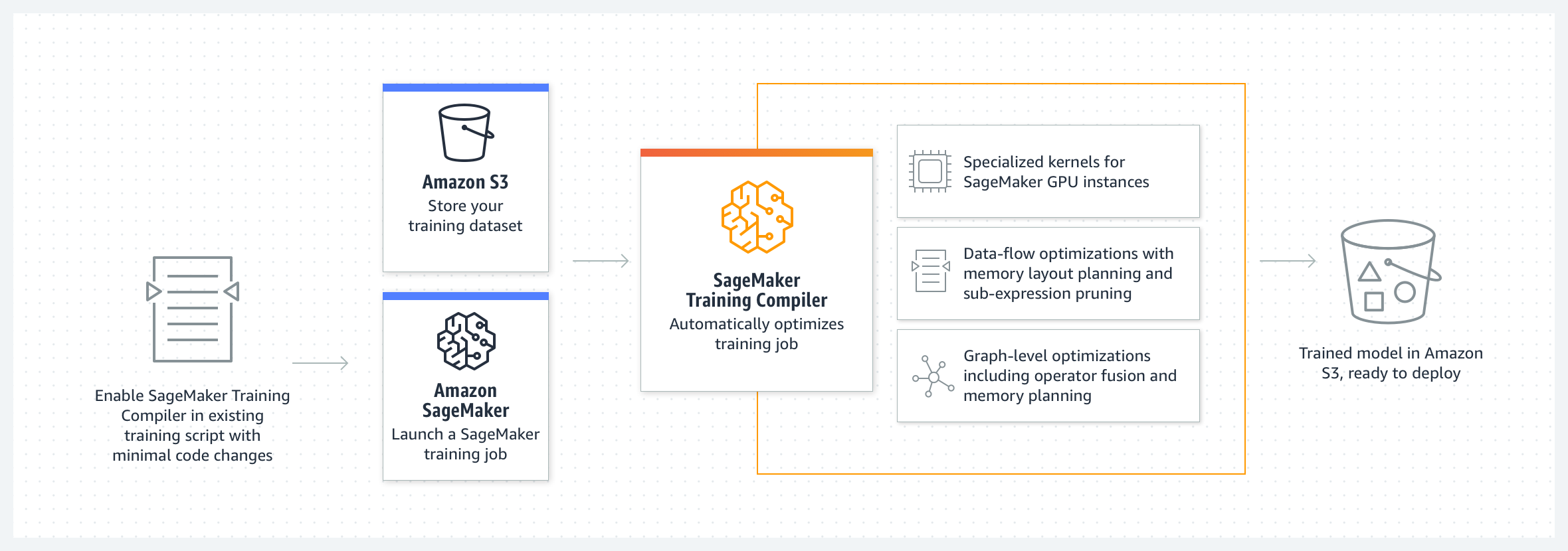

Verwenden Sie Amazon SageMaker Training Compiler, um Deep-Learning-Modelle (DL) schneller auf skalierbaren, von SageMaker KI verwalteten GPU-Instances zu trainieren.

Was ist SageMaker Training Compiler?

State-of-the-art Deep-Learning-Modelle (DL) bestehen aus komplexen, mehrschichtigen neuronalen Netzwerken mit Milliarden von Parametern, deren Training Tausende von GPU-Stunden in Anspruch nehmen kann. Die Optimierung solcher Modelle in der Trainingsinfrastruktur erfordert umfangreiche Kenntnisse in DL und Systemtechnik. Das ist selbst für enge Anwendungsfälle eine Herausforderung. Auch wenn es Open-Source-Implementierungen von Compilern gibt, die den DL-Trainingsprozess optimieren helfen, fehlt ihnen ggf. die Flexibilität, DL-Frameworks in bestimmte Hardware zu integrieren, z. B. GPU-Instances.

SageMaker Training Compiler ist eine Funktion von SageMaker KI, die diese hard-to-implement Optimierungen vornimmt, um die Trainingszeit auf GPU-Instanzen zu reduzieren. Der Compiler optimiert DL-Modelle, um das Training zu beschleunigen, indem GPU-Instanzen für maschinelles Lernen (ML) effizienter eingesetzt werden. SageMaker SageMaker Der Training Compiler ist innerhalb von SageMaker AI ohne zusätzliche Kosten verfügbar und kann dazu beitragen, die gesamte abrechnungsfähige Zeit zu reduzieren, da er das Training beschleunigt.

SageMaker Der Training Compiler ist in die AWS Deep Learning Containers (DLCs) integriert. Wenn der SageMaker Training Compiler aktiviert ist AWS DLCs, können Sie Trainingsjobs auf GPU-Instanzen mit minimalen Änderungen an Ihrem Code kompilieren und optimieren. Bringen Sie Ihre Deep-Learning-Modelle auf SageMaker KI und aktivieren Sie SageMaker Training Compiler, um die Geschwindigkeit Ihres Trainingsjobs auf SageMaker KI-ML-Instances zu beschleunigen, um die Datenverarbeitung zu beschleunigen.

So funktioniert’s

SageMaker Training Compiler konvertiert DL-Modelle von ihrer hochsprachlichen Darstellung in hardwareoptimierte Anweisungen. Insbesondere wendet SageMaker Training Compiler Optimierungen auf Diagrammebene, Optimierungen auf Datenflussebene und Backend-Optimierungen an, um ein optimiertes Modell zu erstellen, das Hardwareressourcen effizient nutzt. So können Sie Ihre Modelle schneller trainieren, als wenn Sie sie ohne Kompilierung trainieren würden.

Die Aktivierung von Training Compiler für Ihre Trainingsaufgabe erfolgt in zwei Schritten: SageMaker

-

Bringen Sie Ihr eigenes DL-Skript mit und passen Sie es bei Bedarf an, um es mit SageMaker Training Compiler zu kompilieren und zu trainieren. Weitere Informationen hierzu finden Sie unter Bringen Sie Ihr eigenes Deep-Learning-Modell mit.

-

Erstellen Sie mithilfe des SageMaker Python-SDK ein SageMaker AI-Estimator-Objekt mit dem Compiler-Konfigurationsparameter.

-

Aktivieren Sie den SageMaker Training Compiler, indem Sie der

compiler_config=TrainingCompilerConfig()SageMaker AI-Estimator-Klasse etwas hinzufügen. -

Passen Sie die Hyperparameter (

batch_sizeundlearning_rate) an, um den Nutzen, den SageMaker Training Compiler bietet, zu maximieren.Durch die Kompilierung mit dem SageMaker Training Compiler ändert sich der Speicherbedarf des Modells. In den meisten Fällen äußert sich dies darin, dass die Speicherauslastung abnimmt und daraus resultierend in einer Zunahme der Batch-Größe, die auf die GPU passt. In manchen Fällen fördert der Compiler auf intelligente Weise die Zwischenspeicherung. Das führt zu einer Abnahme der größten Batch-Größe, die auf die GPU passt. Beachten Sie, dass Sie die Lernrate entsprechend anpassen müssen, wenn Sie die Batch-Größe ändern wollen.

Eine Referenz für

batch_size, die für beliebte Modelle getestet wuren, finden Sie unter Getestete Modelle.Wenn Sie die Batch-Größe anpassen, müssen Sie auch die

learning_rateentsprechend anpassen. Bewährte Methoden zur Anpassung der Lernrate zusammen mit der Änderung der Batch-Größe finden Sie unter SageMaker Bewährte Methoden und Überlegungen zum Training Compiler. -

Durch Ausführen der

estimator.fit()Klassenmethode kompiliert SageMaker KI Ihr Modell und startet den Trainingsjob.

Anweisungen zum Starten eines Trainingsauftrags finden Sie unter Aktivieren Sie den SageMaker Training Compiler.

-

SageMaker Der Training Compiler ändert das endgültige trainierte Modell nicht und ermöglicht es Ihnen, den Trainingsjob zu beschleunigen, indem Sie den GPU-Speicher effizienter nutzen und eine größere Batchgröße pro Iteration anpassen. Das trainierte Endmodell aus dem durch den Compiler beschleunigten Trainingsauftrag ist identisch mit dem aus einem gewöhnlichen Trainingsauftrag erhaltenen Modell.

Tipp

SageMaker Der Training Compiler kompiliert nur DL-Modelle für das Training auf unterstützten GPU-Instanzen, die von KI verwaltet werden. SageMaker Verwenden SageMaker Sie den Neo-Compiler, um Ihr Modell für die Inferenz zu kompilieren und es so bereitzustellen, dass es überall in der Cloud und am Edge ausgeführt werden kann.