Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Optimice los contenedores y AMIs

El tamaño y la estructura del contenedor son importantes para la primera serie de trabajos que ejecute. Esto es especialmente cierto si el contenedor tiene más de 4 GB. Las imágenes del contenedor están integradas en capas. Docker recupera las capas en paralelo mediante tres subprocesos simultáneos. Puede aumentar el número de subprocesos simultáneos mediante el parámetro max-concurrent-downloads. Para obtener más información, consulte la documentación de Docker

Aunque puede utilizar contenedores más grandes, le recomendamos que optimice la estructura y el tamaño de los contenedores para acelerar los tiempos de startup.

-

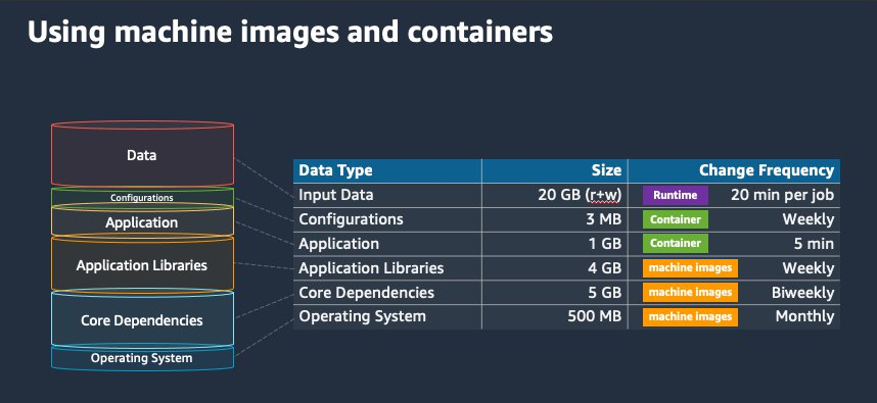

Los contenedores más pequeños se obtienen más rápido: los contenedores más pequeños pueden acelerar los tiempos de inicio de las aplicaciones. Para reducir el tamaño del contenedor, descargue las bibliotecas o los archivos que se actualizan con poca frecuencia en la Imagen de máquina de Amazon (AMI). También puede utilizar soportes de encuadernación para dar acceso a sus contenedores. Para obtener más información, consulte Montajes de enlace.

-

Cree capas que tengan un tamaño uniforme y divida las capas grandes: cada capa se recupera mediante un hilo. Por lo tanto, una capa grande podría afectar significativamente el tiempo de startup de su trabajo. Recomendamos un tamaño máximo de capa de 2 GB como compensación entre un tamaño de contenedor más grande y tiempos de startup más rápidos. Puede ejecutar el comando

docker history your_image_idpara comprobar la estructura de la imagen del contenedor y el tamaño de la capa. Para obtener más información, consulte la documentación de Docker. -

Utilice Amazon Elastic Container Registry como repositorio de contenedores: cuando ejecuta miles de trabajos en paralelo, un repositorio autogestionado puede fallar o reducir el rendimiento. Amazon ECR funciona a escala y puede gestionar cargas de trabajo de hasta más de un millón de unidades. CPUs