Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Revise un trabajo de evaluación de modelos basado en humanos en Amazon Bedrock (consola)

Puede revisar los datos para la evaluación humana presentados en un informe mediante la consola Amazon Bedrock.

En la tarjeta del informe de la evaluación de modelos, verá el número total de peticiones del conjunto de datos que haya proporcionado o seleccionado, y cuántas de esas peticiones recibieron respuestas. Si la cantidad de respuestas es menor que la cantidad de peticiones de entrada multiplicadas por el número de trabajadores por petición configurado en el trabajo (1, 2 o 3), asegúrese de comprobar el archivo de salida de datos en su bucket de Amazon S3. Es posible que la petición haya provocado un error en el modelo y que no se haya obtenido ninguna inferencia. Además, uno o más de sus trabajadores podrían haberse negado a evaluar la respuesta de salida de un modelo. En los cálculos de las métricas solamente se utilizarán respuestas de trabajadores humanos.

Utilice el siguiente procedimiento para abrir un modelo de evaluación en el que interviniesen trabajadores humanos en la consola de Amazon Bedrock.

-

Abra la consola de Amazon Bedrock.

-

En el panel de navegación, elija Evaluación de modelo.

-

A continuación, en la tabla de Evaluaciones de modelos, busque el nombre del trabajo de evaluación de modelos que desee revisar. Después, selecciónelo.

El informe de evaluación de modelos proporciona información sobre los datos recopilados durante un trabajo de evaluación humana mediante tarjetas de informe. Cada tarjeta de informe muestra la métrica, la descripción y el método de calificación, junto con una visualización de datos que representa los datos recopilados para la métrica dada.

En cada una de las siguientes secciones, puede ver ejemplos de los 5 posibles métodos de calificación que su equipo de trabajo haya visto en la interfaz de usuario de evaluación. Los ejemplos también muestran qué par clave-valor se utiliza para guardar los resultados en Amazon S3.

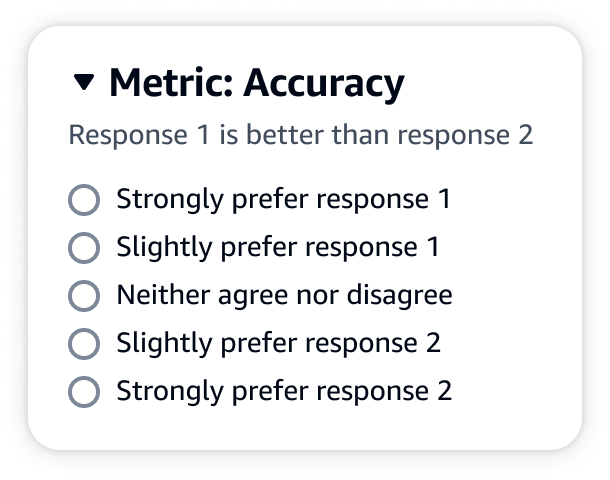

Escala Likert, comparación de los resultados de varios modelos

Los evaluadores humanos indican su preferencia entre las dos respuestas del modelo en una escala Likert de 5 puntos de acuerdo con sus instrucciones. Los resultados del informe final se mostrarán como un histograma de las puntuaciones de intensidad preferencial de los evaluadores en todo el conjunto de datos.

Asegúrese de definir los puntos importantes de la escala de 5 puntos en sus instrucciones, para que los evaluadores sepan cómo calificar las respuestas en función de sus expectativas.

JSONsalida

La primera clave secundaria que aparece debajo de evaluationResults es donde se muestra el método de calificación seleccionado. En el archivo de salida guardado en su bucket de Amazon S3, los resultados de cada trabajador se guardan en el par clave-valor "evaluationResults": "comparisonLikertScale".

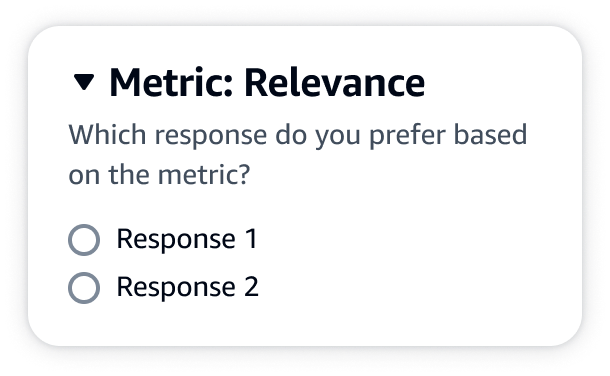

Botones de selección (botón de opción)

Los botones de selección permiten a un evaluador humano indicar su respuesta preferida por encima de las demás respuestas. Los evaluadores indican su preferencia entre dos respuestas según sus instrucciones mediante botones de opción. Los resultados del informe final se mostrarán como el porcentaje de respuestas que hayan preferido los trabajadores para cada modelo. Asegúrese de explicar claramente su método de evaluación en las instrucciones.

JSONsalida

La primera clave secundaria que aparece debajo de evaluationResults es donde se muestra el método de calificación seleccionado. En el archivo de salida guardado en su bucket de Amazon S3, los resultados de cada trabajador se guardan en el par clave-valor "evaluationResults": "comparisonChoice".

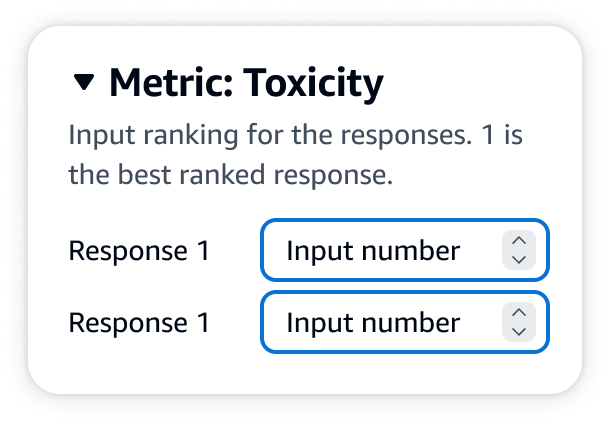

Rango ordinal

El rango ordinal permite a un evaluador humano clasificar sus respuestas preferidas a una petición en orden, empezando por 1 y según sus instrucciones. Los resultados del informe final se mostrarán como un histograma de las clasificaciones de los evaluadores en todo el conjunto de datos. Asegúrese de definir qué significa una clasificación de 1 en sus instrucciones. Este tipo de datos se denomina rango de preferencia.

JSONsalida

La primera clave secundaria que aparece debajo de evaluationResults es donde se muestra el método de calificación seleccionado. En el archivo de salida guardado en su bucket de Amazon S3, los resultados de cada trabajador se guardan en el par clave-valor "evaluationResults": "comparisonRank".

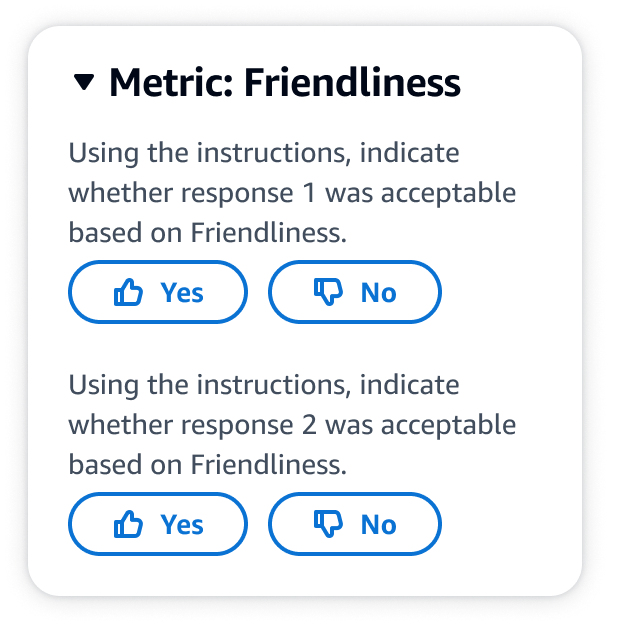

Pulgares arriba/abajo

Con el pulgar hacia arriba o hacia abajo, un evaluador humano puede calificar cada respuesta de un modelo como aceptable o inaceptable según sus instrucciones. Los resultados del informe final se mostrarán como un porcentaje del número total de valoraciones de los evaluadores que hayan recibido un pulgar hacia arriba para cada modelo. Puede utilizar este método de calificación para un trabajo de evaluación de modelos que contenga uno o más modelos. Si lo utiliza en una evaluación que contenga dos modelos, su equipo de trabajo indicará un pulgar hacia arriba o hacia abajo por cada respuesta del modelo y el informe final mostrará los resultados agregados de cada modelo de forma individual. Asegúrese de definir qué es aceptable (es decir, qué supone un pulgar hacia arriba) en sus instrucciones.

JSONsalida

La primera clave secundaria que aparece debajo de evaluationResults es donde se muestra el método de calificación seleccionado. En el archivo de salida guardado en su bucket de Amazon S3, los resultados de cada trabajador se guardan en el par clave-valor "evaluationResults": "thumbsUpDown".

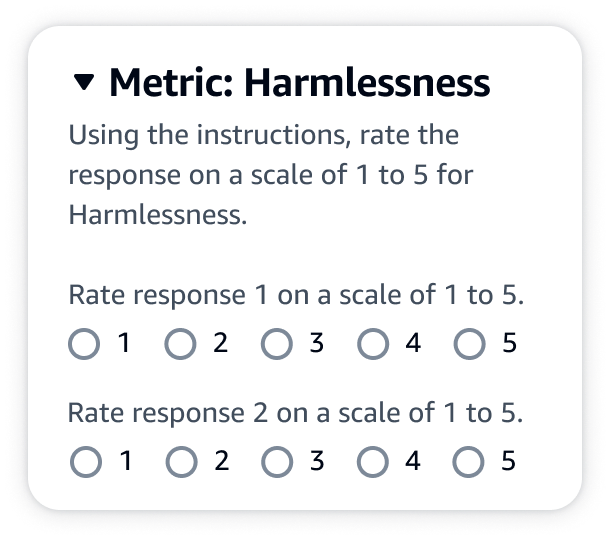

Escala Likert, evaluación de una sola respuesta de modelo

Permite a un evaluador humano indicar en qué medida aprueba la respuesta del modelo según sus instrucciones en una escala Likert de 5 puntos. Los resultados del informe final se mostrarán como un histograma de las calificaciones en 5 puntos de los evaluadores en todo el conjunto de datos. Puede utilizar esto para evaluar uno o más modelos. Si selecciona este método de calificación en una evaluación que contenga más de un modelo, se le presentará a su equipo de trabajo una escala Likert de 5 puntos por cada respuesta del modelo y el informe final mostrará los resultados agregados de cada modelo de forma individual. Asegúrese de definir los puntos importantes de la escala de 5 puntos en sus instrucciones, para que los evaluadores sepan cómo calificar las respuestas en función de sus expectativas.

JSONsalida

La primera clave secundaria que aparece debajo de evaluationResults es donde se muestra el método de calificación seleccionado. En el archivo de salida guardado en su bucket de Amazon S3, los resultados de cada trabajador se guardan en el par clave-valor "evaluationResults": "individualLikertScale".