Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Importación

Puede utilizar Amazon SageMaker Data Wrangler para importar datos de las siguientes fuentes de datos: Amazon Simple Storage Service (Amazon S3), Amazon Athena, Amazon Redshift y Snowflake. El conjunto de datos que importe puede incluir un máximo de 1000 columnas.

Algunos orígenes de datos permiten agregar varias conexiones de datos:

-

Puede conectarse a varios clústeres de Amazon Redshift. Cada clúster se convierte en un origen de datos.

-

Puede consultar cualquier base de datos de Athena de su cuenta para importar datos de esa base de datos.

Al importar un conjunto de datos de un origen de datos, aparece en el flujo de datos. Data Wrangler infiere automáticamente el tipo de datos de cada columna en su conjunto de datos. Para modificar estos tipos, seleccione el paso Tipos de datos y seleccione Editar tipos de datos.

Al importar datos de Athena o Amazon Redshift, los datos importados se almacenan automáticamente en el depósito de AI S3 SageMaker predeterminado de AWS la región en la que utilice Studio Classic. Además, Athena almacena los datos que previsualiza en Data Wrangler en este bucket. Para obtener más información, consulte Almacenamiento de datos importados.

importante

Es posible que el bucket de Amazon S3 predeterminado no tenga la configuración de seguridad menos permisiva, como la política de bucket y el cifrado del servidor (SSE). Se recomienda encarecidamente Agregar una política de bucket para restringir el acceso a los conjuntos de datos importados a Data Wrangler.

importante

Además, si utiliza la política administrada para la SageMaker IA, le recomendamos encarecidamente que la limite a la política más restrictiva que le permita llevar a cabo su caso de uso. Para obtener más información, consulte Conceder permiso a un rol de IAM para que utilice Data Wrangler.

Todas los orígenes de datos, excepto Amazon Simple Storage Service (Amazon S3), requieren que especifique una consulta SQL para importar los datos. Para cada consulta, debe especificar lo siguiente:

-

Catálogo de datos

-

Base de datos

-

Tabla

Puede especificar el nombre de la base de datos o del catálogo de datos en los menús desplegables o dentro de la consulta. A continuación, se muestran algunas consultas de ejemplo:

-

select * from: la consulta no utiliza nada especificado en los menús desplegables de la interfaz de usuario (UI) para ejecutarse. Realiza consultasexample-data-catalog-name.example-database-name.example-table-nameexample-table-namedentro deexample-database-namedentro deexample-data-catalog-name. -

select * from: la consulta utiliza el catálogo de datos que especificó en el menú desplegable Catálogo de datos para ejecutarse. Realiza consultasexample-database-name.example-table-nameexample-table-namedentro deexample-database-namedentro del catálogo de datos que haya especificado. -

select * from: la consulta requiere que seleccione campos para los menús desplegables Catálogo de datos y Nombre de la base de datos. Realiza consultasexample-table-nameexample-table-namedentro del catálogo de datos dentro de la base de datos y el catálogo de datos que haya especificado.

El enlace entre Data Wrangler y el origen de datos es una conexión. La conexión se utiliza para importar datos del origen de datos.

Existen los siguientes tipos de conexiones:

-

Directa

-

Catalogada

Data Wrangler siempre tiene acceso a los datos más recientes en una conexión directa. Si los datos del origen de datos se han actualizado, puede usar la conexión para importar los datos. Por ejemplo, si alguien agrega un archivo a uno de los buckets de Amazon S3, puede importar el archivo.

Una conexión catalogada es el resultado de una transferencia de datos. Los datos de la conexión catalogada no tienen necesariamente los datos más recientes. Por ejemplo, puede configurar una transferencia de datos entre Salesforce y Amazon S3. Si hay una actualización de los datos de Salesforce, debe volver a transferirlos. Puede automatizar el proceso de transferencia de datos. Para obtener más información sobre las transferencias de datos, consulte Importación de datos de plataformas de software como servicio (SaaS).

Importación de datos de Amazon S3

Puede usar Amazon Simple Storage Service (Amazon S3) para almacenar y recuperar cualquier cantidad de datos en cualquier momento y desde cualquier parte de la web. Puede realizar estas tareas mediante la AWS Management Console, que es una interfaz web sencilla e intuitiva, y la API Amazon S3. Si ha almacenado su conjunto de datos de forma local, se recomienda agregarlo a un bucket de S3 para importarlo a Data Wrangler. Para obtener instrucciones, consulte Cargar un objeto en el bucket en la Guía del usuario de Amazon Simple Storage Service.

Data Wrangler usa S3 Select

importante

Si planea exportar un flujo de datos y lanzar un trabajo de Data Wrangler, incorporar datos a un feature SageMaker store de IA o crear una canalización de SageMaker IA, tenga en cuenta que estas integraciones requieren que los datos de entrada de Amazon S3 estén ubicados en la misma región. AWS

importante

Si va a importar un archivo CSV, asegúrese de que cumpla los siguientes requisitos:

-

Un registro de un conjunto de datos no puede tener más de una línea.

-

El único carácter de escape válido es una barra invertida,

\. -

El conjunto de datos debe utilizar uno de los siguientes delimitadores:

-

Coma:

, -

Dos puntos:

: -

Punto y coma:

; -

Barra:

| -

Tabulador:

[TAB]

-

Para ahorrar espacio, puede importar archivos CSV comprimidos.

Data Wrangler le permite importar todo el conjunto de datos o tomar una muestra de una parte del mismo. Para Amazon S3, proporciona las siguientes opciones de muestreo:

-

Ninguno: se importa todo el conjunto de datos.

-

Primeros K: toma una muestra de las primeras filas K del conjunto de datos, donde K es un número entero que especifique.

-

Aleatorio: toma una muestra aleatoria del tamaño que especifique.

-

Estratificado: toma una muestra aleatoria estratificada. Una muestra estratificada conserva la relación de valores de una columna.

Después de importar los datos, también puede usar el transformador de muestreo para tomar una o más muestras de todo el conjunto de datos. Para obtener más información sobre el transformador de muestreo, consulte Muestreo.

Puede utilizar uno de los siguientes identificadores de recursos para importar los datos:

-

Un URI de Amazon S3 que utiliza un bucket de Amazon S3 o un punto de acceso de Amazon S3

-

Un alias de punto de acceso de Amazon S3

-

Un nombre de recurso de Amazon (ARN) que utiliza un bucket de Amazon S3 o un punto de acceso de Amazon S3

Los puntos de acceso de Amazon S3 son puntos de conexión de red con nombre que están asociados a los buckets. Cada punto de acceso tiene permisos y controles de red distintos. Para obtener más información acerca de los puntos de acceso, consulte Administración del acceso a datos con puntos de acceso de Amazon S3.

importante

Si utiliza un nombre de recurso de Amazon (ARN) para importar los datos, debe ser para un recurso ubicado en el mismo lugar Región de AWS que utiliza para acceder a Amazon SageMaker Studio Classic.

Puede importar un solo archivo o varios archivos como un conjunto de datos. Puede utilizar la operación de importación de varios archivos si tiene un conjunto de datos que está particionado en archivos independientes. Toma todos los archivos de un directorio de Amazon S3 y los importa como un único conjunto de datos. Para obtener información sobre los tipos de archivos que puede importar y cómo importarlos, consulte las siguientes secciones.

También puede usar parámetros para importar un subconjunto de archivos que se correspondan con un patrón. Los parámetros le ayudan a seleccionar de forma más selectiva los archivos que va a importar. Para empezar a utilizar los parámetros, edite el origen de datos y aplíquelos a la ruta que va a utilizar para importar los datos. Para obtener más información, consulte Reutilización de flujos de datos para diferentes conjuntos de datos.

Importación de datos de Athena

Utilice Amazon Athena para importar los datos de Amazon Simple Storage Service (Amazon S3) a Data Wrangler. En Athena, escribe consultas SQL estándar para seleccionar los datos que va a importar de Amazon S3. Para obtener más información, consulte ¿Qué es Amazon Athena?

Puede utilizarla AWS Management Console para configurar Amazon Athena. Debe crear al menos una base de datos en Athena antes de comenzar a ejecutar consultas. Para obtener más información sobre cómo empezar a utilizar Athena, consulte Introducción.

Athena se integra directamente con Data Wrangler. Puede escribir consultas de Athena sin tener que salir de la interfaz de usuario de Data Wrangler.

Además de escribir consultas sencillas de Athena en Data Wrangler, también puede usar:

-

Grupos de trabajo de Athena para la administración de los resultados de las consultas. Para obtener información acerca de los grupos de trabajo, consulte Administración de resultados de las consultas.

-

Configuraciones del ciclo de vida para establecer los períodos de retención de datos. Para obtener más información acerca de la retención de datos, consulte Configuración de periodo de retención de datos .

Consulta a Athena en Data Wrangler

nota

Data Wrangler no admite consultas federadas.

Si lo usa AWS Lake Formation con Athena, asegúrese de que sus permisos de IAM de Lake Formation no anulen los permisos de IAM para la base de datos. sagemaker_data_wrangler

Data Wrangler le permite importar todo el conjunto de datos o tomar una muestra de una parte del mismo. Para Athena, proporciona las siguientes opciones de muestreo:

-

Ninguno: se importa todo el conjunto de datos.

-

Primeros K: toma una muestra de las primeras filas K del conjunto de datos, donde K es un número entero que especifique.

-

Aleatorio: toma una muestra aleatoria del tamaño que especifique.

-

Estratificado: toma una muestra aleatoria estratificada. Una muestra estratificada conserva la relación de valores de una columna.

En el procedimiento siguiente, se muestra cómo importar un conjunto de datos de Athena a Data Wrangler.

Para importar un conjunto de datos a Data Wrangler desde Athena

-

Inicia sesión en Amazon SageMaker AI Console

. -

Elija Studio.

-

Elija Lanzar aplicación.

-

En la lista desplegable, seleccione Studio.

-

Elija el icono Inicio.

-

Elija Datos.

-

Elija Data Wrangler.

-

Elija Importar datos.

-

En Disponible, seleccione Amazon Athena.

-

En Catálogo de datos, elija un catálogo de datos.

-

Utilice la lista desplegable Base de datos para seleccionar la base de datos que desea consultar. Al seleccionar una base de datos, puede obtener una vista previa de todas las tablas de la base de datos mediante las Tablas que aparecen en Detalles.

-

De forma opcional, elija Configuración avanzada.

-

Elija un Grupo de trabajo.

-

Si su grupo de trabajo no ha impuesto la ubicación de salida de Amazon S3 o si no utiliza un grupo de trabajo, especifique un valor para la Ubicación de Amazon S3 de los resultados de la consulta.

-

De forma opcional, para Período de retención de datos, seleccione la casilla de verificación para establecer un período de retención de datos y especifique el número de días que se almacenarán los datos antes de que se eliminen.

-

(Opcional) De forma predeterminada, Data Wrangler guarda la conexión. Puede optar por quitar la marca de selección de la casilla de verificación y no guardar la conexión.

-

-

En muestreo, elija un método de muestreo. Elija Ninguno para desactivar el muestreo.

-

Ingrese la consulta en el editor de consultas y utilice el botón Ejecutar para ejecutar la consulta. Una vez que la consulta se haya realizado correctamente, puede obtener una vista previa del resultado en el editor.

nota

Los datos de Salesforce utilizan el tipo

timestamptz. Si va a consultar la columna de fecha y hora que ha importado a Athena desde Salesforce, asigne los datos de la columna al tipotimestamp. La siguiente consulta convierte la columna de fecha y hora en el tipo correcto.# cast column timestamptz_col as timestamp type, and name it as timestamp_col select cast(timestamptz_col as timestamp) as timestamp_col from table -

Para importar los resultados de la consulta, seleccione Importar.

Tras completar el procedimiento anterior, el conjunto de datos que ha consultado e importado aparece en el flujo de Data Wrangler.

De forma predeterminada, Data Wrangler guarda la configuración de conexión como una conexión nueva. Al importar los datos, la consulta que ya especificó aparece como una conexión nueva. Las conexiones guardadas almacenan información sobre los grupos de trabajo de Athena y los buckets de Amazon S3 que utiliza. Cuando vuelva a conectarse al origen de datos, podrá elegir la conexión guardada.

Administración de resultados de las consultas

Data Wrangler admite el uso de grupos de trabajo de Athena para administrar los resultados de las consultas dentro de una cuenta de AWS . Puede especificar una ubicación de salida de Amazon S3 para cada grupo de trabajo. También puede especificar si el resultado de la consulta puede ir a diferentes ubicaciones de Amazon S3. Para obtener más información, consulte Uso de grupos de trabajo para controlar el acceso a las consultas y los costos.

Es posible que el grupo de trabajo esté configurado para aplicar la ubicación de salida de la consulta de Amazon S3. No puede cambiar la ubicación de salida de los resultados de la consulta para esos grupos de trabajo.

Si no utilizas un grupo de trabajo ni especificas una ubicación de salida para tus consultas, Data Wrangler utiliza el bucket predeterminado de Amazon S3 en la misma AWS región en la que se encuentra tu instancia de Studio Classic para almacenar los resultados de las consultas de Athena. Crea tablas temporales en esta base de datos para mover el resultado de la consulta a este bucket de Amazon S3. Elimina estas tablas después de importar los datos; sin embargo, la base de datos, sagemaker_data_wrangler, persiste. Para obtener más información, consulte Almacenamiento de datos importados.

Para usar los grupos de trabajo de Athena, configure la política de IAM que da acceso a los grupos de trabajo. Si utiliza un SageMaker AI-Execution-Role, se recomienda agregar la política al rol. Para obtener más información sobre las políticas de IAM para los grupos de trabajo, consulte Políticas de IAM para acceder a los grupos de trabajo. Para ver ejemplos de políticas de grupos de trabajo, consulte Ejemplos de políticas de grupos de trabajo.

Configuración de periodo de retención de datos

Data Wrangler establece automáticamente un período de retención de datos para los resultados de la consulta. Los resultados se eliminan una vez transcurrido el período de retención. Por ejemplo, el período de retención predeterminado es de cinco días. Los resultados de la consulta se eliminan al cabo de cinco días. Esta configuración está diseñada para ayudarle a limpiar los datos que ya no utiliza. La limpieza de los datos evita que usuarios no autorizados accedan a ellos. También ayuda a controlar los costos de almacenamiento de los datos en Amazon S3.

Si no establece un período de retención, la configuración del ciclo de vida de Amazon S3 determina el tiempo durante el que se almacenan los objetos. La política de retención de datos que especificó para la configuración del ciclo de vida elimina los resultados de las consultas que sean anteriores a la configuración del ciclo de vida que especificó. Para obtener más información, consulte Configurar el ciclo de vida de un bucket.

Data Wrangler utiliza las configuraciones del ciclo de vida de Amazon S3 para administrar la retención y el vencimiento de los datos. Debe conceder a su función de ejecución de IAM de Amazon SageMaker Studio Classic los permisos para gestionar las configuraciones del ciclo de vida de los buckets. Utilice el siguiente procedimiento para conceder permisos.

Para conceder permisos para administrar la configuración del ciclo de vida, haga lo siguiente.

-

Inicie sesión en la consola de IAM AWS Management Console y ábrala en. https://console.aws.amazon.com/iam/

-

Elija Roles.

-

En la barra de búsqueda, especifique la función de ejecución de Amazon SageMaker AI que utiliza Amazon SageMaker Studio Classic.

-

Elija el rol .

-

Elija Añadir permisos.

-

Elija Crear política insertada.

-

En Servicio, especifique S3 y elíjalo.

-

En la sección Leer, selecciona GetLifecycleConfiguration.

-

En la sección Escribir, selecciona PutLifecycleConfiguration.

-

En Recursos, elija Específico.

-

En Acciones, seleccione el icono de flecha situado junto a Administración de permisos.

-

Elija PutResourcePolicy.

-

En Recursos, elija Específico.

-

Elija la casilla de verificación situada junto a Cualquiera de esta cuenta.

-

Elija Revisar política.

-

En Nombre, especifique un nombre.

-

Elija Crear política.

Importación de datos de Amazon Redshift

Amazon Redshift es un servicio de almacenamiento de datos administrado a escala de petabytes en la nube . El primer paso para crear un almacenamiento de datos es el lanzamiento de un conjunto de nodos, llamado un clúster de Amazon Redshift. Después de aprovisionar el clúster, puede cargar su conjunto de datos y, luego, realizar consultas de análisis de datos.

Puede conectarse a uno o más clústeres de Amazon Redshift y consultarlos en Data Wrangler. Para utilizar esta opción de importación, debe crear al menos un clúster en Amazon Redshift. Para obtener información sobre cómo hacerlo, consulte Introducción a Amazon Redshift.

Puede enviar los resultados de la consulta de Amazon Redshift a una de las siguientes ubicaciones:

-

El bucket de Amazon S3 predeterminado

-

Una ubicación de salida de Amazon S3 que especifique

Puede importar todo el conjunto de datos o tomar una muestra de una parte del mismo. Para Amazon Redshift, proporciona las siguientes opciones de muestreo:

-

Ninguno: se importa todo el conjunto de datos.

-

Primeros K: toma una muestra de las primeras filas K del conjunto de datos, donde K es un número entero que especifique.

-

Aleatorio: toma una muestra aleatoria del tamaño que especifique.

-

Estratificado: toma una muestra aleatoria estratificada. Una muestra estratificada conserva la relación de valores de una columna.

El bucket de Amazon S3 predeterminado se encuentra en la misma AWS región en la que se encuentra la instancia de Studio Classic para almacenar los resultados de las consultas de Amazon Redshift. Para obtener más información, consulte Almacenamiento de datos importados.

Para el bucket de Amazon S3 predeterminado o para el bucket que especifique, dispone de las siguientes opciones de cifrado:

-

El cifrado predeterminado del AWS lado del servicio con una clave gestionada de Amazon S3 (SSE-S3)

-

Una clave AWS Key Management Service (AWS KMS) que especifique

Una AWS KMS clave es una clave de cifrado que usted crea y administra. Para obtener más información sobre claves de KMS, consulte AWS Key Management Service.

Puede especificar una AWS KMS clave mediante la clave ARN o el ARN de su cuenta. AWS

Si utiliza la política administrada de IAM, AmazonSageMakerFullAccess, para conceder a un rol permiso para que utilice Data Wrangler en Studio Classic, el nombre de Usuario de la base de datos debe tener el prefijo sagemaker_access.

Utilice los siguientes procedimientos para obtener información sobre cómo agregar un nuevo clúster.

nota

Data Wrangler utiliza la API de datos de Amazon Redshift con credenciales temporales. Para obtener más información sobre esta API, consulte Uso de la API de datos de Amazon Redshift en la Guía de administración de Amazon Redshift.

Para conectarse a un clúster de Amazon Redshift

-

Inicia sesión en Amazon SageMaker AI Console

. -

Elija Studio.

-

Elija Lanzar aplicación.

-

En la lista desplegable, seleccione Studio.

-

Elija el icono Inicio.

-

Elija Datos.

-

Elija Data Wrangler.

-

Elija Importar datos.

-

En Disponible, seleccione Amazon Athena.

-

Elija Amazon Redshift.

-

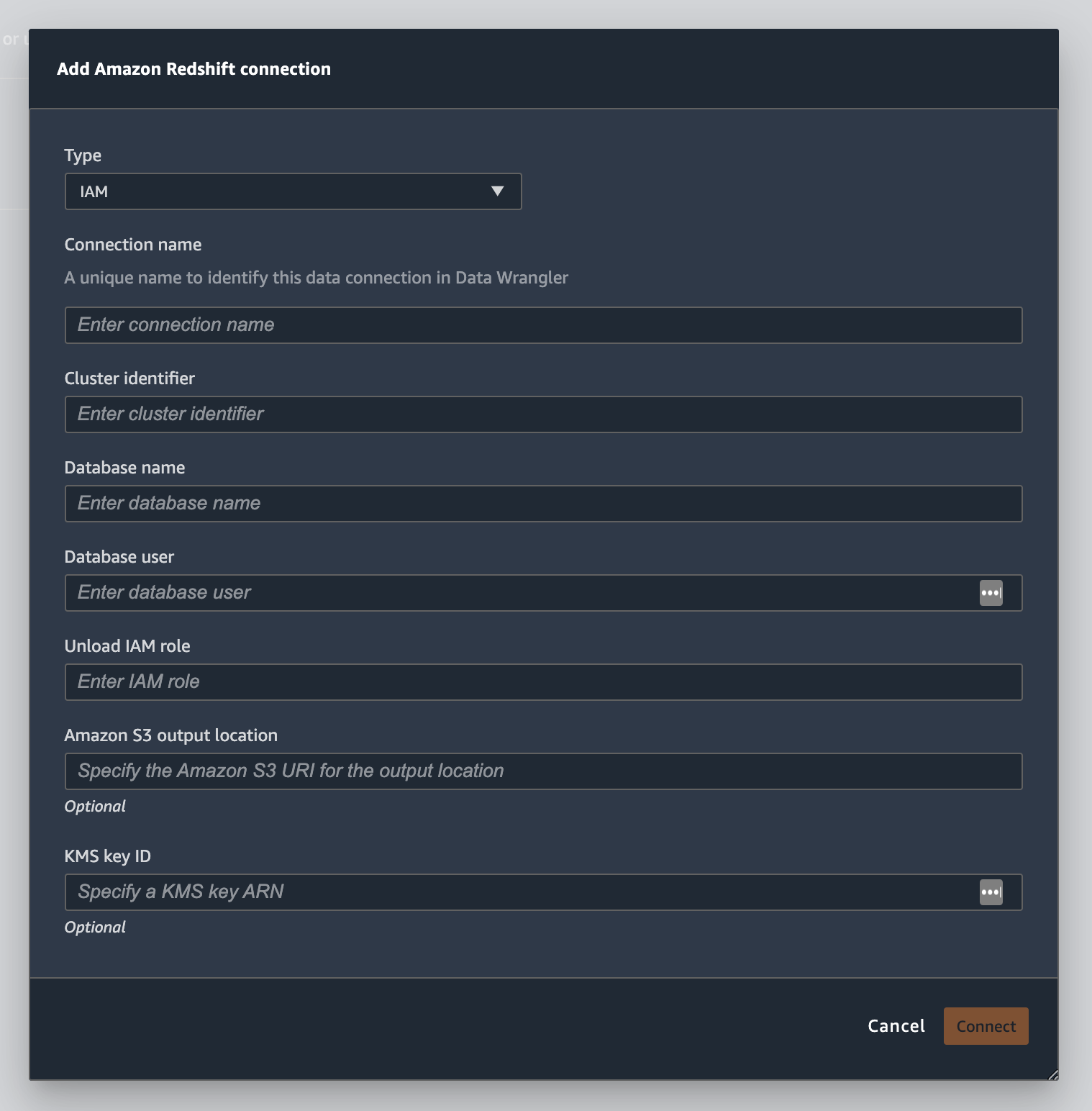

Elija Credenciales temporales (IAM) como Tipo.

-

Especifique un Nombre de la conexión. Data Wrangler utiliza este nombre para identificar esta conexión.

-

Ingrese el Identificador del clúster para especificar a qué clúster desea conectarse. Nota: Ingrese solo el identificador del clúster y no el punto de conexión completo del clúster de Amazon Redshift.

-

Especifique el Nombre de la base de datos a la que desea conectarse.

-

Ingrese un Usuario de la base de datos para identificar el usuario que desea utilizar para conectarse a la base de datos.

-

En Rol de IAM UNLOAD, ingrese el ARN del rol de IAM del rol que debe asumir el clúster de Amazon Redshift para mover y escribir datos en Amazon S3. Para obtener más información sobre esta función, consulte Autorizar a Amazon Redshift a acceder a AWS otros servicios en su nombre en la Guía de administración de Amazon Redshift.

-

Elija Conectar.

-

De forma opcional, en Ubicación de salida de Amazon S3, especifique el URI de S3 en el que almacenar los resultados de la consulta.

-

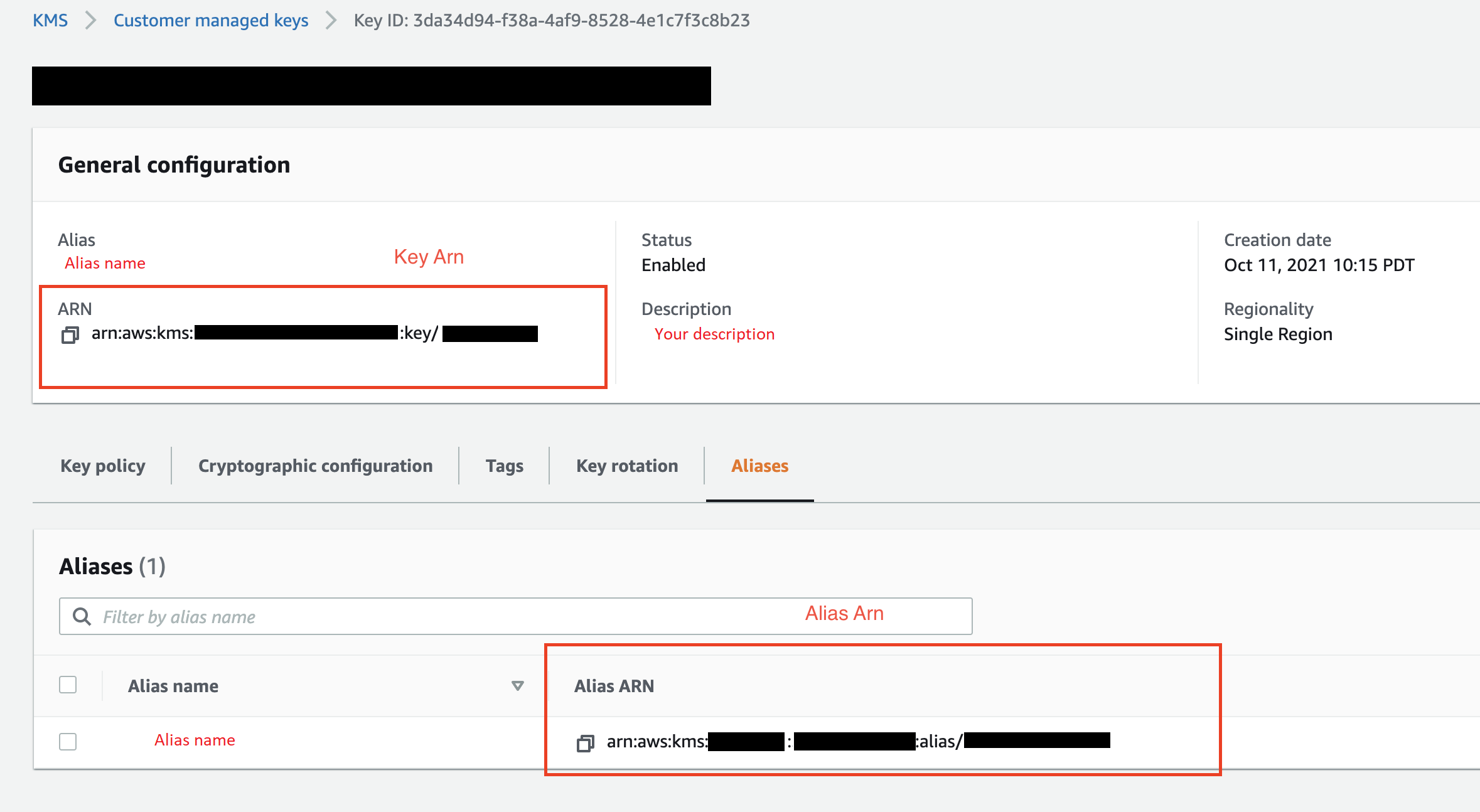

De forma opcional, en ID de clave de KMS, especifique el ARN de la clave de AWS KMS o el alias. La siguiente imagen muestra dónde se encuentra cada clave en la AWS Management Console.

La imagen siguiente muestra todos los campos del procedimiento anterior.

Cuando la conexión se haya establecido correctamente, aparecerá como origen de datos en la sección Importación de datos. Seleccione este origen de datos para consultar la base de datos e importar datos.

Para consultar e importar datos de Amazon Redshift

-

Seleccione la conexión que desee consultar de Orígenes de datos.

-

Seleccione un Esquema. Para obtener más información acerca de los esquemas de Amazon Redshift, consulte Esquemas en la Guía para desarrolladores de bases de datos de Amazon Redshift.

-

De forma opcional, en Configuración avanzada, especifique el método de Muestreo que desee utilizar.

-

Ingrese la consulta en el editor de consultas y elija Ejecutar para ejecutar la consulta. Una vez que la consulta se haya realizado correctamente, puede obtener una vista previa del resultado en el editor.

-

Seleccione Importar conjunto de datos para importar el conjunto de datos que se ha consultado.

-

Introduzca un Nombre del conjunto de datos. Si agrega un Nombre del conjunto de datos que contenga espacios, estos espacios se sustituirán por guiones bajos al importar el conjunto de datos.

-

Elija Agregar.

Para editar un conjunto de datos, haga lo siguiente.

-

Vaya a su flujo de Data Wrangler.

-

Elija el signo + situado junto a Origen: muestreado.

-

Cambie los datos que está importando.

-

Seleccione Apply (Aplicar)

Importación de datos de Amazon EMR

Puede utilizar Amazon EMR como fuente de datos para su flujo de Amazon SageMaker Data Wrangler. Amazon EMR es una plataforma de clúster administrada que puede utilizar para procesar y analizar grandes cantidades de datos. Para obtener más información sobre Amazon EMR, consulte ¿Qué es Amazon EMR? Para importar un conjunto de datos de EMR, debe conectarse a él y consultarlo.

importante

Debe cumplir los siguientes requisitos previos para conectarse a un clúster de Amazon EMR:

Requisitos previos

-

Configuraciones de red

-

Tiene una Amazon VPC en la región que utiliza para lanzar Amazon SageMaker Studio Classic y Amazon EMR.

-

Tanto Amazon EMR como Amazon SageMaker Studio Classic deben lanzarse en subredes privadas. Pueden estar en la misma subred o en subredes diferentes.

-

Amazon SageMaker Studio Classic debe estar en modo solo VPC.

Para obtener información acerca de la creación de una VPC, consulte Creación de una VPC.

Para obtener más información sobre la creación de una VPC, consulte Conectar los cuadernos clásicos de SageMaker Studio en una VPC a recursos externos.

-

Los clústeres de Amazon EMR que ejecuta deben estar en la misma Amazon VPC.

-

Los clústeres de Amazon EMR y la VPC de Amazon deben estar en la misma cuenta. AWS

-

Sus clústeres de Amazon EMR se ejecutan en Hive o Presto.

-

Los clústeres de Hive deben permitir el tráfico entrante de los grupos de seguridad de Studio Classic en el puerto 10000.

-

Los clústeres de Presto deben permitir el tráfico entrante de los grupos de seguridad de Studio Classic en el puerto 8889.

nota

El número de puerto es diferente para los clústeres de Amazon EMR que utilizan roles de IAM. Vaya al final de la sección de requisitos previos para obtener más información.

-

-

-

SageMaker Studio Classic

-

Amazon SageMaker Studio Classic debe ejecutar la versión 3 de Jupyter Lab. Para obtener información sobre la actualización de la versión de Jupyter Lab, consulte Vea y actualice la JupyterLab versión de una aplicación desde la consola.

-

Amazon SageMaker Studio Classic tiene una función de IAM que controla el acceso de los usuarios. La función de IAM predeterminada que utiliza para ejecutar Amazon SageMaker Studio Classic no tiene políticas que le permitan acceder a los clústeres de Amazon EMR. Debe asociar la política que otorga permisos al rol de IAM. Para obtener más información, consulte Configuración de la lista de clústeres de Amazon EMR.

-

El rol de IAM también debe tener la siguiente política asociada:

secretsmanager:PutResourcePolicy. -

Si utiliza un dominio de Studio Classic que ya haya creado, asegúrese de que

AppNetworkAccessTypeesté en modo solo VPC. Para obtener información sobre cómo actualizar un dominio para que utilice el modo solo VPC, consulte Cierre y actualice SageMaker Studio Classic.

-

-

Clústeres de Amazon EMR

-

Debe tener Hive o Presto instalados en el clúster.

-

La versión de Amazon EMR debe ser 5.5.0 o posterior.

nota

Amazon EMR admite la terminación automática. La terminación automática impide que los clústeres inactivos se ejecuten y evita que usted incurra en costos. Las siguientes versiones admiten la terminación automática:

-

Para las versiones 6.x, versión 6.1.0 o posterior.

-

Para las versiones 5.x, versión 5.30.0 o posterior.

-

-

-

Clústeres de Amazon EMR que utilizan roles de tiempo de ejecución de IAM

-

Utilice las siguientes páginas para configurar los roles de tiempo de ejecución de IAM para el clúster de Amazon EMR. Cuando utilice roles de tiempo de ejecución, debe habilitar el cifrado en tránsito:

-

Debe usar Lake Formation como herramienta de gobernanza para los datos de sus bases de datos. También debe utilizar un filtrado de datos externo para el control de acceso.

-

Para obtener más información sobre Lake Formation, consulte ¿Qué es AWS Lake Formation?

-

Para obtener más información sobre la integración de Lake Formation en Amazon EMR, consulte Integrating third-party services with Lake Formation.

-

-

La versión del clúster debe ser 6.9.0 o posterior.

-

Acceso a AWS Secrets Manager. Para obtener más información sobre Secrets Manager, consulte ¿Qué es AWS Secrets Manager Secrets Manager?

-

Los clústeres de Hive deben permitir el tráfico entrante de los grupos de seguridad de Studio Classic en el puerto 10000.

-

Una Amazon VPC es una red virtual aislada de forma lógica de otras redes de la nube. AWS Amazon SageMaker Studio Classic y su clúster de Amazon EMR solo existen en la VPC de Amazon.

Utilice el siguiente procedimiento para lanzar Amazon SageMaker Studio Classic en una Amazon VPC.

Para inicializar Studio Classic en una VPC, haga lo siguiente.

-

Diríjase a la consola de SageMaker IA en https://console.aws.amazon.com/sagemaker/

. -

Elige Launch SageMaker Studio Classic.

-

Elija Configuración estándar.

-

En Rol de ejecución predeterminado, elija el rol de IAM para configurar Studio Classic.

-

Elija la VPC en la que lanzó los clústeres de Amazon EMR.

-

En Subred, elija una subred privada.

-

En Grupo(s) de seguridad, especifique los grupos de seguridad que utilizar para el control entre las VPC.

-

Elija Solo VPC.

-

(Opcional) AWS utiliza una clave de cifrado predeterminada. También puede especificar una clave de AWS Key Management Service para cifrar los datos.

-

Elija Next (Siguiente).

-

En Configuración de Studio, elija las configuraciones que mejor se adapten a su caso.

-

Elija Siguiente para omitir la configuración de SageMaker Canvas.

-

Elija Siguiente para omitir los RStudio ajustes.

Si no tiene un clúster de Amazon EMR listo, puede utilizar el siguiente procedimiento para crear uno. Para obtener más información sobre Amazon EMR, consulte ¿Qué es Amazon EMR?

Para crear un clúster, haga lo siguiente.

-

Vaya a AWS Management Console.

-

En la barra de búsqueda, especifique

Amazon EMR. -

Elija Create cluster.

-

En Nombre del clúster, ingrese el nombre del clúster.

-

En Versión, seleccione la versión de lanzamiento del clúster.

nota

Amazon EMR admite la terminación automática en las siguientes versiones:

-

Para las versiones 6.x, versión 6.1.0 o posterior

-

Para las versiones 5.x, versión 5.30.0 o posterior

La terminación automática impide que los clústeres inactivos se ejecuten y evita que usted incurra en costos.

-

-

De forma opcional, en Aplicaciones, elija Presto.

-

Elija la aplicación que está ejecutando en el clúster.

-

En Redes, para Configuración de hardware, especifique las opciones de configuración del hardware.

importante

Para redes, elija la VPC que ejecuta Amazon SageMaker Studio Classic y elija una subred privada.

-

En Seguridad y acceso, especifique la configuración de seguridad.

-

Seleccione Crear.

Para ver un tutorial sobre cómo crear un clúster de Amazon EMR, consulte Introducción a Amazon EMR. Para obtener información sobre las prácticas recomendadas para configurar un clúster, consulte Consideraciones y prácticas recomendadas.

nota

Como prácticas recomendadas de seguridad, Data Wrangler solo puede conectarse a VPCs subredes privadas. No puede conectarse al nodo principal a menos que lo utilice AWS Systems Manager para sus instancias de Amazon EMR. Para obtener más información, consulte Securing access to EMR clusters using AWS Systems Manager

Actualmente, puede utilizar los siguientes métodos para acceder a un clúster de Amazon EMR:

-

Sin autenticación

-

Protocolo ligero de acceso a directorios (LDAP)

-

IAM (rol de tiempo de ejecución)

Si no se utiliza la autenticación o el uso de LDAP, es posible que tengas que crear varios clústeres y perfiles de EC2 instancias de Amazon. Si es un administrador, es posible que deba proporcionar a grupos de usuarios diferentes niveles de acceso a los datos. Estos métodos pueden generar una sobrecarga administrativa que dificulte la administración de los usuarios.

Se recomienda utilizar un rol de tiempo de ejecución de IAM que permita a varios usuarios conectarse al mismo clúster de Amazon EMR. Un rol de tiempo de ejecución es un rol de IAM que puede asignar a un usuario que se está conectando a un clúster de Amazon EMR. Puede configurar el rol de IAM en tiempo de ejecución para que tenga permisos concretos para cada grupo de usuarios.

Utilice las siguientes secciones para crear un clúster de Amazon EMR de Presto o Hive con el LDAP activado.

Utilice las siguientes secciones para utilizar la autenticación LDAP para los clústeres de Amazon EMR que ya haya creado.

Utilice el siguiente procedimiento para importar datos de un clúster.

Para importar datos de un clúster, haga lo siguiente.

-

Abra un flujo de Data Wrangler.

-

Elija Create Connection (Crear conexión).

-

Elija Amazon EMR.

-

Aplique alguna de las siguientes acciones.

-

De forma opcional, en el ARN del secreto, especifique el número de recurso de Amazon (ARN) de la base de datos del clúster. Los secretos proporcionan seguridad adicional. Para obtener más información sobre los secretos, consulte ¿Qué es AWS Secrets Manager? Para obtener más información acerca de la creación de un secreto para el clúster, consulte Crear un AWS Secrets Manager secreto para el clúster.

importante

Debe especificar un secreto si utiliza un rol de tiempo de ejecución de IAM para la autenticación.

-

Seleccione un clúster de la lista desplegable.

-

-

Elija Next (Siguiente).

-

En Seleccione un punto final para el

example-cluster-nameclúster, elija un motor de consultas. -

De forma opcional, seleccione Guardar conexión.

-

Elija Siguiente, seleccione inicio de sesión y elija una de estas opciones:

-

Sin autenticación

-

LDAP

-

IAM

-

-

En Iniciar sesión en el

example-cluster-nameclúster, especifique el nombre de usuario y la contraseña del clúster. -

Elija Conectar.

-

En el editor de consultas, especifique una consulta SQL.

-

Seleccione Ejecutar.

-

Seleccione Importar.

Crear un AWS Secrets Manager secreto para el clúster

Si utiliza un rol de tiempo de ejecución de IAM para acceder a su clúster de Amazon EMR, debe almacenar las credenciales que utiliza para acceder a Amazon EMR como un secreto de Secrets Manager. Todas las credenciales que utiliza para acceder al clúster se almacenan en el secreto.

Debe almacenar la siguiente información en el secreto:

-

Punto de conexión de JDBC:

jdbc:hive2://. -

Nombre de DNS: el nombre de DNS de su clúster de Amazon EMR. Puede ser el punto de conexión del nodo principal o el nombre de host.

-

Puerto:

8446.

También puede almacenar la siguiente información adicional en el secreto:

-

Rol de IAM: el rol de IAM que utiliza para acceder al clúster. Data Wrangler usa tu función de ejecución de SageMaker IA de forma predeterminada.

-

Ruta del almacén de confianza: de forma predeterminada, Data Wrangler crea una ruta del almacén de confianza para usted. También puede utilizar su propia ruta del almacén de confianza. Para obtener más información sobre las rutas de los almacenes de confianza, consulte Cifrado en tránsito en 2. HiveServer

-

Contraseña del almacén de confianza: de forma predeterminada, Data Wrangler crea una contraseña del almacén de confianza para usted. También puede utilizar su propia ruta del almacén de confianza. Para obtener más información sobre las rutas de los almacenes de confianza, consulte Cifrado en tránsito en la sección 2. HiveServer

Utilice el siguiente procedimiento para almacenar las credenciales en un secreto de Secrets Manager.

Para almacenar las credenciales como un secreto, haga lo siguiente.

-

Vaya a AWS Management Console.

-

En la barra de búsqueda, especifique Secrets Manager.

-

Elija AWS Secrets Manager.

-

Elija Almacenar un secreto nuevo.

-

En Secret type (Tipo de secreto), elija Other type of secret (Otro tipo de secreto).

-

En pares clave-valor, seleccione Texto sin formato.

-

Para los clústeres que ejecutan Hive, puede utilizar la siguiente plantilla para la autenticación de IAM.

{"jdbcURL": "" "iam_auth": {"endpoint": "jdbc:hive2://", #required "dns": "ip-xx-x-xxx-xxx.ec2.internal", #required "port": "10000", #required "cluster_id": "j-xxxxxxxxx", #required "iam_role": "arn:aws:iam::xxxxxxxx:role/xxxxxxxxxxxx", #optional "truststore_path": "/etc/alternatives/jre/lib/security/cacerts", #optional "truststore_password": "changeit" #optional }}nota

Después de importar los datos, se les aplican transformaciones. A continuación, exporta los datos que ha transformado a una ubicación específica. Si utiliza un cuaderno de Jupyter para exportar los datos transformados a Amazon S3, debe utilizar la ruta del almacén de confianza especificada en el ejemplo anterior.

Un secreto de Secrets Manager almacena la URL de JDBC del clúster de Amazon EMR como un secreto. El uso de un secreto es más seguro que introducir directamente las credenciales.

Utilice el siguiente procedimiento para almacenar la URL de JDBC como un secreto.

Para almacenar la URL de JDBC como un secreto, haga lo siguiente.

-

Vaya a AWS Management Console.

-

En la barra de búsqueda, especifique Secrets Manager.

-

Elija AWS Secrets Manager.

-

Elija Almacenar un secreto nuevo.

-

En Secret type (Tipo de secreto), elija Other type of secret (Otro tipo de secreto).

-

Para Pares clave-valor, especifique

jdbcURLcomo clave y una URL de JDBC válida como valor.El formato de una URL de JDBC válida depende de si se utiliza la autenticación y de si se utiliza Hive o Presto como motor de consulta. La siguiente lista muestra los formatos de URL de JBDC válidos para las distintas configuraciones posibles.

-

Hive, sin autenticación:

jdbc:hive2://emr-cluster-master-public-dns:10000/; -

Hive, autenticación LDAP:

jdbc:hive2://emr-cluster-master-public-dns-name:10000/;AuthMech=3;UID=david;PWD=welcome123; -

En el caso de Hive con SSL habilitado, el formato de URL de JDBC depende de si se utiliza un archivo de almacén de claves de Java para la configuración de TLS. El archivo de almacén de claves de Java ayuda a verificar la identidad del nodo maestro del clúster de Amazon EMR. Para usar un archivo de almacén de claves de Java, genérelo en un clúster de EMR y cárguelo en Data Wrangler. Para generar un archivo, utilice el siguiente comando en el clúster de Amazon EMR:

keytool -genkey -alias hive -keyalg RSA -keysize 1024 -keystore hive.jks. Para obtener información sobre la ejecución de comandos en un clúster de Amazon EMR, consulte Securing access to EMR clusters using AWS Systems Manager. Para cargar un archivo, elija la flecha hacia arriba en la barra de navegación izquierda de la interfaz de usuario de Data Wrangler. Los siguientes son los formatos de URL de JDBC válidos para Hive con SSL habilitado:

-

Sin un archivo de almacén de claves de Java:

jdbc:hive2://emr-cluster-master-public-dns:10000/;AuthMech=3;UID=user-name;PWD=password;SSL=1;AllowSelfSignedCerts=1; -

Con un archivo de almacén de claves de Java:

jdbc:hive2://emr-cluster-master-public-dns:10000/;AuthMech=3;UID=user-name;PWD=password;SSL=1;SSLKeyStore=/home/sagemaker-user/data/Java-keystore-file-name;SSLKeyStorePwd=Java-keystore-file-passsword;

-

-

Listo, sin autenticación: jdbc:presto: //:8889/;

emr-cluster-master-public-dns -

En el caso de Presto con autenticación LDAP y SSL habilitado, el formato de URL de JDBC depende de si se utiliza un archivo de almacén de claves de Java para la configuración de TLS. El archivo de almacén de claves de Java ayuda a verificar la identidad del nodo maestro del clúster de Amazon EMR. Para usar un archivo de almacén de claves de Java, genérelo en un clúster de EMR y cárguelo en Data Wrangler. Para cargar un archivo, elija la flecha hacia arriba en la barra de navegación izquierda de la interfaz de usuario de Data Wrangler. Para obtener información sobre cómo crear un archivo de almacén de claves de Java para Presto, consulte Java Keystore File for TLS

. Para obtener información sobre la ejecución de comandos en un clúster de Amazon EMR, consulte Securing access to EMR clusters using AWS Systems Manager . -

Sin un archivo de almacén de claves de Java:

jdbc:presto://emr-cluster-master-public-dns:8889/;SSL=1;AuthenticationType=LDAP Authentication;UID=user-name;PWD=password;AllowSelfSignedServerCert=1;AllowHostNameCNMismatch=1; -

Con un archivo de almacén de claves de Java:

jdbc:presto://emr-cluster-master-public-dns:8889/;SSL=1;AuthenticationType=LDAP Authentication;SSLTrustStorePath=/home/sagemaker-user/data/Java-keystore-file-name;SSLTrustStorePwd=Java-keystore-file-passsword;UID=user-name;PWD=password;

-

-

Durante el proceso de importación de datos desde un clúster de Amazon EMR, podría tener problemas. Para obtener información acerca de la solución de problemas, consulte Solución de problemas con Amazon EMR.

Importación de datos de Databricks (JDBC)

Puede usar Databricks como fuente de datos para su flujo de Amazon SageMaker Data Wrangler. Para importar un conjunto de datos de Databricks, utilice la funcionalidad de importación de JDBC (Java Database Connectivity) para acceder a su base de datos de Databricks. Después de acceder a la base de datos, especifique una consulta SQL para obtener los datos e importarlos.

Suponemos que tiene un clúster de Databricks en ejecución y que ha configurado su controlador JDBC para él. Para obtener más información, consulte las siguientes páginas de documentación de Databricks.

Data Wrangler almacena su URL de JDBC. AWS Secrets Manager Debe conceder permisos a su función de ejecución de IAM de Amazon SageMaker Studio Classic para usar Secrets Manager. Utilice el siguiente procedimiento para conceder permisos.

Para conceder permisos a Secrets Manager, haga lo siguiente.

-

Inicie sesión en la consola de IAM AWS Management Console y ábrala en. https://console.aws.amazon.com/iam/

-

Elija Roles.

-

En la barra de búsqueda, especifique la función de ejecución de Amazon SageMaker AI que utiliza Amazon SageMaker Studio Classic.

-

Elija el rol .

-

Elija Añadir permisos.

-

Elija Crear política insertada.

-

En Servicio, especifique Secrets Manager y elíjalo.

-

En Acciones, seleccione el icono de flecha situado junto a Administración de permisos.

-

Elija PutResourcePolicy.

-

En Recursos, elija Específico.

-

Elija la casilla de verificación situada junto a Cualquiera de esta cuenta.

-

Elija Revisar política.

-

En Nombre, especifique un nombre.

-

Elija Crear política.

Puede usar particiones para importar los datos con mayor rapidez. Las particiones dan a Data Wrangler la capacidad de procesar los datos en paralelo. De forma predeterminada, Data Wrangler usa 2 particiones. Para la mayoría de los casos de uso, 2 particiones ofrecen velocidades de procesamiento de datos casi óptimas.

Si decide especificar más de 2 particiones, también puede especificar una columna para particionar los datos. El tipo de valores de la columna debe ser numérico o de fecha.

Se recomienda usar particiones solo si comprende la estructura de los datos y cómo se procesan.

Puede importar todo el conjunto de datos o tomar una muestra de una parte del mismo. Para una base de datos de Databricks, proporciona las siguientes opciones de muestreo:

-

Ninguno: se importa todo el conjunto de datos.

-

Primeros K: toma una muestra de las primeras filas K del conjunto de datos, donde K es un número entero que especifique.

-

Aleatorio: toma una muestra aleatoria del tamaño que especifique.

-

Estratificado: toma una muestra aleatoria estratificada. Una muestra estratificada conserva la relación de valores de una columna.

Utilice el siguiente procedimiento para importar datos de una base de datos de Databricks.

Para importar datos de Databricks, haga lo siguiente.

-

Inicia sesión en Amazon SageMaker AI Console

. -

Elija Studio.

-

Elija Lanzar aplicación.

-

En la lista desplegable, seleccione Studio.

-

En la pestaña Importar datos de su flujo de Data Wrangler, elija Databricks.

-

Especifique los siguientes campos:

-

Nombre del conjunto de datos: un nombre que desee usar para el conjunto de datos en el flujo de Data Wrangler.

-

Controlador: com.simba.spark.jdbc.Driver.

-

URL de JDBC: la URL de la base de datos de Databricks. El formato de la URL puede variar entre las instancias de Databricks. Para obtener información sobre cómo encontrar la URL y especificar los parámetros que contiene, consulte JDBC configuration and connection parameters

. El siguiente es un ejemplo de cómo se puede formatear una URL: jdbc:spark://aws-sagemaker-datawrangler.cloud.databricks.com:443/default; transportMode=http; ssl=1; HttpPath= /3122619508517275/0909-200301-cut318; =3; UID=; PWD=. sql/protocolv1/o AuthMech tokenpersonal-access-tokennota

Puede especificar el ARN del secreto que contenga la URL de JDBC en lugar de especificar la propia URL de JDBC. El secreto debe contener un par clave-valor con el siguiente formato:

jdbcURL:. Para obtener más información, consulte ¿Qué es Secrets Manager?JDBC-URL

-

-

Especifique una instrucción SQL SELECT.

nota

Data Wrangler no admite expresiones de tabla común (CTE) ni tablas temporales dentro de una consulta.

-

En muestreo, elija un método de muestreo.

-

Seleccione Ejecutar.

-

De forma opcional, en VISTA PREVIA, elija el engranaje para abrir la Configuración de la partición.

-

Especifique el número de particiones. Puede particionar por columna si especifica el número de particiones:

-

Ingrese el número de particiones: especifique un valor superior a 2.

-

(Opcional) Partición por columna: especifique los siguientes campos. Solo puede particionar por una columna si ha especificado un valor para Ingresar número de particiones.

-

Seleccionar columna: seleccione la columna que va a utilizar para la partición de datos. El tipo de valores de la columna debe ser numérico o de fecha.

-

Límite superior: el límite superior de los valores de la columna que ha especificado es el valor que utiliza en la partición. El valor que especifique no cambia los datos que importe. Solo afecta a la velocidad de la importación. Para obtener el mejor rendimiento, especifique un límite superior cercano al máximo de la columna.

-

Límite inferior: el límite inferior de los valores de la columna que ha especificado es el valor que utiliza en la partición. El valor que especifique no cambia los datos que importe. Solo afecta a la velocidad de la importación. Para obtener el mejor rendimiento, especifique un límite inferior cercano al mínimo de la columna.

-

-

-

-

Seleccione Importar.

Importación de datos de Salesforce Data Cloud.

Puede utilizar Salesforce Data Cloud como fuente de datos en Amazon SageMaker Data Wrangler para preparar los datos de su Salesforce Data Cloud para el aprendizaje automático.

Con Salesforce Data Cloud como origen de datos en Data Wrangler, puede conectarse rápidamente a los datos de Salesforce sin necesidad de escribir una sola línea de código. Puede unir sus datos de Salesforce con datos de cualquier otro origen de datos en Data Wrangler.

Una vez que se conecte a la nube de datos, puede hacer lo siguiente:

-

Visualizar los datos con visualizaciones integradas

-

Comprender los datos e identificar posibles errores y valores extremos

-

Transformar los datos con más de 300 transformaciones integradas

-

Exportar los datos que ha transformado

Configuración de administrador

importante

Antes de empezar, asegúrese de que sus usuarios utilizan Amazon SageMaker Studio Classic versión 1.3.0 o posterior. Para obtener más información sobre cómo comprobar la versión de Studio Classic y cómo actualizarla, consulte Prepare datos de aprendizaje automático con Amazon SageMaker Data Wrangler.

Al configurar el acceso a Salesforce Data Cloud, debe completar las siguientes tareas:

-

Obtener la URL del dominio de Salesforce. Salesforce también hace referencia a la URL del dominio como URL de la organización.

-

Obtener OAuth credenciales de Salesforce.

-

Obtener la URL de autorización y la URL del token del dominio de Salesforce.

-

Crear un AWS Secrets Manager secreto con la OAuth configuración.

-

Crear una configuración de ciclo de vida que Data Wrangler utilizará para leer las credenciales del secreto.

-

Otorgar permisos a Data Wrangler para leer el secreto.

Tras realizar las tareas anteriores, sus usuarios pueden iniciar sesión en Salesforce Data Cloud mediante OAuth.

nota

Es posible que sus usuarios tengan problemas una vez que haya configurado todo esto. Para obtener más información acerca de la solución de problemas, consulte Solución de problemas con Salesforce.

Utilice el siguiente procedimiento para obtener la URL del dominio.

-

Vaya a la página de inicio de sesión de Salesforce.

-

En Quick find, especifique My Domain.

-

Copie el valor de Current My Domain URL en un archivo de texto.

-

Agregue

https://al principio de la URL.

Tras obtener la URL del dominio de Salesforce, puede utilizar el siguiente procedimiento para obtener las credenciales de inicio de sesión de Salesforce y permitir que Data Wrangler acceda a los datos de Salesforce.

Para obtener las credenciales de inicio de sesión de Salesforce y proporcionar acceso a Data Wrangler, haga lo siguiente.

-

Vaya a la URL del dominio de Salesforce e inicie sesión en su cuenta.

-

Seleccione el ícono de la rueda.

-

En la barra de búsqueda que aparece, especifique App Manager.

-

Seleccione New Connected App.

-

Especifique los siguientes campos:

-

Nombre de la aplicación conectada: puede especificar cualquier nombre, pero se recomienda elegir uno que incluya Data Wrangler. Por ejemplo, puede especificar Integración de Salesforce Data Cloud y Data Wrangler.

-

Nombre de la API: utilice el valor predeterminado.

-

Correo electrónico de contacto: especifique su dirección de correo electrónico.

-

En el encabezado API (Habilitar OAuth configuración), seleccione la casilla de verificación para activar OAuth la configuración.

-

En la URL de devolución de llamada, especifique la URL de Amazon SageMaker Studio Classic. Para obtener la URL de Studio Classic, acceda a ella desde AWS Management Console y cópiela.

-

-

En OAuth Ámbitos seleccionados, mueva lo siguiente de los ámbitos disponibles a OAuth los ámbitos seleccionados OAuth:

-

Administre los datos de los usuarios mediante () APIs

api -

Realizar solicitudes en cualquier momento (

refresh_token,offline_access) -

Realizar consultas SQL ANSI en los datos de Salesforce Data Cloud (

cdp_query_api) -

Administrar los datos de perfil de la plataforma de datos de clientes de Salesforce (

cdp_profile_api)

-

-

Seleccione Guardar. Tras guardar los cambios, Salesforce abre una página nueva.

-

Elija Continue

-

Vaya a Consumer Key and Secret.

-

Elija Manage Consumer Details. Salesforce lo redirige a una nueva página en la que puede que tendrá que superar una autenticación de dos factores.

-

importante

Copie la clave del consumidor y el secreto del consumidor en un editor de texto. Necesitará esta información para conectar la nube de datos a Data Wrangler.

-

Vuelva a Manage Connected Apps.

-

Vaya Connected App Name y el nombre de su aplicación.

-

Elija Administrar.

-

Seleccione Edit Policies.

-

Cambie IP Relaxation a Relax IP restrictions.

-

Seleccione Guardar.

-

Después de proporcionar acceso a su Salesforce Data Cloud, debe proporcionar permisos a sus usuarios. Utilice el siguiente procedimiento para concederles permisos.

Para proporcionar permisos a los usuarios, haga lo siguiente.

-

Diríjase a la página de inicio de configuración.

-

En la barra de navegación de la izquierda, busque Users y elija la opción de menú Users.

-

Elija el hipervínculo con su nombre de usuario.

-

Vaya a Permission Set Assignments.

-

Elija Edit Assignments.

-

Agregue los siguientes permisos:

-

Customer Data Platform Admin

-

Customer Data Platform Data Aware Specialist

-

-

Seleccione Guardar.

Después de obtener la información de su dominio de Salesforce, debe obtener la URL de autorización y la URL del token del AWS Secrets Manager secreto que está creando.

Utilice el procedimiento siguiente para obtener la URL de autorización y la URL del token.

Para obtener la URL de autorización y la URL del token

-

Vaya a la URL de su dominio de Salesforce.

-

Utilice uno de los siguientes métodos para obtener el URLs. Si utiliza una distribución de Linux con

curlyjqinstalados, se recomienda utilizar el método que solo funciona en Linux.-

Solo en Linux, especifique el siguiente comando en su terminal.

curlsalesforce-domain-URL/.well-known/openid-configuration | \ jq '. | { authorization_url: .authorization_endpoint, token_url: .token_endpoint }' | \ jq '. += { identity_provider: "SALESFORCE", client_id: "example-client-id", client_secret: "example-client-secret" }' -

-

Navegue hasta

example-org-URL/.well-known/openid-configuration -

Copie

authorization_endpointytoken_endpointa un editor de texto. -

Cree el siguiente objeto JSON:

{ "identity_provider": "SALESFORCE", "authorization_url": "example-authorization-endpoint", "token_url": "example-token-endpoint", "client_id": "example-consumer-key", "client_secret": "example-consumer-secret" }

-

-

Tras crear el objeto OAuth de configuración, puede crear un AWS Secrets Manager secreto que lo almacene. Utilice el siguiente procedimiento para crear el secreto.

Para crear un secreto, haga lo siguiente:

-

Vaya a la consola de AWS Secrets Manager

. -

Elija Almacenar un secreto.

-

Seleccione Otro tipo de secreto.

-

En pares clave-valor, seleccione Texto sin formato.

-

Sustituya el JSON vacío por los siguientes ajustes de configuración.

{ "identity_provider": "SALESFORCE", "authorization_url": "example-authorization-endpoint", "token_url": "example-token-endpoint", "client_id": "example-consumer-key", "client_secret": "example-consumer-secret" } -

Elija Next (Siguiente).

-

En Nombre del secreto, especifique el nombre del secreto.

-

En Etiquetas, elija Agregar.

-

En Clave, especifique sagemaker:partner. En Valor, se recomienda especificar un valor que sea útil para su caso de uso. Sin embargo, puede especificar cualquier cosa.

importante

Tiene que crear la clave. No puede importar sus datos de Salesforce si no los ha creado.

-

-

Elija Next (Siguiente).

-

Elija Almacenar.

-

Elija el secreto que ha creado.

-

Tome nota de los siguientes campos:

-

El número de recurso de Amazon (ARN) del secreto

-

El nombre del secreto.

-

Una vez creado el secreto, debe agregar permisos para que Data Wrangler lo lea. Utilice el siguiente procedimiento para agregar permisos.

Para agregar permisos de lectura a Data Wrangler, haga lo siguiente.

-

Navega hasta la consola Amazon SageMaker AI

. -

Elija Dominios.

-

Elija el dominio que utiliza para acceder a Data Wrangler.

-

Elija su Perfil de usuario.

-

En Detalles, busque el Rol de ejecución. El ARN tiene el siguiente formato:

arn:aws:iam::111122223333:role/. Tome nota de la función de ejecución de la SageMaker IA. Dentro de la ARN, es todo lo que viene después deexample-rolerole/. -

Vaya a la consola de IAM

. -

En la barra de búsqueda de IAM de Search, especifique el nombre de la función de ejecución de la SageMaker IA.

-

Elija el rol .

-

Elija Añadir permisos.

-

Elija Crear política insertada.

-

Seleccione la pestaña JSON.

-

Especifique la siguiente política en el editor.

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "secretsmanager:GetSecretValue", "secretsmanager:PutSecretValue" ], "Resource": "arn:aws:secretsmanager:*:*:secret:*", "Condition": { "ForAnyValue:StringLike": { "aws:ResourceTag/sagemaker:partner": "*" } } }, { "Effect": "Allow", "Action": [ "secretsmanager:UpdateSecret" ], "Resource": "arn:aws:secretsmanager:*:*:secret:AmazonSageMaker-*" } ] } -

Elija Revisar la política.

-

En Nombre, especifique un nombre.

-

Elija Crear política.

Tras conceder a Data Wrangler los permisos para leer el secreto, debe añadir una configuración del ciclo de vida que utilice el secreto de Secrets Manager a su perfil de usuario de Amazon SageMaker Studio Classic.

Utilice el siguiente procedimiento para crear una configuración de ciclo de vida y añadirla al perfil de Studio Classic.

Para crear una configuración de ciclo de vida y añadirla al perfil de Studio Classic, haga lo siguiente.

-

Navega hasta la consola Amazon SageMaker AI.

-

Elija Dominios.

-

Elija el dominio que utiliza para acceder a Data Wrangler.

-

Elija su Perfil de usuario.

-

Si ve las siguientes aplicaciones, elimínelas:

-

KernelGateway

-

JupyterKernel

nota

Al eliminar las aplicaciones, Studio Classic se actualiza. Las actualizaciones pueden tardar un poco.

-

-

Mientras espera a que se produzcan las actualizaciones, elija las Configuraciones de ciclo de vida.

-

Asegúrese de que la página en la que se encuentra indique Configuraciones del ciclo de vida de Studio Classic.

-

Seleccione Crear configuración.

-

Asegúrese de que se haya seleccionado la Aplicación de servidor de Jupyter.

-

Elija Next (Siguiente).

-

En Nombre, especifique un nombre para la configuración.

-

En Scripts, especifique el siguiente script:

#!/bin/bash set -eux cat > ~/.sfgenie_identity_provider_oauth_config <<EOL { "secret_arn": "secrets-arn-containing-salesforce-credentials" } EOL -

Seleccione Submit (Enviar).

-

En el panel de navegación izquierdo, elija Dominios.

-

Seleccione su dominio.

-

Seleccione Entorno.

-

En Configuraciones de ciclo de vida para aplicaciones de Studio Classic personales, elija Asociar.

-

Seleccione Configuración existente.

-

En Configuraciones del ciclo de vida de Studio Classic, seleccione la configuración del ciclo de vida que ha creado.

-

Elija Asociar al dominio.

-

Seleccione la casilla situada junto a la configuración del ciclo de vida que ha asociado.

-

Seleccione Establecer como predeterminado.

Podría tener problemas al configurar el ciclo de vida. Para obtener información para depurarlo, consulte Depuración de configuraciones del ciclo de vida.

Guía para científicos de datos

Utilice lo siguiente para conectarse a Salesforce Data Cloud y acceder a sus datos en Data Wrangler.

importante

Su administrador tiene que usar la información de las secciones anteriores para configurar Salesforce Data Cloud. Si tiene problemas, póngase en contacto con ellos para obtener ayuda con la solución de problemas.

Para abrir Studio Classic y comprobar su versión, consulte el siguiente procedimiento.

-

Sigue los pasos que se indican Requisitos previos a continuación para acceder a Data Wrangler a través de Amazon SageMaker Studio Classic.

-

Junto al usuario que desee utilizar para inicializar Studio Classic, seleccione Lanzar aplicación.

-

Elija Studio.

Para crear un conjunto de datos en Data Wrangler con datos de Salesforce Data Cloud

-

Inicia sesión en Amazon SageMaker AI Console

. -

Elija Studio.

-

Elija Lanzar aplicación.

-

En la lista desplegable, seleccione Studio.

-

Elija el icono Inicio.

-

Elija Datos.

-

Elija Data Wrangler.

-

Elija Importar datos.

-

En Disponible, seleccione Salesforce Data Cloud.

-

En Nombre de la conexión, especifique un nombre para su conexión a Salesforce Data Cloud.

-

En URL de la organización, especifique la URL de la organización en su cuenta de Salesforce. Puede obtener la URL de sus administradores.

-

Elija Conectar.

-

Especifique sus credenciales para iniciar sesión en Salesforce.

Puede empezar a crear un conjunto de datos con datos de Salesforce Data Cloud después de conectarse.

Una vez que seleccione una tabla, puede escribir consultas y ejecutarlas. El resultado de la consulta se muestra en Resultados de la consulta.

Una vez que haya establecido el resultado de la consulta, puede importarlo a un flujo de Data Wrangler para realizar transformaciones de datos.

Una vez que haya creado un conjunto de datos, vaya a hasta la pantalla Flujo de datos para empezar a transformar los datos.

Importación de datos de Snowflake

Puede usar Snowflake como fuente de datos en Data Wrangler para preparar SageMaker los datos de Snowflake para el aprendizaje automático.

Con Snowflake como origen de datos en Data Wrangler, puede conectarse rápidamente a Snowflake sin escribir una sola línea de código. Puede unir sus datos de Snowflake con datos de cualquier otro origen de datos en Data Wrangler.

Una vez conectado, puede consultar de forma interactiva los datos almacenados en Snowflake, transformarlos con más de 300 transformaciones de datos preconfiguradas, comprender los datos e identificar posibles errores y valores extremos con un conjunto de sólidas plantillas de visualización preconfiguradas, identificar rápidamente las incoherencias en el flujo de trabajo de preparación de datos y diagnosticar los problemas antes de implementar los modelos en producción. Por último, puede exportar su flujo de trabajo de preparación de datos a Amazon S3 para usarlo con otras funciones de SageMaker IA, como Amazon SageMaker Autopilot, Amazon SageMaker Feature Store y Amazon SageMaker Pipelines.

Puede cifrar el resultado de sus consultas con una AWS Key Management Service clave que haya creado. Para obtener más información al respecto AWS KMS, consulte AWS Key Management Service.

Guía del administrador

importante

Para obtener más información sobre el control de acceso detallado y las prácticas recomendadas, consulte Security Access Control

Esta sección es para los administradores de Snowflake que están configurando el acceso a Snowflake desde Data Wrangler. SageMaker

importante

Usted es responsable de administrar y supervisar el control de acceso de Snowflake. Data Wrangler no agrega una capa de control de acceso con respecto a Snowflake.

El control de acceso incluye lo siguiente:

-

Los datos a los que accede un usuario

-

De forma opcional, la integración de almacenamiento que proporciona a Snowflake la capacidad de escribir los resultados de consultas en un bucket de Amazon S3

-

Las consultas que un usuario puede ejecutar

Configuración de permisos de importación de datos de Snowflake (opcional)

De forma predeterminada, Data Wrangler consulta los datos en Snowflake sin crear una copia de los mismos en una ubicación de Amazon S3. Utilice la siguiente información si va a configurar una integración de almacenamiento con Snowflake. Los usuarios pueden usar una integración de almacenamiento para almacenar los resultados de las consultas en una ubicación de Amazon S3.

Es posible que los usuarios tengan diferentes niveles de acceso a los datos confidenciales. Para lograr una seguridad de datos óptima, proporcione a cada usuario su propia integración de almacenamiento. Cada integración de almacenamiento debe tener su propia política de gobierno de datos.

Esta característica no está disponible actualmente en la región de suscripción voluntaria.

Snowflake necesita los siguientes permisos en un bucket y un directorio de S3 para poder acceder a los archivos del directorio:

-

s3:GetObject -

s3:GetObjectVersion -

s3:ListBucket -

s3:ListObjects -

s3:GetBucketLocation

Creación de una política de IAM

Tiene que crear una política de IAM para configurar los permisos de acceso para que Snowflake cargue y descargue datos de un bucket de Amazon S3.

A continuación, encontrará un documento de política de JSON que se utiliza para crear la política:

# Example policy for S3 write access # This needs to be updated { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "s3:PutObject", "s3:GetObject", "s3:GetObjectVersion", "s3:DeleteObject", "s3:DeleteObjectVersion" ], "Resource": "arn:aws:s3:::bucket/prefix/*" }, { "Effect": "Allow", "Action": [ "s3:ListBucket" ], "Resource": "arn:aws:s3:::bucket/", "Condition": { "StringLike": { "s3:prefix": ["prefix/*"] } } } ] }

Para obtener información y procedimientos sobre la creación de políticas con documentos de políticas, consulte Crear políticas de IAM.

Para ver la documentación que proporciona una descripción general del uso de los permisos de IAM con Snowflake, consulte los siguientes recursos:

Para conceder al científico de datos el permiso de uso del rol de Snowflake para la integración del almacenamiento, debe ejecutar GRANT USAGE ON INTEGRATION

integration_name TO snowflake_role;.

-

integration_namees el nombre de la integración de almacenamiento. -

snowflake_rolees el nombre del rol de Snowflakepredeterminado que se asigna al científico de datos.

Configuración de Snowflake Access OAuth

En lugar de hacer que los usuarios introduzcan directamente sus credenciales en Data Wrangler, puede hacer que usen un proveedor de identidades para acceder a Snowflake. Los siguientes son enlaces a la documentación de Snowflake para los proveedores de identidades compatibles con Data Wrangler.

Utilice la documentación de los enlaces anteriores para configurar el acceso a su proveedor de identidades. La información y los procedimientos de esta sección le ayudarán a entender cómo utilizar correctamente la documentación para acceder a Snowflake desde Data Wrangler.

El proveedor de identidades debe reconocer a Data Wrangler como una aplicación. Utilice el siguiente procedimiento para registrar Data Wrangler como una aplicación dentro del proveedor de identidades:

-

Seleccione la configuración que inicia el proceso de registro de Data Wrangler como aplicación.

-

Proporcione acceso a Data Wrangler a los usuarios del proveedor de identidades.

-

Active la autenticación OAuth del cliente almacenando las credenciales del cliente como un AWS Secrets Manager secreto.

-

Especifique una URL de redireccionamiento con el siguiente formato: https://

domain-ID.studio.Región de AWS.sagemaker. aws/jupyter/default/labimportante

Estás especificando el ID de dominio de Amazon SageMaker AI y Región de AWS que estás utilizando para ejecutar Data Wrangler.

importante

Debes registrar una URL para cada dominio de Amazon SageMaker AI y para el Región de AWS lugar en el que ejecutes Data Wrangler. Los usuarios de un dominio Región de AWS que no tengan URLs configurada la redirección no podrán autenticarse con el proveedor de identidad para acceder a la conexión de Snowflake.

-

Asegúrese de que los tipos de concesión de código de autorización y token de actualización estén permitidos para la aplicación Data Wrangler.

En tu proveedor de identidad, debes configurar un servidor que envíe los OAuth tokens a Data Wrangler a nivel de usuario. El servidor envía los tokens con Snowflake como público.

Snowflake utiliza el concepto de funciones que son funciones distintas de las funciones de IAM utilizadas. AWS Debe configurar el proveedor de identidades para que utilice cualquier rol a fin de usar el rol predeterminado asociado a la cuenta de Snowflake. Por ejemplo, si un usuario tiene systems administrator como rol predeterminado en su perfil de Snowflake, la conexión de Data Wrangler a Snowflake utiliza systems administrator como rol.

Utilice el siguiente procedimiento para configurar el servidor.

Para configurar el servidor, haga lo siguiente: Trabajará en Snowflake en todos los pasos excepto en el último.

-

Comience a configurar el servidor o la API.

-

Configure el servidor de autorización para que utilice los tipos de concesión de código de autorización y token de actualización.

-

Especifique la duración del token de acceso.

-

Establezca el tiempo de espera de inactividad del token de actualización. El tiempo de espera de inactividad es el momento en que el token de actualización vence si no se utiliza.

nota

Si va a programar trabajos en Data Wrangler, se recomienda que el tiempo de espera de inactividad sea mayor que la frecuencia del trabajo de procesamiento. De lo contrario, algunos trabajos de procesamiento podrían producir un error porque el token de actualización vence antes de que pudieran ejecutarse. Cuando el token de actualización vence, el usuario debe volver a autenticarse accediendo a la conexión que ha establecido con Snowflake a través de Data Wrangler.

-

Especifique

session:role-anycomo nuevo ámbito.nota

En el caso de Azure AD, copie el identificador único del ámbito. Data Wrangler requiere que le proporcione el identificador.

-

importante

En la integración de OAuth seguridad externa de Snowflake, habilite.

external_oauth_any_role_mode

importante

Data Wrangler no admite los tokens de actualización rotativos. El uso de tokens de actualización rotativos puede provocar errores de acceso o que los usuarios tengan que iniciar sesión con frecuencia.

importante

Si el token de actualización vence, los usuarios deben volver a autenticarse accediendo a la conexión que ha establecido con Snowflake a través de Data Wrangler.

Después de configurar el OAuth proveedor, proporciona a Data Wrangler la información que necesita para conectarse con el proveedor. Puede usar la documentación de su proveedor de identidades para obtener los valores de los siguientes campos:

-

URL del token: la URL del token que el proveedor de identidades envía a Data Wrangler.

-

URL de autorización: la URL del servidor de autorización del proveedor de identidades.

-

ID de cliente: el ID del proveedor de identidades.

-

Secreto de cliente: el secreto que solo reconoce la API o el servidor de autorización.

-

(Solo en Azure AD) Las credenciales del OAuth ámbito que has copiado.

Los campos y valores se almacenan en AWS Secrets Manager secreto y se añaden a la configuración del ciclo de vida de Amazon SageMaker Studio Classic que se utiliza para Data Wrangler. Una configuración del ciclo de vida es un script de intérprete de comandos. Se utiliza para que Data Wrangler pueda acceder al nombre de recurso de Amazon (ARN) del secreto. Para obtener información sobre cómo crear secretos, consulte Mover secretos codificados a. AWS Secrets Manager Para obtener más información sobre el uso de las configuraciones de ciclo de vida en Studio Classic, consulte Uso de las configuraciones del ciclo de vida para personalizar Studio Classic.

importante

Antes de crear un secreto de Secrets Manager, asegúrate de que el rol de ejecución de SageMaker IA que utilizas para Amazon SageMaker Studio Classic tenga permisos para crear y actualizar secretos en Secrets Manager. Para obtener más información, consulte Ejemplo: permiso para crear secretos.

Para Okta y Ping Federate, el formato del secreto es el siguiente:

{ "token_url":"https://identityprovider.com/oauth2/example-portion-of-URL-path/v2/token", "client_id":"example-client-id", "client_secret":"example-client-secret", "identity_provider":"OKTA"|"PING_FEDERATE", "authorization_url":"https://identityprovider.com/oauth2/example-portion-of-URL-path/v2/authorize" }

Para Azure AD, el formato del secreto es el siguiente:

{ "token_url":"https://identityprovider.com/oauth2/example-portion-of-URL-path/v2/token", "client_id":"example-client-id", "client_secret":"example-client-secret", "identity_provider":"AZURE_AD", "authorization_url":"https://identityprovider.com/oauth2/example-portion-of-URL-path/v2/authorize", "datasource_oauth_scope":"api://appuri/session:role-any)" }

Debe tener una configuración de ciclo de vida que utilice el secreto de Secrets Manager que ha creado. Puede crear la configuración del ciclo de vida o modificar una que ya se haya creado. La configuración debe usar el siguiente script.

#!/bin/bash set -eux ## Script Body cat > ~/.snowflake_identity_provider_oauth_config <<EOL { "secret_arn": "example-secret-arn" } EOL

Para obtener información sobre la definición de las configuraciones de ciclo de vida, consulte Creación y asociación de una configuración del ciclo de vida. Cuando realice el proceso de configuración, haga lo siguiente:

-

Defina el tipo de aplicación de la configuración en

Jupyter Server. -

Adjunta la configuración al dominio de Amazon SageMaker AI que contiene tus usuarios.

-

Haga que la configuración se ejecute de forma predeterminada. Debe ejecutarse cada vez que un usuario inicie sesión en Studio Classic. De lo contrario, las credenciales guardadas en la configuración no estarán disponibles para sus usuarios cuando usen Data Wrangler.

-

La configuración del ciclo de vida crea un archivo con el nombre

snowflake_identity_provider_oauth_configen la carpeta principal del usuario. El archivo contiene el secreto de Secrets Manager. Asegúrese de que esté en la carpeta de inicio del usuario cada vez que se inicialice la instancia del servidor de Jupyter.

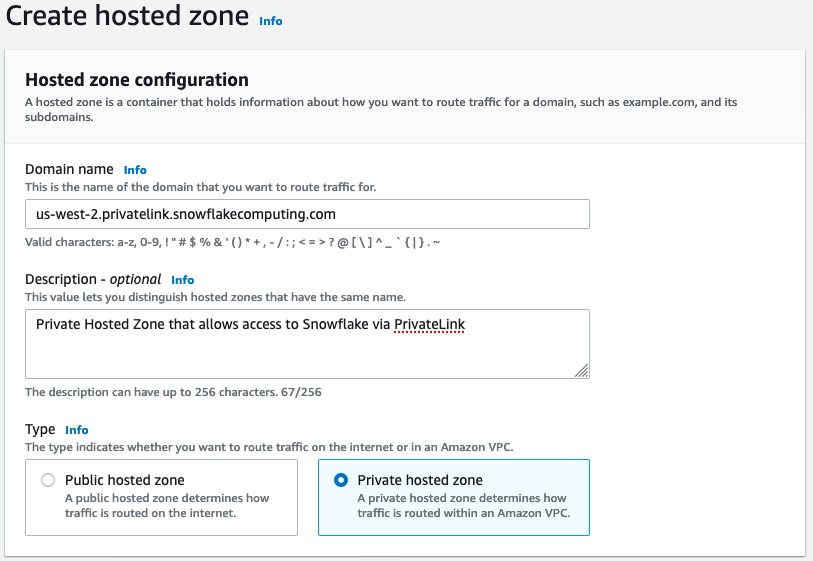

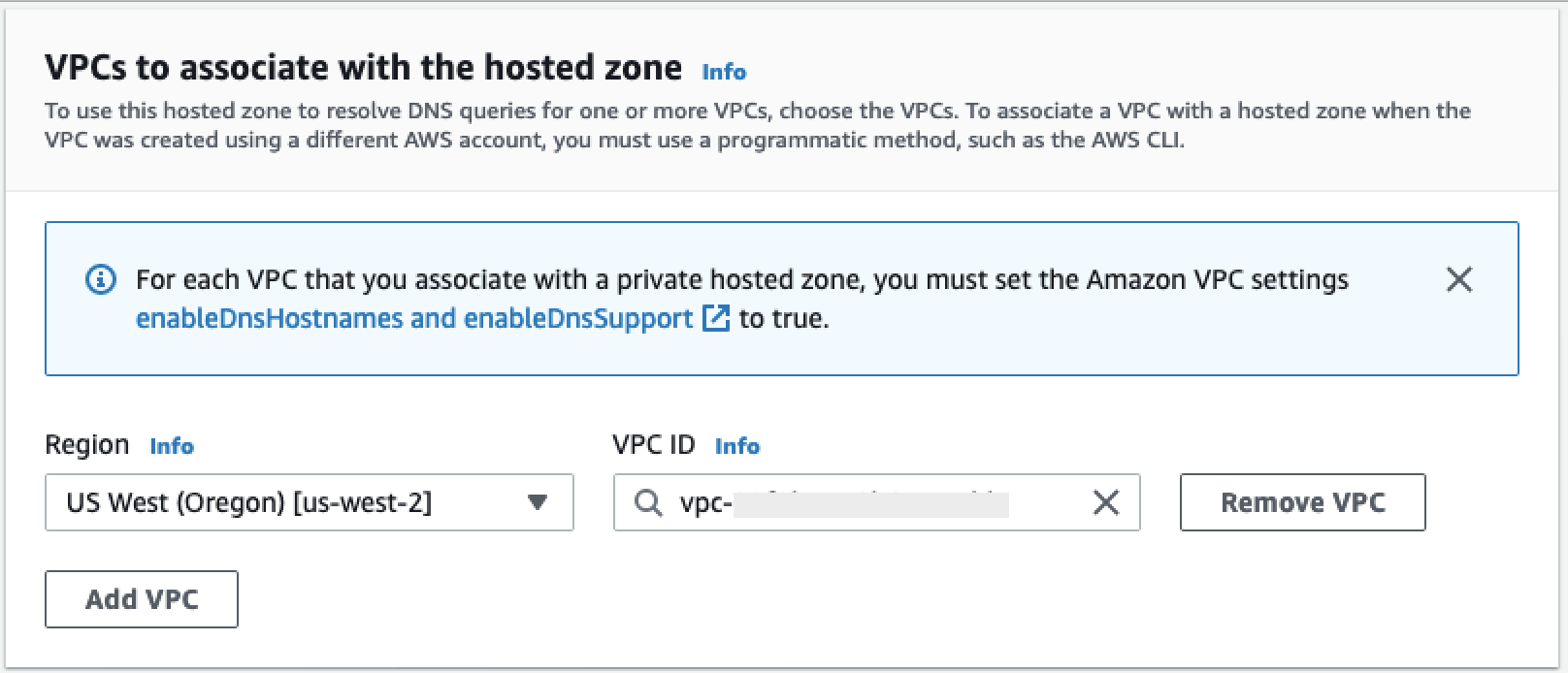

Conectividad privada entre Data Wrangler y Snowflake a través de AWS PrivateLink

En esta sección se explica cómo establecer una conexión privada entre Data Wrangler y Snowflake. AWS PrivateLink Los pasos se explican en las siguientes secciones.

Creación de una VPC

Si no tiene una VPC configurada, siga las instrucciones de Create a new VPC para crear una.

Una vez que haya elegido la VPC que desee utilizar para establecer una conexión privada, proporcione las siguientes credenciales al administrador de Snowflake para que habilite AWS PrivateLink:

-

ID de VPC

-

AWS ID de cuenta

-

La URL de la cuenta correspondiente que utiliza para acceder a Snowflake

importante

Como se describe en la documentación de Snowflake, la activación de la cuenta de Snowflake puede tardar hasta dos días laborables.

Configuración de la integración de AWS PrivateLink con Snowflake

Una vez AWS PrivateLink activado, recupere la AWS PrivateLink configuración de su región ejecutando el siguiente comando en una hoja de trabajo de Snowflake. Inicie sesión en la consola de Snowflake e introduzca lo siguiente en las Hojas de trabajo: select

SYSTEM$GET_PRIVATELINK_CONFIG();.

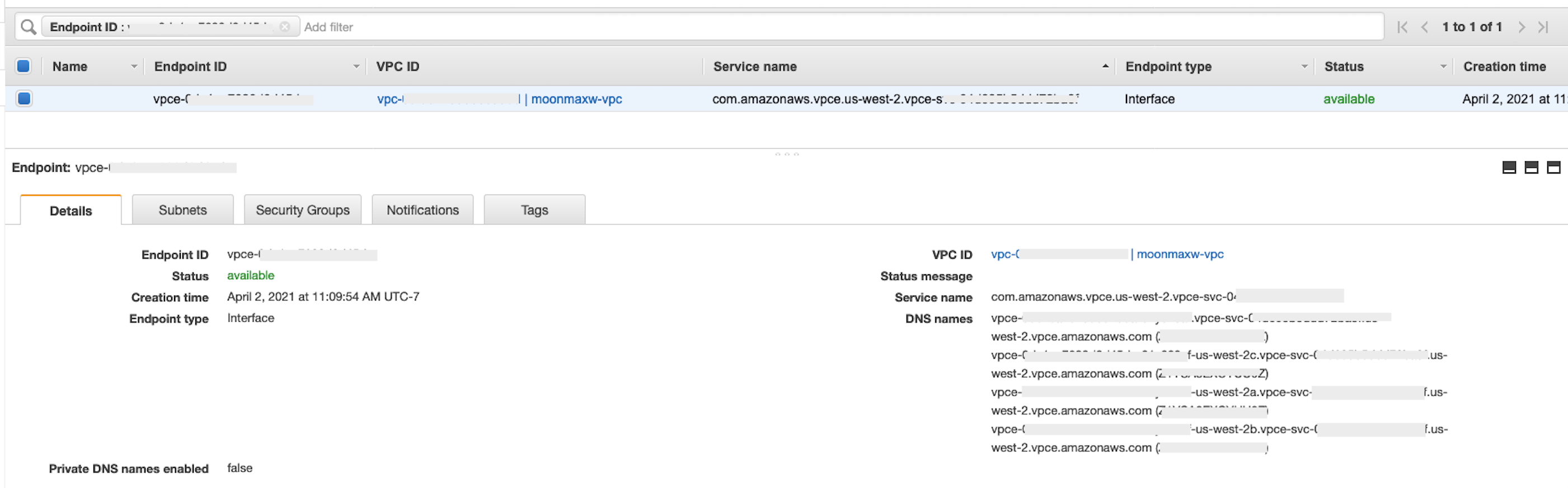

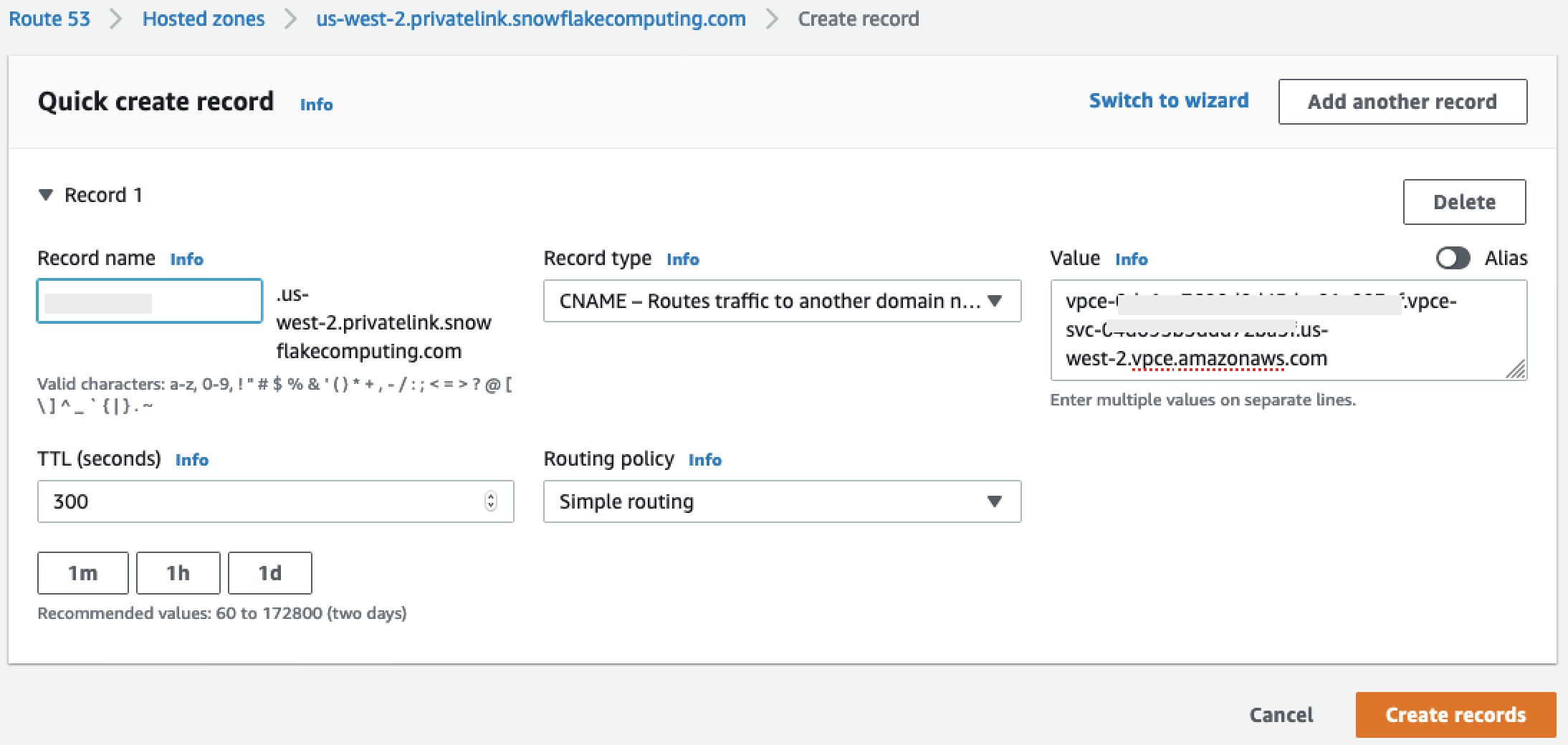

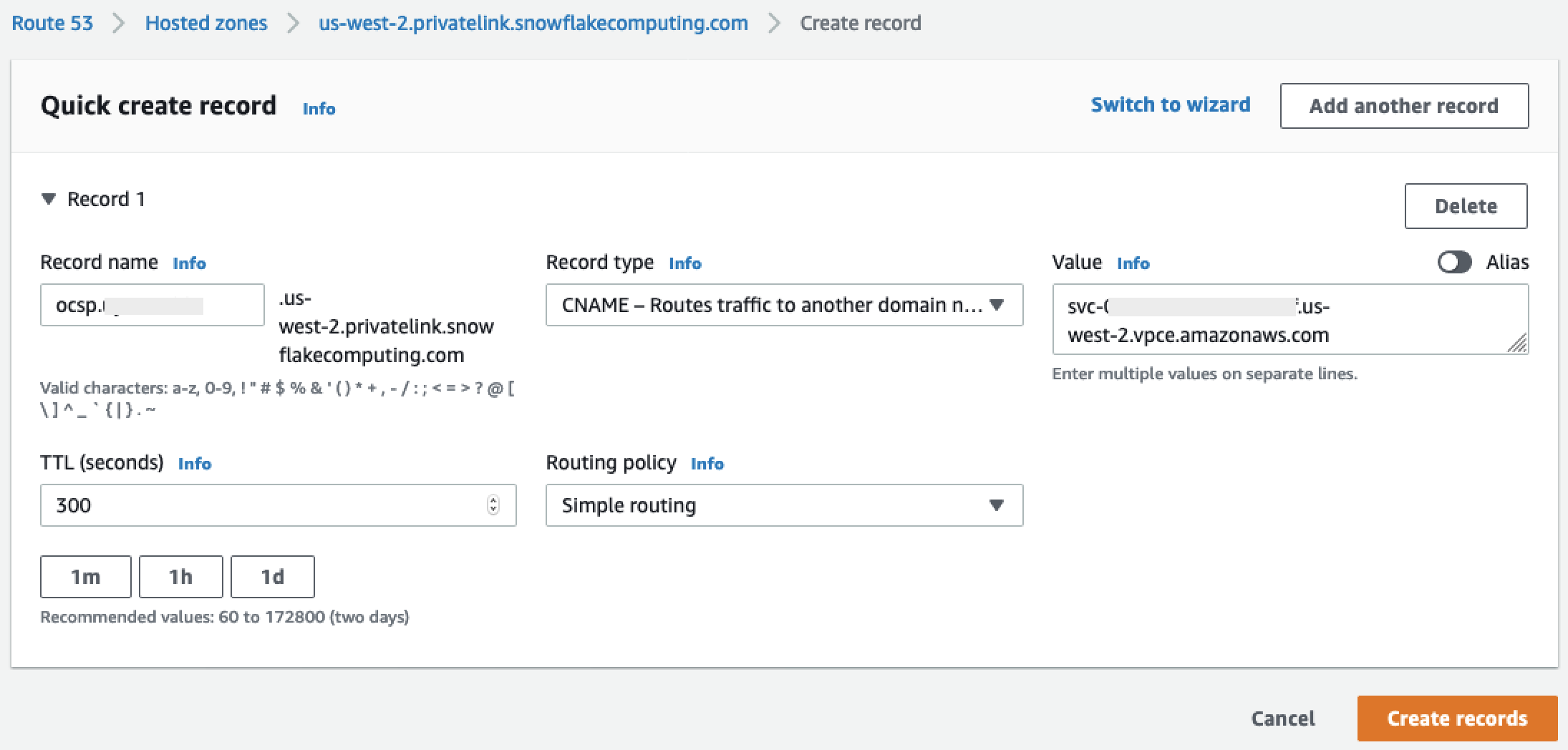

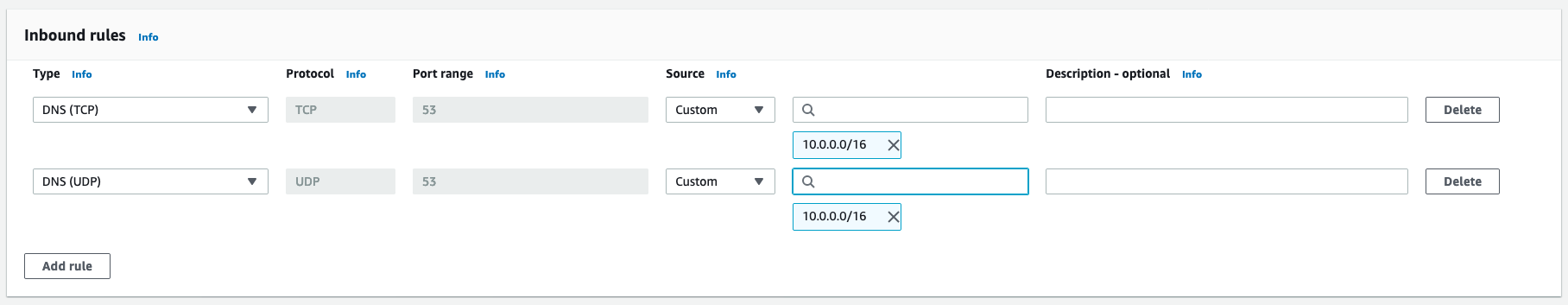

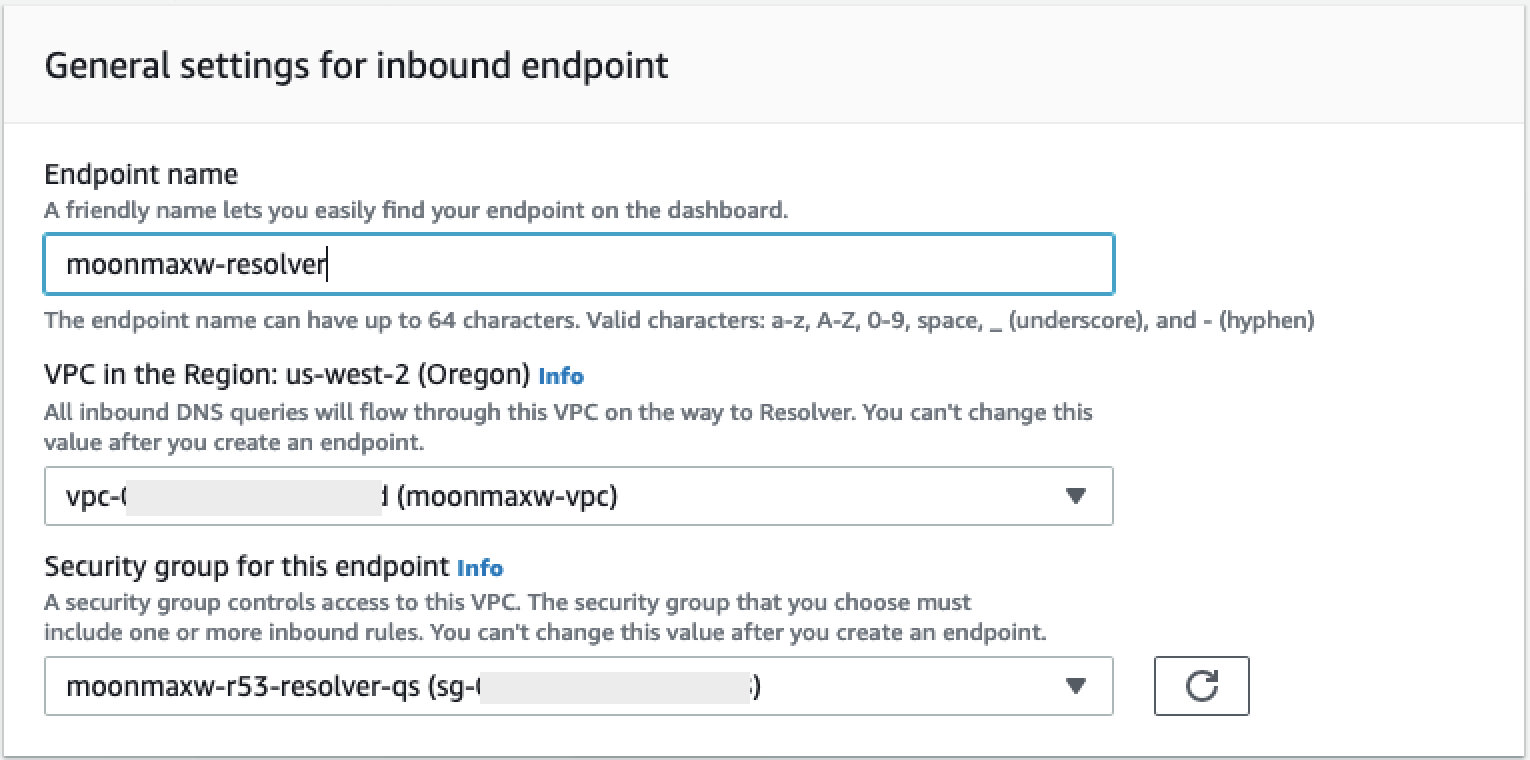

-

Recupere los valores de lo siguiente:

privatelink-account-name,privatelink_ocsp-url,privatelink-account-urlyprivatelink_ocsp-urldel objeto JSON resultante. En el siguiente fragmento de código se muestran ejemplos de cada valor. Guarde estos valores para usarlos más adelante.privatelink-account-name: xxxxxxxx.region.privatelink privatelink-vpce-id: com.amazonaws.vpce.region.vpce-svc-xxxxxxxxxxxxxxxxx privatelink-account-url: xxxxxxxx.region.privatelink.snowflakecomputing.com privatelink_ocsp-url: ocsp.xxxxxxxx.region.privatelink.snowflakecomputing.com -

Cambie a su AWS consola y navegue hasta el menú de la VPC.

-

En el panel lateral izquierdo, elija el enlace Puntos de conexión para ir a la configuración de Puntos de conexión de VPC.

Una vez allí, elija Crear punto de conexión.

-

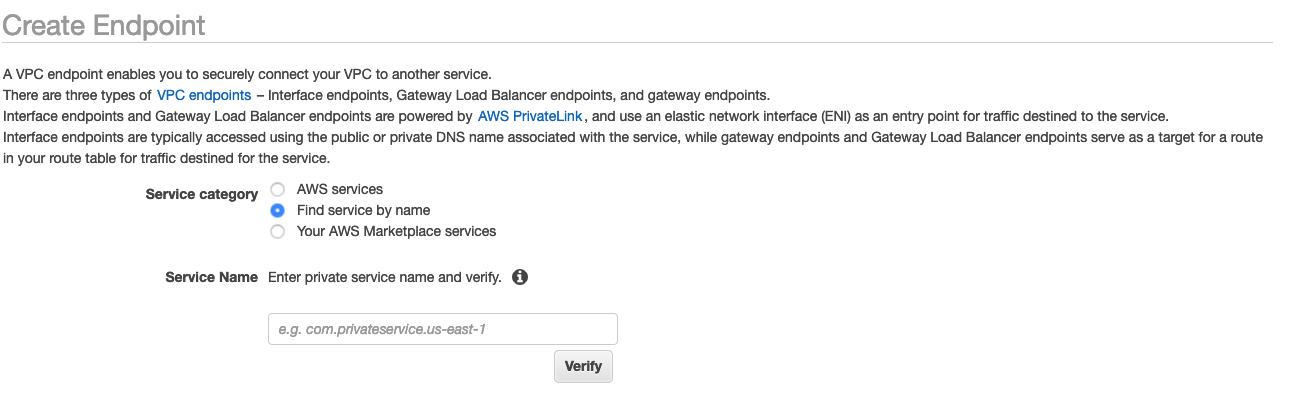

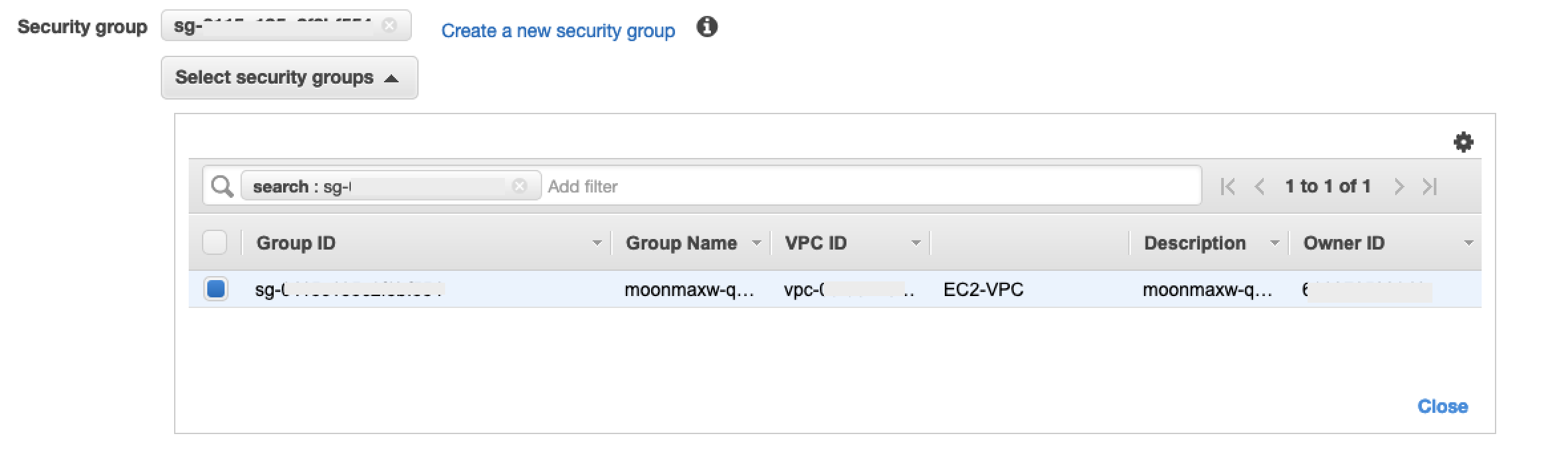

Seleccione el botón de opción para Buscar servicio por nombre, como se muestra en la siguiente captura de pantalla.

-

En el campo Nombre del servicio, pegue el valor de

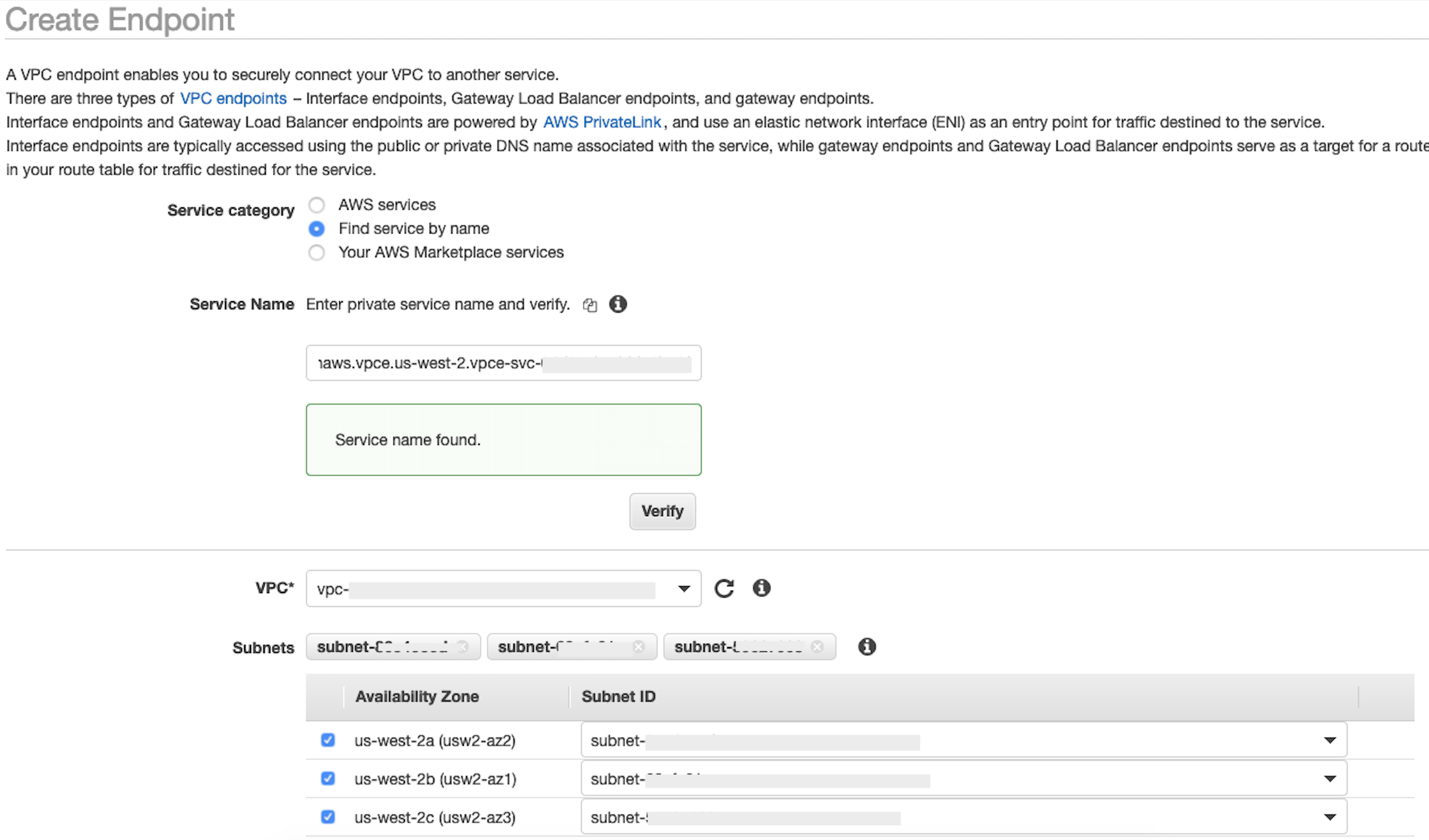

privatelink-vpce-idque recuperó en el paso anterior y elija Verificar.Si la conexión se realiza correctamente, aparece en la pantalla una alerta verde que indica Nombre del servicio encontrado y las opciones VPC y Subred se expanden automáticamente, como se muestra en la siguiente captura de pantalla. En función de la región de destino, es posible que la pantalla resultante muestre el nombre de otra región de AWS .

-

Seleccione el mismo ID de VPC que envió a Snowflake en la lista desplegable VPC.

-

Si aún no ha creado una subred, siga el siguiente conjunto de instrucciones para crear una subred.

-