Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Sécurité et autorisations

Lorsque vous demandez des données à Athena ou Amazon Redshift, le jeu de données demandé est automatiquement stocké dans le compartiment S3 SageMaker par défaut de AWS la région dans laquelle vous utilisez Studio Classic. En outre, lorsque vous exportez un bloc-notes Jupyter depuis Amazon SageMaker Data Wrangler et que vous l'exécutez, vos flux de données, ou fichiers .flow, sont enregistrés dans le même compartiment par défaut, sous le préfixe data_wrangler_flows.

Pour des besoins de sécurité élevés, vous pouvez configurer une politique de compartiment qui restreint les AWS rôles ayant accès à ce compartiment SageMaker S3 par défaut. Utilisez la section suivante pour ajouter ce type de politique à un compartiment S3. Pour suivre les instructions de cette page, utilisez le AWS Command Line Interface (AWS CLI). Pour savoir comment procéder, consultez la section Configuration du AWS CLI dans le guide de IAM l'utilisateur.

En outre, vous devez accorder à chaque IAM rôle qui utilise Data Wrangler des autorisations pour accéder aux ressources requises. Si vous n'avez pas besoin d'autorisations détaillées pour le IAM rôle que vous utilisez pour accéder à Data Wrangler, vous pouvez ajouter la politique IAM gérée à un IAM rôle que vous utilisez pour créer votre utilisateur Studio Classic. AmazonSageMakerFullAccess

Ajouter une politique de compartiment pour restreindre l'accès aux jeux de données importés dans Data Wrangler

Vous pouvez ajouter une politique au compartiment S3 qui contient vos ressources Data Wrangler à l'aide d'une politique de compartiment Amazon S3. Les ressources que Data Wrangler télécharge dans votre compartiment SageMaker S3 par défaut dans la AWS région dans laquelle vous utilisez Studio Classic sont les suivantes :

-

Résultats des requêtes à Amazon Redshift. Ceux-ci sont stockés sous le préfixe redshift/.

-

Résultats des requêtes à Athena. Ceux-ci sont stockés sous le préfixe athena/.

-

Les fichiers .flow chargés sur Amazon S3 lorsque vous exécutez un bloc-notes Jupyter exporté produit par Data Wrangler. Ceux-ci sont stockés sous le préfixe data_wrangler_flows/.

Utilisez la procédure suivante pour créer une politique de compartiment S3 que vous pouvez ajouter afin de restreindre l'accès des IAM rôles à ce compartiment. Pour savoir comment ajouter une politique à un compartiment S3, veuillez consulter Ajout d'une politique de compartiment à l'aide de la console Amazon S3.

Pour configurer une politique de compartiment sur le compartiment S3 qui stocke vos ressources Data Wrangler :

-

Configurez un ou plusieurs IAM rôles auxquels vous souhaitez accéder à Data Wrangler.

-

Ouvrez une invite de commande ou un shell. Pour chaque rôle que vous créez, remplacez

role-nameavec le nom du rôle et exécutez ce qui suit :$ aws iam get-role --role-namerole-nameDans la réponse, vous voyez une chaîne

RoleIdqui commence parAROA. Copiez cette chaîne. -

Ajoutez la politique suivante au compartiment SageMaker par défaut de la AWS région dans laquelle vous utilisez Data Wrangler. Remplacez

regionavec la AWS région dans laquelle se trouve le compartiment, etaccount-idavec votre identifiant de AWS compte. RemplacezuserIds en commençant parAROAEXAMPLEIDavec le IDs nom d'un AWS rôle auquel vous souhaitez autoriser l'utilisation de Data Wrangler.{ "Version": "2012-10-17", "Statement": [ { "Effect": "Deny", "Principal": "*", "Action": "s3:*", "Resource": [ "arn:aws:s3:::sagemaker-region-account-id/data_wrangler_flows/", "arn:aws:s3:::sagemaker-region-account-id/data_wrangler_flows/*", "arn:aws:s3:::sagemaker-region-account-id/athena", "arn:aws:s3:::sagemaker-region-account-id/athena/*", "arn:aws:s3:::sagemaker-region-account-id/redshift", "arn:aws:s3:::sagemaker-region-account-id/redshift/*" ], "Condition": { "StringNotLike": { "aws:userId": [ "AROAEXAMPLEID_1:*", "AROAEXAMPLEID_2:*" ] } } } ] }

Création d'une liste d'autorisation pour Data Wrangler

Chaque fois qu'un utilisateur commence à exécuter Data Wrangler depuis l'interface utilisateur Amazon SageMaker Studio Classic, il appelle l'interface de programmation d'applications (API) pour créer une SageMaker application Data Wrangler.

Il se peut que votre organisation n'accorde pas à vos utilisateurs les autorisations nécessaires pour effectuer ces API appels par défaut. Pour fournir des autorisations, vous devez créer et associer une politique aux IAM rôles de l'utilisateur à l'aide du modèle de politique suivant : Exemple de liste d'autorisation de Data Wrangler

Note

L'exemple de politique précédent permet uniquement à vos utilisateurs d'accéder à l'application Data Wrangler.

Pour plus d'informations sur la création d'une stratégie, consultez la section Création de politiques dans l'JSONonglet. Lorsque vous créez une politique, copiez-collez la JSON politique depuis l'exemple de liste d'autorisation de Data Wrangler

Important

Supprimez toutes IAM les politiques qui empêchent les utilisateurs d'exécuter les opérations suivantes :

Si vous ne supprimez pas les politiques, elles pourraient tout de même affecter vos utilisateurs.

Après avoir créé la politique à l'aide du modèle, associez-la aux IAM rôles de vos utilisateurs. Pour plus d'informations sur l'attachement d'une politique, consultez la section Ajout IAM d'autorisations d'identité (console).

Accorder à un IAM rôle l'autorisation d'utiliser Data Wrangler

Vous pouvez accorder à un IAM rôle l'autorisation d'utiliser Data Wrangler avec la politique générale IAM gérée,. AmazonSageMakerFullAccessAmazonSageMakerFullAccess pour accorder l'accès à Data Wrangler :

-

Si vous importez des données depuis Amazon Redshift, le nom du Database User (Utilisateur de base de données) doit avoir le préfixe

sagemaker_access. -

Cette politique gérée accorde uniquement l'autorisation d'accéder aux compartiments avec l'un des noms suivants :

SageMaker,SageMaker,sagemakerouaws-glue. Si vous souhaitez utiliser Data Wrangler pour effectuer une importation depuis un compartiment S3 sans ces phrases dans le nom, reportez-vous à la dernière section de cette page pour savoir comment autoriser une IAM entité à accéder à vos compartiments S3.

Si vous avez des besoins de sécurité élevés, vous pouvez associer les politiques de cette section à une IAM entité afin d'accorder les autorisations requises pour utiliser Data Wrangler.

Si vous avez des ensembles de données dans Amazon Redshift ou Athena qu'IAMun rôle doit importer depuis Data Wrangler, vous devez ajouter une politique à cette entité pour accéder à ces ressources. Les politiques suivantes sont les plus restrictives que vous pouvez utiliser pour autoriser un IAM rôle à importer des données depuis Amazon Redshift et Athena.

Pour savoir comment associer une politique personnalisée à un IAM rôle, reportez-vous à la section Gestion des IAM politiques du Guide de l'IAMutilisateur.

Exemple de politique pour accorder l'accès à une importation de jeu de données Athena

La politique suivante suppose que le IAM rôle est autorisé à accéder au compartiment S3 sous-jacent dans lequel les données sont stockées par le biais d'une IAM politique distincte.

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "athena:ListDataCatalogs", "athena:ListDatabases", "athena:ListTableMetadata", "athena:GetQueryExecution", "athena:GetQueryResults", "athena:StartQueryExecution", "athena:StopQueryExecution" ], "Resource": [ "*" ] }, { "Effect": "Allow", "Action": [ "glue:CreateTable" ], "Resource": [ "arn:aws:glue:*:*:table/*/sagemaker_tmp_*", "arn:aws:glue:*:*:table/sagemaker_featurestore/*", "arn:aws:glue:*:*:catalog", "arn:aws:glue:*:*:database/*" ] }, { "Effect": "Allow", "Action": [ "glue:DeleteTable" ], "Resource": [ "arn:aws:glue:*:*:table/*/sagemaker_tmp_*", "arn:aws:glue:*:*:catalog", "arn:aws:glue:*:*:database/*" ] }, { "Effect": "Allow", "Action": [ "glue:GetDatabases", "glue:GetTable", "glue:GetTables" ], "Resource": [ "arn:aws:glue:*:*:table/*", "arn:aws:glue:*:*:catalog", "arn:aws:glue:*:*:database/*" ] }, { "Effect": "Allow", "Action": [ "glue:CreateDatabase", "glue:GetDatabase" ], "Resource": [ "arn:aws:glue:*:*:catalog", "arn:aws:glue:*:*:database/sagemaker_featurestore", "arn:aws:glue:*:*:database/sagemaker_processing", "arn:aws:glue:*:*:database/default", "arn:aws:glue:*:*:database/sagemaker_data_wrangler" ] } ] }

Exemple de politique pour accorder l'accès à une importation de jeu de données Amazon Redshift

La politique suivante accorde l'autorisation de configurer une connexion depuis Amazon Redshift vers Data Wrangler à l'aide d'utilisateurs de base de données possédant le préfixe sagemaker_access dans le nom. Pour accorder l'autorisation de se connecter à l'aide d'utilisateurs de base de données supplémentaires, ajoutez des entrées supplémentaires sous "Resources" dans la politique suivante. La politique suivante suppose que le IAM rôle est autorisé à accéder au compartiment S3 sous-jacent dans lequel les données sont stockées par le biais d'une IAM stratégie distincte, le cas échéant.

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "redshift-data:ExecuteStatement", "redshift-data:DescribeStatement", "redshift-data:CancelStatement", "redshift-data:GetStatementResult", "redshift-data:ListSchemas", "redshift-data:ListTables" ], "Resource": [ "*" ] }, { "Effect": "Allow", "Action": [ "redshift:GetClusterCredentials" ], "Resource": [ "arn:aws:redshift:*:*:dbuser:*/sagemaker_access*", "arn:aws:redshift:*:*:dbname:*" ] } ] }

Politique pour accorder l'accès à un compartiment S3

Si votre ensemble de données est stocké dans Amazon S3, vous pouvez accorder à un IAM rôle l'autorisation d'accéder à ce compartiment selon une politique similaire à la suivante. Cet exemple accorde un accès programmatique en lecture-écriture au compartiment nommé test.

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": ["s3:ListBucket"], "Resource": ["arn:aws:s3:::test"] }, { "Effect": "Allow", "Action": [ "s3:PutObject", "s3:GetObject", "s3:DeleteObject" ], "Resource": ["arn:aws:s3:::test/*"] } ] }

Pour importer des données depuis Athena et Amazon Redshift, vous devez accorder à IAM un rôle l'autorisation d'accéder aux préfixes suivants dans le compartiment Amazon S3 par défaut dans AWS le Region Data Wrangler dans lequel il est utilisé :,. athena/ redshift/ Si aucun compartiment Amazon S3 par défaut n'existe déjà dans la AWS région, vous devez également autoriser le IAM rôle à créer un compartiment dans cette région.

En outre, si vous souhaitez que le IAM rôle puisse utiliser les options d'exportation de tâches Amazon SageMaker Feature Store, Pipelines et Data Wrangler, vous devez autoriser l'accès au préfixe data_wrangler_flows/ de ce compartiment.

Data Wrangler utilise les préfixes athena/ et redshift/ pour stocker les fichiers d'aperçu et les jeux de données importés. Pour en savoir plus, consultez Stockage des données importées.

Data Wrangler utilise le préfixe data_wrangler_flows/ pour stocker des fichiers .flow lorsque vous exécutez un bloc-notes Jupyter exporté à partir de Data Wrangler. Pour en savoir plus, consultez Exporter.

Utilisez une politique semblable à la suivante pour accorder les autorisations décrites dans les paragraphes précédents.

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "s3:GetObject", "s3:PutObject" ], "Resource": [ "arn:aws:s3:::sagemaker-region-account-id/data_wrangler_flows/", "arn:aws:s3:::sagemaker-region-account-id/data_wrangler_flows/*", "arn:aws:s3:::sagemaker-region-account-id/athena", "arn:aws:s3:::sagemaker-region-account-id/athena/*", "arn:aws:s3:::sagemaker-region-account-id/redshift", "arn:aws:s3:::sagemaker-region-account-id/redshift/*" ] }, { "Effect": "Allow", "Action": [ "s3:CreateBucket", "s3:ListBucket" ], "Resource": "arn:aws:s3:::sagemaker-region-account-id" }, { "Effect": "Allow", "Action": [ "s3:ListAllMyBuckets", "s3:GetBucketLocation" ], "Resource": "*" } ] }

Vous pouvez également accéder aux données de votre compartiment Amazon S3 depuis un autre AWS compte en spécifiant le compartiment Amazon S3URI. Pour ce faire, la IAM politique qui accorde l'accès au compartiment Amazon S3 dans l'autre compte doit utiliser une politique similaire à celle de l'exemple suivant, où se BucketFolder trouve le répertoire spécifique dans le compartiment de l'utilisateurUserBucket. Cette politique doit être ajoutée à l'utilisateur accordant l'accès à son compartiment pour un autre utilisateur.

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "s3:GetObject", "s3:PutObject", "s3:PutObjectAcl" ], "Resource": "arn:aws:s3:::UserBucket/BucketFolder/*" }, { "Effect": "Allow", "Action": [ "s3:ListBucket" ], "Resource": "arn:aws:s3:::UserBucket", "Condition": { "StringLike": { "s3:prefix": [ "BucketFolder/*" ] } } } ] }

L'utilisateur qui accède au compartiment (qui n'est pas le propriétaire du compartiment) doit ajouter à son utilisateur une politique semblable à celle présentée dans l'exemple suivant. Notez que AccountX et TestUser ci-dessous font référence au propriétaire du compartiment et à son utilisateur respectivement.

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Principal": { "AWS": "arn:aws:iam::AccountX:user/TestUser" }, "Action": [ "s3:GetObject", "s3:PutObject", "s3:PutObjectAcl" ], "Resource": [ "arn:aws:s3:::UserBucket/BucketFolder/*" ] }, { "Effect": "Allow", "Principal": { "AWS": "arn:aws:iam::AccountX:user/TestUser" }, "Action": [ "s3:ListBucket" ], "Resource": [ "arn:aws:s3:::UserBucket" ] } ] }

Exemple de politique permettant d'autoriser l'accès à l'utilisation de SageMaker Studio

Utilisez une politique telle que la suivante pour créer un rôle IAM d'exécution qui peut être utilisé pour configurer une instance de Studio Classic.

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "sagemaker:CreatePresignedDomainUrl", "sagemaker:DescribeDomain", "sagemaker:ListDomains", "sagemaker:DescribeUserProfile", "sagemaker:ListUserProfiles", "sagemaker:*App", "sagemaker:ListApps" ], "Resource": "*" } ] }

Snowflake et Data Wrangler

Toutes les autorisations relatives AWS aux ressources sont gérées via votre IAM rôle associé à votre instance Studio Classic. L'administrateur Snowflake gère les autorisations spécifiques de Snowflake, car elles peuvent accorder des autorisations et privilèges détaillés à chaque utilisateur Snowflake. Cela inclut les bases de données, les schémas, les tables, les entrepôts et les objets d'intégration de stockage. Vous devez vous assurer que les bonnes autorisations sont configurées en dehors de Data Wrangler.

Notez que la COPY INTO Amazon S3 commande Snowflake déplace les données de Snowflake vers Amazon S3 via l'Internet public par défaut, mais les données en transit sont sécurisées à l'aide de. SSL Les données au repos dans Amazon S3 sont chiffrées avec SSE - KMS en utilisant la valeur par défaut AWS KMS key.

En ce qui concerne le stockage des informations d'identification Snowflake, Data Wrangler ne stocke pas les informations d'identification client. Data Wrangler utilise Secrets Manager pour stocker les informations d'identification dans un secret et procède à une rotation des secrets dans le cadre d'un plan de sécurité suivant les bonnes pratiques. L'administrateur de Snowflake ou de Studio Classic doit s'assurer que le rôle d'exécution Studio Classic du data scientist est autorisé à exécuter GetSecretValue le secret stockant les informations d'identification. Si elle est déjà associée au rôle d'exécution de Studio Classic, la AmazonSageMakerFullAccess politique dispose des autorisations nécessaires pour lire les secrets créés par Data Wrangler et les secrets créés en suivant la convention de dénomination et de balisage décrite dans les instructions ci-dessus. L'accès aux secrets qui ne suivent pas les conventions doit être accordé séparément. Nous recommandons d'utiliser Secrets Manager pour empêcher le partage d'informations d'identification sur des canaux non sécurisés ; toutefois, notez qu'un utilisateur connecté peut récupérer le mot de passe en texte brut en lançant un terminal ou un bloc-notes Python dans Studio Classic, puis en appelant des appels API depuis le Secrets Manager. API

Chiffrement des données avec AWS KMS

Dans Data Wrangler, vous pouvez déchiffrer des fichiers chiffrés et les ajouter à votre flux Data Wrangler. Vous pouvez également chiffrer le résultat des transformations à l'aide d'une AWS KMS clé par défaut ou d'une clé que vous fournissez.

Vous pouvez importer des fichiers s'ils possèdent les éléments suivants :

-

chiffrement côté serveur

-

SSE- KMS comme type de cryptage

Pour déchiffrer le fichier et l'importer dans un flux Data Wrangler, vous devez ajouter l'utilisateur SageMaker Studio Classic que vous utilisez comme utilisateur clé.

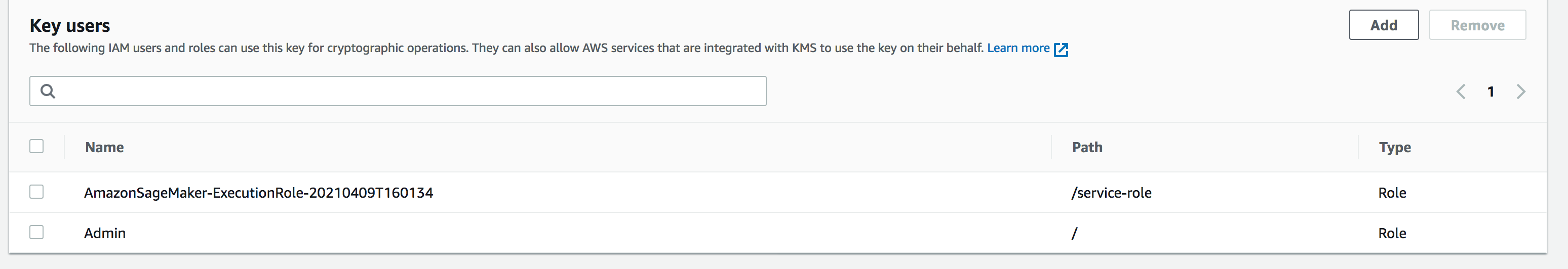

La capture d'écran suivante montre un rôle d'utilisateur Studio Classic ajouté en tant qu'utilisateur clé. Consultez la section IAMRôles

Configuration de la clé gérée par Amazon S3 pour le stockage des données importées Data Wrangler

Par défaut, Data Wrangler utilise des compartiments Amazon S3 qui ont la convention de dénomination suivante : sagemaker-region-account number. Par exemple, si votre numéro de compte est 111122223333 et que vous utilisez Studio Classic dans us-east-1, vos ensembles de données importés sont stockés selon la convention de dénomination suivante :. sagemaker-us-east-1-111122223333

Les instructions suivantes expliquent la façon de configurer une clé gérée par le client pour votre compartiment Amazon S3 par défaut.

-

Pour activer le chiffrement côté serveur et configurer une clé gérée par le client pour votre compartiment S3 par défaut, consultez la section Utilisation KMS du chiffrement.

-

Après avoir suivi l'étape 1, accédez AWS KMS à votre AWS Management Console. Recherchez la clé gérée par le client que vous avez sélectionnée à l'étape 1 de l'étape précédente et ajoutez le rôle Studio Classic en tant qu'utilisateur principal. Pour ce faire, suivez les instructions dans Autorisation aux utilisateurs clés d'utiliser une clé gérée par le client.

Chiffrement des données que vous exportez

Vous pouvez chiffrer les données que vous exportez à l'aide de l'une des méthodes suivantes :

-

Spécifier que votre compartiment Amazon S3 est destiné à l'utilisation d'objets SSE : KMS chiffrement.

-

Spécification d'une AWS KMS clé pour chiffrer les données que vous exportez depuis Data Wrangler.

Sur la page Exporter les données, spécifiez une valeur pour l'ID de AWS KMS clé ou ARN.

Pour plus d'informations sur l'utilisation AWS KMS des clés, consultez la section Protection des données à l'aide du chiffrement côté serveur avec des AWS KMS clés stockées dans AWSAWS Key Management Service (SSE-KMS).

AppFlow Autorisations Amazon

Lorsque vous effectuez un transfert, vous devez spécifier un IAM rôle autorisé à effectuer le transfert. Vous pouvez utiliser le même IAM rôle autorisé à utiliser Data Wrangler. Par défaut, le IAM rôle que vous utilisez pour accéder à Data Wrangler est le. SageMakerExecutionRole

Le IAM rôle doit disposer des autorisations suivantes :

-

Autorisations pour Amazon AppFlow

-

Autorisations d'accès au catalogue AWS Glue de données

-

Autorisations AWS Glue permettant de découvrir les sources de données disponibles

Lorsque vous effectuez un transfert, Amazon AppFlow stocke les métadonnées du transfert dans le catalogue de AWS Glue données. Data Wrangler utilise les métadonnées du catalogue pour déterminer s'il est possible de les interroger et de les importer.

Pour ajouter des autorisations à Amazon AppFlow, ajoutez la politique AmazonAppFlowFullAccess AWS

gérée au IAM rôle. Pour plus d'informations sur l'ajout de politiques, consultez la section Ajouter ou supprimer des autorisations IAM d'identité.

Si vous transférez des données vers Amazon S3, vous devez également joindre la politique suivante.

{ "Version": "2012-10-17", "Statement": [ { "Sid": "VisualEditor0", "Effect": "Allow", "Action": [ "s3:GetBucketTagging", "s3:ListBucketVersions", "s3:CreateBucket", "s3:ListBucket", "s3:GetBucketPolicy", "s3:PutEncryptionConfiguration", "s3:GetEncryptionConfiguration", "s3:PutBucketTagging", "s3:GetObjectTagging", "s3:GetBucketOwnershipControls", "s3:PutObjectTagging", "s3:DeleteObject", "s3:DeleteBucket", "s3:DeleteObjectTagging", "s3:GetBucketPublicAccessBlock", "s3:GetBucketPolicyStatus", "s3:PutBucketPublicAccessBlock", "s3:PutAccountPublicAccessBlock", "s3:ListAccessPoints", "s3:PutBucketOwnershipControls", "s3:PutObjectVersionTagging", "s3:DeleteObjectVersionTagging", "s3:GetBucketVersioning", "s3:GetBucketAcl", "s3:PutObject", "s3:GetObject", "s3:GetAccountPublicAccessBlock", "s3:ListAllMyBuckets", "s3:GetAnalyticsConfiguration", "s3:GetBucketLocation" ], "Resource": "*" } ] }

Pour ajouter AWS Glue des autorisations, ajoutez la politique AWSGlueConsoleFullAccess gérée au IAM rôle. Pour plus d'informations sur AWS Glue les autorisations auprès d'Amazon AppFlow, consultez [link-to-appflow-page].

Amazon AppFlow doit accéder AWS Glue à Data Wrangler pour que vous puissiez importer les données que vous avez transférées. Pour accorder AppFlow l'accès à Amazon, ajoutez la politique de confiance suivante au IAM rôle.

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Principal": { "AWS": "arn:aws:iam::123456789012:root", "Service": [ "appflow.amazonaws.com" ] }, "Action": "sts:AssumeRole" } ] }

Pour afficher les AppFlow données Amazon dans Data Wrangler, ajoutez la politique suivante au IAM rôle :

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": "glue:SearchTables", "Resource": [ "arn:aws:glue:*:*:table/*/*", "arn:aws:glue:*:*:database/*", "arn:aws:glue:*:*:catalog" ] } ] }

Utilisation des configurations de cycle de vie dans Data Wrangler

Vous avez peut-être une EC2 instance Amazon configurée pour exécuter des applications Kernel Gateway, mais pas l'application Data Wrangler. Les applications Kernel Gateway permettent d'accéder à l'environnement et aux noyaux que vous utilisez pour exécuter les ordinateurs portables et les terminaux Studio Classic. L'application Data Wrangler est l'application d'interface utilisateur qui exécute Data Wrangler. Les EC2 instances Amazon qui ne sont pas des instances Data Wrangler nécessitent une modification de leur configuration de cycle de vie pour exécuter Data Wrangler. Les configurations du cycle de vie sont des scripts shell qui automatisent la personnalisation de votre environnement Amazon SageMaker Studio Classic.

Pour en savoir plus sur les configurations du cycle de vie, consultez Utilisez les configurations du cycle de vie pour personnaliser Studio Classic.

La configuration du cycle de vie par défaut de votre instance ne prend pas en charge l'utilisation de Data Wrangler. Vous pouvez apporter les modifications suivantes à la configuration par défaut pour utiliser Data Wrangler avec votre instance.

#!/bin/bash set -eux STATUS=$( python3 -c "import sagemaker_dataprep" echo $? ) if [ "$STATUS" -eq 0 ]; then echo 'Instance is of Type Data Wrangler' else echo 'Instance is not of Type Data Wrangler' # Replace this with the URL of your git repository export REPOSITORY_URL="https://github.com/aws-samples/sagemaker-studio-lifecycle-config-examples.git" git -C /root clone $REPOSTIORY_URL fi

Vous pouvez enregistrer le script sous lifecycle_configuration.sh.

Vous associez la configuration du cycle de vie à votre domaine ou profil utilisateur Studio Classic. Pour plus d'informations sur la création et l'association d'une configuration de cycle de vie, consultez Création et association d'une configuration de cycle de vie.

Les instructions suivantes vous montrent comment associer une configuration de cycle de vie à un domaine ou à un profil utilisateur Studio Classic.

Vous pouvez rencontrer des erreurs lorsque vous créez ou associez une configuration de cycle de vie. Pour de plus amples informations sur le débogage des erreurs de configuration de cycle de vie, KernelGateway échec de l'application.