Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Importer

Vous pouvez utiliser Amazon SageMaker Data Wrangler pour importer des données à partir des sources de données suivantes : Amazon Simple Storage Service (Amazon S3), Amazon Athena, Amazon Redshift et Snowflake. Le jeu de données que vous importez peut contenir jusqu'à 1 000 colonnes.

Rubriques

- Importer des données depuis Amazon S3

- Importer des données depuis Athena

- Importer des données depuis Amazon Redshift

- Importer des données depuis Amazon EMR

- Importer des données depuis Databricks () JDBC

- Importer des données depuis Salesforce Data Cloud

- Importer des données depuis Snowflake

- Importer des données à partir de plateformes de logiciel en tant que service (SaaS)

- Stockage des données importées

Certaines sources de données vous permettent d'ajouter plusieurs connexions de données :

-

Vous pouvez vous connecter à plusieurs clusters Amazon Redshift. Chaque cluster devient une source de données.

-

Vous pouvez interroger n'importe quelle base de données Athena de votre compte pour importer des données à partir de cette base de données.

Lorsque vous importez un jeu de données à partir d'une source de données, il apparaît dans votre flux de données. Data Wrangler déduit automatiquement le type de données de chaque colonne de votre jeu de données. Pour modifier ces types, sélectionnez l'étape Data types (Types de données) et sélectionnez Edit data types (Modifier les types de données).

Lorsque vous importez des données depuis Athena ou Amazon Redshift, les données importées sont automatiquement stockées dans le compartiment S3 SageMaker par défaut de AWS la région dans laquelle vous utilisez Studio Classic. En outre, Athena stocke les données que vous prévisualisez dans Data Wrangler dans ce compartiment. Pour en savoir plus, consultez Stockage des données importées.

Important

Le compartiment Amazon S3 par défaut ne possède peut-être pas les paramètres de sécurité les moins permissifs, tels que la politique de compartiment et le chiffrement côté serveur (). SSE Nous vous recommandons vivement d'ajouter une politique de compartiment pour restreindre l'accès aux jeux de données importés dans Data Wrangler.

Important

En outre, si vous utilisez la politique gérée pour SageMaker, nous vous recommandons vivement de la limiter à la politique la plus restrictive qui vous permet de réaliser votre cas d'utilisation. Pour de plus amples informations, veuillez consulter Accorder à un IAM rôle l'autorisation d'utiliser Data Wrangler.

Toutes les sources de données, à l'exception d'Amazon Simple Storage Service (Amazon S3), nécessitent que vous spécifiiez SQL une requête pour importer vos données. Pour chaque requête, vous devez spécifier les informations suivantes :

-

Data catalog (Catalogue de données)

-

Database (Base de données)

-

Tableau

Vous pouvez spécifier le nom de la base de données ou du catalogue de données dans les menus déroulants ou dans la requête. Voici quelques exemples de requêtes :

-

select * from- Pour son exécution, la requête n'utilise aucun élément spécifié dans les menus déroulants de l'interface utilisateur (UI). Elle interrogeexample-data-catalog-name.example-database-name.example-table-nameexample-table-namedansexample-database-namedansexample-data-catalog-name. -

select * from- La requête utilise le catalogue de données que vous avez spécifié dans le menu déroulant Data catalog (Catalogue de données) pour s'exécuter. Elle interrogeexample-database-name.example-table-nameexample-table-namedansexample-database-namedans le catalogue de données que vous avez spécifié. -

select * from- La requête vous oblige à sélectionner des champs pour les menus déroulants Data catalog (Catalogue de données) et Database name (Nom de la base de données). Elle interrogeexample-table-nameexample-table-namedans le catalogue de données que vous avez spécifié.

La liaison entre Data Wrangler et la source de données est une connexion. Elle vous permet d'importer des données à partir de votre source de données.

Il existe les types de connexions suivants :

-

Direct (Directe)

-

Cataloged (Cataloguée)

Data Wrangler a toujours accès aux données les plus récentes via une connexion directe. Si les données de la source de données ont été mises à jour, vous pouvez utiliser la connexion pour importer les données. Par exemple, si quelqu'un ajoute un fichier à l'un de vos compartiments Amazon S3, vous pouvez importer le fichier.

Une connexion cataloguée est le résultat d'un transfert de données. Les données de la connexion cataloguée ne contiennent pas nécessairement les données les plus récentes. Par exemple, vous pouvez configurer un transfert de données entre Salesforce et Amazon S3. Si les données Salesforce sont mises à jour, vous devez les transférer à nouveau. Vous pouvez automatiser le processus de transfert des données. Pour plus d'informations sur les rôles d'utilisateur, veuillez consulter Importer des données à partir de plateformes de logiciel en tant que service (SaaS).

Importer des données depuis Amazon S3

Vous pouvez utiliser Amazon Simple Storage Service (Amazon S3) pour stocker et récupérer n'importe quelle quantité de données, à tout moment, de n'importe où sur le Web. Vous pouvez accomplir ces tâches à l' AWS Management Console aide de l'interface Web simple et intuitive et de l'Amazon S3API. Si vous avez stocké votre jeu de données localement, nous vous recommandons de l'ajouter à un compartiment S3 pour l'importer dans Data Wrangler. Pour savoir comment procéder, consultez la rubrique Chargement d'un objet dans un compartiment dans le Guide de l'utilisateur Amazon Simple Storage Service.

Data Wrangler utilise S3 Select

Important

Si vous envisagez d'exporter un flux de données et de lancer une tâche Data Wrangler, d'ingérer des données dans un SageMaker feature store ou de créer un SageMaker pipeline, sachez que ces intégrations nécessitent que les données d'entrée Amazon S3 soient situées dans la même région. AWS

Important

Si vous importez un CSV fichier, assurez-vous qu'il répond aux exigences suivantes :

-

Tout registre dans votre jeu de données ne peut pas dépasser une ligne.

-

La barre oblique inverse (

\) est le seul caractère d'échappement valide. -

Votre jeu de données doit utiliser l'un des délimiteurs suivants :

-

Virgule –

, -

Deux-points –

: -

Point-virgule –

; -

Barre verticale –

| -

Tab –

[TAB]

-

Pour économiser de l'espace, vous pouvez importer des CSV fichiers compressés.

Data Wrangler vous permet d'importer l'intégralité du jeu de données ou d'en échantillonner une partie. Pour Amazon S3, il fournit les options d'échantillonnage suivantes :

-

None (Aucun) : importez l'intégralité du jeu de données.

-

First K (K premières lignes) : échantillonnez les K premières lignes du jeu de données, où K est un entier que vous spécifiez.

-

Randomized (Aléatoire) : prélève un échantillon aléatoire d'une taille que vous spécifiez.

-

Stratified (Stratifié) : prélève un échantillon aléatoire stratifié. Un échantillon stratifié conserve le rapport des valeurs dans une colonne.

Une fois que vous avez importé vos données, vous pouvez également utiliser le transformateur d'échantillonnage pour prélever un ou plusieurs échantillons de votre jeu de données. Pour plus d'informations sur le transformateur d'échantillonnage, consultez Echantillonnage.

Vous pouvez utiliser l'un des identificateurs de ressources suivants pour importer vos données :

-

Un Amazon S3 URI qui utilise un compartiment Amazon S3 ou un point d'accès Amazon S3

-

Un alias de points d'accès Amazon S3

-

Un nom de ressource Amazon (ARN) qui utilise un point d'accès Amazon S3 ou un compartiment Amazon S3

Les points d'accès Amazon S3 sont appelés points de terminaison réseau attachés aux compartiments. Chaque point d'accès dispose d'autorisations et de contrôles réseau que vous pouvez configurer. Pour plus d'informations sur les points d'accès, consultez Gestion de l'accès aux données avec les points d'accès Amazon S3.

Important

Si vous utilisez un nom de ressource Amazon (ARN) pour importer vos données, il doit s'agir d'une ressource située dans le même nom Région AWS que celui que vous utilisez pour accéder à Amazon SageMaker Studio Classic.

Vous pouvez importer un seul fichier ou plusieurs fichiers en tant que jeu de données. Vous pouvez utiliser l'opération d'importation de plusieurs fichiers lorsque vous disposez d'un jeu de données partitionné dans des fichiers distincts. Elle prend tous les fichiers d'un répertoire Amazon S3 et les importe en tant que jeu de données unique. Pour plus d'informations sur les types de fichiers que vous pouvez importer et sur la façon de les importer, reportez-vous aux sections suivantes.

Vous pouvez également utiliser des paramètres pour importer un sous-ensemble de fichiers correspondant à un modèle. Les paramètres vous permettent de sélectionner de manière plus sélective les fichiers à importer. Pour commencer à utiliser des paramètres, modifiez la source de données et appliquez-les au chemin que vous utilisez pour importer les données. Pour de plus amples informations, veuillez consulter Réutilisation de flux de données pour différents jeux de données.

Importer des données depuis Athena

Utilisez Amazon Athena pour importer vos données depuis Amazon Simple Storage Service (Amazon S3) dans Data Wrangler. Dans Athena, vous rédigez des SQL requêtes standard pour sélectionner les données que vous importez depuis Amazon S3. Pour plus d'informations, consultez Qu'est-ce que Amazon Athena ?.

Vous pouvez utiliser le AWS Management Console pour configurer Amazon Athena. Vous devez créer au moins une base de données dans Athena avant de commencer à exécuter des requêtes. Pour plus d'informations sur la mise en route avec Athena, consultez Démarrer.

Athena est directement intégré à Data Wrangler. Vous pouvez écrire des requêtes Athena sans avoir à quitter l'interface utilisateur de Data Wrangler.

En plus d'écrire des requêtes Athena simples dans Data Wrangler, vous pouvez également utiliser :

-

Groupes de travail Athena pour la gestion des résultats des requêtes. Pour plus d'informations sur les groupes de travail, consultez Gestion des résultats de requêtes.

-

Configurations du cycle de vie pour définir les périodes de conservation des données. Pour plus d'informations sur la conservation des données, consultez Définition de la durée de conservation des données.

Interroger Athena dans Data Wrangler

Note

Data Wrangler ne prend pas en charge les requêtes fédérées.

Si vous l'utilisez AWS Lake Formation avec Athena, assurez-vous que vos autorisations de Lake Formation ne remplacent pas IAM les autorisations de la base de IAM données. sagemaker_data_wrangler

Data Wrangler vous permet d'importer l'intégralité du jeu de données ou d'en échantillonner une partie. Pour Athena, il fournit les options d'échantillonnage suivantes :

-

None (Aucun) : importez l'intégralité du jeu de données.

-

First K (K premières lignes) : échantillonnez les K premières lignes du jeu de données, où K est un entier que vous spécifiez.

-

Randomized (Aléatoire) : prélève un échantillon aléatoire d'une taille que vous spécifiez.

-

Stratified (Stratifié) : prélève un échantillon aléatoire stratifié. Un échantillon stratifié conserve le rapport des valeurs dans une colonne.

La procédure suivante montre comment importer un jeu de données d'Athena dans Data Wrangler.

Pour importer un jeu de données dans Data Wrangler à partir d'Athena

-

Connectez-vous à Amazon SageMaker Console

. -

Choisissez Studio.

-

Choisissez Launch app (Lancer l'application).

-

Dans la liste déroulante, sélectionnez Studio.

-

Choisissez l'icône d'accueil.

-

Choisissez Data (Données).

-

Choisissez Data Wrangler.

-

Choisissez Import data (Importer les données).

-

Sous Available (Disponible), sélectionnez Amazon Athena.

-

Pour Catalogue de données, choisissez un catalogue de données.

-

Utilisez la liste déroulante Database (Base de données) pour sélectionner la base de données que vous souhaitez interroger. Lorsque vous sélectionnez une base de données, vous pouvez prévisualiser toutes les tables de votre base de données en utilisant les Tables listées sous Details (Détails).

-

(Facultatif) Choisissez Advanced configuration (Configuration avancée).

-

Choisissez un Workgroup (Groupe de travail).

-

Si votre groupe de travail n'a pas appliqué l'emplacement de sortie Amazon S3 ou si vous n'avez pas utilisé un groupe de travail, spécifiez une valeur pour Emplacement Amazon S3 des résultats des requêtes.

-

(Facultatif) Pour la zone Data retention period (Durée de conservation des données), cochez la case permettant de définir une durée de conservation des données et spécifiez le nombre de jours pendant lesquels les données doivent être stockées avant leur suppression.

-

(Facultatif) Par défaut, Data Wrangler enregistre la connexion. Vous pouvez choisir de désélectionner la case à cocher et de ne pas enregistrer la connexion.

-

-

Pour Sampling (Échantillonnage), choisissez une méthode d'échantillonnage. Choisissez None (Aucun) pour désactiver l'échantillonnage.

-

Saisissez votre requête dans l'éditeur de requête et utilisez le bouton Run (Exécuter) pour l'exécuter. Après une requête réussie, vous pouvez prévisualiser votre résultat sous l'éditeur.

Note

Les données Salesforce utilisent le type

timestamptz. Si vous interrogez la colonne d'horodatage que vous avez importée dans Athena depuis Salesforce, convertissez les données de la colonne au typetimestamp. La requête suivante convertit la colonne d'horodatage au type approprié.# cast column timestamptz_col as timestamp type, and name it as timestamp_col select cast(timestamptz_col as timestamp) as timestamp_col from table -

Pour importer les résultats de votre requête, sélectionnez Import (Importer).

Une fois que vous avez terminé la procédure précédente, le jeu de données que vous avez interrogé et importé apparaît dans le flux Data Wrangler.

Par défaut, Data Wrangler enregistre les paramètres de connexion en tant que nouvelle connexion. Lorsque vous importez vos données, la requête que vous avez déjà spécifiée apparaît sous la forme d'une nouvelle connexion. Les connexions enregistrées stockent des informations sur les groupes de travail Athena et les compartiments Amazon S3 que vous utilisez. Lorsque vous vous reconnectez à la source de données, vous pouvez choisir la connexion enregistrée.

Gestion des résultats de requêtes

Data Wrangler prend en charge l'utilisation de groupes de travail Athena pour gérer les résultats de requête dans un compte AWS . Vous pouvez spécifier un emplacement de sortie Amazon S3 pour chaque groupe de travail. Vous pouvez également spécifier si la sortie de la requête peut être envoyée à différents emplacements Amazon S3. Pour plus d'informations, veuillez consulter Utilisation des groupes de travail pour contrôler l'accès aux requêtes et les coûts.

Votre groupe de travail peut-être configuré pour appliquer l'emplacement de sortie des requêtes Amazon S3. Vous ne pouvez pas modifier l'emplacement de sortie des résultats de la requête pour ces groupes de travail.

Si vous n'utilisez pas de groupe de travail ou si vous ne spécifiez pas d'emplacement de sortie pour vos requêtes, Data Wrangler utilise le bucket Amazon S3 par défaut dans la même AWS région que celle dans laquelle se trouve votre instance Studio Classic pour stocker les résultats des requêtes Athena. Il crée des tables temporaires dans cette base de données pour déplacer la sortie de la requête vers ce compartiment Amazon S3. Il supprime ces tables une fois les données importées, mais la base de données sagemaker_data_wrangler persiste. Pour en savoir plus, consultez Stockage des données importées.

Pour utiliser les groupes de travail Athena, configurez la IAM politique qui donne accès aux groupes de travail. Si vous utilisez un SageMaker-Execution-Role, nous vous recommandons d'ajouter la politique au rôle. Pour plus d'informations sur IAM les politiques relatives aux groupes de travail, consultez IAMles politiques d'accès aux groupes de travail. Pour obtenir des exemples de politiques de groupe de travail, consultez Exemples de politiques de groupe de travail.

Définition de la durée de conservation des données

Data Wrangler définit automatiquement une durée de conservation des données pour les résultats de la requête. Les résultats sont supprimés une fois cette durée écoulée. Par exemple, la durée de conservation par défaut est de cinq jours. Les résultats de la requête sont supprimés au bout de cinq jours. Cette configuration est conçue pour vous aider à nettoyer les données que vous n'utilisez plus. Le nettoyage de vos données empêche les utilisateurs non autorisés d'y accéder. Il permet également de contrôler les coûts de stockage de vos données sur Amazon S3.

Si vous ne définissez pas de durée de conservation, c'est la configuration du cycle de vie d'Amazon S3 qui détermine la durée de stockage des objets. La politique de conservation des données que vous avez spécifiée pour la configuration du cycle de vie supprime tous les résultats de requête antérieurs à la configuration du cycle de vie que vous avez spécifiée. Pour en savoir plus, consultez Définition d'une configuration de cycle de vie sur un compartiment.

Data Wrangler utilise des configurations de cycle de vie Amazon S3 pour gérer la conservation et l'expiration des données. Vous devez accorder à votre rôle d'IAMexécution Amazon SageMaker Studio Classic les autorisations nécessaires pour gérer les configurations du cycle de vie des compartiments. Procédez comme suit pour accorder des autorisations.

Pour accorder les autorisations de gestion de la configuration du cycle de vie, procédez comme suit.

-

Connectez-vous à la IAM console AWS Management Console et ouvrez-la à l'adresse https://console.aws.amazon.com/iam/

. -

Sélectionnez Roles (Rôles).

-

Dans la barre de recherche, spécifiez le rôle SageMaker d'exécution Amazon utilisé par Amazon SageMaker Studio Classic.

-

Choisissez le rôle.

-

Choisissez Add permissions (Ajouter des autorisations).

-

Choisissez Create inline policy (Créer une politique en ligne).

-

Pour Service, spécifiez S3 et choisissez-le.

-

Dans la section Lire, choisissez GetLifecycleConfiguration.

-

Dans la section Écrire, choisissez PutLifecycleConfiguration.

-

Pour Resources (Ressources), choisissez Specific (Spécifique).

-

Pour Actions, sélectionnez l'icône en forme de flèche en regard de Permissions management (Gestion des autorisations).

-

Choisissez PutResourcePolicy.

-

Pour Resources (Ressources), choisissez Specific (Spécifique).

-

Cochez la case en regard de Any in this account (N'importe quelle ressource dans ce compte).

-

Choisissez Review policy (Examiner une politique).

-

Pour Name (Nom), spécifiez un nom.

-

Sélectionnez Create policy (Créer la stratégie).

Importer des données depuis Amazon Redshift

Amazon Redshift est un service d’entrepôt des données entièrement géré dans le cloud. La première étape pour créer un entrepôt de données consiste à lancer un ensemble de nœuds, appelé cluster Amazon Redshift. Après avoir alloué votre cluster, vous pouvez charger votre jeu de données, puis effectuer des requêtes d'analyse de données.

Vous pouvez vous connecter à un ou plusieurs clusters Amazon Redshift et les interroger dans Data Wrangler. Pour utiliser cette option d'importation, vous devez créer au moins un cluster dans Amazon Redshift. Pour savoir comment procéder, veuillez consulter Démarrer avec Amazon Redshift.

Vous pouvez afficher les résultats de votre requête Amazon Redshift dans l'un des emplacements suivants :

-

Compartiment Amazon S3 par défaut

-

Emplacement de sortie Amazon S3 que vous spécifiez

Vous pouvez importer l'intégralité du jeu de données ou en échantillonner une partie. Pour Amazon Redshift, il fournit les options d'échantillonnage suivantes :

-

None (Aucun) : importez l'intégralité du jeu de données.

-

First K (K premières lignes) : échantillonnez les K premières lignes du jeu de données, où K est un entier que vous spécifiez.

-

Randomized (Aléatoire) : prélève un échantillon aléatoire d'une taille que vous spécifiez.

-

Stratified (Stratifié) : prélève un échantillon aléatoire stratifié. Un échantillon stratifié conserve le rapport des valeurs dans une colonne.

Le compartiment Amazon S3 par défaut se trouve dans la même AWS région que celle dans laquelle se trouve votre instance Studio Classic pour stocker les résultats des requêtes Amazon Redshift. Pour de plus amples informations, veuillez consulter Stockage des données importées.

Pour le compartiment Amazon S3 par défaut ou le compartiment que vous spécifiez, vous disposez des options de chiffrement suivantes :

-

Le chiffrement AWS côté service par défaut avec une clé gérée Amazon S3 (SSE-S3)

-

Une clé AWS Key Management Service (AWS KMS) que vous spécifiez

Une AWS KMS clé est une clé de chiffrement que vous créez et gérez. Pour plus d'informations sur KMS les clés, consultez AWS Key Management Service.

Vous pouvez spécifier une AWS KMS clé en utilisant la clé ARN ou celle ARN de votre AWS compte.

Si vous utilisez la politique IAM géréeAmazonSageMakerFullAccess, pour accorder à un rôle l'autorisation d'utiliser Data Wrangler dans Studio Classic, le nom d'utilisateur de votre base de données doit comporter le préfixe. sagemaker_access

Découvrez comment ajouter un nouveau cluster à l'aide des procédures suivantes.

Note

Data Wrangler utilise les données Amazon Redshift avec des API informations d'identification temporaires. Pour en savoir plus à ce sujetAPI, reportez-vous à la section Utilisation des données Amazon Redshift API dans le guide de gestion Amazon Redshift.

Pour vous connecter à un cluster Amazon Redshift

-

Connectez-vous à Amazon SageMaker Console

. -

Choisissez Studio.

-

Choisissez Launch app (Lancer l'application).

-

Dans la liste déroulante, sélectionnez Studio.

-

Choisissez l'icône d'accueil.

-

Choisissez Data (Données).

-

Choisissez Data Wrangler.

-

Choisissez Import data (Importer les données).

-

Sous Available (Disponible), sélectionnez Amazon Athena.

-

Choisissez Amazon Redshift.

-

Choisissez Informations d'identification temporaires (IAM) pour Type.

-

Saisissez un Connection Name (Nom de la connexion). Il s'agit d'un nom utilisé par Data Wrangler pour identifier cette connexion.

-

Saisissez le Cluster Identifier (Identifiant du cluster) pour spécifier à quel cluster vous souhaitez vous connecter. Remarque : saisissez uniquement l'identifiant de cluster et non le point de terminaison complet du cluster Amazon Redshift.

-

Saisissez le Database Name (Nom de base de données) de la base de données à laquelle vous souhaitez vous connecter.

-

Saisissez un Database User (Utilisateur de base de données) pour identifier l'utilisateur que vous souhaitez utiliser pour vous connecter à la base de données.

-

Pour UNLOADIAMRôle, entrez le IAM rôle ARN que le cluster Amazon Redshift doit assumer pour déplacer et écrire des données sur Amazon S3. Pour plus d'informations sur ce rôle, consultez la section Autoriser Amazon Redshift à accéder à AWS d'autres services en votre nom dans le guide de gestion Amazon Redshift.

-

Choisissez Se connecter.

-

(Facultatif) Pour l'emplacement de sortie Amazon S3, spécifiez le S3 dans URI lequel stocker les résultats de la requête.

-

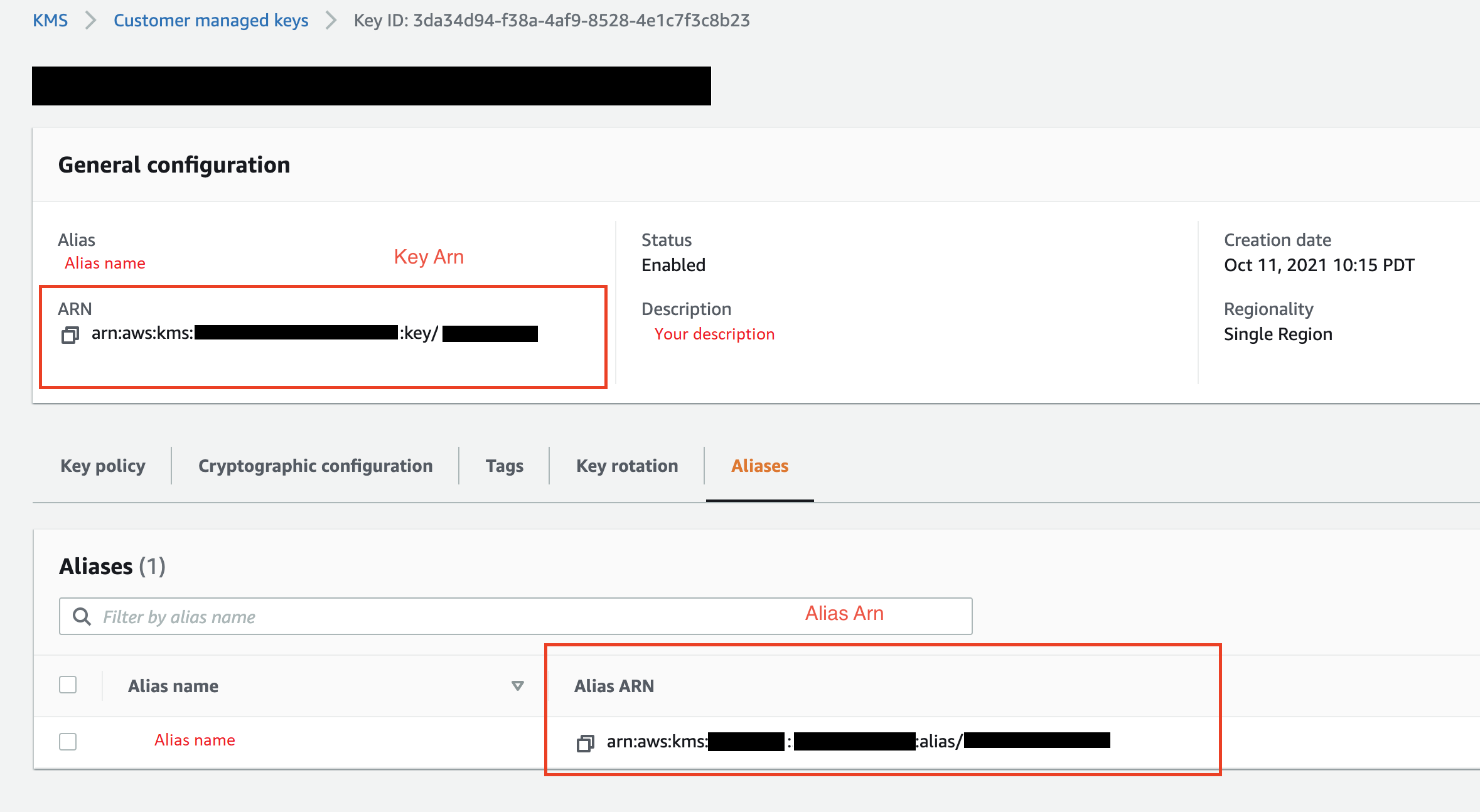

(Facultatif) Pour l'ID de KMS clé, spécifiez ARN la AWS KMS clé ou l'alias. L'image suivante montre où vous pouvez trouver l'une ou l'autre clé dans la AWS Management Console.

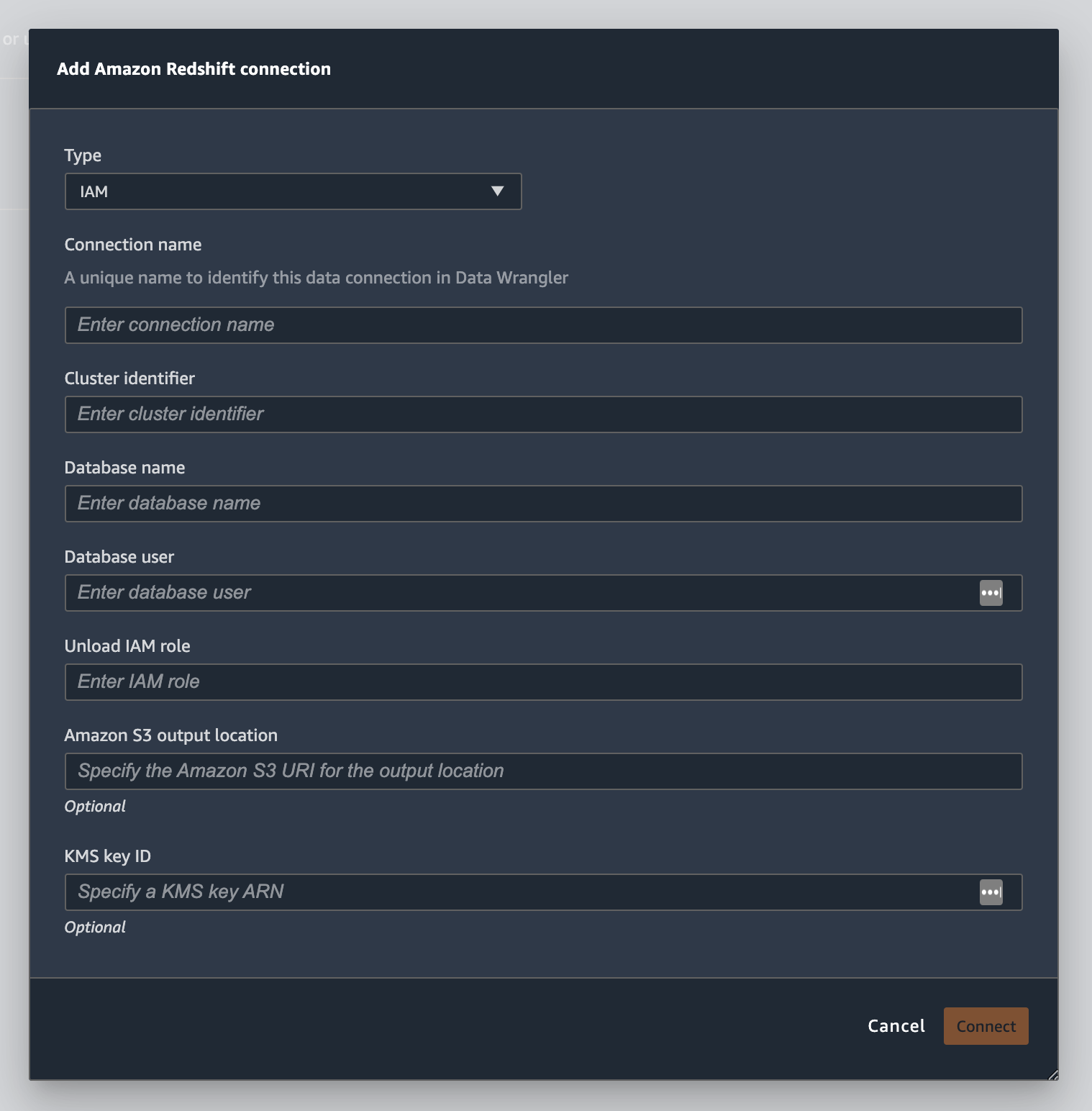

L'image suivante montre tous les champs de la procédure précédente.

Une fois votre connexion établie avec succès, elle apparaît en tant que source de données sous Data Import (Importation de données). Sélectionnez cette source de données pour interroger votre base de données et importer des données.

Pour interroger et importer des données à partir d'Amazon Redshift

-

Sélectionnez la connexion à partir de laquelle vous souhaitez effectuer une requête dans Data Source (Sources de données).

-

Sélectionnez un Scheme (Schéma). Pour en savoir plus sur les schémas Amazon Redshift, consultez la rubrique Schémas dans le Guide du développeur de la base de données Amazon Redshift.

-

(Facultatif) Sous Advanced configuration (Configuration avancée), spécifiez la méthode Sampling (Échantillonnage) que vous souhaitez utiliser.

-

Entrez votre requête dans l'éditeur de requête, puis choisissez Run (Exécuter) pour exécuter la requête. Après une requête réussie, vous pouvez prévisualiser votre résultat sous l'éditeur.

-

Sélectionnez Import dataset (Importer un jeu de données) pour importer le jeu de données interrogé.

-

Saisissez un Dataset name (Nom de jeu de données). Si vous ajoutez un Dataset name (Nom de jeu de données) qui contient des espaces, ces derniers sont remplacés par des traits de soulignement lorsque votre jeu de données est importé.

-

Choisissez Ajouter.

Pour modifier un jeu de données, procédez comme suit.

-

Accédez à votre flux Data Wrangler.

-

Cliquez sur le signe + à côté de Source - Sampled (Source - Échantillonnée).

-

Modifiez les données que vous importez.

-

Choisissez Apply (Appliquer)

Importer des données depuis Amazon EMR

Vous pouvez utiliser Amazon EMR comme source de données pour votre flux Amazon SageMaker Data Wrangler. Amazon EMR est une plateforme de clusters gérés que vous pouvez utiliser pour traiter et analyser de grandes quantités de données. Pour plus d'informations sur AmazonEMR, consultez Qu'est-ce qu'Amazon EMR ? . Pour importer un jeu de donnéesEMR, vous devez vous y connecter et l'interroger.

Important

Vous devez remplir les conditions préalables suivantes pour vous connecter à un EMR cluster Amazon :

Prérequis

-

Configurations réseau

-

Vous avez un Amazon VPC dans la région que vous utilisez pour lancer Amazon SageMaker Studio Classic et AmazonEMR.

-

Amazon EMR et Amazon SageMaker Studio Classic doivent tous deux être lancés dans des sous-réseaux privés. Ils peuvent se trouver dans le même sous-réseau ou dans des sous-réseaux différents.

-

Amazon SageMaker Studio Classic doit être en mode VPC -only.

Pour plus d'informations sur la création d'unVPC, voir Créer un VPC.

Pour plus d'informations sur la création d'unVPC, voir Connect SageMaker Studio Classic Notebooks in a VPC to External Resources.

-

Les EMR clusters Amazon que vous exécutez doivent se trouver dans le même AmazonVPC.

-

Les EMR clusters Amazon et Amazon VPC doivent se trouver dans le même AWS compte.

-

Vos EMR clusters Amazon exécutent Hive ou Presto.

-

Les clusters Hive doivent autoriser le trafic entrant en provenance des groupes de sécurité Studio Classic sur le port 10000.

-

Les clusters Presto doivent autoriser le trafic entrant en provenance des groupes de sécurité Studio Classic sur le port 8889.

Note

Le numéro de port est différent pour les EMR clusters Amazon utilisant IAM des rôles. Accédez à la fin de la section des conditions préalables pour plus d'informations.

-

-

-

SageMaker Studio classique

-

Amazon SageMaker Studio Classic doit exécuter Jupyter Lab version 3. Pour plus d'informations sur la mise à jour de la version de Jupyter Lab, veuillez consulter Afficher et mettre à jour la JupyterLab version d'une application depuis la console.

-

Amazon SageMaker Studio Classic possède un IAM rôle qui contrôle l'accès des utilisateurs. Le IAM rôle par défaut que vous utilisez pour exécuter Amazon SageMaker Studio Classic ne comporte aucune politique vous donnant accès aux EMR clusters Amazon. Vous devez associer la politique octroyant les autorisations au IAM rôle. Pour de plus amples informations, veuillez consulter Configurer la liste des EMR clusters Amazon.

-

Le IAM rôle doit également être associé à la politique suivante

secretsmanager:PutResourcePolicy. -

Si vous utilisez un domaine Studio Classic que vous avez déjà créé, assurez-vous qu'il

AppNetworkAccessTypeest en mode VPC -only. Pour plus d'informations sur la mise à jour d'un domaine afin d'utiliser le mode VPC -only, consultezArrêter et mettre à jour SageMaker Studio Classic.

-

-

EMRClusters Amazon

-

Hive ou Presto doit être installé sur votre cluster.

-

La EMR version d'Amazon doit être la version 5.5.0 ou ultérieure.

Note

Amazon EMR prend en charge la résiliation automatique. La terminaison automatique empêche le fonctionnement des clusters inactifs, ce qui permet de réaliser des économies. Les versions qui prennent en charge la terminaison automatique sont les suivantes :

-

Pour les versions 6.x, version 6.1.0 ou ultérieure.

-

Pour les versions 5.x, version 5.30.0 ou ultérieure.

-

-

-

EMRClusters Amazon utilisant des rôles IAM d'exécution

-

Utilisez les pages suivantes pour configurer les rôles IAM d'exécution pour le EMR cluster Amazon. Vous devez activer le chiffrement en transit lorsque vous utilisez des rôles d'exécution :

-

Vous devez utiliser Lake Formation comme outil de gouvernance pour les données de vos bases de données. Vous devez également utiliser un filtrage de données externe pour le contrôle d'accès.

-

Pour plus d'informations sur Lake Formation, voir Qu'est-ce que c'est AWS Lake Formation ?

-

Pour plus d'informations sur l'intégration de Lake Formation dans AmazonEMR, consultez Intégrer des services tiers à Lake Formation.

-

-

Le cluster doit être d'une version 6.9.0 ou ultérieure.

-

Accès à AWS Secrets Manager. Pour plus d'informations sur Secrets Manager, consultez Qu'est-ce que AWS Secrets Manager ?

-

Les clusters Hive doivent autoriser le trafic entrant en provenance des groupes de sécurité Studio Classic sur le port 10000.

-

Un Amazon VPC est un réseau virtuel qui est logiquement isolé des autres réseaux du AWS cloud. Amazon SageMaker Studio Classic et votre EMR cluster Amazon n'existent qu'au sein d'AmazonVPC.

Suivez la procédure ci-dessous pour lancer Amazon SageMaker Studio Classic dans un AmazonVPC.

Pour lancer Studio Classic dans unVPC, procédez comme suit.

-

Accédez à la SageMaker console à l'adresse https://console.aws.amazon.com/sagemaker/

. -

Choisissez Launch SageMaker Studio Classic.

-

Choisissez Standard setup (Configuration standard).

-

Pour Rôle d'exécution par défaut, choisissez le IAM rôle pour configurer Studio Classic.

-

Choisissez l'VPCendroit où vous avez lancé les EMR clusters Amazon.

-

Dans Subnet (Sous-réseau), choisissez un sous-réseau privé.

-

Pour Groupe (s) de sécurité, spécifiez les groupes de sécurité que vous utilisez pour contrôler entre vosVPC.

-

Choisissez VPCuniquement.

-

(Facultatif) AWS utilise une clé de chiffrement par défaut. Vous pouvez spécifier une clé AWS Key Management Service pour chiffrer vos données.

-

Choisissez Suivant.

-

Sous Studio settings (Paramètres Studio), choisissez les configurations qui vous conviennent le mieux.

-

Choisissez Next pour ignorer les paramètres du SageMaker canevas.

-

Choisissez Next pour ignorer les RStudio paramètres.

Si aucun EMR cluster Amazon n'est prêt, vous pouvez utiliser la procédure suivante pour en créer un. Pour plus d'informations sur AmazonEMR, consultez Qu'est-ce qu'Amazon EMR ?

Pour créer un cluster, procédez comme suit.

-

Accédez à AWS Management Console.

-

Dans la barre de recherche, spécifiez

Amazon EMR. -

Choisissez Créer un cluster.

-

Pour Cluster name (Nom du cluster), saisissez le nom de votre cluster.

-

Dans Release (Version), sélectionnez la version du cluster.

Note

Amazon EMR prend en charge la résiliation automatique pour les versions suivantes :

-

Pour les versions 6.x, version 6.1.0 ou ultérieure

-

Pour les versions 5.x, version 5.30.0 ou ultérieure

La terminaison automatique empêche le fonctionnement des clusters inactifs, ce qui permet de réaliser des économies.

-

-

(Facultatif) Pour Applications, choisissez Presto.

-

Choisissez l'application que vous exécutez sur le cluster.

-

Sous Networking (Mise en réseau), dans Hardware configuration (Configuration matérielle), spécifiez les paramètres de configuration matérielle.

Important

Pour la mise en réseau, choisissez VPC celui qui exécute Amazon SageMaker Studio Classic et choisissez un sous-réseau privé.

-

Sous Security and access (Sécurité et accès), définissez les paramètres de sécurité.

-

Sélectionnez Create (Créer).

Pour un didacticiel sur la création d'un EMR cluster Amazon, consultez Getting started with Amazon EMR. Pour plus d'informations sur les bonnes pratiques de configuration d'un cluster, veuillez consulter Considérations et bonnes pratiques.

Note

Pour des raisons de sécurité optimales, Data Wrangler ne peut se connecter qu'à des VPCs sous-réseaux privés. Vous ne pouvez pas vous connecter au nœud principal sauf si vous l'utilisez AWS Systems Manager pour vos EMR instances Amazon. Pour plus d'informations, voir Sécurisation de l'accès aux EMR clusters à l'aide

Vous pouvez actuellement utiliser les méthodes suivantes pour accéder à un EMR cluster Amazon :

-

Pas d'authentification

-

Protocole léger d'accès aux annuaires (LDAP)

-

IAM(Rôle d'exécution)

Le fait de ne pas utiliser l'authentification ou de l'utiliser LDAP peut vous obliger à créer plusieurs clusters et profils d'EC2instance Amazon. Si vous êtes administrateur, vous devrez peut-être fournir différents niveaux d'accès aux données aux groupes d'utilisateurs. Ces méthodes peuvent entraîner une surcharge administrative qui complique la gestion de vos utilisateurs.

Nous vous recommandons d'utiliser un rôle IAM d'exécution qui permet à plusieurs utilisateurs de se connecter au même EMR cluster Amazon. Un rôle d'exécution est un IAM rôle que vous pouvez attribuer à un utilisateur qui se connecte à un EMR cluster Amazon. Vous pouvez configurer le IAM rôle d'exécution pour qu'il dispose d'autorisations spécifiques à chaque groupe d'utilisateurs.

Utilisez les sections suivantes pour créer un EMR cluster Presto ou Hive Amazon avec LDAP Activé.

Utilisez les sections suivantes pour utiliser l'LDAPauthentification pour les EMR clusters Amazon que vous avez déjà créés.

Utilisez la procédure suivante pour importer des données à partir d'un cluster.

Pour importer des données à partir d'un cluster, procédez comme suit.

-

Ouvrez un flux Data Wrangler.

-

Choisissez Create Connection (Créer une connexion).

-

Choisissez Amazon EMR.

-

Effectuez l’une des actions suivantes :

-

(Facultatif) Pour les secrets ARN, spécifiez le numéro de ressource Amazon (ARN) de la base de données au sein du cluster. Les secrets offrent une sécurité supplémentaire. Pour plus d'informations sur les secrets, voir Qu'est-ce que c'est AWS Secrets Manager ? Pour plus d'informations sur la création d'un secret pour votre cluster, veuillez consulter Création d'un AWS Secrets Manager secret pour votre cluster.

Important

Vous devez spécifier un secret si vous utilisez un rôle IAM d'exécution pour l'authentification.

-

Dans le tableau déroulant, choisissez un cluster.

-

-

Choisissez Next (Suivant).

-

Pour Sélectionnez un point de terminaison pour

example-cluster-namecluster, choisissez un moteur de requête. -

(Facultatif) Sélectionnez Save connection (Enregistrer la connexion).

-

Choisissez Next, select login (Ensuite, sélectionner la connexion) et choisissez l'une des options suivantes :

-

No authentication (Pas d'authentification)

-

LDAP

-

IAM

-

-

Pour vous connecter

example-cluster-namecluster, spécifiez le nom d'utilisateur et le mot de passe du cluster. -

Choisissez Se connecter.

-

Dans l'éditeur de requêtes, spécifiez une SQL requête.

-

Cliquez sur Exécuter.

-

Choisissez Import (Importer).

Création d'un AWS Secrets Manager secret pour votre cluster

Si vous utilisez un rôle IAM d'exécution pour accéder à votre EMR cluster Amazon, vous devez stocker les informations d'identification que vous utilisez pour accéder à Amazon en EMR tant que secret de Secrets Manager. Vous stockez toutes les informations d'identification que vous utilisez pour accéder au cluster dans le secret.

Vous devez conserver les informations suivantes dans le secret :

-

JDBCpoint de terminaison —

jdbc:hive2:// -

DNSname — Le DNS nom de votre EMR cluster Amazon. Il s'agit soit du point de terminaison du nœud primaire, soit du nom d'hôte.

-

Port :

8446

Vous pouvez également enregistrer les informations supplémentaires suivantes dans le secret :

-

IAMrole : IAM rôle que vous utilisez pour accéder au cluster. Data Wrangler utilise votre rôle SageMaker d'exécution par défaut.

-

Chemin truststore : par défaut, Data Wrangler crée un chemin truststore pour vous. Vous pouvez également utiliser votre propre chemin truststore. Pour plus d'informations sur les chemins Truststore, consultez la section Chiffrement en transit en HiveServer 2.

-

Mot de passe truststore : par défaut, Data Wrangler crée un mot de passe truststore pour vous. Vous pouvez également utiliser votre propre chemin truststore. Pour plus d'informations sur les chemins Truststore, consultez la section Chiffrement en transit en HiveServer 2.

Utilisez la procédure ci-dessous pour stocker les informations d'identification dans un secret Secrets Manager.

Pour stocker vos informations d'identification en tant que secret, procédez comme suit.

-

Accédez à AWS Management Console.

-

Dans la barre de recherche, spécifiez Secrets Manager.

-

Sélectionnez AWS Secrets Manager.

-

Choisissez Store a new secret (Stocker un nouveau secret).

-

Pour Secret type (Type de secret), choisissez Other type of secret (Autre type de secret).

-

Sous Paires clé/valeur, sélectionnez Texte brut.

-

Pour les clusters exécutant Hive, vous pouvez utiliser le modèle suivant pour l'IAMauthentification.

{"jdbcURL": "" "iam_auth": {"endpoint": "jdbc:hive2://", #required "dns": "ip-xx-x-xxx-xxx.ec2.internal", #required "port": "10000", #required "cluster_id": "j-xxxxxxxxx", #required "iam_role": "arn:aws:iam::xxxxxxxx:role/xxxxxxxxxxxx", #optional "truststore_path": "/etc/alternatives/jre/lib/security/cacerts", #optional "truststore_password": "changeit" #optional }}Note

Après avoir importé vos données, vous leur appliquez des transformations. Vous exportez ensuite les données que vous avez transformées vers un emplacement spécifique. Si vous utilisez un bloc-notes Jupyter pour exporter vos données transformées vers Amazon S3, vous devez utiliser le chemin truststore spécifié dans l'exemple précédent.

Un secret Secrets Manager stocke le JDBC URL contenu du EMR cluster Amazon en tant que secret. L'utilisation d'un secret est plus sûre que la saisie directe de vos informations d'identification.

Utilisez la procédure suivante pour les enregistrer JDBC URL en tant que secret.

Pour le stocker JDBC URL en tant que secret, procédez comme suit.

-

Accédez à AWS Management Console.

-

Dans la barre de recherche, spécifiez Secrets Manager.

-

Sélectionnez AWS Secrets Manager.

-

Choisissez Store a new secret (Stocker un nouveau secret).

-

Pour Secret type (Type de secret), choisissez Other type of secret (Autre type de secret).

-

Pour les paires clé/valeur, spécifiez

jdbcURLcomme clé et validez JDBC URL comme valeur.Le format d'une valeur valide JDBC URL varie selon que vous utilisez l'authentification et que vous utilisez Hive ou Presto comme moteur de requête. La liste suivante indique les JBDC URL formats valides pour les différentes configurations possibles.

-

Hive, aucune authentification :

jdbc:hive2://emr-cluster-master-public-dns:10000/; -

Hive, LDAP authentification —

jdbc:hive2://emr-cluster-master-public-dns-name:10000/;AuthMech=3;UID=david;PWD=welcome123; -

Pour Hive SSL activé, le JDBC URL format dépend de l'utilisation ou non d'un fichier Java Keystore pour la TLS configuration. Le fichier Java Keystore permet de vérifier l'identité du nœud principal du EMR cluster Amazon. Pour utiliser un fichier Java Keystore, générez-le sur un EMR cluster et téléchargez-le dans Data Wrangler. Pour générer un fichier, utilisez la commande suivante sur le EMR cluster Amazon,

keytool -genkey -alias hive -keyalg RSA -keysize 1024 -keystore hive.jks. Pour plus d'informations sur l'exécution de commandes sur un EMR cluster Amazon, consultez Sécurisation de l'accès aux EMR clusters à l'aidede AWS Systems Manager. Pour charger un fichier, cliquez sur la flèche vers le haut dans le menu de navigation de gauche de l'interface utilisateur de Data Wrangler. Les JDBC URL formats suivants sont valides pour Hive lorsque SSL cette option est activée :

-

Sans fichier keystore Java :

jdbc:hive2://emr-cluster-master-public-dns:10000/;AuthMech=3;UID=user-name;PWD=password;SSL=1;AllowSelfSignedCerts=1; -

Avec un fichier keystore Java -

jdbc:hive2://emr-cluster-master-public-dns:10000/;AuthMech=3;UID=user-name;PWD=password;SSL=1;SSLKeyStore=/home/sagemaker-user/data/Java-keystore-file-name;SSLKeyStorePwd=Java-keystore-file-passsword;

-

-

Presto, aucune authentification — jdbc:presto ://

emr-cluster-master-public-dns:8889/ ; -

Pour Presto avec LDAP authentification SSL activée, le JDBC URL format dépend de l'utilisation ou non d'un fichier Java Keystore pour la TLS configuration. Le fichier Java Keystore permet de vérifier l'identité du nœud principal du EMR cluster Amazon. Pour utiliser un fichier Java Keystore, générez-le sur un EMR cluster et téléchargez-le dans Data Wrangler. Pour charger un fichier, cliquez sur la flèche vers le haut dans le menu de navigation de gauche de l'interface utilisateur de Data Wrangler. Pour plus d'informations sur la création d'un fichier Java Keystore pour Presto, voir Fichier Java Keystore

pour. TLS Pour plus d'informations sur l'exécution de commandes sur un EMR cluster Amazon, consultez Sécurisation de l'accès aux EMR clusters à l'aide de AWS Systems Manager. -

Sans fichier keystore Java :

jdbc:presto://emr-cluster-master-public-dns:8889/;SSL=1;AuthenticationType=LDAP Authentication;UID=user-name;PWD=password;AllowSelfSignedServerCert=1;AllowHostNameCNMismatch=1; -

Avec un fichier keystore Java -

jdbc:presto://emr-cluster-master-public-dns:8889/;SSL=1;AuthenticationType=LDAP Authentication;SSLTrustStorePath=/home/sagemaker-user/data/Java-keystore-file-name;SSLTrustStorePwd=Java-keystore-file-passsword;UID=user-name;PWD=password;

-

-

Tout au long du processus d'importation de données depuis un EMR cluster Amazon, vous pouvez rencontrer des problèmes. Pour obtenir des informations sur la résolution de ces problèmes, veuillez consulter Résolution des problèmes liés à Amazon EMR.

Importer des données depuis Databricks () JDBC

Vous pouvez utiliser Databricks comme source de données pour votre flux Amazon SageMaker Data Wrangler. Pour importer un ensemble de données depuis Databricks, utilisez la fonctionnalité d'importation JDBC (Java Database Connectivity) pour accéder à votre base de données Databricks. Après avoir accédé à la base de données, spécifiez une SQL requête pour obtenir les données et les importer.

Nous partons du principe que vous avez un cluster Databricks en cours d'exécution et que vous y avez configuré votre JDBC pilote. Pour plus d'informations, consultez les pages suivantes de la documentation Databricks :

Data Wrangler enregistre votre contenu. JDBC URL AWS Secrets Manager Vous devez autoriser votre rôle IAM d'exécution Amazon SageMaker Studio Classic à utiliser Secrets Manager. Procédez comme suit pour accorder des autorisations.

Pour accorder des autorisations à Secrets Manager, procédez comme suit.

-

Connectez-vous à la IAM console AWS Management Console et ouvrez-la à l'adresse https://console.aws.amazon.com/iam/

. -

Sélectionnez Roles (Rôles).

-

Dans la barre de recherche, spécifiez le rôle SageMaker d'exécution Amazon utilisé par Amazon SageMaker Studio Classic.

-

Choisissez le rôle.

-

Choisissez Add permissions (Ajouter des autorisations).

-

Choisissez Create inline policy (Créer une politique en ligne).

-

Pour Service, spécifiez Secrets Manager et choisissez-le.

-

Pour Actions, sélectionnez l'icône en forme de flèche en regard de Permissions management (Gestion des autorisations).

-

Choisissez PutResourcePolicy.

-

Pour Resources (Ressources), choisissez Specific (Spécifique).

-

Cochez la case en regard de Any in this account (N'importe quelle ressource dans ce compte).

-

Choisissez Review policy (Examiner une politique).

-

Pour Name (Nom), spécifiez un nom.

-

Sélectionnez Create policy (Créer la stratégie).

Vous pouvez utiliser des partitions pour importer vos données plus rapidement. Les partitions permettent à Data Wrangler de traiter les données en parallèle. Par défaut, Data Wrangler utilise 2 partitions. Dans la plupart des cas d'utilisation, 2 partitions offrent des vitesses de traitement des données quasi optimales.

Si vous choisissez de spécifier plus de 2 partitions, vous pouvez également spécifier une colonne pour partitionner les données. Le type des valeurs de la colonne doit être numérique ou date.

Nous vous recommandons d'utiliser des partitions uniquement si vous comprenez la structure des données et la manière dont elles sont traitées.

Vous pouvez importer l'intégralité du jeu de données ou en échantillonner une partie. Pour une base de données Databricks, il fournit les options d'échantillonnage suivantes :

-

None (Aucun) : importez l'intégralité du jeu de données.

-

First K (K premières lignes) : échantillonnez les K premières lignes du jeu de données, où K est un entier que vous spécifiez.

-

Randomized (Aléatoire) : prélève un échantillon aléatoire d'une taille que vous spécifiez.

-

Stratified (Stratifié) : prélève un échantillon aléatoire stratifié. Un échantillon stratifié conserve le rapport des valeurs dans une colonne.

Procédez comme suit pour importer vos données à partir d'une base de données Databricks.

Pour importer des données depuis Databricks, procédez comme suit.

-

Connectez-vous à Amazon SageMaker Console

. -

Choisissez Studio.

-

Choisissez Launch app (Lancer l'application).

-

Dans la liste déroulante, sélectionnez Studio.

-

Dans l'onglet Import data (Importation de données) de votre flux Data Wrangler, choisissez Databricks.

-

Spécifiez les champs suivants :

-

Dataset name (Nom du jeu de données) : nom que vous souhaitez utiliser pour le jeu de données de votre flux Data Wrangler.

-

Driver (Pilote) : com.simba.spark.jdbc.Driver.

-

JDBCURL— Celui URL de la base de données Databricks. Le URL formatage peut varier selon les instances de Databricks. Pour plus d'informations sur la recherche URL et la spécification des paramètres qu'il contient, consultez la section Paramètres JDBC de configuration et de connexion

. Voici un exemple de formatage URL possible : jdbc:spark ://aws-sagemaker-datawrangler.cloud.databricks.com:443/default ; =http ; ssl=1 ; =sql/protocolv1/o/3122619508517275/0909-200301-cut318 ; =3 ; = transportMode httpPath AuthMech UID token;PWD=personal-access-token.Note

Vous pouvez spécifier un secret ARN contenant le au JDBC URL lieu de le spécifier JDBC URL lui-même. Le secret doit contenir une paire clé-valeur au format suivant :

jdbcURL:. Pour plus d'informations, consultez Qu'est-ce que Secrets Manager ?.JDBC-URL

-

-

Spécifiez une SQL SELECT déclaration.

Note

Data Wrangler ne prend pas en charge les expressions de table communes (CTE) ou les tables temporaires dans une requête.

-

Pour Sampling (Échantillonnage), choisissez une méthode d'échantillonnage.

-

Cliquez sur Exécuter.

-

(Facultatif) Pour le PREVIEW, choisissez l'équipement pour ouvrir les paramètres de partition.

-

Spécifiez le nombre de partitions. Vous pouvez partitionner par colonne si vous spécifiez le nombre de partitions :

-

Enter number of partitions (Saisissez le nombre de partitions) : spécifiez une valeur supérieure à 2.

-

(Facultatif) Partition by column (Partitionner par colonne) : renseignez les champs suivants. Vous ne pouvez partitionner par colonne que si vous avez spécifié une valeur dans le champ Enter number of partitions (Saisissez le nombre de partitions).

-

Select column (Sélectionner la colonne) – Sélectionnez la colonne que vous utilisez pour la partition de données. Le type de données de la colonne doit être numérique ou date.

-

Upper bound (Limite supérieure) – À partir des valeurs de la colonne que vous avez spécifiée, la limite supérieure est la valeur que vous utilisez dans la partition. La valeur que vous spécifiez ne modifie pas les données que vous importez. Elle n'affecte que la vitesse d'importation. Pour obtenir les meilleures performances, spécifiez une limite supérieure proche du maximum de la colonne.

-

Lower bound (Limite inférieure) – À partir des valeurs de la colonne que vous avez spécifiée, la limite inférieure est la valeur que vous utilisez dans la partition. La valeur que vous spécifiez ne modifie pas les données que vous importez. Elle n'affecte que la vitesse d'importation. Pour obtenir les meilleures performances, spécifiez une limite inférieure proche du minimum de la colonne.

-

-

-

-

Choisissez Import (Importer).

Importer des données depuis Salesforce Data Cloud

Vous pouvez utiliser Salesforce Data Cloud comme source de données dans Amazon SageMaker Data Wrangler pour préparer les données de votre Salesforce Data Cloud à des fins d'apprentissage automatique.

Avec Salesforce Data Cloud comme source de données dans Data Wrangler, vous pouvez vous connecter rapidement à vos données Salesforce sans écrire une seule ligne de code. Vous pouvez joindre vos données Salesforce à des données provenant de toute autre source de données Data Wrangler.

Une fois connecté au cloud de données, vous pouvez effectuer les opérations suivantes :

-

Visualiser vos données à l'aide de visualisations intégrées

-

Comprendre les données et identifier les erreurs potentielles et les valeurs extrêmes

-

Transformer les données grâce à plus de 300 transformations intégrées

-

Exporter les données que vous avez transformées

Configuration d'administrateur

Important

Avant de commencer, assurez-vous que vos utilisateurs exécutent Amazon SageMaker Studio Classic version 1.3.0 ou ultérieure. Pour plus d'informations sur la vérification de la version de Studio Classic et sa mise à jour, consultezPréparez les données ML avec Amazon SageMaker Data Wrangler.

Lorsque vous configurez l'accès à Salesforce Data Cloud, vous devez effectuer les tâches suivantes :

-

Obtenir votre domaine SalesforceURL. Salesforce désigne également le domaine URL comme celui de votre organisationURL.

-

Obtenir des OAuth informations d'identification auprès de Salesforce.

-

Obtenir l'autorisation URL et le jeton URL pour votre domaine Salesforce.

-

Création d'un AWS Secrets Manager secret avec la OAuth configuration.

-

Créer une configuration du cycle de vie que Data Wrangler utilise pour lire les informations d'identification contenues dans le secret.

-

Permettre à Data Wrangler de lire le secret.

Après avoir effectué les tâches précédentes, vos utilisateurs peuvent se connecter au Salesforce Data Cloud à l'aide deOAuth.

Note

Vos utilisateurs peuvent rencontrer des problèmes une fois que vous avez tout configuré. Pour en savoir plus sur la résolution des problèmes, consultez Résolution des problèmes avec Salesforce.

Pour obtenir le domaine, procédez comme suitURL.

-

Accédez à la page de connexion de Salesforce.

-

Pour Recherche rapide, spécifiez Mon domaine.

-

Copiez la valeur de Current My Domain URL dans un fichier texte.

-

Ajoutez

https://au début duURL.

Après avoir obtenu le domaine SalesforceURL, vous pouvez utiliser la procédure suivante pour obtenir les informations de connexion auprès de Salesforce et autoriser Data Wrangler à accéder à vos données Salesforce.

Pour obtenir les informations d'identification de connexion auprès de Salesforce et donner l'accès à Data Wrangler, procédez comme suit.

-

Accédez à votre domaine Salesforce URL et connectez-vous à votre compte.

-

Choisissez l’icône d’engrenage.

-

Dans la barre de recherche qui apparaît, spécifiez Gestionnaire d'applications.

-

Sélectionnez Nouvelle application connectée.

-

Spécifiez les champs suivants :

-

Nom de l'application connectée : vous pouvez spécifier n'importe quel nom, mais nous vous recommandons de choisir un nom qui inclut Data Wrangler. Par exemple, vous pouvez spécifier Intégration de Salesforce Data Cloud Data Wrangler.

-

APIname — Utilise la valeur par défaut.

-

Adresse e-mail de contact : spécifiez votre adresse e-mail.

-

Sous le APItitre (Activer OAuth les paramètres), cochez la case pour activer OAuth les paramètres.

-

Pour Callback, URL spécifiez Amazon SageMaker Studio ClassicURL. Pour obtenir le URL for Studio Classic, accédez-y depuis le AWS Management Console et copiez leURL.

-

-

Sous Étendue OAuth sélectionnée, déplacez ce qui suit de la liste Étendue disponible OAuth vers Étendue sélectionnée OAuth :

-

Gérez les données utilisateur via APIs (

api) -

Exécuter les demandes à tout moment (

refresh_token,offline_access) -

Exécuter ANSI SQL des requêtes sur les données Salesforce Data Cloud (

cdp_query_api) -

Gérer les données de profil de Salesforce Customer Data Platform (

cdp_profile_api)

-

-

Choisissez Save (Enregistrer). Après avoir enregistré vos modifications, Salesforce ouvre une nouvelle page.

-

Choisissez Continue

-

Accédez à Clé et secret du consommateur.

-

Choisissez Gérer les informations du consommateur. Salesforce vous redirige vers une nouvelle page où vous devrez peut-être passer une authentification à deux facteurs.

-

Important

Copiez la clé du consommateur et le secret du consommateur dans un éditeur de texte. Vous avez besoin de ces informations pour connecter le cloud de données à Data Wrangler.

-

Revenez à Gérer les applications connectées.

-

Accédez à Nom de l'application connectée et au nom de votre application.

-

Choisissez Gérer.

-

Sélectionnez Modifier les politiques.

-

Modifiez Relaxation d'IP pour Assouplir les restrictions d'IP.

-

Choisissez Save (Enregistrer).

-

Une fois que vous avez autorisé l'accès à votre Salesforce Data Cloud, vous devez fournir des autorisations à vos utilisateurs. Procédez comme suit pour leur accorder des autorisations.

Pour fournir des autorisations à vos utilisateurs, procédez comme suit.

-

Accédez à la page d'accueil de la configuration.

-

Dans la barre de navigation de gauche, recherchez Utilisateurs et choisissez l'élément de menu Utilisateurs.

-

Choisissez le lien hypertexte avec votre nom d'utilisateur.

-

Accédez à Attributions d'un jeu d'autorisations.

-

Choisissez Modifier les attributions.

-

Ajoutez les autorisations suivantes :

-

Administrateur de la plateforme de données client

-

Spécialiste en connaissance des données de la plateforme de données client

-

-

Choisissez Save (Enregistrer).

Une fois que vous avez obtenu les informations relatives à votre domaine Salesforce, vous devez obtenir l'autorisation URL et le jeton URL AWS Secrets Manager correspondant au secret que vous créez.

Pour obtenir l'autorisation URL et le jeton, procédez comme suitURL.

Pour obtenir l'autorisation URL et le jeton URL

-

Accédez à votre domaine SalesforceURL.

-

Utilisez l'une des méthodes suivantes pour obtenir leURLs. Si vous utilisez une distribution Linux avec

curletjqinstallés, nous vous recommandons d'utiliser la méthode qui ne fonctionne que sous Linux.-

(Linux uniquement) Spécifiez la commande suivante dans votre terminal.

curlsalesforce-domain-URL/.well-known/openid-configuration | \ jq '. | { authorization_url: .authorization_endpoint, token_url: .token_endpoint }' | \ jq '. += { identity_provider: "SALESFORCE", client_id: "example-client-id", client_secret: "example-client-secret" }' -

-

Naviguez vers

example-org-URL/.well-known/openid-configuration -

Copiez

authorization_endpointettoken_endpointdans un éditeur de texte. -

Créez l'JSONobjet suivant :

{ "identity_provider": "SALESFORCE", "authorization_url": "example-authorization-endpoint", "token_url": "example-token-endpoint", "client_id": "example-consumer-key", "client_secret": "example-consumer-secret" }

-

-

Après avoir créé l'objet OAuth de configuration, vous pouvez créer un AWS Secrets Manager secret qui le stocke. Utilisez la procédure suivante pour créer le secret.

Pour créer un secret, procédez comme suit.

-

Accédez à la console AWS Secrets Manager

. -

Choisissez Stocker un secret.

-

Sélectionnez Autre type de secret.

-

Sous Paires clé/valeur, sélectionnez Texte brut.

-

Remplacez le champ vide JSON par les paramètres de configuration suivants.

{ "identity_provider": "SALESFORCE", "authorization_url": "example-authorization-endpoint", "token_url": "example-token-endpoint", "client_id": "example-consumer-key", "client_secret": "example-consumer-secret" } -

Choisissez Suivant.

-

Dans Nom du secret, spécifiez le nom du secret.

-

Sous Balises, choisissez Ajouter.

-

Pour Clé, spécifiez sagemaker:partner. Pour Valeur, nous vous recommandons de spécifier une valeur qui pourrait être utile pour votre cas d'utilisation. Toutefois, vous pouvez spécifier ce que vous voulez.

Important

Vous devez créer la clé. Vous ne pouvez pas importer vos données depuis Salesforce sans la créer.

-

-

Choisissez Suivant.

-

Choisissez Stocker.

-

Choisissez le secret que vous avez créé.

-

Prenez en compte les champs suivants :

-

Le numéro de ressource Amazon (ARN) du secret

-

Le nom du secret

-

Après avoir créé le secret, vous devez ajouter des autorisations permettant à Data Wrangler de le lire. Procédez comme suit pour ajouter des autorisations.

Pour ajouter des autorisations de lecture pour Data Wrangler, procédez comme suit.

-

Accédez à la SageMaker console Amazon

. -

Choisissez des domaines.

-

Choisissez le domaine que vous utilisez pour accéder à Data Wrangler.

-

Choisissez votre Profil utilisateur.

-

Sous Détails, recherchez le Rôle d'exécution. ARNIl est au format suivant :

arn:aws:iam::111122223333:role/. Notez le rôle d' SageMaker exécution. À l'intérieurARN, c'est tout ce qui suitexample-rolerole/. -

Accédez à la console IAM

. -

Dans la barre de IAM recherche de recherche, spécifiez le nom du rôle SageMaker d'exécution.

-

Choisissez le rôle.

-

Choisissez Add permissions (Ajouter des autorisations).

-

Choisissez Create inline policy (Créer une politique en ligne).

-

Choisissez l'JSONonglet.

-

Spécifiez la politique suivante dans l'éditeur.

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "secretsmanager:GetSecretValue", "secretsmanager:PutSecretValue" ], "Resource": "arn:aws:secretsmanager:*:*:secret:*", "Condition": { "ForAnyValue:StringLike": { "aws:ResourceTag/sagemaker:partner": "*" } } }, { "Effect": "Allow", "Action": [ "secretsmanager:UpdateSecret" ], "Resource": "arn:aws:secretsmanager:*:*:secret:AmazonSageMaker-*" } ] } -

Choisissez Examiner une politique.

-

Pour Name (Nom), spécifiez un nom.

-

Sélectionnez Create policy (Créer la stratégie).

Une fois que vous avez autorisé Data Wrangler à lire le secret, vous devez ajouter une configuration du cycle de vie utilisant votre secret Secrets Manager à votre profil utilisateur Amazon SageMaker Studio Classic.

Utilisez la procédure suivante pour créer une configuration de cycle de vie et l'ajouter au profil Studio Classic.

Pour créer une configuration de cycle de vie et l'ajouter au profil Studio Classic, procédez comme suit.

-

Accédez à la SageMaker console Amazon.

-

Choisissez des domaines.

-

Choisissez le domaine que vous utilisez pour accéder à Data Wrangler.

-

Choisissez votre Profil utilisateur.

-

Si vous voyez les applications suivantes, supprimez-les :

-

KernelGateway

-

JupyterKernel

Note

La suppression des applications met à jour Studio Classic. Les mises à jour peuvent prendre un certain temps.

-

-

Pendant que vous attendez que les mises à jour soient effectuées, choisissez Configurations de cycle de vie.

-

Assurez-vous que la page sur laquelle vous vous trouvez indique les configurations du cycle de vie de Studio Classic.

-

Choisissez Create configuration (Créer une configuration).

-

Assurez-vous qu'Application Jupyter Server a été sélectionnée.

-

Choisissez Suivant.

-

Pour Nom, spécifiez un nom pour la configuration.

-

Pour Scripts, spécifiez le script suivant :

#!/bin/bash set -eux cat > ~/.sfgenie_identity_provider_oauth_config <<EOL { "secret_arn": "secrets-arn-containing-salesforce-credentials" } EOL -

Sélectionnez Envoyer.

-

Dans la barre de navigation de gauche, sélectionnez les domaines.

-

Choisissez votre domaine.

-

Choisissez Environment (Environnement).

-

Sous Configurations du cycle de vie pour les applications personnelles de Studio Classic, sélectionnez Attacher.

-

Sélectionnez Configuration existante.

-

Sous Configurations du cycle de vie de Studio Classic, sélectionnez la configuration du cycle de vie que vous avez créée.

-

Choisissez Attacher au domaine.

-

Cochez la case à côté de la configuration du cycle de vie que vous avez attachée.

-

Sélectionnez Définir comme valeur par défaut.

Vous pouvez rencontrer des problèmes lors de la configuration de votre cycle de vie. Pour en savoir plus sur leur débogage, consultez Débogage des configurations de cycle de vie.

Guide des scientifiques des données

Utilisez ce qui suit pour connecter Salesforce Data Cloud et accéder à vos données dans Data Wrangler.

Important

Votre administrateur doit utiliser les informations des sections précédentes pour configurer Salesforce Data Cloud. Si vous rencontrez des problèmes, contactez-les pour obtenir de l'aide.

Pour ouvrir Studio Classic et vérifier sa version, consultez la procédure suivante.

-

Suivez les étapes ci-dessous Prérequis pour accéder à Data Wrangler via Amazon SageMaker Studio Classic.

-

À côté de l'utilisateur que vous souhaitez utiliser pour lancer Studio Classic, sélectionnez Lancer l'application.

-

Choisissez Studio.

Pour créer un jeu de données dans Data Wrangler à partir des données de Salesforce Data Cloud

-

Connectez-vous à Amazon SageMaker Console

. -

Choisissez Studio.

-

Choisissez Launch app (Lancer l'application).

-

Dans la liste déroulante, sélectionnez Studio.

-

Choisissez l'icône d'accueil.

-

Choisissez Data (Données).

-

Choisissez Data Wrangler.

-

Choisissez Import data (Importer les données).

-

Sous Disponible, choisissez Salesforce Data Cloud.

-

Dans Nom de la connexion, spécifiez le nom de votre connexion à Salesforce Data Cloud.

-

Pour Org URL, spécifiez l'organisation URL dans votre compte Salesforce. Vous pouvez les obtenir URL auprès de vos administrateurs.

-

Choisissez Se connecter.

-

Spécifiez vos informations d'identification pour vous connecter à Salesforce.

Vous pouvez commencer à créer un jeu de données à partir des données de Salesforce Data Cloud une fois que vous vous y êtes connecté.

Après avoir sélectionné une table, vous pouvez écrire des requêtes et les exécuter. La sortie de votre requête s'affichera sous Résultats de la requête.

Une fois que vous avez réglé la sortie de votre requête, vous pouvez l'importer dans un flux Data Wrangler pour effectuer des transformations de données.

Après avoir créé un jeu de données, accédez à l'écran Flux de données pour commencer à transformer vos données.

Importer des données depuis Snowflake

Vous pouvez utiliser Snowflake comme source de données dans Data Wrangler pour préparer SageMaker les données dans Snowflake à des fins d'apprentissage automatique.

Avec Snowflake comme source de données dans Data Wrangler, vous pouvez vous connecter rapidement à Snowflake sans écrire une seule ligne de code. Vous pouvez joindre vos données dans Snowflake à des données provenant de toute autre source de données Data Wrangler.

Une fois connecté, vous pouvez interroger de manière interactive les données stockées dans Snowflake, transformer les données avec plus de 300 transformations de données préconfigurées, comprendre les données et identifier les erreurs potentielles et les valeurs extrêmes grâce à un ensemble de modèles de visualisation préconfigurés robustes, identifier rapidement les incohérences dans votre flux de préparation des données, et diagnostiquer les problèmes avant que les modèles soient déployés en production. Enfin, vous pouvez exporter votre flux de travail de préparation des données vers Amazon S3 pour l'utiliser avec d'autres SageMaker fonctionnalités telles qu'Amazon SageMaker Autopilot, Amazon SageMaker Feature Store et Amazon SageMaker Model Building Pipelines.

Vous pouvez chiffrer le résultat de vos requêtes à l'aide d'une AWS Key Management Service clé que vous avez créée. Pour plus d'informations sur AWS KMS, voir AWS Key Management Service.

Guide de l'administrateur

Important

Pour en savoir plus sur le contrôle d'accès détaillé et les bonnes pratiques, veuillez consulter la rubrique Contrôle d'accès de sécurité

Cette section est destinée aux administrateurs Snowflake qui configurent l'accès à Snowflake depuis Data Wrangler. SageMaker

Important

Vous êtes responsable de la gestion et de la surveillance du contrôle d'accès dans Snowflake. Data Wrangler n'ajoute pas de couche de contrôle d'accès par rapport à Snowflake.

Le contrôle d'accès inclut les éléments suivants :

-

Les données auxquelles un utilisateur accède

-

(Facultatif) L'intégration du stockage qui permet à Snowflake d'écrire les résultats des requêtes dans un compartiment Amazon S3

-

Les requêtes qu'un utilisateur peut exécuter

(Facultatif) Configurer les autorisations d'importation de données Snowflake

Par défaut, Data Wrangler interroge les données dans Snowflake sans en créer de copie dans un emplacement Amazon S3. Utilisez les informations suivantes si vous configurez une intégration de stockage avec Snowflake. Vos utilisateurs peuvent utiliser une intégration de stockage pour stocker les résultats de leurs requêtes dans un emplacement Amazon S3.

Vos utilisateurs peuvent avoir différents niveaux d'accès aux données sensibles. Pour une sécurité optimale des données, fournissez à chaque utilisateur sa propre intégration de stockage. Chaque intégration de stockage doit avoir sa propre politique de gouvernance des données.

Cette fonction n'est actuellement pas disponible dans les régions d'adhésion.

Snowflake a besoin des autorisations suivantes sur un compartiment et un répertoire S3 pour pouvoir accéder aux fichiers du répertoire :

-

s3:GetObject -

s3:GetObjectVersion -

s3:ListBucket -

s3:ListObjects -

s3:GetBucketLocation

Création d'une IAM politique

Vous devez créer une IAM politique pour configurer les autorisations d'accès permettant à Snowflake de charger et de décharger des données depuis un compartiment Amazon S3.

Le document de JSON stratégie que vous utilisez pour créer la stratégie est le suivant :

# Example policy for S3 write access # This needs to be updated { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "s3:PutObject", "s3:GetObject", "s3:GetObjectVersion", "s3:DeleteObject", "s3:DeleteObjectVersion" ], "Resource": "arn:aws:s3:::bucket/prefix/*" }, { "Effect": "Allow", "Action": [ "s3:ListBucket" ], "Resource": "arn:aws:s3:::bucket/", "Condition": { "StringLike": { "s3:prefix": ["prefix/*"] } } } ] }

Pour obtenir des informations et des procédures relatives à la création de politiques à l'aide de documents de stratégie, consultez la section Création IAM de politiques.

Pour une documentation qui fournit une vue d'ensemble de l'utilisation IAM des autorisations avec Snowflake, consultez les ressources suivantes :

Pour accorder à l'intégration de stockage l'autorisation d'utiliser le rôle Snowflake du scientifique des données, vous devez exécuter GRANT USAGE ON INTEGRATION

integration_name TO snowflake_role;.

-

integration_nameest le nom de votre intégration de stockage. -

snowflake_roleest le nom du rôle Snowflakepar défaut donné au scientifique des données.

Configuration de Snowflake Access OAuth

Au lieu de demander à vos utilisateurs d'entrer directement leurs informations d'identification dans Data Wrangler, vous pouvez leur demander d'utiliser un fournisseur d'identité pour accéder à Snowflake. Vous trouverez ci-dessous des liens vers la documentation Snowflake qui répertorient les fournisseurs d'identité pris en charge par Data Wrangler.

Utilisez la documentation des liens précédents pour configurer l'accès à votre fournisseur d'identité. Les informations et les procédures dans cette section vous aident à comprendre comment utiliser correctement la documentation pour accéder à Snowflake dans Data Wrangler.

Votre fournisseur d'identité doit reconnaître Data Wrangler en tant qu'application. Pour enregistrer Data Wrangler comme application dans le fournisseur d'identité, procédez comme suit :

-

Sélectionnez la configuration qui lance le processus d'enregistrement de Data Wrangler en tant qu'application.

-

Fournissez aux utilisateurs du fournisseur d'identité l'accès à Data Wrangler.

-

Activez l'authentification OAuth du client en stockant les informations d'identification du client sous forme de AWS Secrets Manager secret.

-

Spécifiez une redirection URL au format suivant : https ://

domain-ID.studio.Région AWS.sagemaker.aws/jupyter/default/labImportant

Vous spécifiez l'ID de SageMaker domaine Amazon Région AWS que vous utilisez pour exécuter Data Wrangler.

Important

Vous devez en enregistrer un URL pour chaque SageMaker domaine Amazon et pour chaque domaine sur Région AWS lequel vous exécutez Data Wrangler. Les utilisateurs d'un domaine pour Région AWS lesquels aucune redirection n'est URLs configurée ne pourront pas s'authentifier auprès du fournisseur d'identité pour accéder à la connexion Snowflake.

-

Assurez-vous que le code d'autorisation et les types d'octroi de jetons d'actualisation sont autorisés pour l'application Data Wrangler.

Au sein de votre fournisseur d'identité, vous devez configurer un serveur qui envoie OAuth des jetons à Data Wrangler au niveau de l'utilisateur. Le serveur envoie les jetons avec Snowflake comme public.

Snowflake utilise le concept de rôles distincts de ceux dans lesquels les IAM rôles sont utilisés. AWS Vous devez configurer le fournisseur d'identité pour qu'il utilise n'importe quel rôle afin d'utiliser le rôle par défaut associé au compte Snowflake. Par exemple, si un utilisateur a le rôle systems administrator par défaut dans son profil Snowflake, la connexion entre Data Wrangler et Snowflake utilise systems administrator comme rôle.

Suivez la procédure ci-dessous pour configurer le serveur.

Pour configurer le serveur, procédez comme suit. Vous travaillez dans Snowflake pour toutes les étapes sauf la dernière.

-

Commencez à configurer le serveur ouAPI.

-

Configurez le serveur d'autorisation pour utiliser le code d'autorisation et actualiser les types d'octroi de jetons.

-

Spécifiez la durée de vie du jeton d'accès.

-

Définissez le délai d'inactivité du jeton d'actualisation. Le délai d'inactivité est la durée au cours de laquelle le jeton d'actualisation expire s'il n'est pas utilisé.

Note

Si vous planifiez des tâches dans Data Wrangler, nous recommandons que le délai d'inactivité soit supérieur à la fréquence de la tâche de traitement. Dans le cas contraire, certaines tâches de traitement risquent d'échouer car le jeton d'actualisation a expiré avant qu'elles n'aient pu être exécutées. Lorsque le jeton d'actualisation expire, l'utilisateur doit s'authentifier à nouveau en accédant à la connexion qu'il a établie avec Snowflake via Data Wrangler.

-

Spécifiez

session:role-anycomme nouvelle portée.Note

Pour Azure AD, copiez l'identifiant unique de la portée. Data Wrangler vous demande de lui fournir l'identifiant.

-

Important

Dans l'intégration OAuth de sécurité externe pour Snowflake, activez.

external_oauth_any_role_mode

Important

Data Wrangler ne prend pas en charge la rotation des jetons d'actualisation. L'utilisation de jetons d'actualisation en rotation peut entraîner des échecs d'accès ou la nécessité pour les utilisateurs de se connecter fréquemment.

Important

Si le jeton d'actualisation expire, vos utilisateurs doivent s'authentifier à nouveau en accédant à la connexion qu'ils ont établie avec Snowflake via Data Wrangler.

Après avoir configuré le OAuth fournisseur, vous fournissez à Data Wrangler les informations dont il a besoin pour se connecter au fournisseur. Vous pouvez utiliser la documentation de votre fournisseur d'identité pour obtenir des valeurs pour les champs suivants :

-

Jeton URL — Le URL jeton que le fournisseur d'identité envoie à Data Wrangler.

-

Autorisation URL : URL du serveur d'autorisation du fournisseur d'identité.

-

ID client : ID du fournisseur d'identité.

-

Secret du client : secret que seul le serveur d'autorisation API reconnaît.

-

(Azure AD uniquement) Les informations d'identification du OAuth scope que vous avez copiées.

Vous stockez les champs et les valeurs dans un AWS Secrets Manager secret et vous les ajoutez à la configuration du cycle de vie Amazon SageMaker Studio Classic que vous utilisez pour Data Wrangler. Une configuration du cycle de vie est un script shell. Utilisez-le pour rendre le nom de ressource Amazon (ARN) du secret accessible à Data Wrangler. Pour plus d'informations sur la création de secrets, voir Déplacer des secrets codés en dur vers AWS Secrets Manager. Pour plus d'informations sur l'utilisation des configurations de cycle de vie dans Studio Classic, consultezUtilisez les configurations du cycle de vie pour personnaliser Studio Classic.

Important

Avant de créer un secret Secrets Manager, assurez-vous que le rôle SageMaker d'exécution que vous utilisez pour Amazon SageMaker Studio Classic est autorisé à créer et à mettre à jour des secrets dans Secrets Manager. Pour plus d'informations sur l'ajout d'autorisations, consultez Exemple : Autorisation de créer des secrets.

Pour Okta et Ping Federate, le secret doit avoir le format suivant :