Terjemahan disediakan oleh mesin penerjemah. Jika konten terjemahan yang diberikan bertentangan dengan versi bahasa Inggris aslinya, utamakan versi bahasa Inggris.

Apa itu Amazon Data Firehose?

Amazon Data Firehose adalah layanan yang dikelola sepenuhnya untuk mengirimkan data streaming

Untuk informasi selengkapnya tentang solusi AWS big data, lihat Big Data di AWS

catatan

Perhatikan Solusi Data AWS Streaming terbaru untuk Amazon MSK

Pelajari konsep kunci

Saat Anda memulai Amazon Data Firehose, Anda bisa mendapatkan keuntungan dari memahami konsep-konsep berikut.

- Aliran Firehose

-

Entitas yang mendasari Amazon Data Firehose. Anda menggunakan Amazon Data Firehose dengan membuat aliran Firehose dan kemudian mengirim data ke sana. Untuk informasi selengkapnya, silakan lihat Tutorial: Membuat aliran Firehose dari konsol dan Mengirim data ke aliran Firehose.

- Rekam

-

Data yang menarik yang dikirim oleh produsen data Anda ke aliran Firehose. Sebuah catatan bisa berukuran sebesar 1.000 KB.

- Produsen data

-

Produsen mengirim catatan ke aliran Firehose. Misalnya, server web yang mengirimkan data log ke aliran Firehose adalah produsen data. Anda juga dapat mengonfigurasi aliran Firehose untuk secara otomatis membaca data dari aliran data Kinesis yang ada, dan memuatnya ke tujuan. Untuk informasi selengkapnya, lihat Mengirim data ke aliran Firehose.

- Ukuran buffer dan interval buffer

-

Amazon Data Firehose menyangga data streaming yang masuk ke ukuran tertentu atau untuk jangka waktu tertentu sebelum mengirimkannya ke tujuan. Buffer Sizemasuk MBs dan Buffer Interval dalam hitungan detik.

Memahami aliran data di Amazon Data Firehose

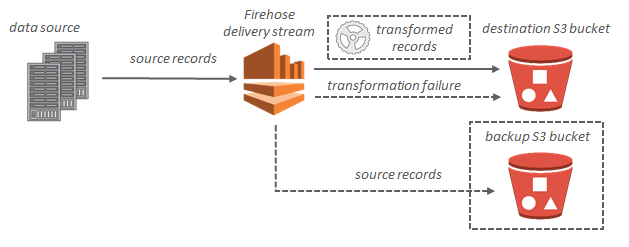

Untuk tujuan Amazon S3, data streaming dikirim ke bucket S3 Anda. Jika transformasi data diaktifkan, Anda dapat secara opsional mencadangkan data sumber ke bucket Amazon S3 lain.

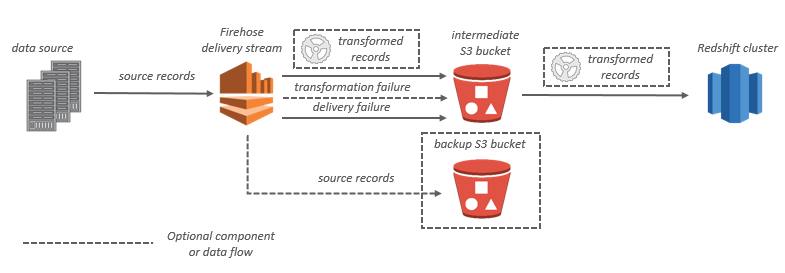

Untuk tujuan Amazon Redshift, data streaming dikirim ke bucket S3 Anda. Amazon Data Firehose kemudian mengeluarkan perintah Amazon COPY Redshift untuk memuat data dari bucket S3 ke cluster Amazon Redshift. Jika transformasi data diaktifkan, Anda dapat secara opsional mencadangkan data sumber ke bucket Amazon S3 lain.

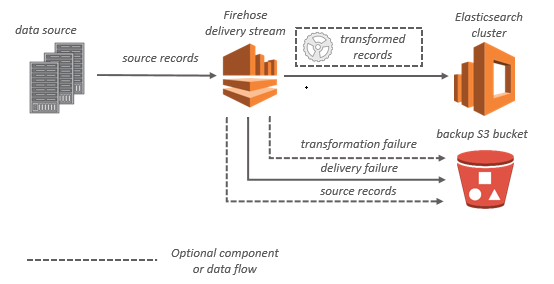

Untuk tujuan OpenSearch Layanan, data streaming dikirimkan ke kluster OpenSearch Layanan Anda, dan secara opsional dapat dicadangkan ke bucket S3 Anda secara bersamaan.

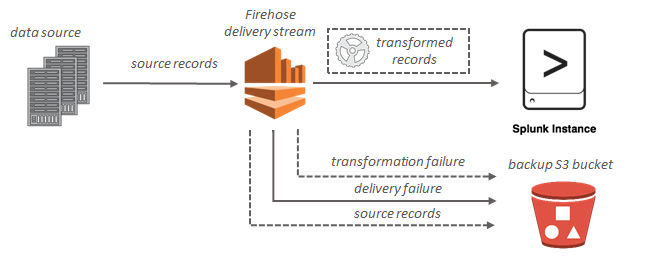

Untuk tujuan Splunk, data streaming dikirim ke Splunk, dan secara opsional dapat dicadangkan ke bucket S3 Anda secara bersamaan.