Terjemahan disediakan oleh mesin penerjemah. Jika konten terjemahan yang diberikan bertentangan dengan versi bahasa Inggris aslinya, utamakan versi bahasa Inggris.

Kompiler SageMaker Pelatihan Amazon

penting

Amazon Web Services (AWS) mengumumkan bahwa tidak akan ada rilis baru atau versi SageMaker Training Compiler. Anda dapat terus menggunakan SageMaker Training Compiler melalui AWS Deep Learning Containers (DLCs) for SageMaker Training yang ada. Penting untuk dicatat bahwa meskipun yang ada DLCs tetap dapat diakses, mereka tidak akan lagi menerima tambalan atau pembaruan dari AWS, sesuai dengan Kebijakan Dukungan Framework AWS Deep Learning Containers.

Gunakan Amazon SageMaker Training Compiler untuk melatih model deep learning (DL) lebih cepat pada instans GPU terukur yang dikelola oleh AI. SageMaker

Apa itu SageMaker Training Compiler?

State-of-the-art Model deep learning (DL) terdiri dari jaringan saraf berlapis-lapis yang kompleks dengan miliaran parameter yang dapat memakan waktu ribuan jam GPU untuk dilatih. Mengoptimalkan model seperti itu pada infrastruktur pelatihan membutuhkan pengetahuan luas tentang DL dan rekayasa sistem; ini menantang bahkan untuk kasus penggunaan yang sempit. Meskipun ada implementasi open-source dari kompiler yang mengoptimalkan proses pelatihan DL, mereka dapat kekurangan fleksibilitas untuk mengintegrasikan kerangka kerja DL dengan beberapa perangkat keras seperti instance GPU.

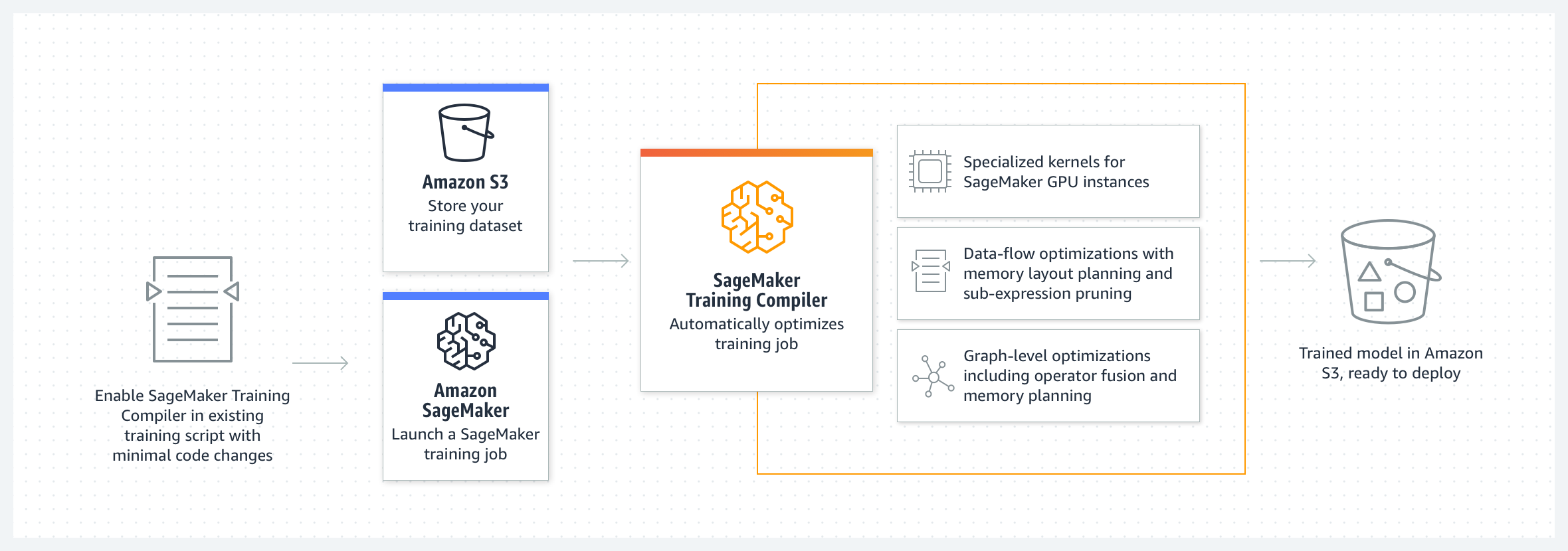

SageMaker Training Compiler adalah kemampuan SageMaker AI yang membuat hard-to-implement pengoptimalan ini untuk mengurangi waktu pelatihan pada instans GPU. Kompiler mengoptimalkan model DL untuk mempercepat pelatihan dengan lebih efisien menggunakan instance GPU pembelajaran mesin SageMaker AI (ML). SageMaker Training Compiler tersedia tanpa biaya tambahan dalam SageMaker AI dan dapat membantu mengurangi total waktu yang dapat ditagih karena mempercepat pelatihan.

SageMaker Training Compiler diintegrasikan ke dalam AWS Deep Learning Containers (DLCs). Dengan menggunakan SageMaker Training Compiler—enabled AWS DLCs, Anda dapat mengkompilasi dan mengoptimalkan pekerjaan pelatihan pada instans GPU dengan sedikit perubahan pada kode Anda. Bawa model pembelajaran mendalam Anda ke SageMaker AI dan aktifkan SageMaker Training Compiler untuk mempercepat kecepatan pekerjaan pelatihan Anda pada instans SageMaker AI ML untuk komputasi yang dipercepat.

Cara Kerjanya

SageMaker Training Compiler mengonversi model DL dari representasi bahasa tingkat tinggi menjadi instruksi yang dioptimalkan perangkat keras. Secara khusus, SageMaker Training Compiler menerapkan pengoptimalan tingkat grafik, pengoptimalan tingkat rendah data, dan pengoptimalan backend untuk menghasilkan model yang dioptimalkan yang secara efisien menggunakan sumber daya perangkat keras. Hasilnya, Anda dapat melatih model Anda lebih cepat daripada saat Anda melatihnya tanpa kompilasi.

Ini adalah proses dua langkah untuk mengaktifkan SageMaker Training Compiler untuk pekerjaan pelatihan Anda:

-

Bawa skrip DL Anda sendiri dan, jika perlu, beradaptasi untuk mengkompilasi dan melatih dengan SageMaker Training Compiler. Untuk mempelajari selengkapnya, lihat Bawa Model Pembelajaran Mendalam Anda Sendiri.

-

Buat objek estimator SageMaker AI dengan parameter konfigurasi kompiler menggunakan Python SageMaker SDK.

-

Aktifkan SageMaker Training Compiler dengan menambahkan

compiler_config=TrainingCompilerConfig()ke kelas estimator SageMaker AI. -

Sesuaikan hiperparameter (

batch_sizedanlearning_rate) untuk memaksimalkan manfaat yang disediakan oleh SageMaker Training Compiler.Kompilasi melalui SageMaker Training Compiler mengubah jejak memori model. Paling umum, ini bermanifestasi sebagai pengurangan pemanfaatan memori dan konsekuensi peningkatan ukuran batch terbesar yang dapat muat pada GPU. Dalam beberapa kasus, kompiler cerdas mempromosikan caching yang mengarah pada penurunan ukuran batch terbesar yang dapat muat pada GPU. Perhatikan bahwa jika Anda ingin mengubah ukuran batch, Anda harus menyesuaikan tingkat pembelajaran dengan tepat.

Untuk referensi untuk

batch_sizediuji untuk model populer, lihatModel yang Diuji.Saat Anda menyesuaikan ukuran batch, Anda juga harus menyesuaikannya

learning_ratedengan tepat. Untuk praktik terbaik untuk menyesuaikan tingkat pembelajaran bersama dengan perubahan ukuran batch, lihatSageMaker Praktik dan Pertimbangan Terbaik Kompiler Pelatihan. -

Dengan menjalankan metode

estimator.fit()kelas, SageMaker AI mengkompilasi model Anda dan memulai pekerjaan pelatihan.

Untuk petunjuk tentang cara meluncurkan pekerjaan pelatihan, lihatAktifkan Kompiler SageMaker Pelatihan.

-

SageMaker Training Compiler tidak mengubah model terlatih akhir, sekaligus memungkinkan Anda untuk mempercepat pekerjaan pelatihan dengan lebih efisien menggunakan memori GPU dan menyesuaikan ukuran batch yang lebih besar per iterasi. Model terlatih terakhir dari pekerjaan pelatihan yang dipercepat kompiler identik dengan model dari pekerjaan pelatihan biasa.

Tip

SageMaker Training Compiler hanya mengkompilasi model DL untuk pelatihan pada instans GPU yang didukung yang dikelola oleh AI. SageMaker Untuk mengkompilasi model Anda untuk inferensi dan menerapkannya untuk dijalankan di mana saja di cloud dan di tepi, gunakan SageMaker kompiler Neo.