Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Come funzionano le knowledge base di Amazon Bedrock

Le Knowledge Base di Amazon Bedrock ti aiutano a sfruttare Retrieval Augmented Generation (RAG), una tecnica popolare che prevede l'estrazione di informazioni da un archivio dati per aumentare le risposte generate da Large Language Models (). LLMs Quando configuri una knowledge base con la tua fonte di dati, l'applicazione può interrogare la knowledge base per restituire informazioni utili a rispondere alla domanda con citazioni dirette dalle fonti o con risposte naturali generate dai risultati della query.

Con Amazon Bedrock Knowledge Bases, puoi creare applicazioni arricchite dal contesto ricevuto dall'interrogazione di una knowledge base. Consente un time-to-market più rapido evitando il carico gravoso delle pipeline degli edifici e fornendoti una soluzione out-of-the-box RAG per ridurre i tempi di creazione della tua applicazione. L'aggiunta di una knowledge base aumenta anche l'efficacia dei costi, eliminando la necessità di addestrare continuamente il modello per poter sfruttare i dati privati.

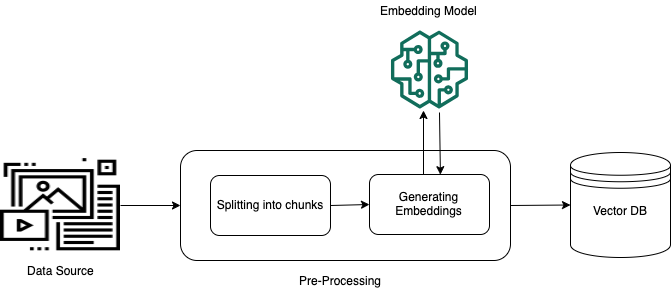

I seguenti diagrammi illustrano schematicamente come viene eseguita la RAG. La knowledge base semplifica la configurazione e l'implementazione della RAG automatizzando diverse fasi di questo processo.

Pre-elaborazione di dati non strutturati

Per consentire un recupero efficace dai dati privati non strutturati (dati che non esistono in un archivio di dati strutturato), una pratica comune consiste nel convertire i dati in testo e dividerli in parti gestibili. Le parti o i blocchi vengono quindi convertiti in incorporamenti e scritti in un indice vettoriale, mantenendo al contempo una mappatura con il documento originale. Questi incorporamenti vengono utilizzati per determinare la somiglianza semantica tra le query e il testo delle origini dati. L'immagine seguente illustra la pre-elaborazione dei dati per il database vettoriale.

Gli incorporamenti vettoriali sono una serie di numeri che rappresentano ogni blocco di testo. Un modello converte ogni blocco di testo in serie di numeri, note come vettori, in modo che i testi possano essere confrontati matematicamente. Questi vettori possono essere numeri a virgola mobile (float32) o numeri binari. La maggior parte dei modelli di incorporamento supportati da Amazon Bedrock utilizza vettori a virgola mobile per impostazione predefinita. Tuttavia, alcuni modelli supportano i vettori binari. Se si sceglie un modello di incorporamento binario, è necessario scegliere anche un modello e un archivio vettoriale che supporti i vettori binari.

I vettori binari, che utilizzano solo 1 bit per dimensione, non sono così costosi in termini di archiviazione come i vettori a virgola mobile (float32), che utilizzano 32 bit per dimensione. Tuttavia, i vettori binari non sono così precisi come i vettori a virgola mobile nella rappresentazione del testo.

L'esempio seguente mostra una parte di testo in tre rappresentazioni:

| Rappresentazione | Valore |

|---|---|

| Testo | «Amazon Bedrock utilizza modelli di base ad alte prestazioni delle principali aziende di intelligenza artificiale e di Amazon». |

| Vettore a virgola mobile | [0.041..., 0.056..., -0.018..., -0.012..., -0.020...,

...] |

| Vettore binario | [1,1,0,0,0, ...] |

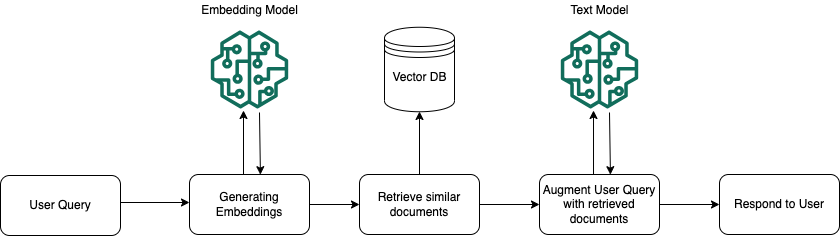

Esecuzione in fase di runtime

In fase di runtime, viene utilizzato un modello di incorporamento per convertire la query dell'utente in un vettore. L'indice vettoriale viene quindi interrogato per trovare blocchi semanticamente simili alla query dell'utente confrontando i vettori del documento con il vettore di query dell'utente. Nel passaggio finale, il prompt dell'utente viene aumentato con il contesto aggiuntivo proveniente dai blocchi recuperati dall'indice vettoriale. Il prompt insieme al contesto aggiuntivo viene quindi inviato al modello per generare una risposta per l'utente. L'immagine seguente mostra come la RAG opera in fase di runtime per migliorare le risposte alle query degli utenti.

Per ulteriori informazioni su come trasformare i dati in una knowledge base, su come interrogare la knowledge base dopo averla configurata e sulle personalizzazioni che è possibile applicare all'origine dati durante l'ingestione, consulta i seguenti argomenti: