翻訳は機械翻訳により提供されています。提供された翻訳内容と英語版の間で齟齬、不一致または矛盾がある場合、英語版が優先します。

SageMaker HyperPod レシピ

Amazon SageMaker HyperPod レシピを使用して、公開されている基盤モデルのトレーニングと微調整を開始します。使用可能なレシピを表示するには、「 recipesSageMaker HyperPod

レシピは、以下のモデルファミリー用に事前設定されたトレーニング設定です。

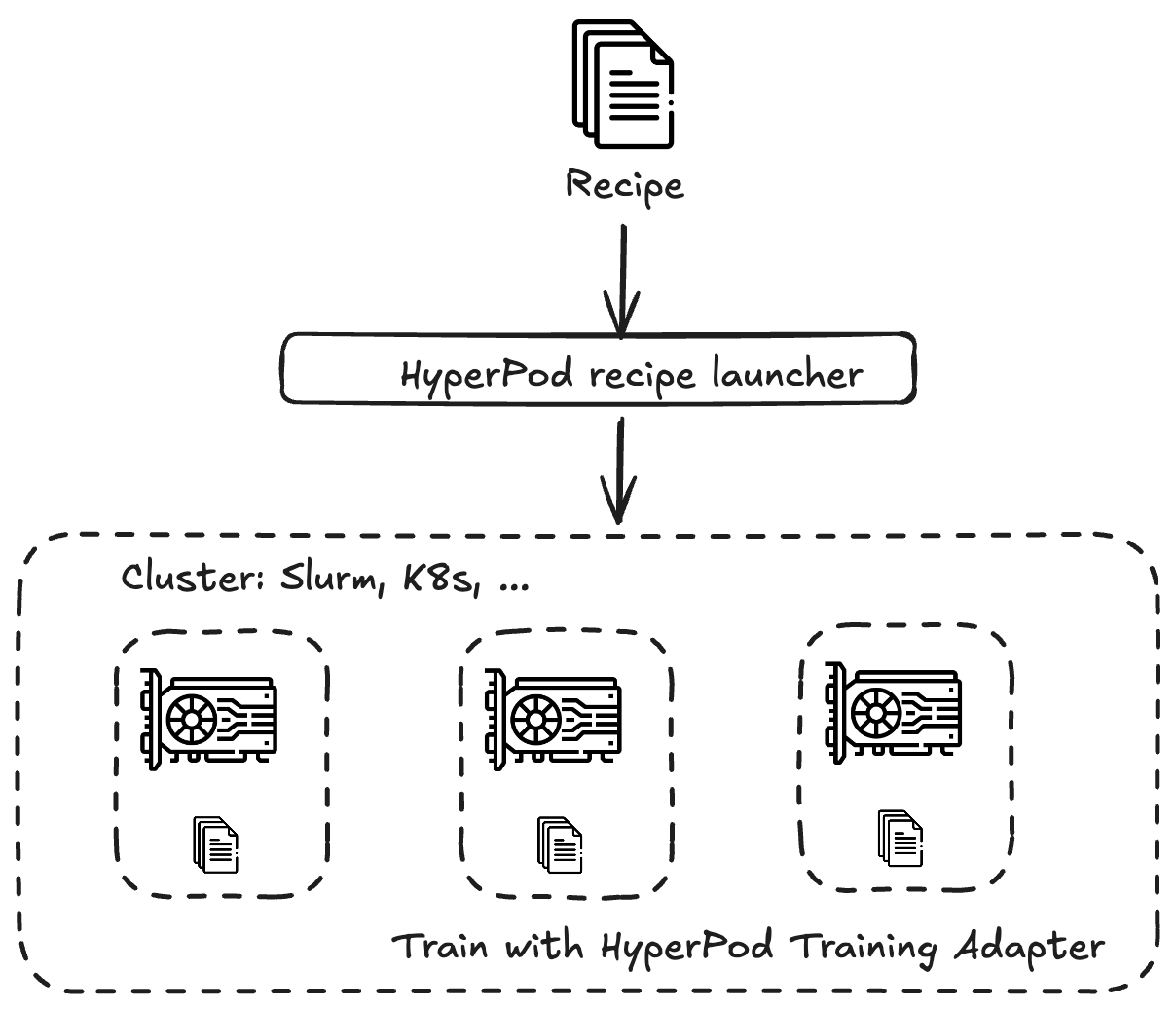

レシピは、 内 SageMaker HyperPod または SageMaker トレーニングジョブとして実行できます。 SageMaker HyperPod トレーニングワークフローの実行 end-to-endに役立つフレームワークとして Amazon トレーニングアダプターを使用します。トレーニングアダプターは、NVIDIA NeMoフレームワーク

独自のカスタムレシピを定義して、独自のモデルをトレーニングすることもできます。

次の表は、 が現在サポートしている SageMaker HyperPod事前定義されたレシピと起動スクリプトの概要を示しています。

| モデル | サイズ | [Sequence] (シーケンス) | ノード | インスタンス | アクセラレーター | レシピ | スクリプト |

|---|---|---|---|---|---|---|---|

| Llama3.2 | 11b | 8192 | 4 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.2 | 90 b | 8192 | 32 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.2 | 1b | 8192 | 1 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.2 | 3b | 8192 | 1 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | 70 b | 16384 | 32 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | 70 b | 16384 | 64 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | 70 b | 8192 | 32 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | 70 b | 8192 | 64 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3 | 70 b | 8192 | 16 | ml.trn1.32xlarge | AWS TRN | link |

link |

| Llama3.1 | 8b | 16384 | 16 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | 8b | 16384 | 32 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | 8b | 8192 | 16 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | 8b | 8192 | 32 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3 | 8b | 8192 | 4 | ml.trn1.32xlarge | AWS TRN | link |

link |

| Llama3.1 | 8b | 8192 | 16 | ml.p5.48xlarge | Nvidia H100 | link |

該当なし |

| Mistral | 7b | 16384 | 16 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Mistral | 7b | 16384 | 32 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Mistral | 7b | 8192 | 16 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Mistral | 7b | 8192 | 32 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Mixtral | 22b | 16384 | 32 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Mixtral | 22b | 16384 | 64 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Mixtral | 22b | 8192 | 32 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Mixtral | 22b | 8192 | 64 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Mixtral | 7b | 16384 | 16 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Mixtral | 7b | 16384 | 32 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Mixtral | 7b | 8192 | 16 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Mixtral | 7b | 8192 | 32 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| モデル | [メソッド] | サイズ | シーケンスの長さ | ノード | インスタンス | アクセラレーター | レシピ | スクリプト |

|---|---|---|---|---|---|---|---|---|

| Llama3.1 | QLoRA | 405b | 131072 | 2 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | LoRA | 405b | 16384 | 6 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | QLoRA | 405b | 16384 | 2 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | LoRA | 405b | 16384 | 6 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | QLoRA | 405b | 8192 | 2 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | SFT | 70 b | 16384 | 16 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | LoRA | 70 b | 16384 | 2 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | SFT | 70 b | 8192 | 10 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | LoRA | 70 b | 8192 | 1 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | SFT | 8b | 16384 | 1 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | LoRA | 8b | 16384 | 1 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | SFT | 8b | 8192 | 1 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | LoRA | 8b | 8192 | 1 | ml.p5.48xlarge | Nvidia H100 | link |

link |

| Llama3.1 | SFT | 70 b | 8192 | 32 | ml.p4d.24xlarge | Nvidia A100 | link |

link |

| Llama3.1 | LoRA | 70 b | 8192 | 20 | ml.p4d.24xlarge | Nvidia A100 | link |

link |

| Llama3.1 | SFT | 8b | 8192 | 4 | ml.p4d.24xlarge | Nvidia A100 | link |

link |

| Llama3.1 | LoRA | 8b | 8192 | 1 | ml.p4d.24xlarge | Nvidia A100 | link |

link |

| Llama3 | SFT | 8b | 8192 | 1 | ml.trn1.32xlarge | AWS TRN | link |

link |

チュートリアルを開始するには、「」を参照してくださいチュートリアル。