기계 번역으로 제공되는 번역입니다. 제공된 번역과 원본 영어의 내용이 상충하는 경우에는 영어 버전이 우선합니다.

인스턴트 예상 인스턴스 가져오기

또한 Inference Recommender는 SageMaker AI 모델 세부 정보 페이지에서 모델에 적합할 수 있는 예상 인스턴스 또는 인스턴스 유형 목록을 제공할 수 있습니다. Inference Recommender는 모델을 대상으로 자동 예비 벤치마킹을 수행하여 상위 5개 예상 인스턴스를 제공합니다. 이는 예비 권장 사항이므로 더 정확한 결과를 얻으려면 추가 인스턴스 권장 작업을 실행하는 것이 좋습니다.

DescribeModel API, SageMaker Python SDK 또는 SageMaker AI 콘솔을 사용하여 프로그래밍 방식으로 모델의 예상 인스턴스 목록을 볼 수 있습니다.

참고

이 기능을 사용할 수 있게 되기 전에는 SageMaker AI에서 생성한 모델의 예상 인스턴스를 얻을 수 없습니다.

콘솔을 통해 모델의 예상 인스턴스를 보는 방법은 다음과 같습니다.

-

https://console.aws.amazon.com/sagemaker/

에서 SageMaker 콘솔로 이동합니다. -

왼쪽 탐색 창에서 추론(Inference)을 선택한 다음 모델(Models)을 선택합니다.

-

모델 목록에서 모델을 선택합니다.

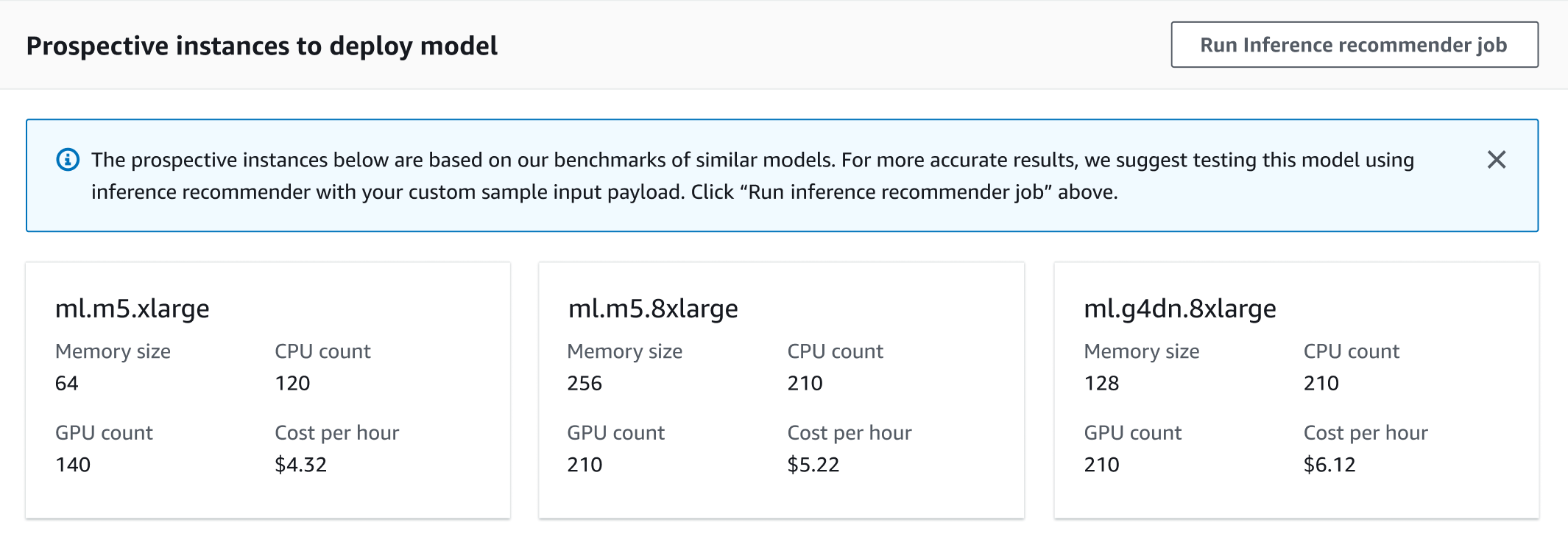

모델 세부정보 페이지에서 모델을 배포할 예상 인스턴스 섹션(Prospective instances to deploy model)으로 이동합니다. 아래 스크린샷에서 이 섹션을 볼 수 있습니다.

이 섹션에서는 메모리 크기, CPU 및 GPU 수, 시간당 비용 등 각 인스턴스 유형에 대한 추가 정보와 함께 모델 배포를 위한 비용, 처리량, 지연 시간에 맞게 최적화된 예상 인스턴스를 볼 수 있습니다.

샘플 페이로드를 벤치마크하고 모델에 대한 전체 추론 권장 작업을 실행하기로 결정한 경우, 이 페이지에서 기본 추론 권장 작업을 시작할 수 있습니다. 콘솔을 통해 기본 작업을 시작하는 방법은 다음과 같습니다.

-

모델 세부정보 페이지에 있는 모델을 배포할 예상 인스턴스 섹션(Prospective instances to deploy model section)에서 Inference Recommender 작업 실행(Run Inference recommender job)을 선택합니다.

-

표시되는 대화 상자에서 벤치마킹 페이로드용 S3 버킷(S3 bucket for benchmarking payload)에 모델의 샘플 페이로드를 저장한 Amazon S3의 위치를 입력합니다.

-

페이로드 콘텐츠 유형(Payload content type)에 페이로드 데이터의 MIME 유형을 입력합니다.

-

(선택 사항) SageMaker Neo를 사용한 모델 컴파일(Model compilation using SageMaker Neo) 섹션에서 데이터 입력 구성(Data input configuration)에 사전 형식의 데이터 형상을 입력합니다.

-

작업 실행(Run job)을 선택합니다.

Inference Recommender가 작업을 시작하면 SageMaker AI 콘솔의 추론 추천자 목록 페이지에서 작업과 그 결과를 볼 수 있습니다.

고급 작업을 실행하고 사용자 지정 부하 테스트를 수행하거나, 작업에 대한 추가 설정 및 파라미터를 구성하는 방법은 사용자 지정 부하 테스트 실행하기에서 확인하세요.