As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Configurar prompts avançados

Você pode configurar prompts avançados no AWS Management Console ou por meio doAPI.

- Console

-

No console, é possível configurar prompts avançados após a criação do agente. Configure-os ao editar o agente.

Como visualizar ou editar prompts avançados para o agente

-

Faça login no AWS Management Console usando uma IAMfunção com as permissões do Amazon Bedrock e abra o console do Amazon Bedrock em. https://console.aws.amazon.com/bedrock/

-

No painel de navegação à esquerda, escolha Agentes. Escolha um agente na seção Agentes.

-

Na página de detalhes do agente, na seção Rascunho de trabalho, selecione Rascunho de trabalho.

-

Na página Rascunho de trabalho, na seção Estratégia de orquestração, escolha Editar.

-

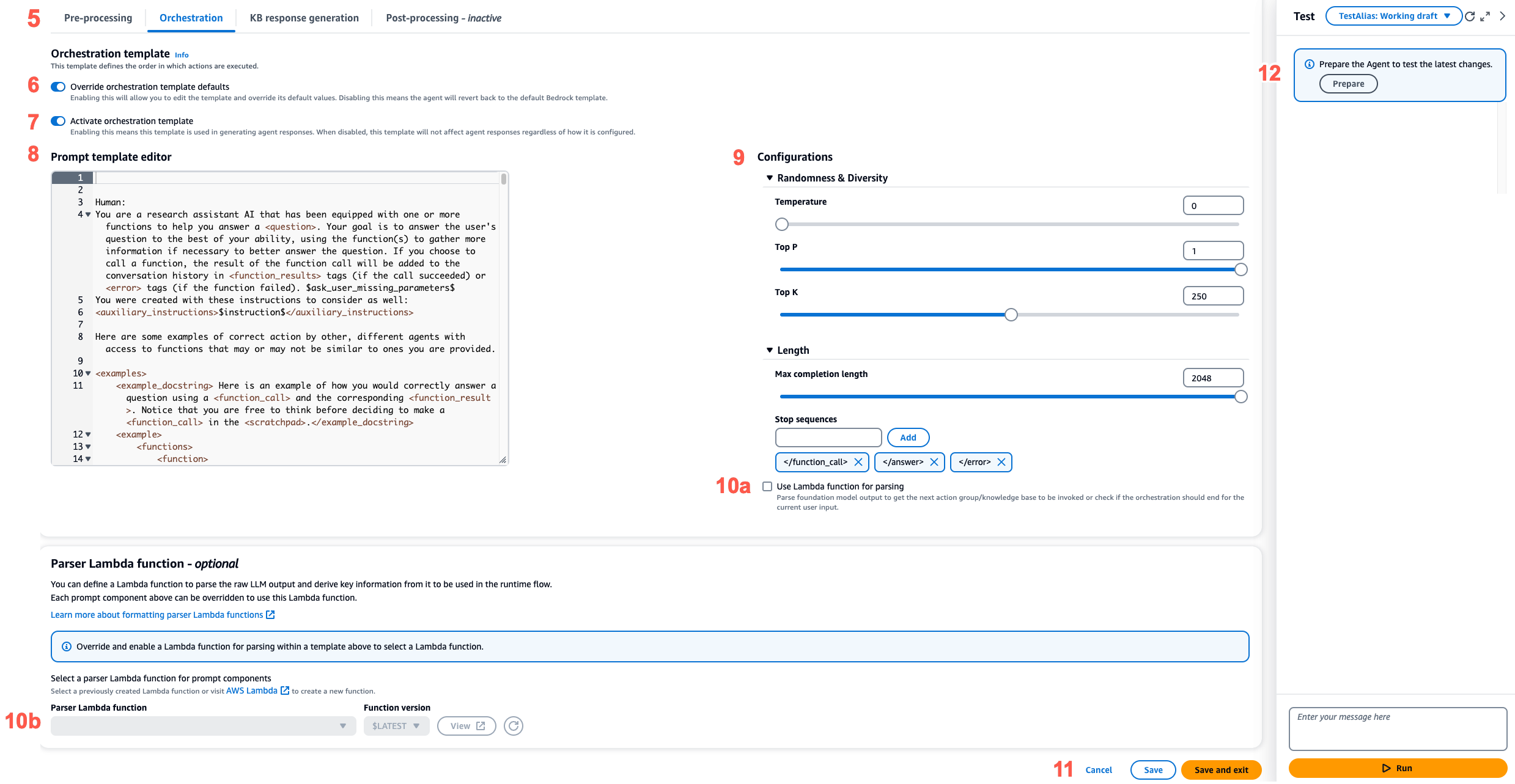

Na página Estratégia de orquestração, na seção Detalhes da estratégia de orquestração, verifique se a Orquestração padrão está selecionada e escolha a guia correspondente à etapa da sequência do agente que você deseja editar.

-

Para habilitar a edição do modelo, ative Substituir padrões do modelo. Na caixa de diálogo Substituir padrões do modelo, escolha Confirmar.

Atenção

Se você desativar a opção Substituir padrões do modelo ou alterar o modelo, o modelo padrão do Amazon Bedrock será usado e o seu modelo será excluído imediatamente. Para confirmar, insira

confirmna caixa de texto a fim de confirmar a mensagem que é exibida. -

Para permitir que o agente use o modelo ao gerar respostas, ative Ativar modelo. Se essa configuração estiver desativada, o agente não a usará.

-

Para modificar o exemplo do modelo de prompt, use o Editor de modelos de prompt.

-

Em Configurações, é possível modificar os parâmetros de inferência do prompt. Para obter definições dos parâmetros e mais informações sobre os parâmetros para modelos diferentes, consulte Parâmetros de solicitação de inferência e campos de resposta para modelos de base.

-

(Opcional) Para usar uma função do Lambda que você definiu para analisar a saída bruta do modelo de base, execute as ações a seguir.

nota

Uma função do Lambda é usada para todos os modelos de prompt.

-

Na seção Configurações, selecione Usar função do Lambda para análise. Se você limpar essa configuração, o agente usará o analisador padrão para o prompt.

-

Em Função do Lambda analisadora, selecione uma função do Lambda no menu suspenso.

nota

Você deve anexar permissões para que o agente possa acessar a função do Lambda. Para obter mais informações, consulte Política baseada em recurso para permitir que o Amazon Bedrock invoque uma função do Lambda do grupo de ação.

-

-

Para salvar as configurações, escolha uma das seguintes opções:

-

Para permanecer na mesma janela e poder atualizar dinamicamente as configurações do prompt enquanto testa o agente atualizado, escolha Salvar.

-

Para salvar as configurações e retornar à página Rascunho de trabalho, escolha Salvar e sair.

-

-

Para testar as configurações atualizadas, escolha Preparar na janela Teste.

-

- API

-

Para configurar prompts avançados usando as API operações, você envia uma UpdateAgentchamada e modifica o

promptOverrideConfigurationobjeto a seguir."promptOverrideConfiguration": { "overrideLambda": "string", "promptConfigurations": [ { "basePromptTemplate": "string", "inferenceConfiguration": { "maximumLength": int, "stopSequences": [ "string" ], "temperature": float, "topK": float, "topP": float }, "parserMode": "DEFAULT | OVERRIDDEN", "promptCreationMode": "DEFAULT | OVERRIDDEN", "promptState": "ENABLED | DISABLED", "promptType": "PRE_PROCESSING | ORCHESTRATION | KNOWLEDGE_BASE_RESPONSE_GENERATION | POST_PROCESSING | MEMORY_SUMMARIZATION" } ], promptCachingState: { cachingState: "ENABLED | DISABLED" } }-

Na lista

promptConfigurations, inclua um objetopromptConfigurationpara cada modelo de prompt que deseja editar. -

Especifique o prompt a ser modificado no campo

promptType. -

Modifique o modelo de prompt por meio das seguintes etapas:

-

Especifique os campos

basePromptTemplatecom o modelo de prompt. -

Inclua parâmetros de inferência nos objetos

inferenceConfiguration. Para obter mais informações sobre as configurações de inferência, consulte Parâmetros de solicitação de inferência e campos de resposta para modelos de base.

-

-

Para habilitar o modelo de prompt, defina

promptCreationModecomoOVERRIDDEN. -

Para permitir ou impedir que o agente execute a etapa no campo

promptType, modifique o valor depromptState. Essa configuração pode ser útil para solucionar o comportamento do agente.-

Se você definir

promptStatecomoDISABLEDpara as etapasPRE_PROCESSING,KNOWLEDGE_BASE_RESPONSE_GENERATIONouPOST_PROCESSING, o agente ignorará essa etapa. -

Se você definir

promptStatecomoDISABLEDpara a etapaORCHESTRATION, o agente enviará somente a entrada do usuário ao modelo de base em orquestração. Além disso, o agente retorna a resposta no estado em que se encontra, sem orquestrar chamadas entre API operações e bases de conhecimento. -

Por padrão, a etapa

POST_PROCESSINGestáDISABLED. Por padrão, as etapasPRE_PROCESSING,ORCHESTRATIONeKNOWLEDGE_BASE_RESPONSE_GENERATIONestãoENABLED. -

Por padrão, a

MEMORY_SUMMARIZATIONetapa éENABLEDse a memória estiver ativada e aMEMORY_SUMMARIZATIONetapa éDISABLEDse a memória estiver desativada.

-

-

Para usar uma função do Lambda que definiu para analisar a saída bruta do modelo de base, execute as etapas a seguir.

-

Para cada modelo de prompt para o qual deseja habilitar a função do Lambda, defina

parserModecomoOVERRIDDEN. -

Especifique o Amazon Resource Name (ARN) da função Lambda no

overrideLambdacampo do objeto.promptOverrideConfiguration

-

-

(Opcional) Para ativar o cache imediato para reduzir a latência quando você tem entradas com contexto longo e repetido, defina o

cachingStatecampo como.ENABLEDPara obter mais informações sobre o cache de prompts, consulteCache imediato para inferência mais rápida do modelo.nota

No momento, o cache de prompts do Amazon Bedrock está disponível apenas para um número selecionado de clientes. Para saber mais sobre como participar da prévia, consulte Cache de prompts do Amazon Bedrock

.

-