本文属于机器翻译版本。若本译文内容与英语原文存在差异,则一律以英文原文为准。

在 Amazon A SageMaker I 中使用强化学习

强化学习 (RL) 结合了计算机科学、神经科学和心理学等领域,以确定如何将情况与行动相映射,从而最大化数字奖励信号。RL 中的奖励信号概念源于神经科学研究,研究了人类大脑如何决定哪些行动可最大限度提高奖励以及最大限度减少惩罚。在大多数情况下,人类不会获得明确指示要采取哪些行动,而是必须了解哪些行动可以产生最直接的回报,以及这些行动如何影响未来的局势和后果。

RL 问题是使用源自动力学系统理论的马尔可夫决策过程 (MDPs) 来形式化的。 MDPs旨在捕捉学习代理在尝试实现某个最终目标时在一段时间内遇到的实际问题的高级细节。学习代理应当能够确定其环境的当前状态,并确定影响学习代理当前状态的可能操作。此外,学习代理的目标应该与环境状况密切相关。以这种方式制定问题解决方案被称为强化学习方法。

强化学习、有监督学习与无监督学习范式之间有什么区别?

机器学习可以分为三种不同的学习范式:有监督、无监督和强化。

在有监督学习中,外部监督方提供一个已标记样本的训练集。每个样本都包含有关某种情况的信息,属于某个类别,并具有标识其所述类别的标签。有监督学习的目标是泛化,以便正确预测训练数据中不存在的情况。

与之相反,RL 处理的是交互式问题,因此不可能收集到代理可能遇到的、具有正确标签的所有可能情况样本。如果代理能够准确地从自己的经验中学习并进行相应调整,这种学习方式最有前景。

在无监督学习中,代理通过发现未标注数据中的结构来学习。尽管 RL 代理可能会根据其经验,从发现结构中受益,但 RL 的唯一目的是最大化奖励信号。

主题

为什么强化学习很重要?

RL 非常适合解决大型复杂问题,例如供应链管理、HVAC系统、工业机器人、游戏人工智能、对话系统和自动驾驶汽车。由于 RL 模型的学习方法是连续处理代理采取的每个操作所获得奖励和惩罚,因此我们可以训练系统在不确定条件下和动态环境中做出决策。

马尔可夫决策过程 () MDP

RL 基于称为马尔可夫决策过程 () MDPs 的模型。MDP由一系列时间步组成。每个时间步长由以下内容组成:

- 环境

-

定义 RL 模型在其中运行的空间。这可以是真实的环境或模拟器。例如,如果您在实际道路上训练真实的自动驾驶车辆,则这就是一个真实的环境。如果您训练一个模拟自动驾驶车辆在道路上行驶的计算机程序,则这就是一个模拟器。

- 状态

-

指定所有环境相关信息以及与未来相关的过往步骤的信息。例如,在一个机器人能够以任意时间步长向任意方向移动的 RL 模型中,机器人在当前时间步长所在的位置是状态,因为如果我们知道了机器人的位置,就不必去了解机器人经过了多少步才到达那里。

- 操作

-

代理的行为。例如,机器人前进一步。

- 奖励

-

表示代理采取的上一步操作所导致的状态值的数值。例如,如果目标是让机器人找到宝藏,那么可以将找到宝藏的奖励设为 5,而没有找到宝藏的奖励设为 0。RL 模型试图寻找旨在优化长期累积奖励的策略。这种计划被称为策略。

- 观察

-

代理在每一步可获得的环境状态相关信息。这可能是整个状态,也可能只是状态的一部分。例如,国际象棋模型中的代理能够在任何步骤观察整个棋盘的状态,但迷宫中的机器人可能只能观察迷宫中它当前占据的一小部分。

通常情况下,RL 中的训练包含许多回合。剧集包含MDP从初始状态到环境达到终端状态的所有时间步长。

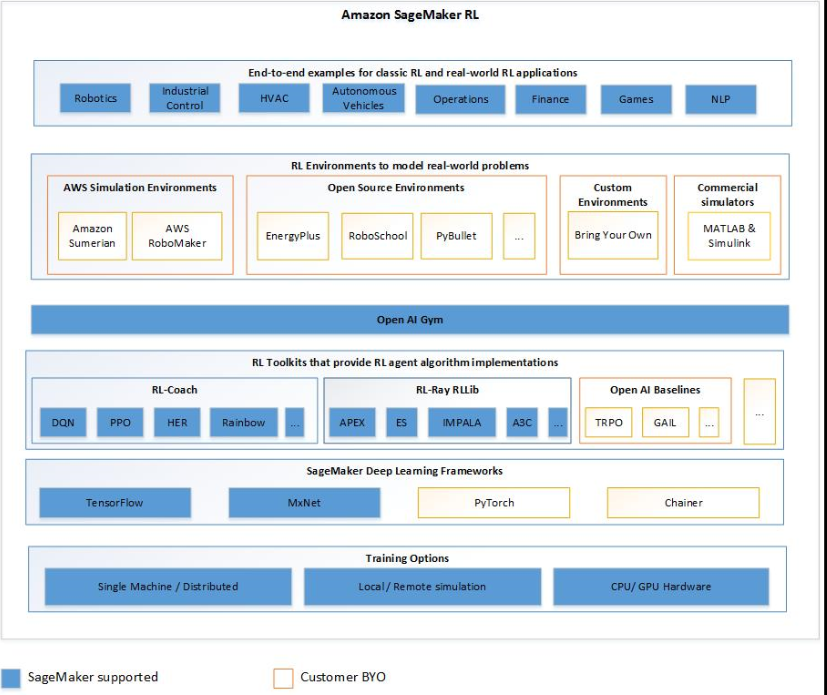

Amazon A SageMaker I RL 的主要特点

要在 SageMaker AI RL 中训练 RL 模型,请使用以下组件:

-

深度学习 (DL) 框架。目前, SageMaker 人工智能支持 RL in TensorFlow 和 Ap MXNet ache。

-

RL 工具包。RL 工具包用于管理代理与环境之间的交互,并提供众多一流的 RL 算法以供选择。 SageMaker AI 支持英特尔 Coach 和 Ray RLlib 工具包。有关 Intel Coach 的信息,请参阅 https://nervanasystems.github.io/coach/

。有关 Ray 的信息RLlib,请参见https://ray.readthedocs.io/en/latest/rllib.html 。 -

RL 环境。您可以使用自定义环境、开源环境或商用环境。有关信息,请参阅亚马逊 A SageMaker I 中的 RL 环境。

下图显示了 SageMaker AI RL 中支持的 RL 组件。

强化学习示例笔记本

有关完整的代码示例,请参阅 SageMaker AI 示例存储库中的强化学习示例笔记本