本文為英文版的機器翻譯版本,如內容有任何歧義或不一致之處,概以英文版為準。

使用主控台部署編譯的模型

如果模型是使用 AWS SDK for Python (Boto3)、 或 Amazon SageMaker 主控台編譯的 AWS CLI,您必須滿足先決條件區段。請依照下列步驟,使用 SageMaker主控台 https://console.aws.amazon.com/ SageMaker

主題

部署模型

符合先決條件之後,請使用下列步驟部署使用 Neo 編譯的模型:

-

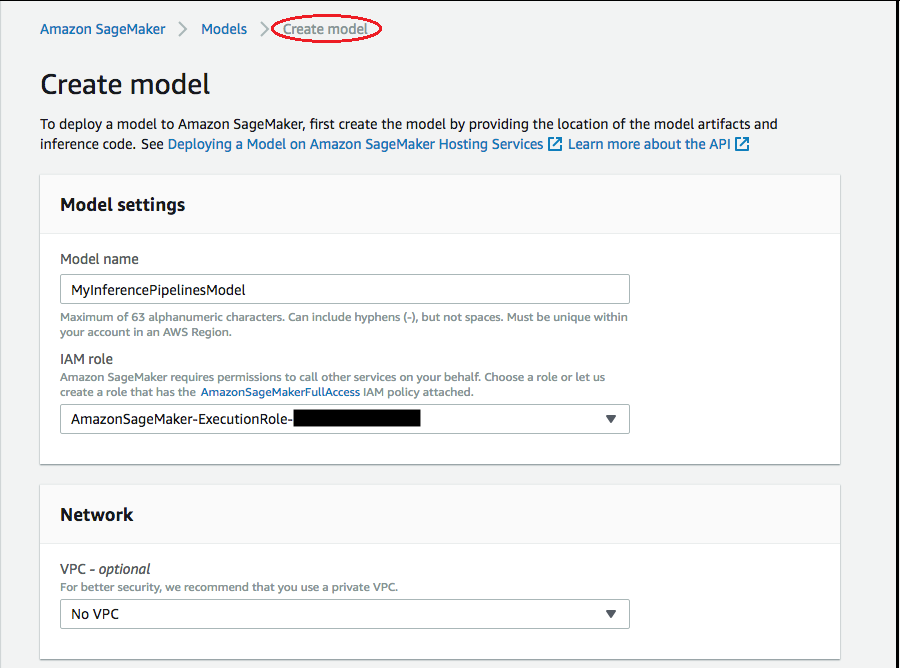

選擇模型,然後從推論 群組中選擇 建立模型。在建立模型頁面上,視需要完成模型名稱 、IAM角色 和VPC欄位 (選用)。

-

若要針對部署模型用的容器新增相關資訊,請選擇新增容器,然後選擇下一步。填寫 Container input options (容器輸入選項)、Location of inference code image (推論程式碼映像的位置) 和 Location of model artifacts (模型成品的位置),以及選用的 Container host name (容器主機名稱) 和 Environmental variables (環境變數) 欄位。

-

若要部署 Neo 編譯模型,請選擇下列項目:

-

容器輸入選項:選擇提供模型成品和推論影像。

-

推論程式碼映像的位置 :根據 AWS 應用程式的區域和類型,URI從 Neo Inference Container Images 中選擇推論映像。

-

模型成品的位置 :輸入 Neo 編譯產生的編譯模型成品URI的 Amazon S3 儲存貯體API。

-

環境變數:

-

將此欄位留白SageMakerXGBoost。

-

如果您使用 訓練模型 SageMaker,請將環境變數指定

SAGEMAKER_SUBMIT_DIRECTORY為包含訓練指令碼URI的 Amazon S3 儲存貯體。 -

如果您未使用 訓練模型 SageMaker,請指定下列環境變數:

金錀 MXNet 和 的值 PyTorch 值 TensorFlow SAGEMAKER_PROGRAM inference.py inference.py SAGEMAKER_SUBMIT_DIRECTORY /opt/ml/model/code /opt/ml/model/code SAGEMAKER_CONTAINER_LOG_LEVEL 20 20 SAGEMAKER_REGION <your region> <your region> MMS_DEFAULT_RESPONSE_TIMEOUT 500 請為 TF 將此欄位留白

-

-

-

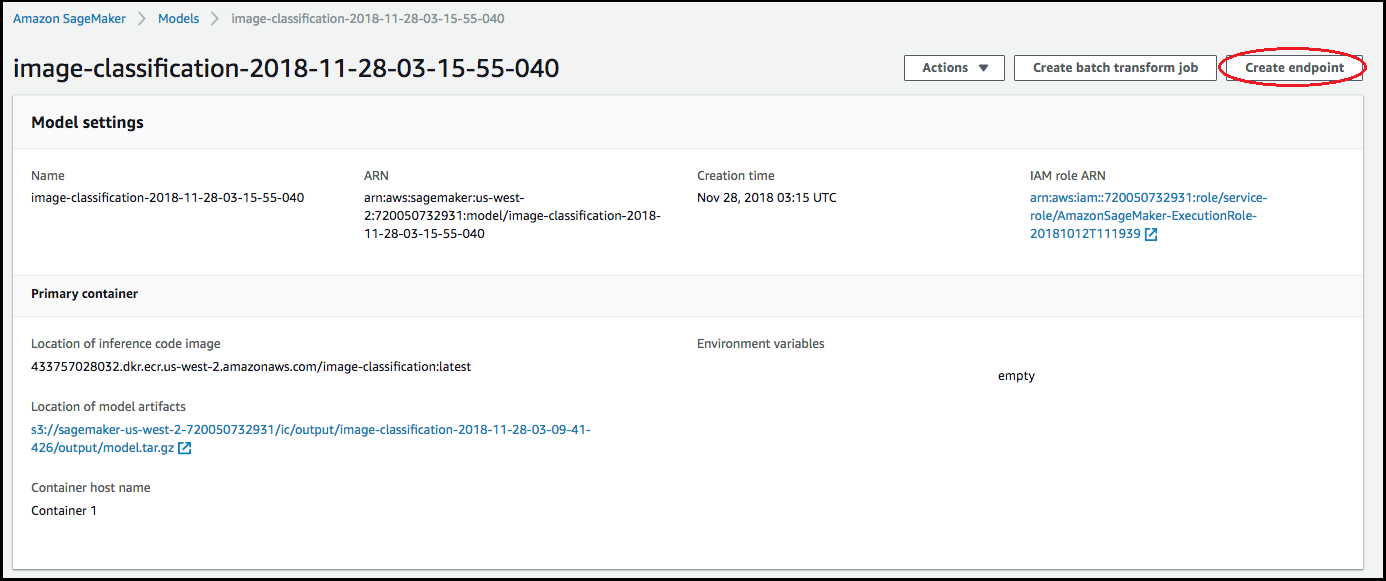

確認容器的資訊正確,然後選擇 Create model (建立模型)。在建立模型登陸頁面上,選擇建立端點。

-

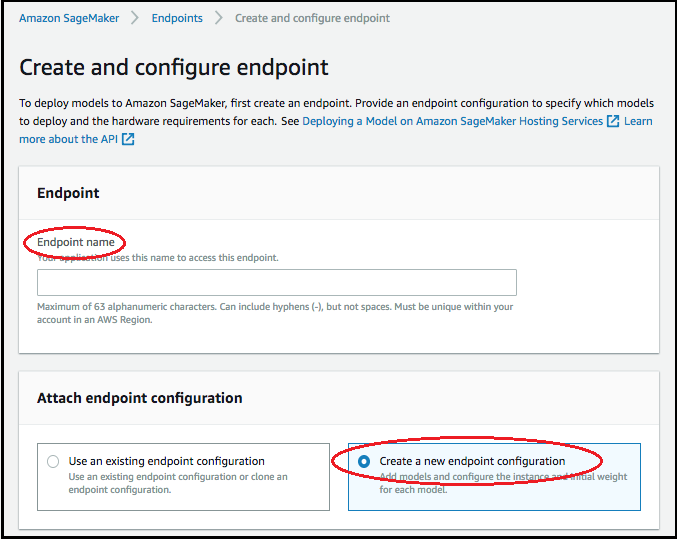

在 Create and configure endpoint (建立與設定端點) 圖表中,指定 Endpoint name (端點名稱)。針對附加端點組態,選擇建立新端點組態。

-

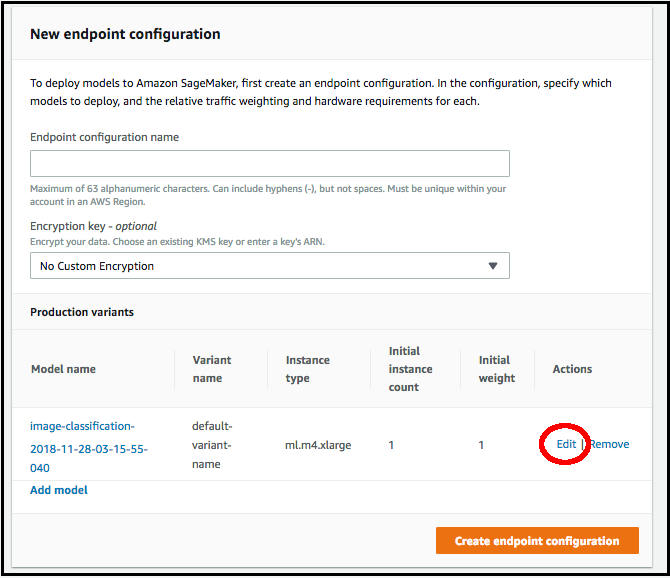

在 New endpoint configuration (新端點組態) 頁面中,指定 Endpoint configuration name (端點組態名稱)。

-

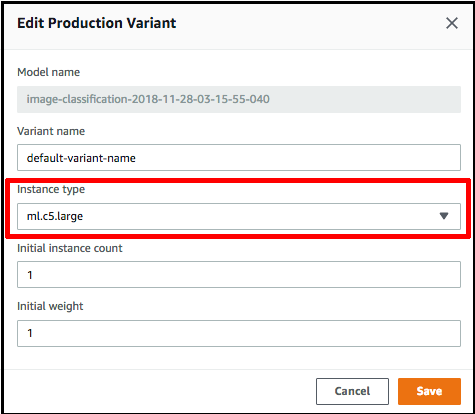

選擇模型名稱旁邊的編輯,然後在編輯生產變體頁面上指定正確的執行個體類型。Instance type (執行個體類型) 值一定要符合編譯任務中指定的值。

-

選擇 Save (儲存)。

-

在新端點組態頁面上,選擇建立端點組態,然後選擇建立端點。