Amazon Forecast ist für Neukunden nicht mehr verfügbar. Bestehende Kunden von Amazon Forecast können den Service weiterhin wie gewohnt nutzen. Erfahren Sie mehr“

Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Amazon Forecast erstellt Genauigkeitsmetriken zur Bewertung von Prädiktoren und hilft Ihnen bei der Auswahl, welche für die Erstellung von Prognosen verwendet werden sollen. Forecast bewertet Prädiktoren anhand der Metriken Root Mean Square Error (RMSE), Weighted Quantile Loss (wQL), Mean Absolute Percentage Error (MAPE), Mean Absolute Scaled Error (MASE) und Weighted Absolute Percentage Error (WAPE).

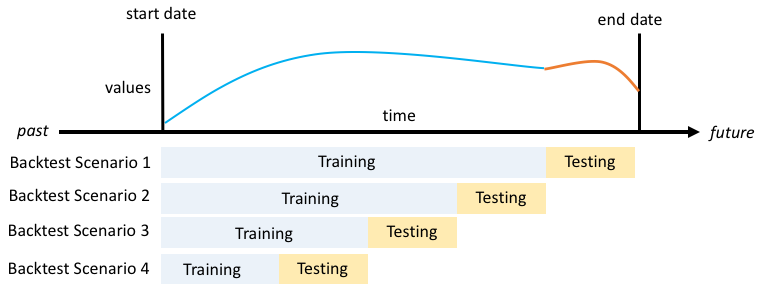

Amazon Forecast verwendet Backtesting, um Parameter zu optimieren und Genauigkeitsmetriken zu erstellen. Beim Backtesting teilt Forecast Ihre Zeitreihendaten automatisch in zwei Sätze auf: einen Trainingssatz und einen Testsatz. Das Trainingsset wird verwendet, um ein Modell zu trainieren und Prognosen für Datenpunkte innerhalb des Testsatzes zu generieren. Forecast bewertet die Genauigkeit des Modells, indem die prognostizierten Werte mit den beobachteten Werten im Testsatz verglichen werden.

Mit Forecast können Sie Prädiktoren anhand verschiedener Prognosetypen auswerten, bei denen es sich um eine Reihe von Quantilprognosen und die Mittelwertprognose handeln kann. Bei der Mittelwertprognose handelt es sich um eine Punktschätzung, wohingegen Quantilprognosen in der Regel eine Reihe möglicher Ergebnisse liefern.

Python-Notizbücher

Eine step-by-step Anleitung zur Auswertung von Prädiktormetriken finden Sie unter Berechnung von Metriken mithilfe von Backtests auf Elementebene

Themen

Interpretation von Genauigkeitsmetriken

Amazon Forecast bietet Metriken für Root Mean Square Error (RMSE), Weighted Quantile Loss (WqL), Average Weighted Quantile Loss (Average wQL), Mean Absolute Scaled Error (MASE), Mean Absolute Percentage Error (MAPE) und Weighted Absolute Percentage Error (WAPE) zur Bewertung Ihrer Prädiktoren. Zusammen mit den Metriken für den Gesamtprädiktor berechnet Forecast Metriken für jedes Backtest-Fenster.

Sie können Genauigkeitsmetriken für Ihre Prädiktoren mit dem Amazon Forecast Software Development Kit (SDK) und der Amazon Forecast-Konsole anzeigen.

Geben Sie mithilfe der GetAccuracyMetricsOperation an, ob Sie PredictorArn die RMSE-, MASE-, MAPE-, WAPE-, Average wQL- und wQL-Metriken für jeden Backtest anzeigen möchten.

{

"PredictorArn": "arn:aws:forecast:region:acct-id:predictor/example-id"

}

Anmerkung

Bei durchschnittlichen WQL-, wQL-, RMSE-, MASE-, MASE-, MAPE- und WAPE-Metriken weist ein niedrigerer Wert auf ein besseres Modell hin.

Themen

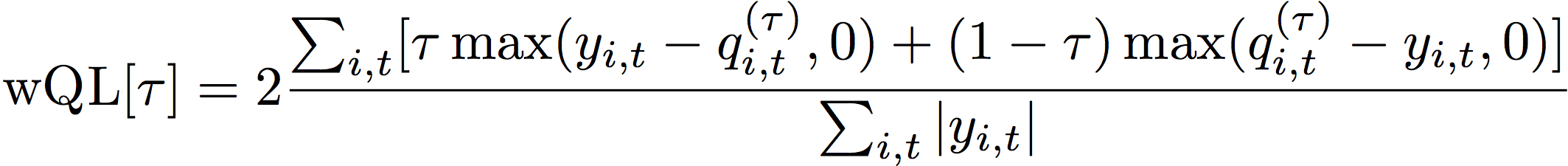

Gewichteter Quantilverlust (wQL)

Die Metrik Weighted Quantile Loss (wQL) misst die Genauigkeit eines Modells bei einem bestimmten Quantil. Sie ist besonders nützlich, wenn unterschiedliche Kosten für Unterprognosen und Überprognosen anfallen. Indem Sie die Gewichtung (τ) der wQL-Funktion festlegen, können Sie automatisch unterschiedliche Strafen für zu niedrige und zu hohe Prognosen einbeziehen.

Die Verlustfunktion wird wie folgt berechnet.

- Wobei gilt:

-

τ - ein Quantil in der Menge {0,01, 0,02,..., 0,99}

q i,t (τ) — das α-Quantil, das das Modell vorhersagt.

y i,t - der beobachtete Wert am Punkt (i, t)

Die Quantile (τ) für wQL können zwischen 0,01 (P1) und 0,99 (P99) liegen. Die wQL-Metrik kann für die durchschnittliche Prognose nicht berechnet werden.

Standardmäßig berechnet Forecast wQL bei 0.1 (P10), (P50) und 0.5 0.9 (P90).

-

P10 (0.1) — Es wird erwartet, dass der wahre Wert in 10% der Fälle unter dem vorhergesagten Wert liegt.

-

P50 (0.5) — Es wird erwartet, dass der wahre Wert in 50% der Fälle unter dem vorhergesagten Wert liegt. Dies wird auch als Medianprognose bezeichnet.

-

P90 (0.9) — Es wird erwartet, dass der wahre Wert in 90% der Fälle unter dem vorhergesagten Wert liegt.

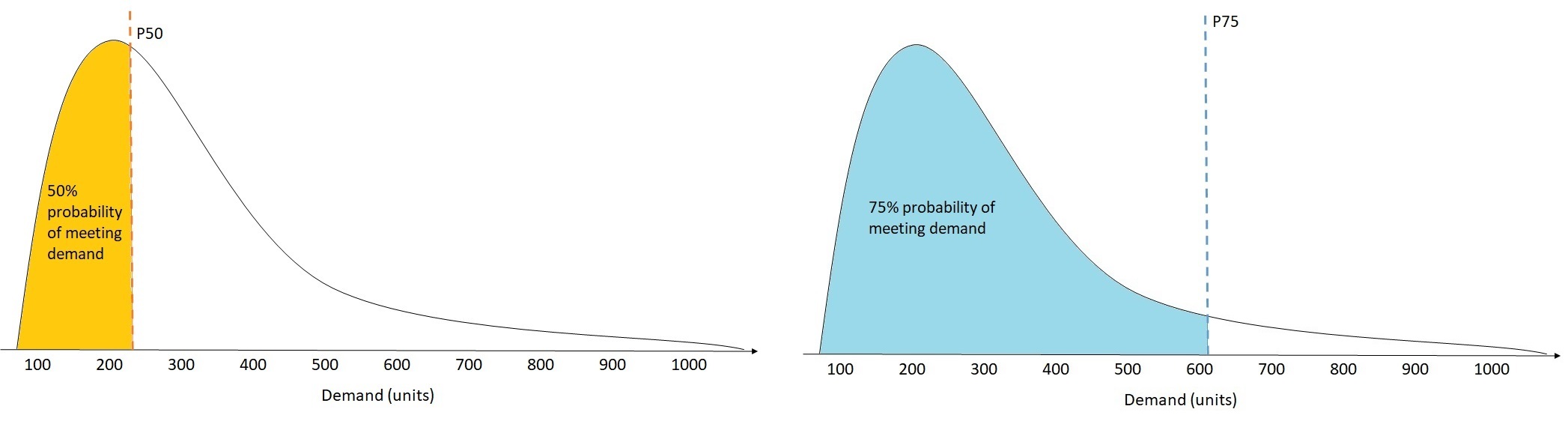

Im Einzelhandel sind die Kosten einer Unterversorgung häufig höher als die Kosten eines Überbestands, weshalb Prognosen für P75 (τ = 0,75) aussagekräftiger sein können als Prognosen für das Medianquantil (P50). In diesen Fällen weist wQL [0,75] Unterprognosen ein höheres Strafgewicht (0,75) und Überprognosen ein kleineres Strafgewicht (0,25) zu.

Die obige Abbildung zeigt die unterschiedlichen Nachfrageprognosen für WqL [0,50] und WqL [0,75]. Der prognostizierte Wert für P75 ist deutlich höher als der prognostizierte Wert für P50, da mit der P75-Prognose die Nachfrage voraussichtlich in 75% der Fälle gedeckt wird, wohingegen die P50-Prognose die Nachfrage voraussichtlich nur zu 50% der Zeit decken wird.

Wenn die Summe der beobachteten Werte für alle Elemente und Zeitpunkte in einem bestimmten Backtest-Fenster ungefähr Null ist, ist der Ausdruck des gewichteten Quantilverlusts undefiniert. In diesen Fällen gibt Forecast den ungewichteten Quantilverlust aus, der der Zähler im wQL-Ausdruck ist.

Forecast berechnet auch den durchschnittlichen wQL, d. h. den Mittelwert der gewichteten Quantilverluste über alle angegebenen Quantile. Standardmäßig ist dies der Durchschnitt von wQL [0,10], wQL [0,50] und wQL [0,90].

Gewichteter absoluter prozentualer Fehler (WAPE)

Der gewichtete absolute Prozentfehler (WAPE) misst die Gesamtabweichung der prognostizierten Werte von den beobachteten Werten. WAPE wird berechnet, indem die Summe der beobachteten Werte und die Summe der vorhergesagten Werte genommen und der Fehler zwischen diesen beiden Werten berechnet wird. Ein niedrigerer Wert bedeutet ein genaueres Modell.

Wenn die Summe der beobachteten Werte für alle Zeitpunkte und alle Elemente in einem bestimmten Backtest-Fenster ungefähr Null ist, ist der gewichtete absolute prozentuale Fehlerausdruck undefiniert. In diesen Fällen gibt Forecast die ungewichtete absolute Fehlersumme aus, die der Zähler im WAPE-Ausdruck ist.

- Wobei gilt:

-

y i,t — der beobachtete Wert am Punkt (i, t)

i,t- der vorhergesagte Wert am Punkt (i, t)

Forecast verwendet den Mittelwert der Prognose als vorhergesagten Wert,i,t.

WAPE ist robuster gegenüber Ausreißern als Root Mean Square Error (RMSE), da es den absoluten Fehler anstelle des quadratischen Fehlers verwendet.

Amazon Forecast bezeichnete die WAPE-Metrik zuvor als Mean Absolute Percentage Error (MAPE) und verwendete die mittlere Prognose (P50) als prognostizierten Wert. Forecast verwendet jetzt den Mittelwert der Prognose zur Berechnung des WAPE. Die wQL-Metrik [0,5] entspricht der WAPE-Metrik [Median], wie unten dargestellt:

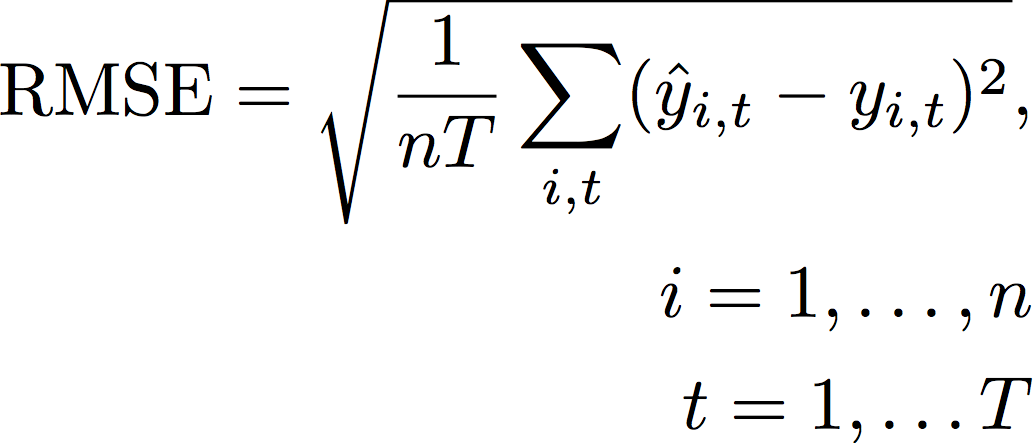

Root Mean Square Error (RMSE)

Root Mean Square Error (RMSE) ist die Quadratwurzel des Durchschnitts der quadratischen Fehler und reagiert daher empfindlicher auf Ausreißer als andere Genauigkeitsmetriken. Ein niedrigerer Wert bedeutet ein genaueres Modell.

- Wobei gilt:

-

y i,t — der beobachtete Wert am Punkt (i, t)

i,t- der vorhergesagte Wert am Punkt (i, t)

nT — die Anzahl der Datenpunkte in einem Testsatz

Forecast verwendet den Mittelwert der Prognose als vorhergesagten Wert,i,t. Bei der Berechnung von Prädiktormetriken ist nT die Anzahl der Datenpunkte in einem Backtest-Fenster.

RMSE verwendet den quadrierten Wert der Residuen, wodurch die Wirkung von Ausreißern verstärkt wird. In Anwendungsfällen, in denen nur wenige große Fehlprognosen sehr kostspielig sein können, ist der RMSE die relevantere Kennzahl.

Prädiktoren, die vor dem 11. November 2020 erstellt wurden, berechneten RMSE standardmäßig mit dem 0,5-Quantil (P50). Forecast verwendet jetzt den Mittelwert der Prognose.

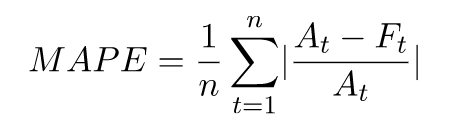

Mittlerer absoluter prozentualer Fehler (MAPE)

Der mittlere absolute Prozentfehler (MAPE) berechnet den absoluten Wert des prozentualen Fehlers zwischen beobachteten und vorhergesagten Werten für jede Zeiteinheit und bildet dann den Durchschnitt dieser Werte. Ein niedrigerer Wert bedeutet ein genaueres Modell.

- Wobei gilt:

-

A t — der beobachtete Wert am Punkt t

F t - der vorhergesagte Wert am Punkt t

n - die Anzahl der Datenpunkte in der Zeitreihe

In der Forecast wird der Mittelwert der Prognose als prognostizierter Wert verwendet, t F.

MAPE ist nützlich für Fälle, in denen sich die Werte zwischen den Zeitpunkten erheblich unterscheiden und Ausreißer erhebliche Auswirkungen haben.

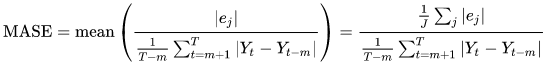

Mittlerer absoluter skalierter Fehler (MASE)

Der mittlere absolute skalierte Fehler (MASE) wird berechnet, indem der durchschnittliche Fehler durch einen Skalierungsfaktor dividiert wird. Dieser Skalierungsfaktor hängt vom Saisonalitätswert m ab, der auf der Grundlage der Prognosefrequenz ausgewählt wird. Ein niedrigerer Wert bedeutet ein genaueres Modell.

- Wobei gilt:

-

Y t - der beobachtete Wert am Punkt t

Y t-m - der beobachtete Wert am Punkt t-m

e j - der Fehler am Punkt j (beobachteter Wert - vorhergesagter Wert)

m - der Saisonalitätswert

Forecast verwendet den Mittelwert der Prognose als vorhergesagten Wert.

MASE ist ideal für Datensätze, die zyklischer Natur sind oder saisonale Eigenschaften aufweisen. Beispielsweise können Prognosen für Artikel, die im Sommer stark und im Winter wenig nachgefragt werden, von der Berücksichtigung der saisonalen Auswirkungen profitieren.

Genauigkeitsmetriken exportieren

Anmerkung

Exportdateien können direkt Informationen aus dem Datensatz-Import zurückgeben. Dies macht die Dateien anfällig für CSV-Injections, wenn die importierten Daten Formeln oder Befehle enthalten. Aus diesem Grund können exportierte Dateien Sicherheitswarnungen auslösen. Um böswillige Aktivitäten zu vermeiden, deaktivieren Sie Links und Makros beim Lesen exportierter Dateien.

Mit Forecast können Sie prognostizierte Werte und Genauigkeitsmetriken exportieren, die beim Backtesting generiert wurden.

Sie können diese Exporte verwenden, um bestimmte Elemente zu bestimmten Zeitpunkten und Quantilen auszuwerten und Ihren Prädiktor besser zu verstehen. Die Backtest-Exporte werden an einen bestimmten S3-Speicherort gesendet und enthalten zwei Ordner:

-

Prognosewerte: Enthält CSV- oder Parquet-Dateien mit prognostizierten Werten für jeden Prognosetyp für jeden Backtest.

-

accuracy-metrics-values: Enthält CSV- oder Parquet-Dateien mit Metriken für jeden Backtest sowie den Durchschnitt aller Backtests. Zu diesen Metriken gehören wQL für jedes Quantil, Average wQL, RMSE, MASE, MAPE und WAPE.

Der forecasted-values Ordner enthält prognostizierte Werte für jeden Prognosetyp für jedes Backtest-Fenster. Er enthält auch Informationen zu Elementen IDs, Dimensionen, Zeitstempeln, Zielwerten sowie Start- und Endzeiten des Backtest-Fensters.

Der accuracy-metrics-values Ordner enthält Genauigkeitsmetriken für jedes Backtest-Fenster sowie die durchschnittlichen Messwerte für alle Backtest-Fenster. Er enthält WQL-Metriken für jedes angegebene Quantil sowie durchschnittliche wQL-, RMSE-, MASE-, MAPE- und WAPE-Metriken.

Dateien in beiden Ordnern folgen der Benennungskonvention:. <ExportJobName>_<ExportTimestamp>_<PartNumber>.csv

Sie können Genauigkeitsmetriken mit dem Amazon Forecast Software Development Kit (SDK) und der Amazon Forecast-Konsole exportieren.

Geben Sie mithilfe des CreatePredictorBacktestExportJobVorgangs Ihren S3-Standort und Ihre IAM-Rolle im DataDestinationObjekt zusammen mit PredictorArn und PredictorBacktestExportJobName an.

Zum Beispiel:

{

"Destination": {

"S3Config": {

"Path": "s3://bucket/example-path/",

"RoleArn": "arn:aws:iam::000000000000:role/ExampleRole"

}

},

"Format": PARQUET;

"PredictorArn": "arn:aws:forecast:region:predictor/example",

"PredictorBacktestExportJobName": "backtest-export-name",

}

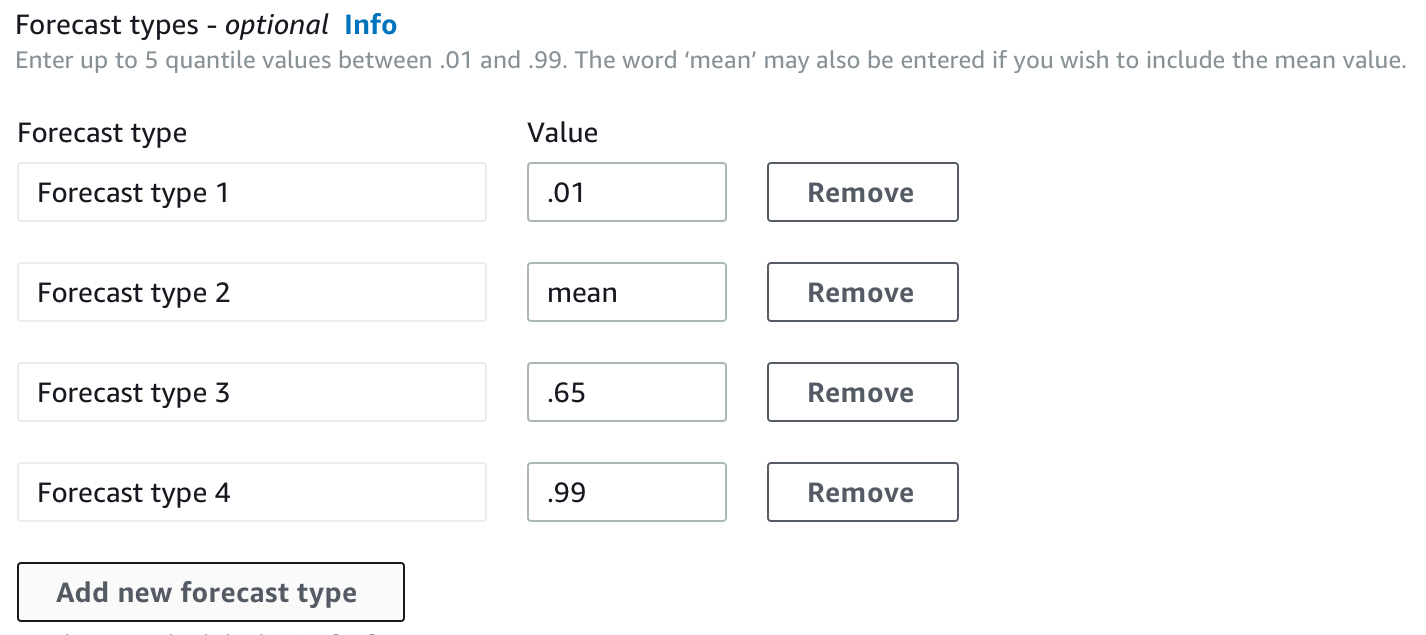

Prognosetypen auswählen

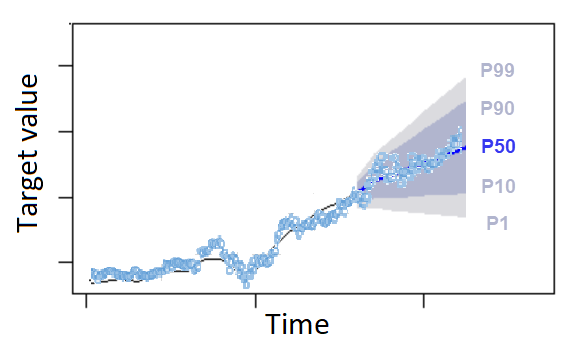

Amazon Forecast verwendet Prognosetypen, um Prognosen zu erstellen und Prädiktoren auszuwerten. Prognosetypen gibt es in zwei Formen:

-

Prognosetyp „Mittelwert“ — Eine Prognose, bei der der Mittelwert als erwarteter Wert verwendet wird. Wird in der Regel als Punktprognosen für einen bestimmten Zeitpunkt verwendet.

-

Prognosetyp „Quantil“ — Eine Prognose für ein bestimmtes Quantil. Wird in der Regel verwendet, um ein Prognoseintervall anzugeben, bei dem es sich um einen Bereich möglicher Werte handelt, um der Prognoseunsicherheit Rechnung zu tragen. Bei einer Prognose zum

0.65Quantil wird beispielsweise ein Wert geschätzt, der in 65% der Fälle unter dem beobachteten Wert liegt.

Standardmäßig verwendet Forecast die folgenden Werte für die Prädiktor-Prognosetypen: 0.1 (P10), 0.5 (P50) und 0.9 (P90). Sie können bis zu fünf benutzerdefinierte Prognosetypen auswählen, einschließlich mean Quantilen im Bereich von 0.01 (P1) bis (P99). 0.99

Quantile können eine Ober- und Untergrenze für Prognosen bilden. Wenn Sie beispielsweise die Prognosetypen 0.1 (P10) und 0.9 (P90) verwenden, erhalten Sie einen Wertebereich, der als 80-%-Konfidenzintervall bezeichnet wird. Es wird erwartet, dass der beobachtete Wert in 10% der Fälle unter dem P10-Wert liegt, und es wird erwartet, dass der P90-Wert in 90% der Fälle über dem beobachteten Wert liegt. Wenn Sie Prognosen für P10 und P90 generieren, können Sie davon ausgehen, dass der wahre Wert in 80% der Fälle zwischen diesen Grenzen liegt. Dieser Wertebereich wird in der Abbildung unten durch den schattierten Bereich zwischen P10 und P90 dargestellt.

Sie können eine Quantilprognose auch als Punktprognose verwenden, wenn sich die Kosten einer zu niedrigen Prognose von den Kosten einer zu hohen Prognose unterscheiden. In einigen Fällen im Einzelhandel sind beispielsweise die Kosten für Unterbestände höher als für Überbestände. In diesen Fällen ist die Prognose bei 0,65 (P65) aussagekräftiger als der Median (P50) oder die mittlere Prognose.

Beim Training eines Prädiktors können Sie mithilfe des Amazon Forecast Software Development Kit (SDK) und der Amazon Forecast-Konsole benutzerdefinierte Prognosetypen auswählen.

Geben Sie mithilfe der CreateAutoPredictorOperation die benutzerdefinierten Prognosetypen im ForecastTypes Parameter an. Formatieren Sie den Parameter als ein Array von Zeichenfolgen.

Verwenden Sie beispielsweise den folgenden Code, um einen Prädiktor für die 0.01 Typen,, und 0.99 Prognose zu erstellen. mean 0.65

{

"ForecastTypes": [ "0.01", "mean", "0.65", "0.99" ],

}, Mit älteren Prädiktoren arbeiten

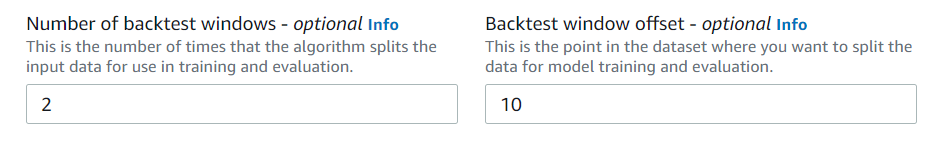

Einstellung von Backtesting-Parametern

Forecast verwendet Backtesting, um Genauigkeitsmetriken zu berechnen. Wenn Sie mehrere Backtests ausführen, berechnet Forecast den Durchschnitt jeder Metrik in allen Backtestfenstern. Standardmäßig berechnet Forecast einen Backtest, wobei die Größe des Backtestfensters (Testsatz) der Länge des Prognosehorizonts (Prognosefenster) entspricht. Sie können sowohl die Länge des Backtest-Fensters als auch die Anzahl der Backtest-Szenarien festlegen, wenn Sie einen Prädiktor trainieren.

Forecast lässt gefüllte Werte aus dem Backtesting-Prozess aus, und jedes Element mit gefüllten Werten innerhalb eines bestimmten Backtest-Fensters wird von diesem Backtest ausgeschlossen. Dies liegt daran, dass Forecast beim Backtesting nur prognostizierte Werte mit beobachteten Werten vergleicht und gefüllte Werte keine beobachteten Werte sind.

Das Backtest-Fenster muss mindestens so groß wie der Prognosehorizont und kleiner als die Hälfte der Länge des gesamten Zielzeitreihen-Datensatzes sein. Sie können zwischen 1 und 5 Backtests wählen.

Im Allgemeinen führt eine Erhöhung der Anzahl von Backtests zu zuverlässigeren Genauigkeitsmetriken, da ein größerer Teil der Zeitreihen beim Testen verwendet wird und Forecast in der Lage ist, einen Durchschnitt der Metriken für alle Backtests zu ermitteln.

Sie können die Backtesting-Parameter mit dem Amazon Forecast Software Development Kit (SDK) und der Amazon Forecast-Konsole festlegen.

Stellen Sie mithilfe des CreatePredictorVorgangs die Backtest-Parameter im Datentyp ein. EvaluationParameters Geben Sie die Länge des Testsatzes beim Backtesting mit dem BackTestWindowOffset Parameter und die Anzahl der Backtest-Fenster mit dem Parameter an. NumberOfBacktestWindows

Um beispielsweise 2 Backtests mit einem Testsatz von 10 Zeitpunkten auszuführen, verwenden Sie den folgenden Code.

"EvaluationParameters": {

"BackTestWindowOffset": 10,

"NumberOfBacktestWindows": 2

}

HPO und AutoML

Standardmäßig verwendet Amazon Forecast die Quantile 0.1 (P10), 0.5 (P50) und 0.9 (P90) für das Hyperparameter-Tuning während der Hyperparameter-Optimierung (HPO) und für die Modellauswahl während AutoML. Wenn Sie bei der Erstellung eines Prädiktors benutzerdefinierte Prognosetypen angeben, verwendet Forecast diese Prognosetypen während HPO und AutoML.

Wenn benutzerdefinierte Prognosetypen angegeben sind, verwendet Forecast diese angegebenen Prognosetypen, um die optimalen Ergebnisse während HPO und AutoML zu ermitteln. Während HPO verwendet Forecast das erste Backtest-Fenster, um die optimalen Hyperparameterwerte zu ermitteln. Während AutoML verwendet Forecast die Durchschnittswerte aller Backtestfenster und die optimalen Hyperparameterwerte von HPO, um den optimalen Algorithmus zu finden.

Sowohl für AutoML als auch für HPO wählt Forecast die Option, die die durchschnittlichen Verluste gegenüber den Prognosetypen minimiert. Sie können Ihren Prädiktor auch während AutoML und HPO mit einer der folgenden Genauigkeitsmetriken optimieren: Average Weighted Quantile Loss (Average wQL), Weighted Absolute Percentage Error (WAPE), Root Mean Squared Error (RMSE), Mean Absolute Percentage Error (MAPE) oder Mean Absolute Scaled Error (MASE).

Sie können mithilfe des Amazon Forecast Software Development Kit (SDK) und der Amazon Forecast-Konsole eine Optimierungsmetrik auswählen.

Geben Sie mithilfe der CreatePredictorOperation die benutzerdefinierten Prognosetypen im ObjectiveMetric Parameter an.

Der ObjectiveMetric Parameter akzeptiert die folgenden Werte:

-

AverageWeightedQuantileLoss- Durchschnittlicher gewichteter Quantilverlust -

WAPE- Gewichteter absoluter prozentualer Fehler -

RMSE- Quadratischer Mittelwert des Fehlers -

MAPE- Mittlerer absoluter prozentualer Fehler -

MASE- Mittlerer absoluter skalierter Fehler

Um beispielsweise einen Prädiktor mit AutoML zu erstellen und mithilfe der Genauigkeitsmetrik Mean Absolute Scaled Error (MASE) zu optimieren, verwenden Sie den folgenden Code.

{

...

"PerformAutoML": "true",

...

"ObjectiveMetric": "MASE",

},