Nous ne mettons plus à jour le service Amazon Machine Learning et n'acceptons plus de nouveaux utilisateurs pour ce service. Cette documentation est disponible pour les utilisateurs existants, mais nous ne la mettons plus à jour. Pour plus d'informations, veuillez consulter la rubriqueQu'est-ce qu'Amazon Machine Learning.

Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Étape 4 : Examen des performances prédictives du modèle d'apprentissage-machine et définition d'un score seuil

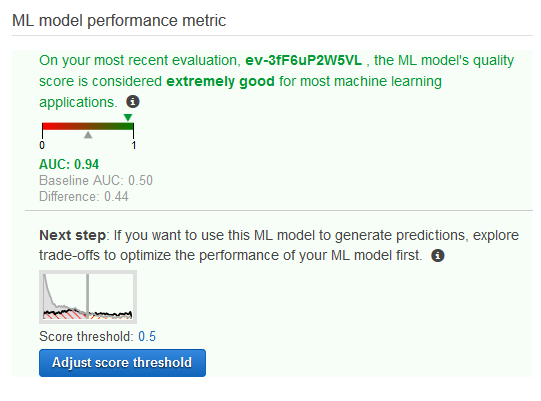

Maintenant que vous avez créé votre modèle d'apprentissage-machine et qu'Amazon (Amazon ML) l'a évalué, voyons s'il est assez bon pour être mis en application. Au cours de l'évaluation, Amazon ML a calculé une métrique de qualité conforme aux normes du secteur, appelée métrique Aire sous une courbe (AUC, Area Under a Curve), qui exprime la qualité des performances de votre modèle d'apprentissage-machine. Amazon ML interprète également la métrique AUC pour vous indiquer si la qualité du modèle d'apprentissage-machine est appropriée pour la plupart des applications d'apprentissage-machine. (Découvrez plus d'informations sur AUC dans Mesure de la précision du modèle d'apprentissage-machine.) Examinons la métrique AUC, puis ajustez le score seuil ou la limite pour optimiser les performances prédictives de votre modèle.

Pour examiner la métrique AUC de votre modèle d'apprentissage-machine

-

Dans la pageRécapitulatif du, dans laRapport d'apprentissage-Volet de navigation, choisissez,Evaluations, choisissezEvaluation : modèle ML : Le modèle bancaire 1Choisissez, puisRécapitulatif.

-

Dans la page Evaluation summary, examinez le résumé d'évaluation, dont notamment la métrique de performances AUC du modèle.

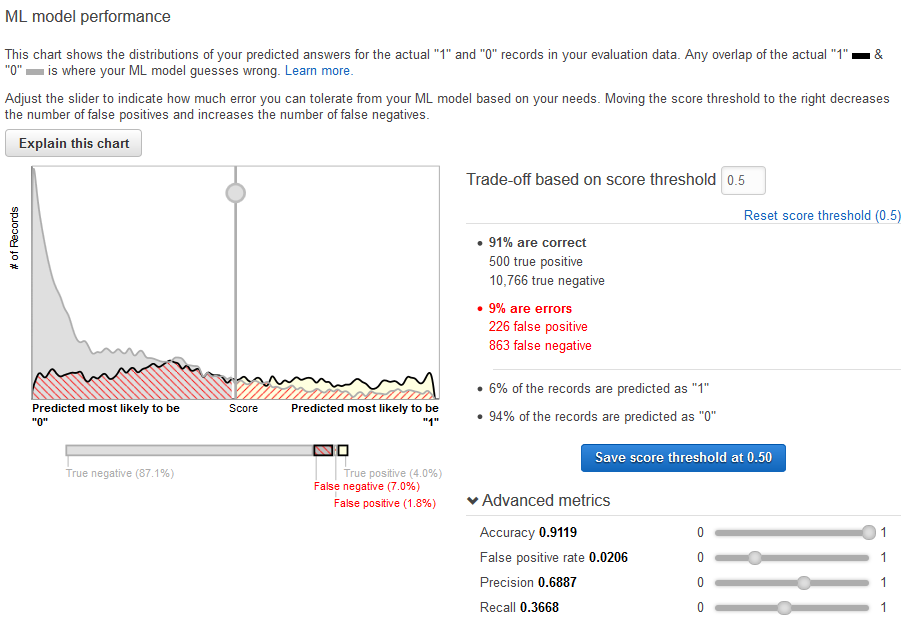

Le modèle d'apprentissage-machine génère des scores de prédiction numériques pour chaque enregistrement dans une source de données de prédiction, puis applique un seuil pour convertir ces scores en étiquettes binaires 0 (pour non) ou 1 (pour oui). En changeant le score seuil, vous pouvez ajuster la manière dont le modèle d'apprentissage-machine attribue ces étiquettes. Maintenant, définissez le score seuil.

Pour définir un score seuil pour votre modèle d'apprentissage-machine

-

Dans la page Evaluation Summary, choisissez Adjust Score Threshold.

Vous pouvez affiner les métriques de performances de votre modèle d'apprentissage-machine en ajustant le score seuil. L'ajustement de cette valeur modifie le niveau de confiance que le modèle doit avoir dans une prédiction avant de considérer la prédiction comme positive. Il change également le nombre de faux négatifs et de faux positifs que vous êtes prêt à tolérer dans vos prévisions.

Vous pouvez contrôler la limite pour ce que le modèle considère comme une prédiction positive en augmentant le score seuil jusqu'à ce qu'il considère comme positives uniquement les prédictions dotées de la plus haute probabilité d'être de vrais positifs. Vous pouvez également réduire le score seuil jusqu'à ce que vous n'ayez plus aucun faux négatif. Choisissez votre limite pour refléter les besoins de votre activité. Dans le cadre de ce didacticiel, chaque faux positif a un coût financier sur la campagne, si bien que nous voulons un haut ratio de vrais positifs par rapport aux faux positifs.

-

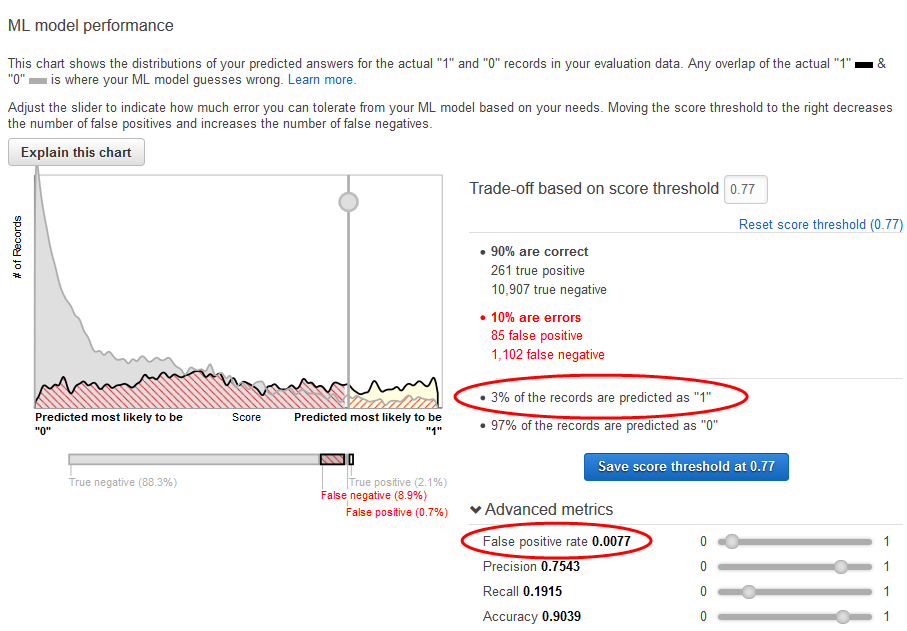

Disons que vous voulez cibler les 3 % supérieurs des clients qui souscrivent au produit. Faites glisser le sélecteur vertical pour définir le score seuil sur une valeur qui correspond à 3% of the records are predicted as "1".

Notez l'impact de ce score seuil sur les performances du modèle d'apprentissage-machine : le taux de faux positifs est de 0,007. Supposons que ce taux de faux positifs est acceptable.

-

Choisissez Save score threshold at 0.77.

Chaque fois que vous utilisez ce modèle d'apprentissage-machine pour faire des prédictions, il prédit les enregistrements avec des scores supérieurs à 0,77 en tant que « 1 », et le reste des enregistrements en tant que « 0 ».

Pour en savoir plus sur le score seuil, consultez Classification binaire.

Maintenant, vous êtes prêt à créer des prédictions à l'aide de votre modèle.