Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Equità, spiegabilità del modello e rilevamento delle distorsioni con Clarify SageMaker

Puoi usare Amazon SageMaker Clarify per comprendere l'equità e la spiegabilità dei modelli e per spiegare e rilevare errori nei tuoi modelli. Puoi configurare un processo di elaborazione SageMaker Clarify per calcolare metriche di distorsioni e attribuzioni di funzionalità e generare report per la spiegabilità del modello. SageMaker I processi di elaborazione di Clarify vengono implementati utilizzando un'immagine del contenitore Clarify specializzata. SageMaker La pagina seguente descrive come funziona SageMaker Clarify e come iniziare con un'analisi.

Cosa sono l'equità e la spiegabilità dei modelli per le previsioni di machine learning?

I modelli di machine learning (ML) aiutano a prendere decisioni in settori quali servizi finanziari, assistenza sanitaria, istruzione e risorse umane. I responsabili politici, i regolatori e i sostenitori hanno sensibilizzato l'opinione pubblica sulle sfide etiche e politiche poste dal machine learning e dai sistemi basati sui dati. Amazon SageMaker Clarify può aiutarti a capire perché il tuo modello di machine learning ha creato una previsione specifica e se questa distorsione influisce su questa previsione durante l'addestramento o l'inferenza. SageMaker Clarify fornisce anche strumenti che possono aiutarti a creare modelli di machine learning meno distorti e più comprensibili. SageMaker Clarify può anche generare report sulla governance dei modelli da fornire ai team di rischio e conformità e alle autorità di regolamentazione esterne. Con SageMaker Clarify, puoi fare quanto segue:

-

Rileva le distorsioni e aiuta a spiegare le previsioni del modello.

-

Identifica i tipi di distorsioni nei dati di pre-allenamento.

-

Identifica i tipi di distorsioni nei dati post-allenamento che possono emergere durante l'addestramento o quando il modello è in produzione.

SageMaker Clarify aiuta a spiegare come i tuoi modelli effettuano previsioni utilizzando le attribuzioni di funzionalità. Può anche monitorare i modelli di inferenza in produzione sia per individuare distorsioni che deviazioni nell'attribuzione delle caratteristiche. Queste informazioni possono essere utili nelle seguenti aree:

-

Normativa: i responsabili politici e gli altri regolatori possono nutrire preoccupazioni in merito agli impatti discriminatori delle decisioni che utilizzano i risultati dei modelli di machine learning. Ad esempio, un modello di machine learning può codificare pregiudizi e influenzare una decisione automatizzata.

-

Aziende: i domini regolamentati possono richiedere spiegazioni affidabili su come i modelli ML effettuano previsioni. La spiegabilità dei modelli può essere particolarmente importante per i settori che dipendono dall'affidabilità, dalla sicurezza e dalla conformità. Questi possono includere servizi finanziari, risorse umane, assistenza sanitaria e trasporti automatizzati. Ad esempio, le richieste di prestito potrebbero dover fornire spiegazioni su come i modelli di machine learning hanno fornito determinate previsioni ai responsabili dei prestiti, agli addetti alle previsioni e ai clienti.

-

Scienza dei dati: i data scientist e gli ingegneri di machine learning possono eseguire il debug e migliorare i modelli di machine learning quando sono in grado di determinare se un modello sta effettuando inferenze basate su funzionalità rumorose o irrilevanti. Sono inoltre in grado di comprendere i limiti dei propri modelli e le modalità di errore a cui possono andare incontro.

Per un post sul blog che mostra come progettare e creare un modello completo di machine learning per reclami automobilistici fraudolenti che integri SageMaker Clarify in una SageMaker pipeline, consulta Architect e crea l'intero ciclo di vita dell'apprendimento automatico con AWS

Le migliori pratiche per valutare l'equità e la spiegabilità nel ciclo di vita del machine learning

L'equità come processo: le nozioni di pregiudizio ed equità dipendono dalla loro applicazione. La misurazione dei pregiudizi e la scelta delle metriche dei pregiudizi possono essere guidate da considerazioni sociali, legali e di altro tipo non tecniche. L'adozione di successo di approcci di apprendimento automatico consapevoli dell'equità include la creazione del consenso e il raggiungimento della collaborazione tra le principali parti interessate. Questi possono includere team di prodotto, policy, legali, ingegneristici, AI/ML, utenti finali e comunità.

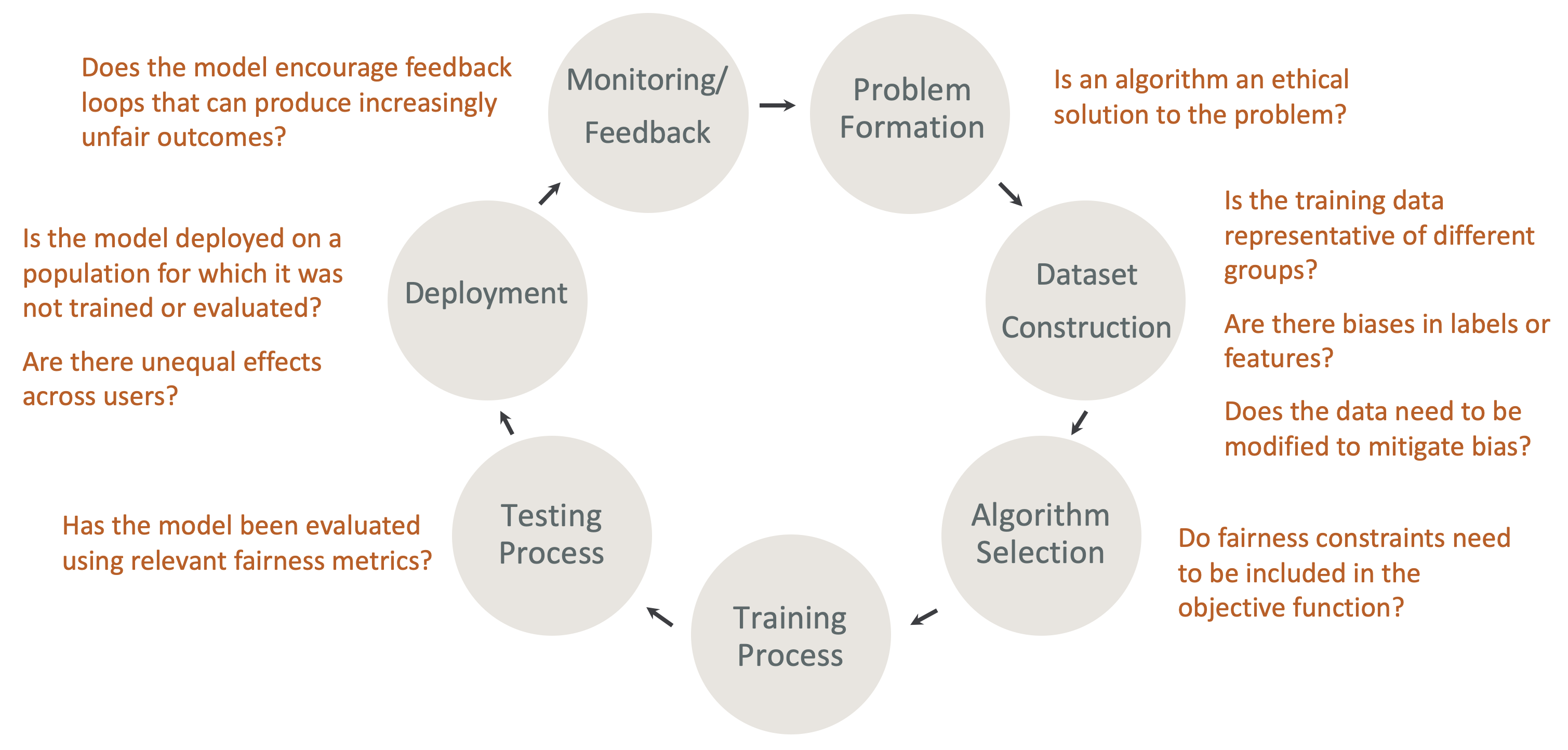

Equità e spiegabilità fin dalla progettazione nel ciclo di vita del machine learning: considera l'equità e la spiegabilità in ogni fase del ciclo di vita del machine learning. Queste fasi includono la formazione dei problemi, la costruzione del set di dati, la selezione degli algoritmi, il processo di addestramento del modello, il processo di test, l'implementazione, il monitoraggio e il feedback. È importante disporre degli strumenti giusti per eseguire questa analisi. Ti consigliamo di porre le seguenti domande durante il ciclo di vita del machine learning:

-

Il modello incoraggia cicli di feedback che possono produrre risultati sempre più iniqui?

-

Un algoritmo è una soluzione etica al problema?

-

I dati di allenamento sono rappresentativi di diversi gruppi?

-

Ci sono pregiudizi nelle etichette o nelle caratteristiche?

-

I dati devono essere modificati per mitigare le distorsioni?

-

I vincoli di equità devono essere inclusi nella funzione obiettivo?

-

Il modello è stato valutato utilizzando metriche di equità pertinenti?

-

Vi sono effetti diseguali tra gli utenti?

-

Il modello è utilizzato su una popolazione per la quale non è stato formato o valutato?

Guida alle SageMaker spiegazioni e alla documentazione sui pregiudizi

Le distorsioni possono verificarsi ed essere misurate nei dati sia prima che dopo l'addestramento di un modello. SageMaker Clarify può fornire spiegazioni per le previsioni dei modelli dopo l'addestramento e per i modelli implementati in produzione. SageMaker Clarify può anche monitorare i modelli in produzione per rilevare eventuali variazioni nelle loro attribuzioni esplicative di base e calcolare le linee di base quando necessario. La documentazione per spiegare e rilevare i pregiudizi utilizzando Clarify è strutturata come segue: SageMaker

-

Per informazioni sulla configurazione di un processo di elaborazione basato su distorsioni e spiegabilità, consulta. Configurazione di un processo di elaborazione SageMaker Clarify

-

Per informazioni su come rilevare le distorsioni nei dati di pre-elaborazione prima che vengano utilizzati per addestrare un modello, vedere. Data Bias prima dell'allenamento

-

Per informazioni sul rilevamento dei dati post-addestramento e delle distorsioni del modello, vedere. Dati post-allenamento e distorsioni dei modelli

-

Per informazioni sull'approccio di attribuzione delle funzionalità indipendente dal modello per spiegare le previsioni dei modelli dopo l'addestramento, vedere. Spiegabilità del modello

-

Per informazioni sul monitoraggio del contributo delle funzionalità rispetto alla linea di base stabilita durante l'addestramento del modello, vedere. Cambiamenti nell'attribuzione delle funzionalità per i modelli in produzione

-

Per informazioni sul monitoraggio della deviazione di base dei modelli in produzione, vedere. Bias drift per i modelli in produzione

-

Per informazioni su come ottenere spiegazioni in tempo reale da un SageMaker endpoint, vedere. Spiegabilità online con Clarify SageMaker

Come funzionano i lavori di elaborazione di SageMaker Clarify

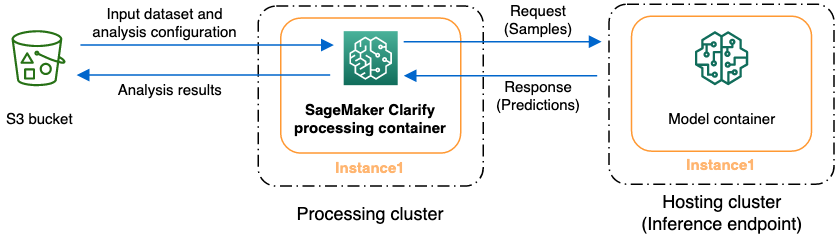

Puoi utilizzare SageMaker Clarify per analizzare i set di dati e i modelli per verificarne la spiegabilità e le distorsioni. Un processo di elaborazione SageMaker Clarify utilizza il contenitore di elaborazione SageMaker Clarify per interagire con un bucket Amazon S3 contenente i set di dati di input. Puoi anche utilizzare SageMaker Clarify per analizzare un modello di cliente distribuito su un endpoint di inferenza. SageMaker

Il grafico seguente mostra come un processo di elaborazione SageMaker Clarify interagisce con i dati di input e, facoltativamente, con un modello del cliente. Questa interazione dipende dal tipo specifico di analisi eseguita. Il contenitore di elaborazione SageMaker Clarify ottiene il set di dati di input e la configurazione per l'analisi da un bucket S3. Per determinati tipi di analisi, inclusa l'analisi delle feature, il contenitore di elaborazione SageMaker Clarify deve inviare le richieste al contenitore del modello. Quindi recupera le previsioni del modello dalla risposta inviata dal container del modello. Successivamente, il contenitore di elaborazione SageMaker Clarify calcola e salva i risultati dell'analisi nel bucket S3.

È possibile eseguire un processo di elaborazione SageMaker Clarify in più fasi del ciclo di vita del flusso di lavoro di apprendimento automatico. SageMaker Clarify può aiutarvi a calcolare i seguenti tipi di analisi:

-

Metriche di distorsione prima dell'allenamento. Queste metriche possono aiutarti a comprendere la distorsione dei tuoi dati in modo da poterla correggere e addestrare il tuo modello su un set di dati più equo. Metriche di bias pre-addestramentoPer informazioni sulle metriche relative ai pregiudizi prima dell'allenamento, consulta la sezione. Per eseguire un processo di analisi delle metriche di distorsione prima dell'allenamento, devi fornire il set di dati e un file di configurazione dell'analisi a. JSON File di configurazione dell'analisi

-

Metriche di distorsione post-allenamento. Queste metriche possono aiutarti a comprendere eventuali distorsioni introdotte da un algoritmo, le scelte iperparametriche o qualsiasi distorsione che non era evidente in precedenza nel flusso. Per ulteriori informazioni sulle metriche relative ai pregiudizi post-allenamento, consulta. Dati post-allenamento e metriche di distorsione dei modelli SageMaker Clarify utilizza le previsioni del modello oltre ai dati e alle etichette per identificare i pregiudizi. Per eseguire un processo di analisi delle metriche di distorsione successive all'allenamento, è necessario fornire il set di dati e un file di configurazione dell'analisi. JSON La configurazione deve includere il nome del modello o dell'endpoint.

-

Valori di Shapley, che possono aiutarvi a capire l'impatto della feature su quanto previsto dal modello. Per ulteriori informazioni sui valori di Shapley, consultate. Caratterizzazione delle attribuzioni che utilizzano i valori Shapley Questa funzionalità richiede un modello addestrato.

-

Grafici di dipendenza parziale (PDPs), che possono aiutarvi a capire quanto cambierebbe la variabile target prevista se variassi il valore di una feature. Per ulteriori informazioni suPDPs, consulta PDPsAnalisi dei grafici di dipendenza parziale () Questa funzionalità richiede un modello addestrato.

SageMaker Clarify necessita di previsioni basate su modelli per calcolare le metriche di distorsione post-allenamento e l'attribuzione delle funzionalità. È possibile fornire un endpoint oppure SageMaker Clarify creerà un endpoint temporaneo utilizzando il nome del modello, noto anche come endpoint ombra. Il contenitore SageMaker Clarify elimina l'endpoint shadow dopo il completamento dei calcoli. A un livello elevato, il contenitore SageMaker Clarify completa i seguenti passaggi:

-

Convalida input e parametri.

-

Crea l'endpoint shadow (se viene fornito un nome di modello).

-

Carica il set di dati di input in un frame di dati.

-

Ottiene le previsioni del modello dall'endpoint, se necessario.

-

Calcola i parametri di bias e le attribuzioni delle funzionalità.

-

Elimina l'endpoint shadow.

-

Genera i risultati dell'analisi.

Una volta completato il processo di elaborazione di SageMaker Clarify, i risultati dell'analisi verranno salvati nella posizione di output specificata nel parametro di output di elaborazione del lavoro. Questi risultati includono un JSON file con metriche di distorsione e attribuzioni globali delle funzionalità, un rapporto visivo e file aggiuntivi per le attribuzioni di funzionalità locali. È possibile scaricare i risultati dalla posizione di output e visualizzarli.

Per ulteriori informazioni sulle metriche dei pregiudizi, sulla spiegabilità e su come interpretarle, consulta Scopri come Amazon SageMaker Clarify aiuta a rilevare bias

Notebook di esempio

Le seguenti sezioni contengono taccuini per aiutarvi a iniziare a utilizzare SageMaker Clarify, a utilizzarlo per attività speciali, incluse quelle all'interno di un lavoro distribuito, e per la visione artificiale.

Nozioni di base

I seguenti taccuini di esempio mostrano come utilizzare SageMaker Clarify per iniziare con le attività di spiegabilità e distorsione dei modelli. Queste attività includono la creazione di un processo di elaborazione, l'addestramento di un modello di machine learning (ML) e il monitoraggio delle previsioni dei modelli:

-

Spiegabilità e rilevamento delle distorsioni con Amazon SageMaker Clarify: usa SageMaker Clarify

per creare un processo di elaborazione per rilevare distorsioni e spiegare le previsioni dei modelli. -

Monitoraggio della deriva dei pregiudizi e delle variazioni nell'attribuzione delle funzionalità Amazon SageMaker Clarify: utilizza SageMaker Amazon

Model Monitor per monitorare la deriva dei pregiudizi e la variazione dell'attribuzione delle funzionalità nel tempo. -

Come leggere un set di dati in formato Lines in un processo di elaborazione Clarify

. JSON SageMaker -

Mitigate i pregiudizi, addestrate un altro modello imparziale e inseritelo nel registro dei modelli: utilizzate Synthetic Minority Over-sampling Technique (SMOTE)

e SageMaker Clarify per mitigare i pregiudizi, addestrare un altro modello e quindi inserire il nuovo modello nel registro dei modelli. Questo taccuino di esempio mostra anche come inserire i nuovi artefatti del modello, inclusi dati, codice e metadati del modello, nel registro dei modelli. Questo notebook fa parte di una serie che mostra come integrare SageMaker Clarify in una SageMaker pipeline descritta in Architect e creare l'intero ciclo di vita dell'apprendimento automatico con un post sul blog. AWS

Casi speciali

I seguenti taccuini mostrano come utilizzare SageMaker Clarify per casi speciali, ad esempio all'interno del proprio contenitore e per attività di elaborazione del linguaggio naturale:

-

Equità e spiegabilità con SageMaker Clarify (Bring Your Own Container): create il vostro modello e contenitore

in grado di integrarsi con SageMaker Clarify per misurare le distorsioni e generare un rapporto di analisi della spiegabilità. Questo taccuino di esempio introduce anche i termini chiave e mostra come accedere al rapporto tramite Studio Classic. SageMaker -

Equità e spiegabilità con l'elaborazione distribuita di SageMaker Clarify Spark: utilizzate l'elaborazione distribuita

per eseguire un job SageMaker Clarify che misuri la distorsione pre-addestramento di un set di dati e la distorsione post-formazione di un modello. Questo taccuino di esempio mostra anche come ottenere una spiegazione dell'importanza delle funzionalità di input sull'output del modello e accedere al rapporto di analisi della spiegabilità tramite Studio Classic. SageMaker -

Spiegabilità con SageMaker Clarify - Grafici di dipendenza parziale (PDP): utilizzate SageMaker Clarify per generare

e accedere a un rapporto sulla spiegabilità del modello. PDPs -

Spiegazione dell'analisi del sentimento testuale utilizzando SageMaker Clarify Natural language processing () spiegabilità: utilizzate Clarify per l'analisi

del sentimento testuale. NLP SageMaker -

Utilizzate la spiegabilità della visione artificiale (CV) per la classificazione delle immagini e il rilevamento degli oggetti.

È stato verificato che questi notebook funzionino in Amazon SageMaker Studio Classic. Se hai bisogno di istruzioni su come aprire un notebook in Studio Classic, consulta. Crea o apri un notebook Amazon SageMaker Studio Classic Se ti viene richiesto di scegliere un kernel, scegli Python 3 (Data Science).