翻訳は機械翻訳により提供されています。提供された翻訳内容と英語版の間で齟齬、不一致または矛盾がある場合、英語版が優先します。

Amazon Data Firehose とは何ですか?

Amazon Data Firehose は、宛先 (Amazon Simple Storage Service (Amazon S3)、Amazon Redshift、Amazon OpenSearch Service、Amazon OpenSearch Serverless、Splunk、Apache Iceberg テーブル、カスタム HTTP エンドポイント、または Datadog、Dynatrace、LogicMonitor、MongoDB、New Relic、Coralogix、Elastic などのサポートされているサードパーティーのサービスプロバイダーが所有する HTTP エンドポイントなど) にストリーミングデータ

AWS ビッグデータソリューションの詳細については、「AWS でのビッグデータ

注記

最新のAWS Amazon MSK 向けストリーミングデータソリューション

主要な概念を学ぶ

Amazon Data Firehose の使用を開始すると、次の概念を理解することができます。

- Firehose ストリーム

-

Amazon Data Firehose の基礎となるエンティティ。Firehose ストリームを作成し、それにデータを送信することで Amazon Data Firehose を使用します。詳細については、チュートリアル: コンソールから Firehose ストリームを作成するおよびFirehose ストリームにデータを送信するを参照してください。

- レコード

-

データプロデューサーが Firehose ストリームに送信する、関心のあるデータ。レコードのサイズは最大 1000 KB です。

- データプロデューサー

-

プロデューサーは Firehose ストリームにレコードを送信します。例えば、Firehose ストリームにログデータを送信するウェブサーバーはデータプロデューサーです。Firehose ストリームが自動的に既存のKinesis データストリームからデータを読み取り、宛先にロードするよう設定することもできます。詳細については、「Firehose ストリームにデータを送信する」を参照してください。

- バッファリングサイズおよびバッファリングの間隔

-

Amazon Data Firehose は特定の期間、着信ストリーミングデータを特定のサイズにバッファリングしてから、宛先に配信します。Buffer Size は MB 単位で、Buffer Interval は秒単位です。

Amazon Data Firehose のデータフローを理解する

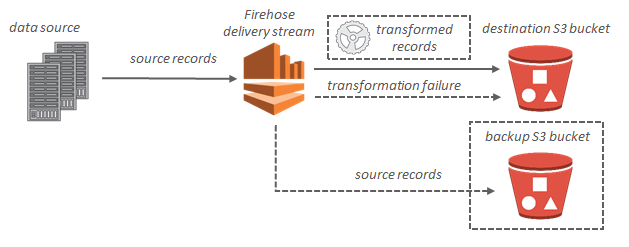

Amazon S3 の送信先の場合、ストリーミングデータは S3 バケットに配信されます。データ変換が有効な場合は、オプションで、送信元データを別の Amazon S3 バケットにバックアップすることもできます。

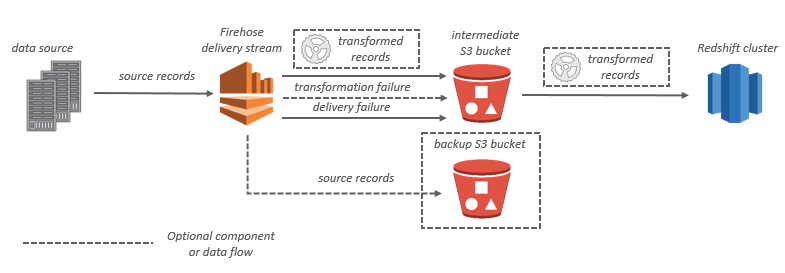

Amazon Redshift の送信先の場合、ストリーミングデータは S3 バケットに配信されます。次に Amazon Data Firehose は、Amazon Redshift COPY コマンドを発行して、S3 バケットから Amazon Redshift クラスターにデータをロードします。データ変換が有効な場合は、オプションで、送信元データを別の Amazon S3 バケットにバックアップすることもできます。

OpenSearch Service の送信先の場合、ストリーミングデータは OpenSearch Service クラスターに配信され、オプションで、配信と同時に S3 バケットにバックアップすることもできます。

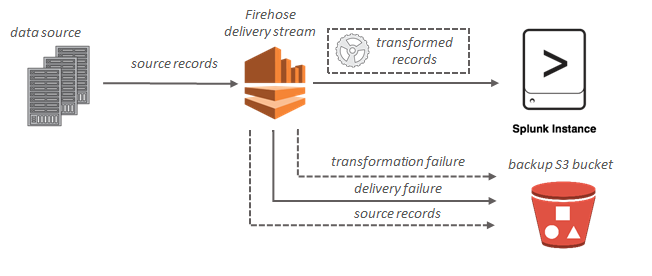

Splunk の送信先を使用する場合、ストリーミングデータは Splunk に配信され、オプションで、配信と同時に S3 バケットにバックアップすることもできます。